scrapy入门到放弃02:整一张架构图,开发一个程序

前言

Scrapy开门篇写了一些纯理论知识,这第二篇就要直奔主题了。先来讲讲Scrapy的架构,并从零开始开发一个Scrapy爬虫程序。

本篇文章主要阐述Scrapy架构,理清开发流程,掌握基本操作。

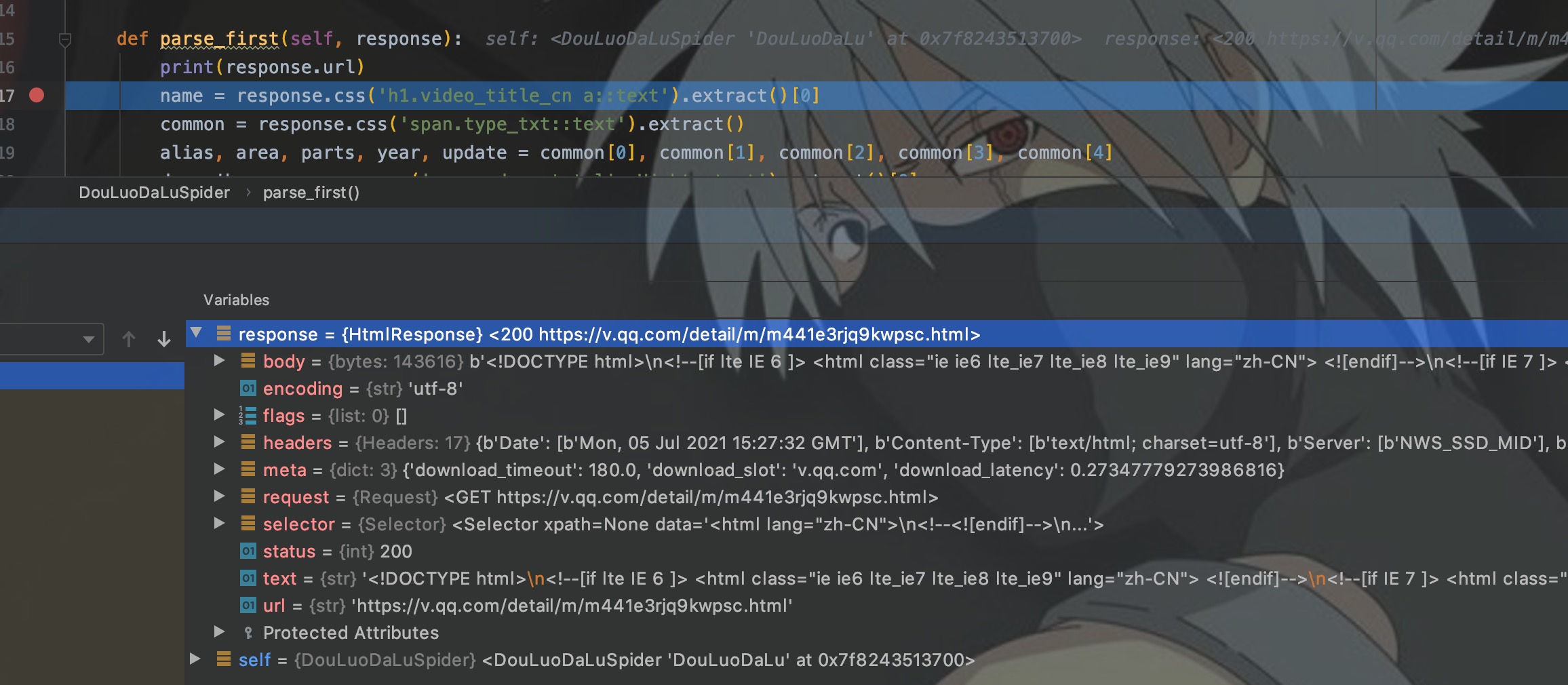

整体架构

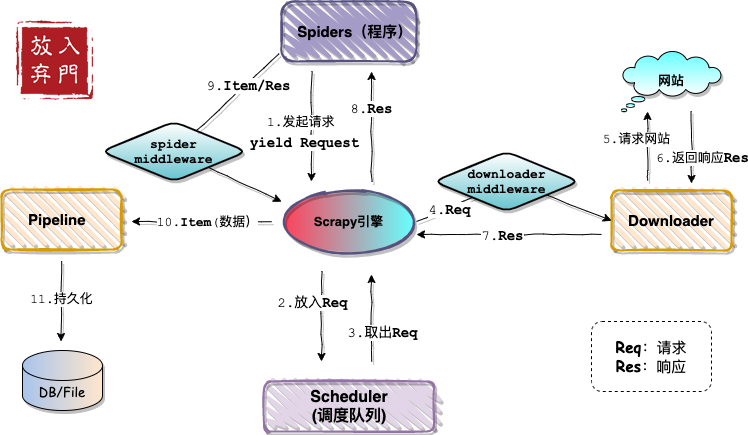

自己动手画架构图一张:

这就是Scrapy的整体架构,看起来流程比较复杂,但其实需要开发者参与的部分不多。这里先介绍一下各个部分。

- Spider:要开发的爬虫程序,用来定义网站入口,实现解析逻辑并发起请求。

- Pipeline:数据管道,可自定义实现数据持久化方式。

- Middleware:中间件,分为两类。一类是下载器中间件,主要处理请求,用于添加请求头、代理等;一类是spider中间件,用于处理响应,用的很少。

- Scheduler:调度器,用来存放爬虫程序的请求。

- Downloader:下载器。对目标网站发起请求,获取响应内容。

一个完整的爬虫,开发者需要参与1、2、3部分的开发。甚至最简单的爬虫,只需要开发Spider部分即可。

准备工作

安装Scrapy

Scrapy的安装和普通模块相同:

pip3 install scrapy

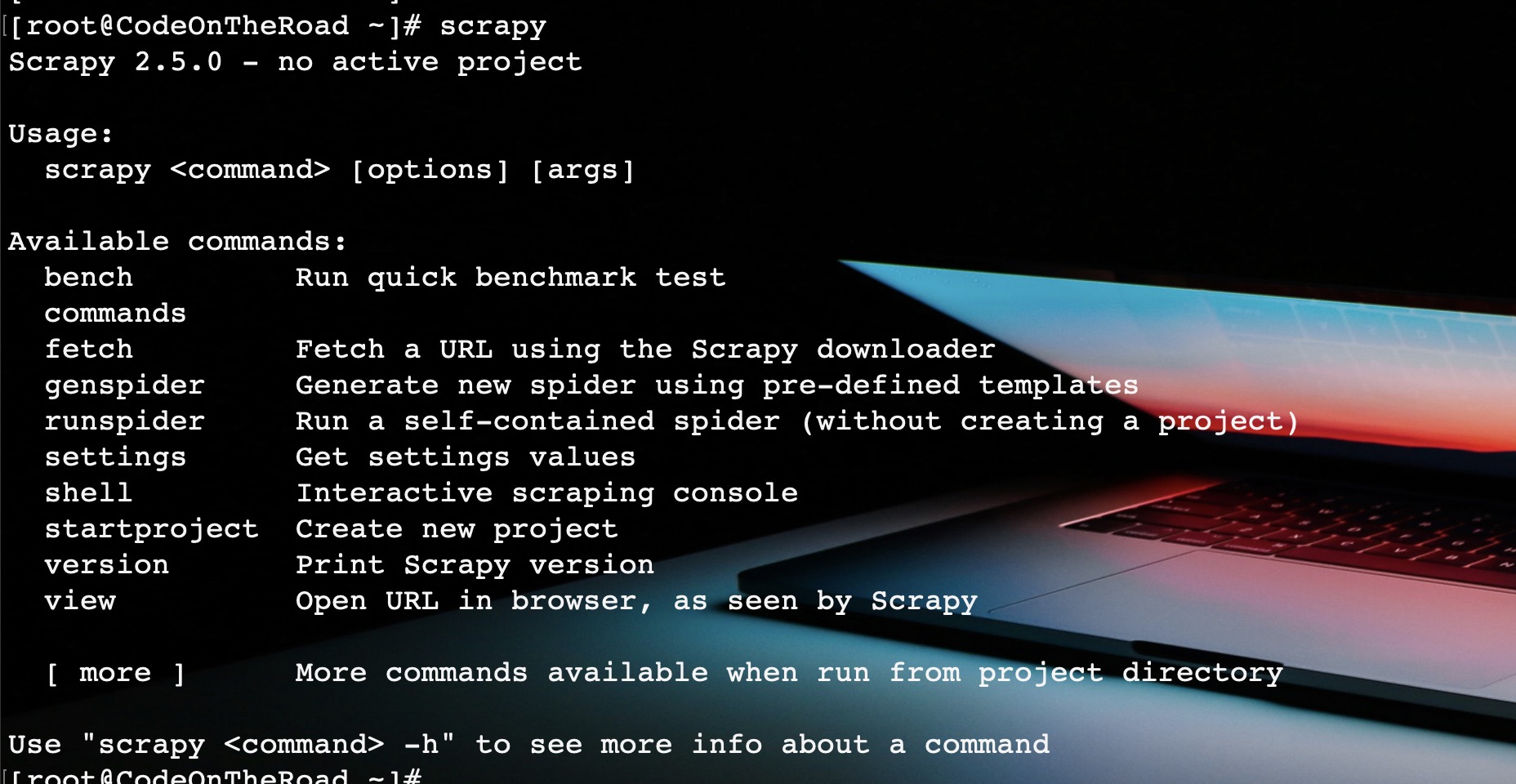

安装之后,就会多出一个scrapy命令,我们可以使用此命令来新建项目、新建爬虫程序、进入shell交互环境等等。

命令说明如下图:

新建项目

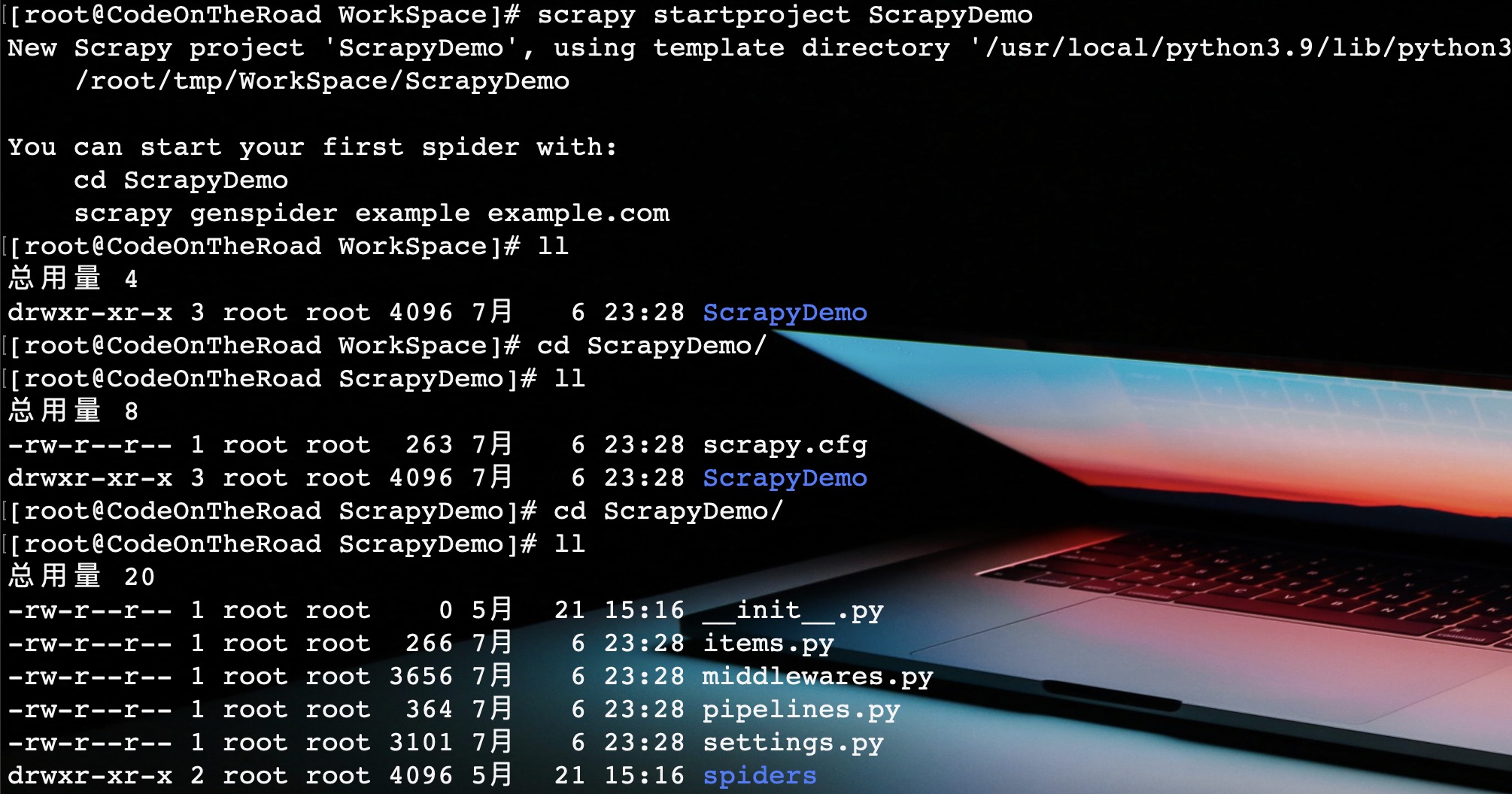

和普通python项目不同的是,Scrapy需要使用命令行新建项目,然后再导入IDE进行开发。

scrapy startproject [ProjectName]

执行上面命令,新建一个新的Scrapy项目。

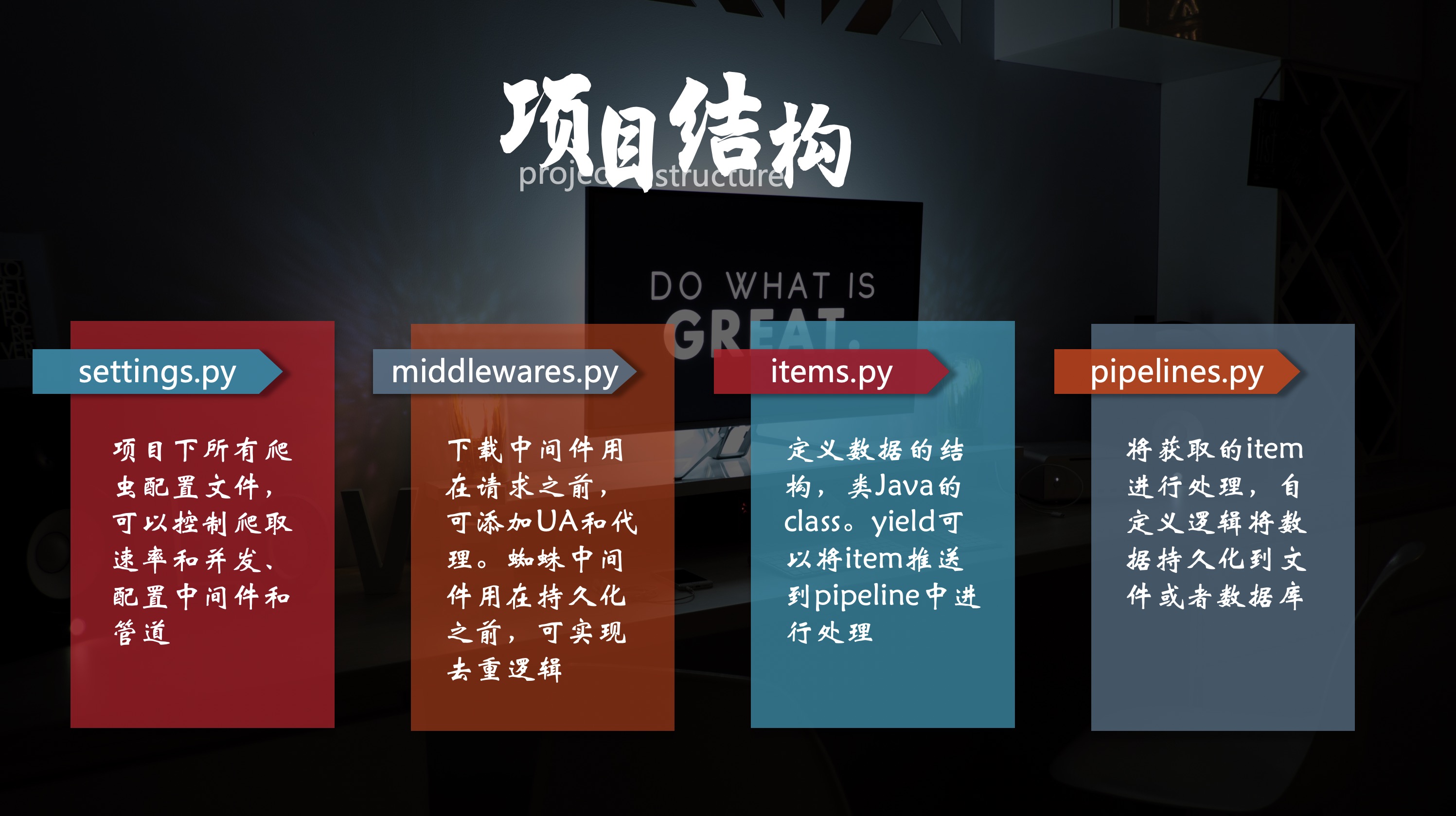

从项目结构可以看出,一个Scrapy项目分为四大模块,与架构中各个部分对应。

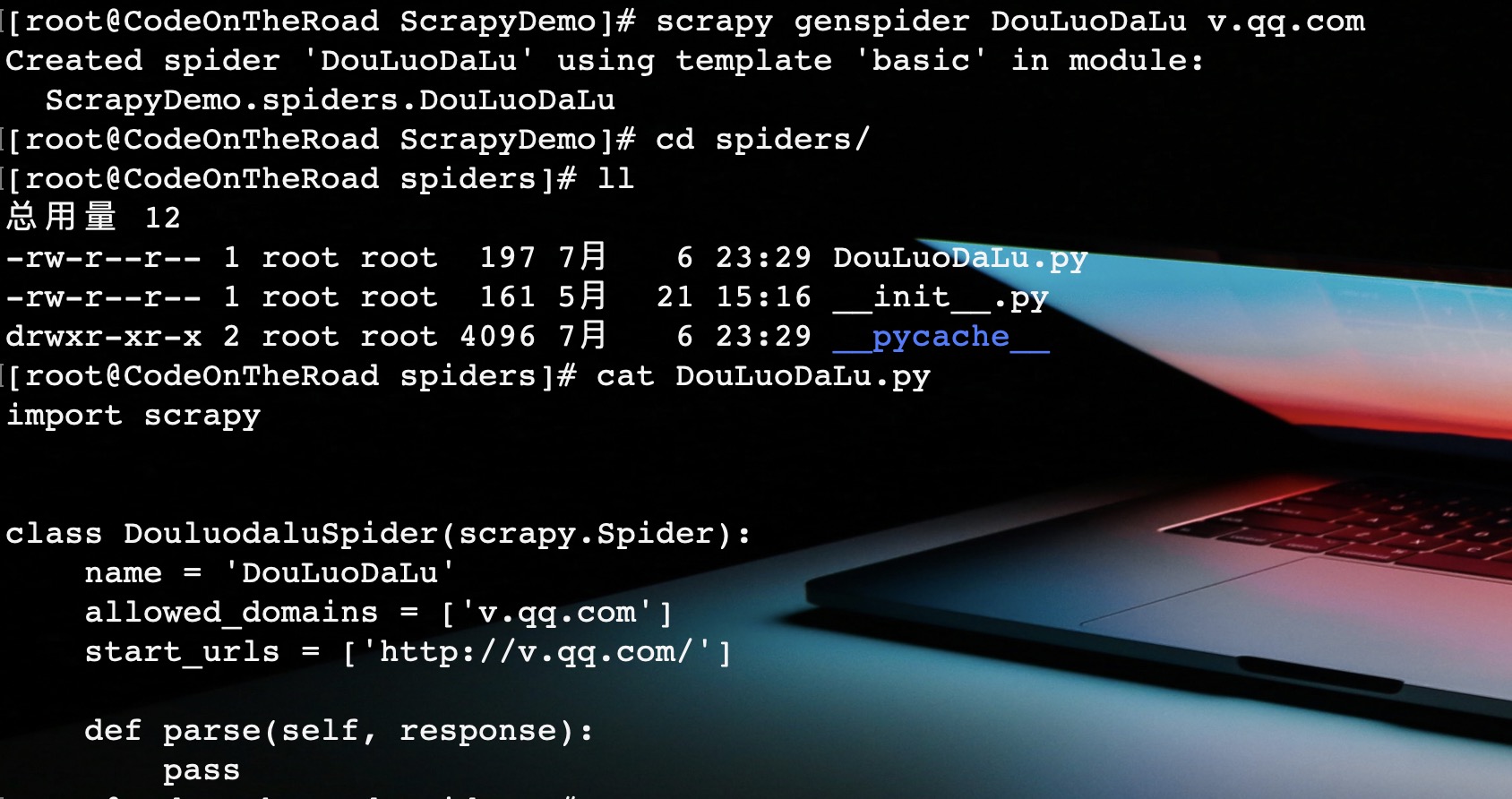

新建爬虫程序

将项目导入IDE,spiders包用于存放开发的爬虫程序。而爬虫程序的新建也是通过命令行操作。

# domain就是域名,例如百度域名就是www.baidu.com

scrapy genspider [SpiderName] [domin]

在本scrapy项目任何目录下的命令行中执行此命令,都会在spiders下新建一个爬虫程序。

爬虫程序开发

如图,scrapy爬虫程序已经生成,在其中实现解析规则代码即可完成开发。

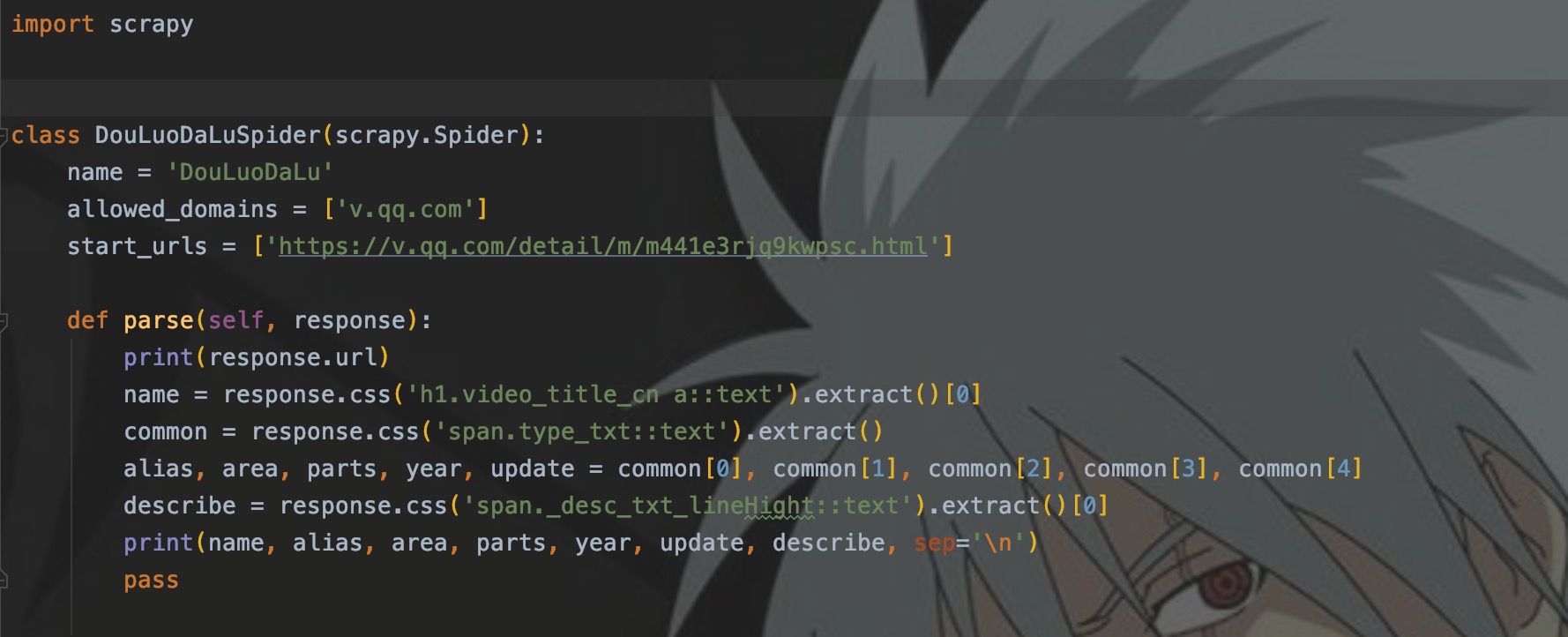

这里依然以斗罗大陆为例,程序代码如下。

程序结构

每个Scrapy程序都会有三个模块:

- name:每个项目中的爬虫的名称,作为唯一标识用于爬虫的启动

- allowed_domains:主要用于限定运行爬虫网站的域名

- start_urls::网站入口,起始url

- parse:预设的第一个解析函数

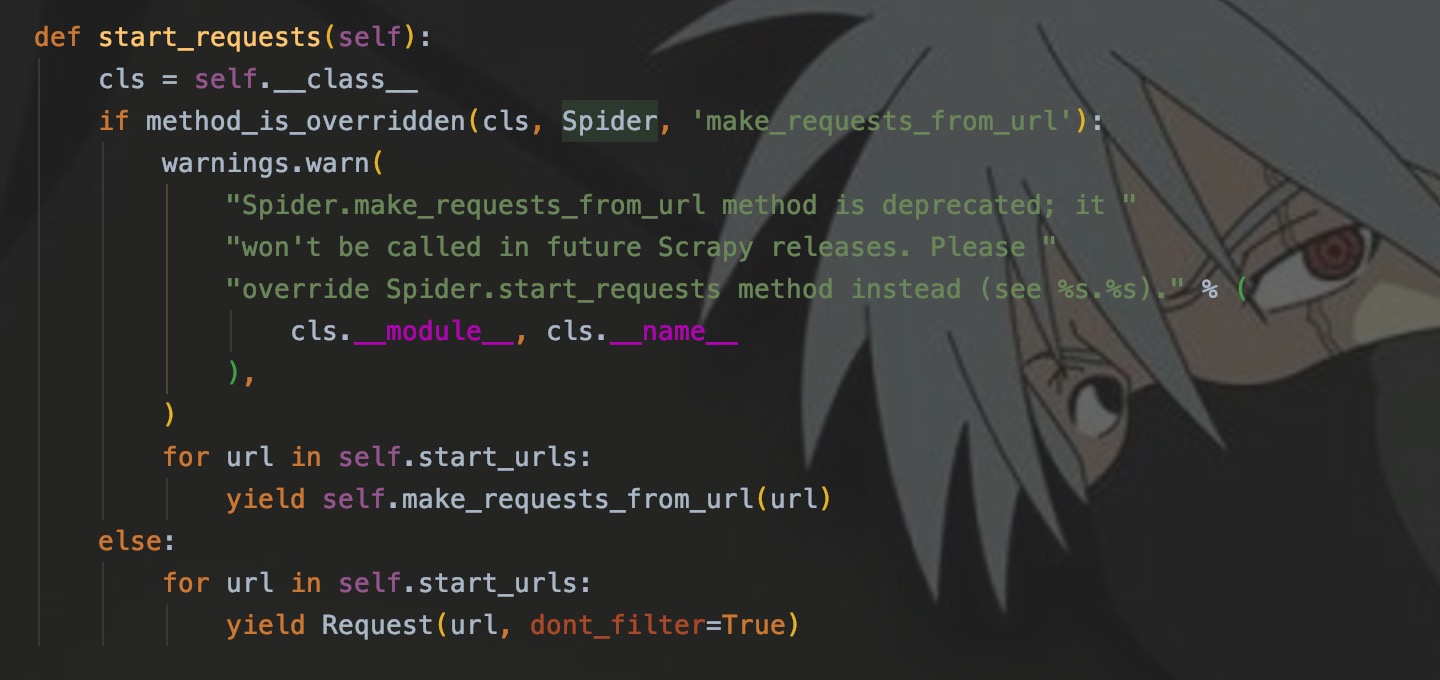

上面说道,start_urls是爬虫程序的入口,那么它是怎么发起请求,并将Res响应传给parse解析?作为一个list类型,是否可以有多个入口url?

start_requests()

每个爬虫程序都继承了Spider类,里面的start_requests方法用来发起请求,并自动将响应传递给parse()。

如图,我们可以看到,此方法遍历了start_urls来发起了请求。那么,我就不想传递给parse()解析,我就想自定义方法,啷个怎么办来?

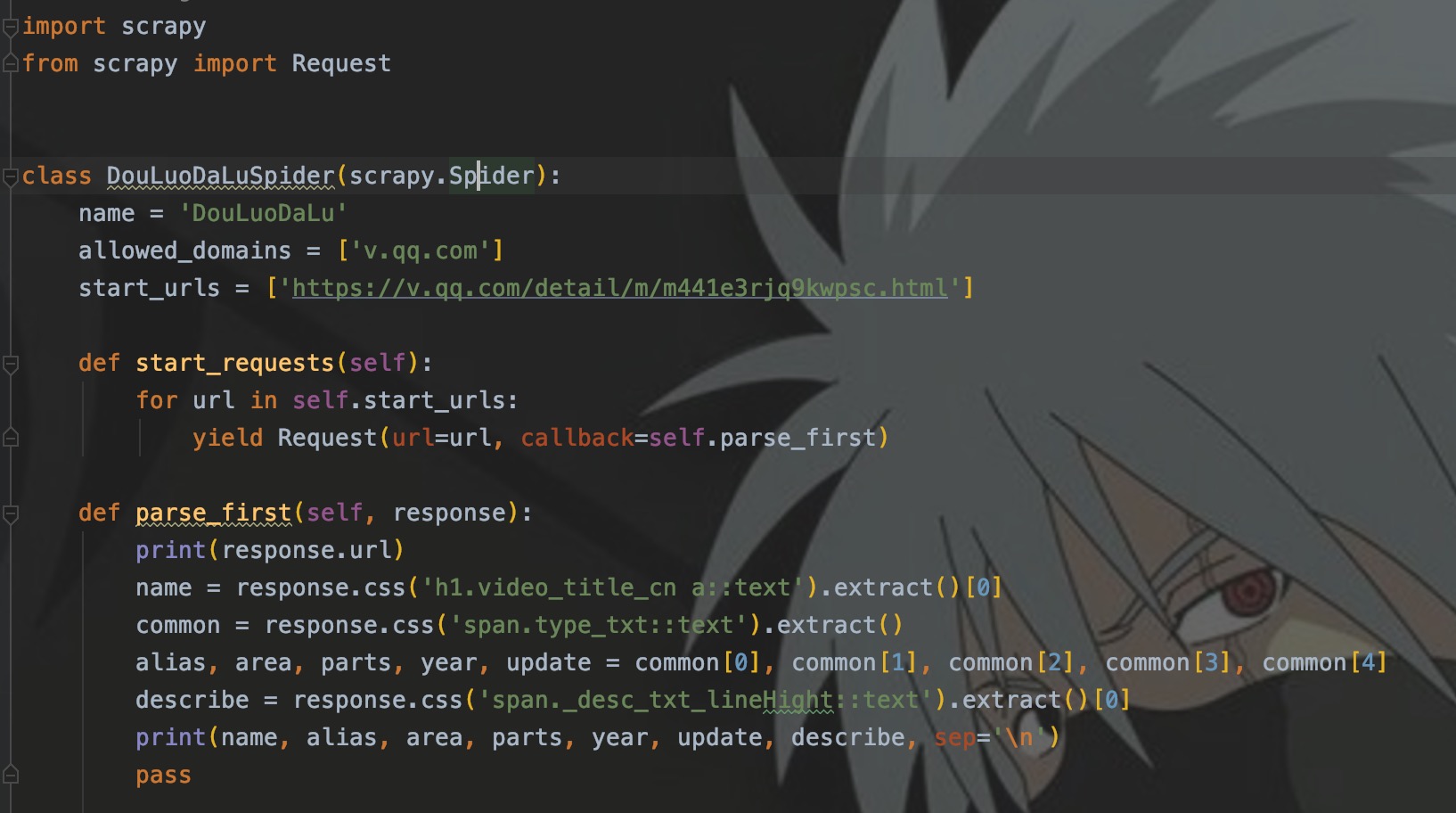

小事莫慌,我们重写start_requests就好了嘛。

如图,我们自定义了parse_first解析函数,在发起请求时使用callback来指定回调函数,这里记住:函数名一定不要加括号,加括号表示立即执行此函数,不加代表是引用。

修改后的程序输出结果和之前相同。

Request

我们使用yield Request发起一个请求,为什么不用return?因为yield不会立即返回,不会终结方法。这里就涉及到了生成器的问题,有兴趣的可以去研究一下。

Request使用的参数如下顺序排列:

- url:要请求的url

- callback:处理响应的回调函数

- meta:字典,通过响应传递kv数据给回调函数

- dont_filter:默认为False,即开启url去重。如果我们在start_urls写入两条一样的url时,只会输出一次结果,如果我们修改为True,则输出两次。

- method:请求方式,默认为get

- priority:请求优先级,默认为0,数值越大优先级越大

至于cookies、headers参数,我们可以在Request设置,但大多时候都是在下载器middleware中进行设置。

爬虫程序启动

Scrapy爬虫程序的启动主要有两种方式。

命令行启动

第一种就是在scrapy项目目录下的命令行下启动。

scrapy crawl [SpiderName]

这种启动方式的缺点显而易见,就是无法IDE中使用Debug功能,所以这种方式通常用于生产。

IDE启动

我们在开发过程中通常使用第二种启动方式,这也是符合我们常规启动程序的方式。新建一个python程序,引入命令行工具执行爬虫启动命令。

from scrapy.cmdline import execute

if __name__ == "__main__":

execute("scrapy crawl DouLuoDaLu".split(" "))

这样就可以在IDE中启动程序,并使用Debug功能。

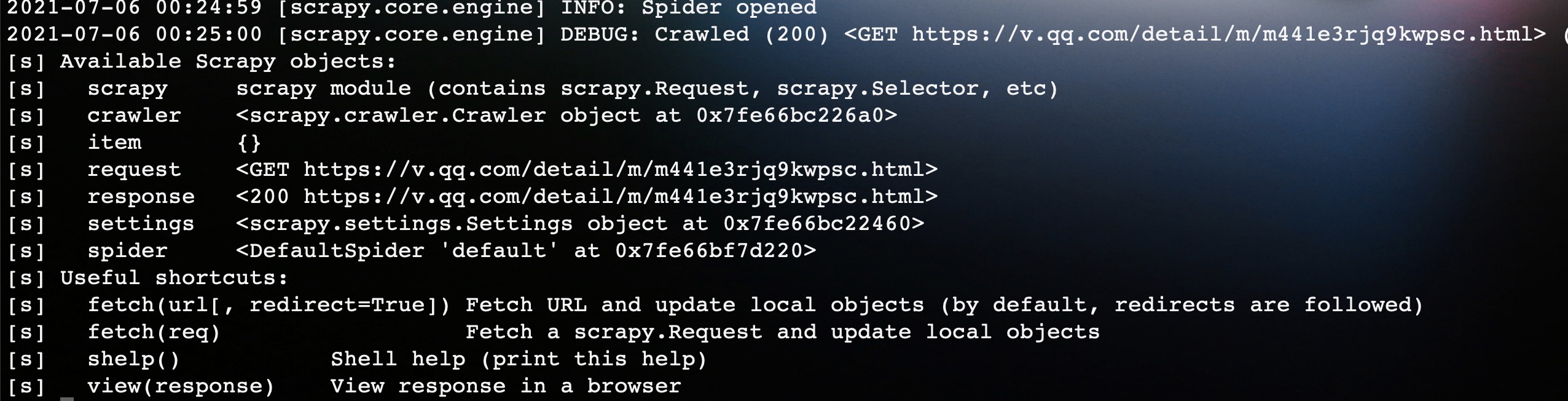

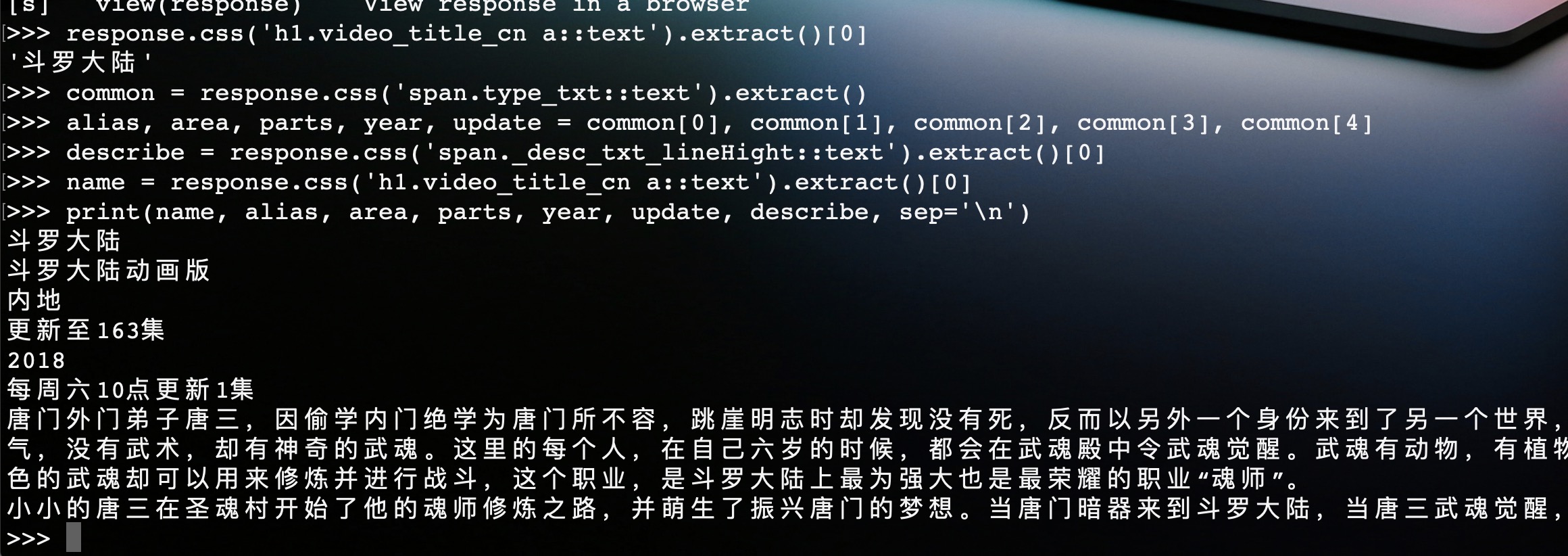

scrapy shell交互环境

我们可以shell交互环境中进行解析代码的调试。

scrapy shell https://v.qq.com/detail/m/m441e3rjq9kwpsc.html

输入命令回车,对斗罗大陆页面发起请求并进入shell环境。

如图所示,在进入shell环境后,自动封装了一些变量,这里我们只关注响应response。

如图,我们在shell交互环境中对网页进行了解析。这样,我们将测试好的解析代码复制到程序中即可,这样提高了开发效率。

输入view(response),敲击回车,将自动在浏览器打开页面。

结语

在样例程序中,请求和响应只在架构图右半边简单地流转,如果想要持久化,还需要定义pipeline等等,而且程序中也只写了一层解析函数,即parse()。

如果在parse中还要进行深度爬取,我们也要在parse中发起请求,并定义新的callback回调函数来进行解析,一直到我们想要的数据页面为止。当然,这些后面都会讲到。

自Scrapy系列写了开篇之后,就搁置了很久。一是最近的确挺忙的,二是Scrapy知识点比较多,一时间不知该从何处写起。不过我还是会继续写下去的,虽然可能更新的有点慢,欢迎小伙伴催更、也希望多多提出宝贵的意见。

95后小程序员,写的都是日常工作中的亲身实践,置身于初学者的角度从0写到1,详细且认真。

文章会在公众号 [入门到放弃之路] 首发,期待你的关注。

scrapy入门到放弃02:整一张架构图,开发一个程序的更多相关文章

- Scrapy入门到放弃04:下载器中间件,让爬虫更完美

前言 MiddleWare,顾名思义,中间件.主要处理请求(例如添加代理IP.添加请求头等)和处理响应 本篇文章主要讲述下载器中间件的概念,以及如何使用中间件和自定义中间件. MiddleWare分类 ...

- Scrapy入门到放弃06:Spider中间件

前言 写一写Spider中间件吧,都凌晨了,一点都不想写,主要是也没啥用...哦不,是平时用得少.因为工作上的事情,已经拖更好久了,这次就趁着半夜写一篇. Scrapy-deltafetch插件是在S ...

- Scrapy入门到放弃01:开启爬虫2.0时代

前言 Scrapy is coming!! 在写了七篇爬虫基础文章之后,终于写到心心念念的Scrapy了.Scrapy开启了爬虫2.0的时代,让爬虫以一种崭新的形式呈现在开发者面前. 在18年实习的时 ...

- Scrapy入门到放弃03:理解settings配置,监控Scrapy引擎

前言 代码未动,配置先行.本篇文章主要讲述一下Scrapy中的配置文件settings.py的参数含义,以及如何去获取一个爬虫程序的运行性能指标. 这篇文章无聊的一匹,没有代码,都是配置化的东西,但是 ...

- Scrapy入门到放弃05:让Item在Pipeline中飞一会儿

前言 "又回到最初的起点,呆呆地站在镜子前". 本来这篇是打算写Spider中间件的,但是因为这一块涉及到Item,所以这篇文章先将Item讲完,顺便再讲讲Pipeline,然后再 ...

- Java从入门到放弃——02.常量、变量、数据类型、运算符

本文目标 理解什么是常量,什么是变量 认识八大基本数据类型 了解算数运算符.赋值运算符.关系运算符.逻辑运算符.位运算符.三元运算符 1.什么是常量与变量? 常量是相对静止的量,比如整数:1,2,3 ...

- php从入门到放弃系列-02.php基础语法

php从入门到放弃系列-02.php基础语法 一.学习语法,从hello world开始 PHP(全称:PHP:Hypertext Preprocessor,即"PHP:超文本预处理器&qu ...

- 爬虫入门到放弃系列02:html网页如何解析

前言 上一篇文章讲了爬虫的概念,本篇文章主要来讲述一下如何来解析爬虫请求的网页内容. 一个简单的爬虫程序主要分为两个部分,请求部分和解析部分.请求部分基本一行代码就可以搞定,所以主要来讲述一下解析部分 ...

- Python爬虫从入门到放弃(十三)之 Scrapy框架的命令行详解

这篇文章主要是对的scrapy命令行使用的一个介绍 创建爬虫项目 scrapy startproject 项目名例子如下: localhost:spider zhaofan$ scrapy start ...

随机推荐

- 一文搞懂:java中的VO、PO、BO、DAO、POJO

针对java工程里的各种带O的对象,进行分析,了解各自的作用. PO:persistent object,持久对象.与数据库里表字段一一对应.PO是一些属性,以及set和get方法组成.一般情况下,一 ...

- 四大浏览器JavaScript性能/硬件加速测试

四大浏览器JavaScript性能/硬件加速测试 出处:快科技 2010-09-19 10:52:59 人气: 27925 次 作者:萧萧 编辑:萧萧[爆料] 评论(42) 收藏文章 新 ...

- mysql简单教程-(转自wid)

21分钟 MySQL 入门教程 目录 一.MySQL的相关概念介绍 二.Windows下MySQL的配置 配置步骤 MySQL服务的启动.停止与卸载 三.MySQL脚本的基本组成 四.MySQL中的数 ...

- 什么是FOC

https://zhidao.baidu.com/question/354536332.html FOC简述 磁场定向控制系统(FOC)又称为矢量控制系统,他是选择电机某一旋转磁场轴作为特定的同步旋转 ...

- GPIO端口上拉下拉 与 硬件图的上拉下拉

硬件图上的上拉下拉: 没有触发时默认接到IO的是高电平就是上拉: 没有触发时默认接到IO的是低电平就是 下拉: (2)对应GPIO的配置 配置与你的外围电路息息相关: 比如下图: 你只能配置为上拉: ...

- Java Bean(Day_05)

我们一路奋战,不是为了改变世界,而是为了不让世界改变我们. 运行环境 JDK8 + IntelliJ IDEA 2018.3 本文中使用的jar包链接 https://files.cnblogs.co ...

- 调试备忘录-SWD协议解析

目录--点击可快速直达 目录 写在前面 1 SWD协议简介 2 SWD物理层协议解析 2.1 SWD通信时序分析 2.2 SWD 寄存器简介 2.2.1 DP寄存器 2.2.2 AP寄存器 ...

- SpringMVC=>解决JSON乱码问题

<!-- 解决JSON乱码问题 --> <mvc:annotation-driven> <mvc:message-converters register-defaults ...

- 【greys使用】阿里greys在线诊断工具

Greys是一个Java进程的异常诊断工具,可以在不停止程序的前提下,对一些问题进行检测.这个框架主要是采用Java的探针技术,可以做到动态修改java的字节码技术.前提是Jdk版本6+.(prema ...

- C++ 扩展 Op

C++ 扩展 Op 本文将介绍如何使用 C++ 扩展 Op,与用 Python 扩展 Op 相比,使用 C++ 扩展 Op,更加灵活.可配置的选项更多,且支持使用 GPU 作为计算设备.一般可使用 P ...