scrapy实例matplotlib脚本下载

利用scrapy框架实现matplotlib实例脚本批量下载至本地并进行文件夹分类;话不多说上代码:

首先是爬虫代码:

import scrapy

from scrapy.linkextractors import LinkExtractor

from urllib.parse import urljoin

from ..items import MatplotlibExamplesItem class MatExamplesSpider(scrapy.Spider):

name = 'mat_examples'

# allowed_domains = ['matplotlib.org']

start_urls = ['https://matplotlib.org/gallery/index.html'] def parse(self, response):

le = LinkExtractor(restrict_xpaths='//span[contains(@class, "caption-text")]/a[contains(@class, "reference internal")]')

links = le.extract_links(response)

for link in links:

yield scrapy.Request(link.url, callback=self.parse_mat)

def parse_mat(self, response):

href = response.xpath('//div[contains(@class, "docutils container")]/a/@href').extract_first()

# print('href:', href)

url = response.urljoin(href)

# print('url:', url)

example = MatplotlibExamplesItem()

example['file_urls'] = [url]

return example

分析代码:

parse函数主要为了获取初始url中的所有实例所在页面的url,通过yield输出scrapy.Request中的callback来调用parse_mat函数,下面继续介绍parse_mat函数的作用;

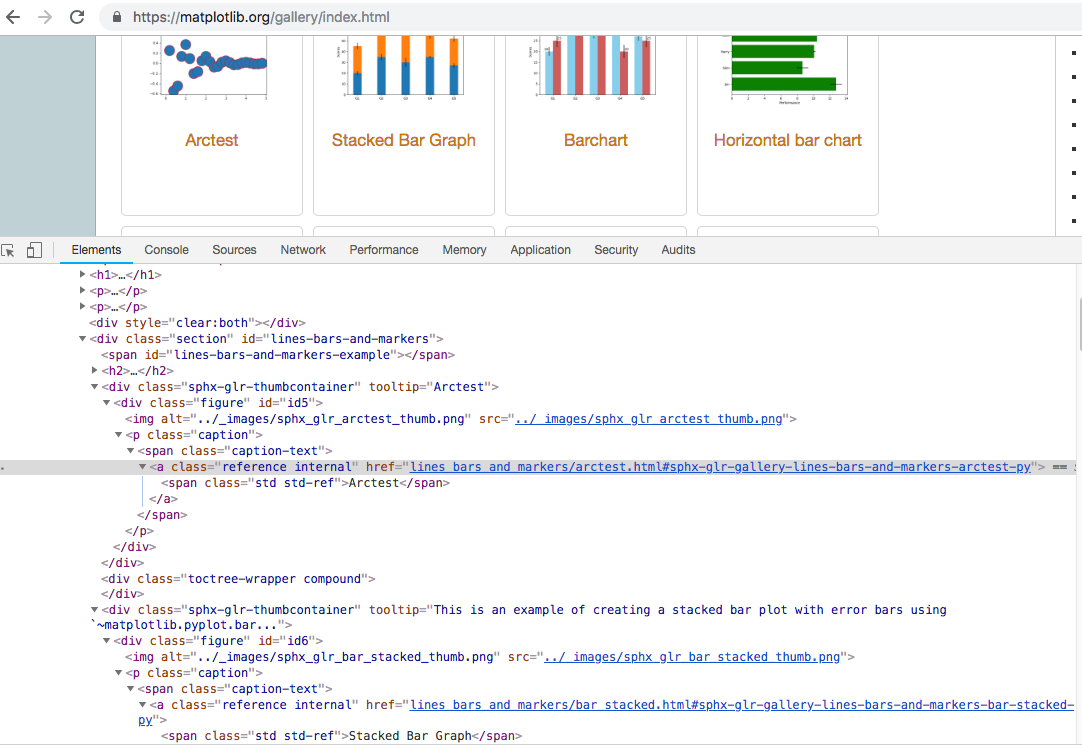

le = LinkExtractor(restrict_xpaths='//span[contains(@class, "caption-text")]/a[contains(@class, "reference internal")]')

此处代码主要是为了获取单个实例代码所在页面链接,如下图示:

parse_mat函数主要是为了获取每个实例所在的下载链接,并存入item中返回至pipelines中进行下载;

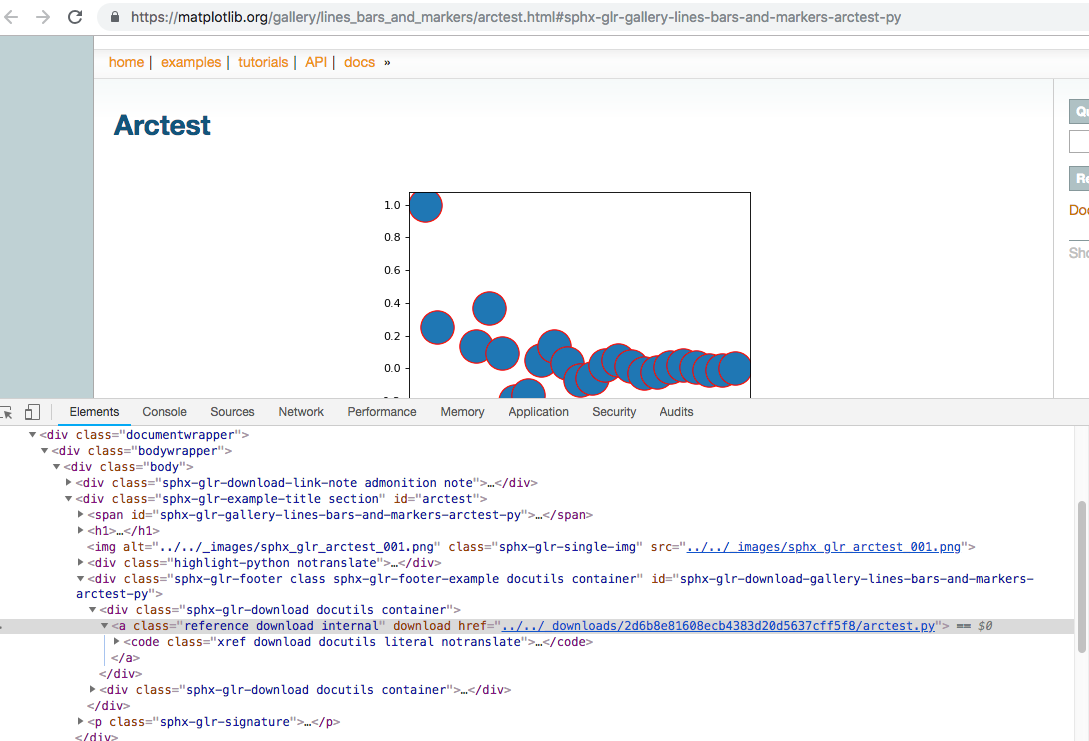

href = response.xpath('//div[contains(@class, "docutils container")]/a/@href').extract_first() ---通过xpath规则获取对应的下载链接;

url = response.urljoin(href) ---通过urljoin方法将链接补全;

example = MatplotlibExamplesItem()

example['file_urls'] = [url] ----存入item中返回

下图为显示下载链接所在页面位置,便于使用xpath规则获取链接;

接下来写pipelines代码,具体代码如下:

from scrapy.pipelines.files import FilesPipeline

from urllib.parse import urlparse

from os.path import basename, dirname, join class MatplotlibExamplesFilesPipeline(FilesPipeline):

"""docstring for Matploitem, spiderbExamplesFilesPipeline"""

def file_path(self, request, response=None, info=None):

# print('rl:', request.url)

path = urlparse(request.url).path

print('path', path)

# return join(basename(dirname(path)), basename(path))

return join(basename(path).split('.')[0], basename(path))

通过重写file_path方法保存下载文件,至于文件下载的文件或者路径可在setting中配置;

分析代码:

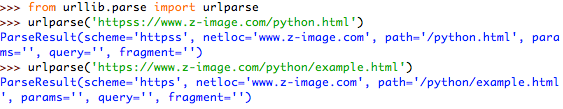

path = urlparse(request.url).path ---通过urlparse方法将url进行分解,以下用实例进行介绍该方法的输出:

实例1:介绍urlparse方法的输出

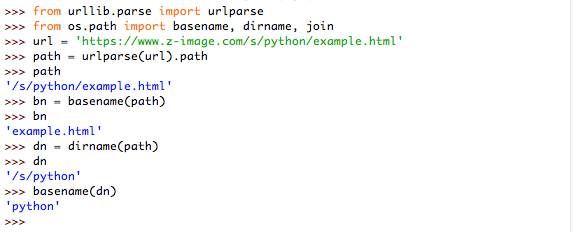

实例2:介绍basename与dirname方法的输出

return join(basename(path).split('.')[0], basename(path))

由于获取的下载链接:https://matplotlib.org/_downloads/2d6b8e81608ecb4383d20d5637cff5f8/arctest.py

所以basename(dirname(path))得到的是一串’2d6b8e81608ecb4383d20d5637cff5f8‘哈希值,于是就直接用basename(path).split('.')[0]为文件夹的名字

接下来写上简单的item的代码(这个代码最简单了,就是写url和file):

import scrapy class MatplotlibExamplesItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

file_urls = scrapy.Field()

files = scrapy.Field()

最后贴上setting的代码:

BOT_NAME = 'matplotlib_examples' SPIDER_MODULES = ['matplotlib_examples.spiders']

NEWSPIDER_MODULE = 'matplotlib_examples.spiders' ITEM_PIPELINES = {

# 'scrapy.pipelines.files.FilesPipeline':1,

'matplotlib_examples.pipelines.MatplotlibExamplesFilesPipeline':1,

}

FILES_STORE = 'result' # Obey robots.txt rules

ROBOTSTXT_OBEY = False # Disable cookies (enabled by default)

COOKIES_ENABLED = False # Override the default request headers:

DEFAULT_REQUEST_HEADERS = {

'user-agent' : 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36'

}

'BOT_NAME' ----爬虫项目名称;一般进行新建scrapy爬虫后都自动写入了;

'ITEM_PIPELINES ' ---此处记得改为自己写的pipelines类名;

'FILES_STORE' ---此处为下载文件所在的文件夹;

其他的配置就基本了;例如是否遵循robots.txt协议,是否用cookies,user-agent改为与浏览器相同,这些都是为了避免被‘ban’;

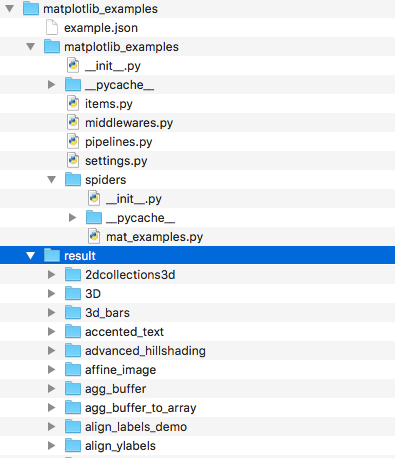

最后的最后附上项目:

scrapy实例matplotlib脚本下载的更多相关文章

- 爬虫入门六 总结 资料 与Scrapy实例-bibibili番剧信息

title: 爬虫入门六 总结 资料 与Scrapy实例-bibibili番剧信息 date: 2020-03-16 20:00:00 categories: python tags: crawler ...

- 10个提供免费PHP脚本下载的网站

本文将重点介绍10个PHP脚本的免费资源下载站.之前推荐 <16个下载超酷脚本的热门网站>,这些网站除了PHP脚本,还有JavaScript.Java.Perl.ASP等脚本.如果你已是脚 ...

- Python爬虫框架Scrapy实例(三)数据存储到MongoDB

Python爬虫框架Scrapy实例(三)数据存储到MongoDB任务目标:爬取豆瓣电影top250,将数据存储到MongoDB中. items.py文件复制代码# -*- coding: utf-8 ...

- 第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器 编写spiders爬虫文件循环 ...

- 第三百二十五节,web爬虫,scrapy模块标签选择器下载图片,以及正则匹配标签

第三百二十五节,web爬虫,scrapy模块标签选择器下载图片,以及正则匹配标签 标签选择器对象 HtmlXPathSelector()创建标签选择器对象,参数接收response回调的html对象需 ...

- python爬虫脚本下载YouTube视频

python爬虫脚本下载YouTube视频 爬虫 python YouTube视频 工作环境: python 2.7.13 pip lxml, 安装 pip install lxml,主要用xpath ...

- 二十 Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

编写spiders爬虫文件循环抓取内容 Request()方法,将指定的url地址添加到下载器下载页面,两个必须参数, 参数: url='url' callback=页面处理函数 使用时需要yield ...

- python脚本下载 Google Driver 文件

使用python脚本下载 Google Driver 文件 import yaml import sys import requests import os import re import tarf ...

- Python爬虫框架Scrapy实例(四)下载中间件设置

还是豆瓣top250爬虫的例子,添加下载中间件,主要是设置动态Uesr-Agent和代理IP Scrapy代理IP.Uesr-Agent的切换都是通过DOWNLOADER_MIDDLEWARES进行控 ...

随机推荐

- java多线程——线程通信

一.线程通信目标 1.线程通信的目标是使线程间能够互相发送信号 2.线程通信使线程能够等待其他线程的信号 二.几种方式 1.通过共享对象 2.忙等待 线程 B 运行在一个循环里,以等待信号 (不释放c ...

- (C语言版)链表(三)——实现双向链表创建、删除、插入、释放内存等简单操作

上午写了下单向循环链表的程序,今天下午我把双向链表的程序写完了.其实双向链表和单向链表也是有很多相似的地方的,听名字可以猜到,每个节点都包含两个指针,一个指针指向上一个节点,一个指针指向下一个节点.这 ...

- tiny4412 裸机程序 五、控制icache【转】

本文转载自:http://blog.csdn.net/eshing/article/details/37115411 版权声明:本文为博主原创文章,未经博主允许不得转载. 目录(?)[+] 一 ...

- Codeforces--622A--Infinite Sequence(数学)

Infinite Sequence Crawling in process... Crawling failed Time Limit:1000MS Memory Limit:26214 ...

- JSP-Runoob:JSP 指令

ylbtech-JSP-Runoob:JSP 指令 1.返回顶部 1. JSP 指令 JSP指令用来设置整个JSP页面相关的属性,如网页的编码方式和脚本语言. 语法格式如下: <%@ direc ...

- jeesite ckfinder mac/linux 文件上传路径设置

背景: 如果你使用的是Mac 或者 Ubuntu 这种 Unix系统的话,你一定知道Unix系统的文件路径分隔符是 / 而Windows系统文件分隔符是 \ 当你设置了jeesite.properti ...

- Counterfeit Dollar

http://poj.org/problem?id=1013 #include<stdio.h> #include<string.h> #include<math.h&g ...

- html5做的一个激光条

<!DOCTYPE HTML><html lang="zh-cn"><head> <title>CSS3激光加载条</titl ...

- [Swift通天遁地]四、网络和线程-(5)解析网络请求数据:String(字符串)、Data(二进制数据)和JSON数据

★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★★➤微信公众号:山青咏芝(shanqingyongzhi)➤博客园地址:山青咏芝(https://www.cnblogs. ...

- 常用mysql记录

多个关键词 like$joinwhere .=" and CONCAT(`JpTel`,`JpName`) Like '%$keywords%' ";