机器学习基础02DAY

数据的特征预处理

单个特征

(1)归一化

归一化首先在特征(维度)非常多的时候,可以防止某一维或某几维对数据影响过大,也是为了把不同来源的数据统一到一个参考区间下,这样比较起来才有意义,其次可以程序可以运行更快。 例如:一个人的身高和体重两个特征,假如体重50kg,身高175cm,由于两个单位不一样,数值大小不一样。如果比较两个人的体型差距时,那么身高的影响结果会比较大,k-临近算法会有这个距离公式。

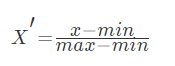

min-max方法

常用的方法是通过对原始数据进行线性变换把数据映射到[0,1]之间,变换的函数为:

其中min是样本中最小值,max是样本中最大值,注意在数据流场景下最大值最小值是变化的,另外,最大值与最小值非常容易受异常点影响,所以这种方法鲁棒性较差,只适合传统精确小数据场景。

- min-max自定义处理

import numpy as np

def data_matrix(file_name):

"""

将文本转化为matrix

:param file_name: 文件名

:return: 数据矩阵

"""

fr = open(file_name)

array_lines = fr.readlines()

number_lines = len(array_lines)

return_mat = zeros((number_lines, 3))

# classLabelVector = []

index = 0

for line in array_lines:

line = line.strip()

list_line = line.split('\t')

return_mat[index,:] = list_line[0:3]

# if(listFromLine[-1].isdigit()):

# classLabelVector.append(int(listFromLine[-1]))

# else:

# classLabelVector.append(love_dictionary.get(listFromLine[-1]))

# index += 1

return return_mat

输出结果为

[[ 4.09200000e+04 8.32697600e+00 9.53952000e-01]

[ 1.44880000e+04 7.15346900e+00 1.67390400e+00]

[ 2.60520000e+04 1.44187100e+00 8.05124000e-01]

...,

[ 2.65750000e+04 1.06501020e+01 8.66627000e-01]

[ 4.81110000e+04 9.13452800e+00 7.28045000e-01]

[ 4.37570000e+04 7.88260100e+00 1.33244600e+00]]

我们查看数据集会发现,有的数值大到几万,有的才个位数,同样如果计算两个样本之间的距离时,其中一个影响会特别大。也就是说飞行里程数对于结算结果或者说相亲结果影响较大,但是统计的人觉得这三个特征同等重要,所以需要将数据进行这样的处理。

这样每个特征任意的范围将变成[0,1]的区间内的值,或者也可以根据需求处理到[-1,1]之间,我们再定义一个函数,进行这样的转换。

def feature_normal(data_set):

"""

特征归一化

:param data_set:

:return:

"""

# 每列最小值

min_vals = data_set.min(0)

# 每列最大值

max_vals = data_set.max(0)

ranges = max_vals - min_vals

norm_data = np.zeros(np.shape(data_set))

# 得出行数

m = data_set.shape[0]

# 矩阵相减

norm_data = data_set - np.tile(min_vals, (m,1))

# 矩阵相除

norm_data = norm_data/np.tile(ranges, (m, 1)))

return norm_data

输出结果为

[[ 0.44832535 0.39805139 0.56233353]

[ 0.15873259 0.34195467 0.98724416]

[ 0.28542943 0.06892523 0.47449629]

...,

[ 0.29115949 0.50910294 0.51079493]

[ 0.52711097 0.43665451 0.4290048 ]

[ 0.47940793 0.3768091 0.78571804]]

这样得出的结果都非常相近,这样的数据可以直接提供测试验证了

- min-max的scikit-learn处理

scikit-learn.preprocessing中的类MinMaxScaler,将数据矩阵缩放到[0,1]之间

>>> X_train = np.array([[ 1., -1., 2.],

... [ 2., 0., 0.],

... [ 0., 1., -1.]])

...

>>> min_max_scaler = preprocessing.MinMaxScaler()

>>> X_train_minmax = min_max_scaler.fit_transform(X_train)

>>> X_train_minmax

array([[ 0.5 , 0. , 1. ],

[ 1. , 0.5 , 0.33333333],

[ 0. , 1. , 0. ]])

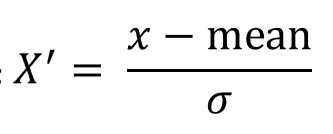

(3)标准化

常用的方法是z-score标准化,经过处理后的数据均值为0,标准差为1,处理方法是:

作用于每一列,mean为平均值,σ为标准差(考量数据的稳定性)

它们可以通过现有的样本进行估计,在已有的样本足够多的情况下比较稳定,适合嘈杂的数据场景

sklearn中提供了StandardScalar类实现列标准化:

In [2]: import numpy as np

In [3]: X_train = np.array([[ 1., -1., 2.],[ 2., 0., 0.],[ 0., 1., -1.]])

In [4]: from sklearn.preprocessing import StandardScaler

In [5]: std = StandardScaler()

In [6]: X_train_std = std.fit_transform(X_train)

In [7]: X_train_std

Out[7]:

array([[ 0. , -1.22474487, 1.33630621],

[ 1.22474487, 0. , -0.26726124],

[-1.22474487, 1.22474487, -1.06904497]])

(3)缺失值

由于各种原因,许多现实世界的数据集包含缺少的值,通常编码为空白,NaN或其他占位符。然而,这样的数据集与scikit的分类器不兼容,它们假设数组中的所有值都是数字,并且都具有和保持含义。使用不完整数据集的基本策略是丢弃包含缺失值的整个行和/或列。然而,这是以丢失可能是有价值的数据(即使不完整)的代价。更好的策略是估算缺失值,即从已知部分的数据中推断它们。

(1)填充缺失值 使用sklearn.impute中的SimpleImputerr类进行数据的填充

#导入imputer

from sklearn.impute import SimpleImputer

import numpy as np

data = [[1, 2, np.nan], [4, np.nan, 6], [7, 8, 9]]

#实例化

imp = SimpleImputer(missing_values=np.nan, strategy="mean")

#数据填充

result = imp.fit_transform(data)

result

#结果

array([[1. , 2. , 7.5],

[4. , 5. , 6. ],

[7. , 8. , 9. ]])

数据预处理

归一化处理

In [ ]:

# MinMaxScaler导入包

from sklearn.preprocessing import MinMaxScaler

data = [[90, 2, 10, 40],

[60, 4, 15, 45],

[75, 3, 13, 46]]

# 实例化 feature_range默认(0,1)

mms = MinMaxScaler(feature_range=(0,1))

#归一化处理

rusult = mms.fit_transform(data)

rusult

Out[ ]:

array([[1. , 0. , 0. , 0. ],

[0. , 1. , 1. , 0.83333333],

[0.5 , 0.5 , 0.6 , 1. ]])

标准化处理

In [ ]:

#导入StandardScaler包

from sklearn.preprocessing import StandardScaler

data = [[ 1., -1., 3.],

[ 2., 4., 2.],

[ 4., 6., -1.]]

#实例化

sds = StandardScaler()

#标准化处理

result = sds.fit_transform(data)

result

Out[ ]:

array([[-1.06904497, -1.35873244, 0.98058068],

[-0.26726124, 0.33968311, 0.39223227],

[ 1.33630621, 1.01904933, -1.37281295]])

In [ ]:

# 查看原始数据中每个特征的平均值

sds.mean_

Out[ ]:

array([2.33333333, 3. , 1.33333333])

In [ ]:

#查看原始数据每列特征的方差

sds.var_

Out[ ]:

array([1.55555556, 8.66666667, 2.88888889])

缺失值处理

In [ ]:

#导入imputer

from sklearn.impute import SimpleImputer

import numpy as np

data = [[1, 2, np.nan], [4, np.nan, 6], [7, 8, 9]]

#实例化

imp = SimpleImputer(missing_values=np.nan, strategy="mean")

#数据填充

result = imp.fit_transform(data)

result

Out[ ]:

array([[1. , 2. , 7.5],

[4. , 5. , 6. ],

[7. , 8. , 9. ]])

机器学习基础02DAY的更多相关文章

- Coursera 机器学习课程 机器学习基础:案例研究 证书

完成了课程1 机器学习基础:案例研究 贴个证书,继续努力完成后续的课程:

- Coursera台大机器学习基础课程1

Coursera台大机器学习基础课程学习笔记 -- 1 最近在跟台大的这个课程,觉得不错,想把学习笔记发出来跟大家分享下,有错误希望大家指正. 一 机器学习是什么? 感觉和 Tom M. Mitche ...

- 机器学习 —— 基础整理(六)线性判别函数:感知器、松弛算法、Ho-Kashyap算法

这篇总结继续复习分类问题.本文简单整理了以下内容: (一)线性判别函数与广义线性判别函数 (二)感知器 (三)松弛算法 (四)Ho-Kashyap算法 闲话:本篇是本系列[机器学习基础整理]在time ...

- 算法工程师<机器学习基础>

<机器学习基础> 逻辑回归,SVM,决策树 1.逻辑回归和SVM的区别是什么?各适用于解决什么问题? https://www.zhihu.com/question/24904422 2.L ...

- 数据分析之Matplotlib和机器学习基础

一.Matplotlib基础知识 Matplotlib 是一个 Python 的 2D绘图库,它以各种硬拷贝格式和跨平台的交互式环境生成出版质量级别的图形. 通过 Matplotlib,开发者可以仅需 ...

- 【dlbook】机器学习基础

[机器学习基础] 模型的 vc dimension 如何衡量? 如何根据网络结构衡量模型容量?有效容量和模型容量之间的关系? 统计学习理论中边界不用于深度学习之中,原因? 1.边界通常比较松, 2.深 ...

- Python机器学习基础教程-第2章-监督学习之决策树集成

前言 本系列教程基本就是摘抄<Python机器学习基础教程>中的例子内容. 为了便于跟踪和学习,本系列教程在Github上提供了jupyter notebook 版本: Github仓库: ...

- Python机器学习基础教程-第2章-监督学习之决策树

前言 本系列教程基本就是摘抄<Python机器学习基础教程>中的例子内容. 为了便于跟踪和学习,本系列教程在Github上提供了jupyter notebook 版本: Github仓库: ...

- Python机器学习基础教程-第2章-监督学习之线性模型

前言 本系列教程基本就是摘抄<Python机器学习基础教程>中的例子内容. 为了便于跟踪和学习,本系列教程在Github上提供了jupyter notebook 版本: Github仓库: ...

- Python机器学习基础教程-第2章-监督学习之K近邻

前言 本系列教程基本就是摘抄<Python机器学习基础教程>中的例子内容. 为了便于跟踪和学习,本系列教程在Github上提供了jupyter notebook 版本: Github仓库: ...

随机推荐

- sequelize的创建接口以及模糊查询

第一步: 在routes里面复制index.js更改为xxx.js(例如arctile.js) res.json()返回的就是json文件 第二步: 在views里app.js引用路由 第三步:查找数 ...

- 使用IScroll组件出现滑动卡顿问题解决方法

var is = new IScroll('#wrapper2', { scrollX: true, scrollY: false, click: true, keyBindings: true, / ...

- delete、truncate、drop的区别

delete:只删除数据,不删除结构.删除的数据存储在系统回滚段中,可以回滚.不会自动提交事务. 在InnoDB中,delete不会真的把数据删除,mysql实际上只是给删除的数据打了个标记为已删除, ...

- P2P网络

P2P 网络是什么 点对点技术(peer-to-peer, 简称 P2P )又称对等互联网络技术,是一种网络技术,依赖网络中参与者的计算能力和带宽,而不是把依赖都聚集在较少的几台服务器上. 即不是传统 ...

- 在NCBI中下载SRA数据

目前,在NCBI中下载SRA数据主要有三种方式: 利用Aspera工具下载. 利用SRA Toolkit下载. 利用wget命令直接下载 第三种最为方便.其中的关键是得到下载数据的链接,即ftp的地址 ...

- 狐漠漠养成日记 Cp.00000 前言

前言 狐漠漠是我的常用网名,来源是因为我非常非常非常喜欢耳廓狐(也称作沙漠狐),所以我就给自己拟造了一个名叫狐漠漠的虚拟形象(如下图所示). 设定上是女孩子因为我想当女孩子但是我不是所以我就在设定上满 ...

- clamav测试用例 API

最近接触到clamav这一块,本身是一个很简单的任务,只需要调用他的API对文件进行检测即可,但是在进行大量搜索发现,网上最多只有API的讲解,且质量层次不齐,这可为难住我了,作为一个名副其实的&qu ...

- Linux用户管理2

passwd给用户修改密码 用户自己给自己设置密码直接passwd root用户给普通用户设置密码passwd 用户名 --stdin从标准输入获取信息 echo "1" | pa ...

- Cookie 设置 添加 删除 修改

置cookie 如果设置domin 后面的域名前面就会有. <script>//设置cookiefunction setCookie(cname, cvalue, exdays) ...

- ubuntu安装matplotlib失败:Can't rollback pillow, nothing uninstalled.

今天在ubuntu1804上面使用pip安装matplotlib,安装失败,报错如下: ---------------------------------------- Can't rollback ...