爬虫之Xpath案例

案例:使用XPath的爬虫

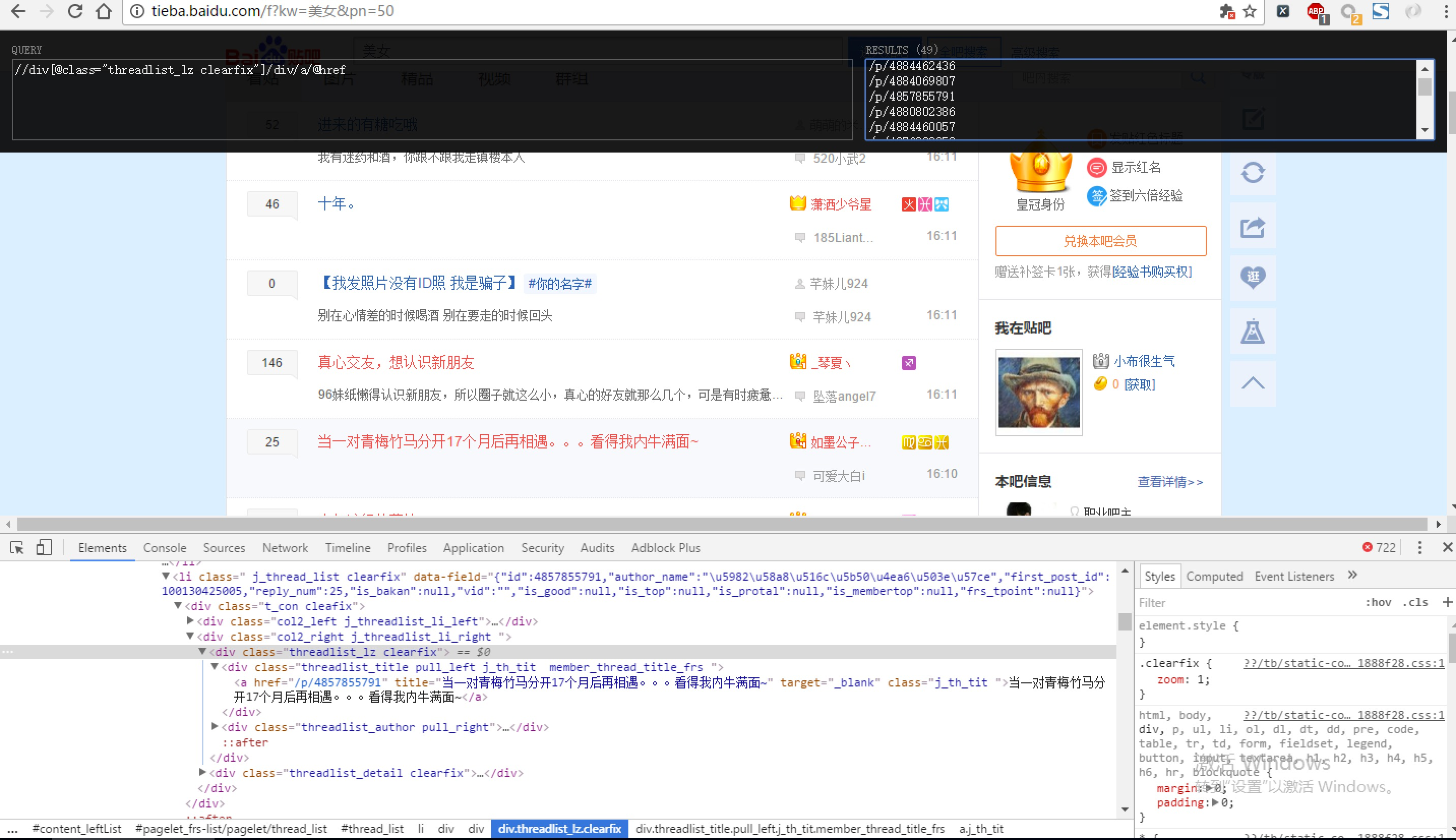

现在我们用XPath来做一个简单的爬虫,我们尝试爬取某个贴吧里的所有帖子,并且将该这个帖子里每个楼层发布的图片下载到本地。

# tieba_xpath.py

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import os

import urllib

import urllib2

from lxml import etree

class Spider:

def __init__(self):

self.tiebaName = raw_input("请需要访问的贴吧:")

self.beginPage = int(raw_input("请输入起始页:"))

self.endPage = int(raw_input("请输入终止页:"))

self.url = 'http://tieba.baidu.com/f'

self.ua_header = {"User-Agent" : "Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1 Trident/5.0;"}

# 图片编号

self.userName = 1

def tiebaSpider(self):

for page in range(self.beginPage, self.endPage + 1):

pn = (page - 1) * 50 # page number

word = {'pn' : pn, 'kw': self.tiebaName}

word = urllib.urlencode(word) #转换成url编码格式(字符串)

myUrl = self.url + "?" + word

# 示例:http://tieba.baidu.com/f? kw=%E7%BE%8E%E5%A5%B3 & pn=50

# 调用 页面处理函数 load_Page

# 并且获取页面所有帖子链接,

links = self.loadPage(myUrl) # urllib2_test3.py

# 读取页面内容

def loadPage(self, url):

req = urllib2.Request(url, headers = self.ua_header)

html = urllib2.urlopen(req).read()

# 解析html 为 HTML 文档

selector=etree.HTML(html)

#抓取当前页面的所有帖子的url的后半部分,也就是帖子编号

# http://tieba.baidu.com/p/4884069807里的 “p/4884069807”

links = selector.xpath('//div[@class="threadlist_lz clearfix"]/div/a/@href')

# links 类型为 etreeElementString 列表

# 遍历列表,并且合并成一个帖子地址,调用 图片处理函数 loadImage

for link in links:

link = "http://tieba.baidu.com" + link

self.loadImages(link)

# 获取图片

def loadImages(self, link):

req = urllib2.Request(link, headers = self.ua_header)

html = urllib2.urlopen(req).read()

selector = etree.HTML(html)

# 获取这个帖子里所有图片的src路径

imagesLinks = selector.xpath('//img[@class="BDE_Image"]/@src')

# 依次取出图片路径,下载保存

for imagesLink in imagesLinks:

self.writeImages(imagesLink)

# 保存页面内容

def writeImages(self, imagesLink):

'''

将 images 里的二进制内容存入到 userNname 文件中

'''

print imagesLink

print "正在存储文件 %d ..." % self.userName

# 1. 打开文件,返回一个文件对象

file = open('./images/' + str(self.userName) + '.png', 'wb')

# 2. 获取图片里的内容

images = urllib2.urlopen(imagesLink).read()

# 3. 调用文件对象write() 方法,将page_html的内容写入到文件里

file.write(images)

# 4. 最后关闭文件

file.close()

# 计数器自增1

self.userName += 1

# 模拟 main 函数

if __name__ == "__main__":

# 首先创建爬虫对象

mySpider = Spider()

# 调用爬虫对象的方法,开始工作

mySpider.tiebaSpider()

爬虫之Xpath案例的更多相关文章

- Python爬虫之xpath语法及案例使用

Python爬虫之xpath语法及案例使用 ---- 钢铁侠的知识库 2022.08.15 我们在写Python爬虫时,经常需要对网页提取信息,如果用传统正则表达去写会增加很多工作量,此时需要一种对数 ...

- 爬虫常用Xpath和CSS3选择器对比

爬虫常用Xpath和CSS3选择器对比 1. 简介 CSS是来配合HTML工作的,和Xpath对比起来,CSS选择器通常都比较短小,但是功能不够强大.CSS中的空白符' '和Xpath的'//'都表示 ...

- 中国爬虫违法违规案例汇总github项目介绍

中国爬虫违法违规案例汇总github项目介绍 GitHub - 本项目用来整理所有中国大陆爬虫开发者涉诉与违规相关的新闻.资料与法律法规.致力于帮助在中国大陆工作的爬虫行业从业者了解我国相关法律,避免 ...

- python爬虫:XPath语法和使用示例

python爬虫:XPath语法和使用示例 XPath(XML Path Language)是一门在XML文档中查找信息的语言,可以用来在XML文档中对元素和属性进行遍历. 选取节点 XPath使用路 ...

- 非常全的一份Python爬虫的Xpath博文

非常全的一份Python爬虫的Xpath博文 Xpath 是 python 爬虫过程中非常重要的一个用来定位的一种语法. 一.开始使用 首先我们需要得到一个 HTML 源代码,用来模拟爬取网页中的源代 ...

- Python爬虫(十三)_案例:使用XPath的爬虫

本篇是使用XPath的案例,更多内容请参考:Python学习指南 案例:使用XPath的爬虫 现在我们用XPath来做一个简单的爬虫,我们尝试爬取某个贴吧里的所有帖子且将该帖子里每个楼层发布的图片下载 ...

- 爬虫神器xpath的用法(三)

xpath的多线程爬虫 #encoding=utf-8 ''' pool = Pool(4) cpu的核数为4核 results = pool.map(爬取函数,网址列表) ''' from mult ...

- 爬虫神器XPath,程序员带你免费获取周星驰等明星热门电影

本教程由"做全栈攻城狮"原创首发,本人大学生一枚平时还需要上课,但尽量每日更新文章教程.一方面把我所习得的知识分享出来,希望能对初学者有所帮助.另一方面总结自己所学,以备以后查看. ...

- 互联网金融爬虫怎么写-第一课 p2p网贷爬虫(XPath入门)

版权声明:本文为博主原创文章,未经博主允许不得转载. 相关教程: 手把手教你写电商爬虫-第一课 找个软柿子捏捏 手把手教你写电商爬虫-第二课 实战尚妆网分页商品采集爬虫 手把手教你写电商爬虫-第三课 ...

随机推荐

- Netty 应用程序的一个一般准则:尽可能的重用 EventLoop,以减少线程创建所带来的开销。

Netty 系列一(核心组件和实例). - JMCui - 博客园 https://www.cnblogs.com/jmcui/p/9154842.html 阅读目录 一.概念 二.核心组件 三.实例 ...

- userAgent font-family

w view-source:http://you.163.com/ CODE <script type="text/javascript"> (function () ...

- Myeclipse更新SVNStatusSubscriber 时报告了错误。1 中的 0 个资源已经同步。

1.先确认SVN服务是否能连接,或权限. 方法:在项目目录下右键选择repo-browser 能打开就表示正常. 2.同样在项目目录下选择cleaup 选择下面3个选项 clean up workin ...

- Travel---hdu5441(并查集)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=5441 题意:是有n个城市,m条边包含u v w:代表u到v的时间是w: 给q的时间x,求在x时间内Ja ...

- javascrpt 页面格式化页面

下面这个页面,格式化javaScript <html> <head> <title>JS格式化工具 </title> <meta http-equ ...

- 一种部署 Python 代码的新方法

在Nylas,我们喜欢使用Python进行开发.它的语法简单并富有表现力,拥有大量可用的开源模块和框架,而且这个社区既受欢迎又有多样性.我们的后台是纯用 Python 写的,团队也经常在 PyCon ...

- 使用curl发送post或者get数据

一. 使用curl可以仿造http的请求,向目标服务器或者是目标IP发送数据,进行操作. (1).使用php操作curl向某个接口上发送GET请求: 下面是写的一个比较简单的请求方式请求数据,传入的参 ...

- POJO,简单的Java对象

POJO = "Plain Ordinary Java Object",简单的Java对象,是为了避免和EJB混淆所创造的简称,是MartinFowler等发明的一个术语,用来表示 ...

- Linux-vim与ssh客户端

一.vim使用 Linux系统下标准的编辑器,他就相当于windows系统中的记事本一样,它的强大不逊色于任何最新的文本编辑器. (1)vim安装 (2)vim使用:操作模式 一般模式(默认模式,不 ...

- Mock Server 之 moco-runner 使用指南二

文章出处http://blog.csdn.net/crisschan/article/details/53335234 moco-runner 安装配置 1. 下载jar https://repo1. ...