Python3网络爬虫(1):利用urllib进行简单的网页抓取

1.开发环境

pycharm2017.3.3

python3.5

2.网络爬虫的定义

网络爬虫,也叫网络蜘蛛(web spider),如果把互联网比喻成一个蜘蛛网,spider就是一只在网上爬来爬去的蜘蛛,网络爬虫就是根据网页的地址来寻找网页的,也就是URL。举一个简单的例子,我们在浏览器的地址栏中输入的字符串就是URL,例如:https://www.baidu.com/

URL就是统一资源定位符(uniform resource location),他的一般格式如下(带方括号[]的为可选项)

protocol://hostname[:port]/path/[:parameters][?query]#fragment

URL的格式由三部分组成:

(1)protocol:第一部分就是协议,例如百度使用的就是https协议;

(2)hostname[:port]:第二部分人就是主机名(还有端口号为可选参数),一般网站默认的端口号为80

(3)path:第三部分就是主机资源的具体地址,如目录和文件名等,网络爬虫就是根据这个URL来获取网页信息的

3.简单爬虫实例

在Python3.x中,我们可以使用urllib这个组件抓取网页,urllib是一个URL处理包,这个包中集合了一下处理url的模块,如下:

(1)urllib.request模块是用来打开和读取URLs的;

(2)urllib.error模块包含一些由urllib.request产生的错误,可以使用try进行捕捉处理

(3)urllib.parse模块包含了一些解析URLs的方法;

(4)urllib.robotparser模块用来解析robots.txt文本文件,它提供了一个单独的RobotFileParser类,通过该类提供的can_fatch()方法测试爬虫是否可以下载一个页面

我们使用urllib.request.urlopen()这个接口函数就可以很轻松的打开一个网站,读取并打印信息

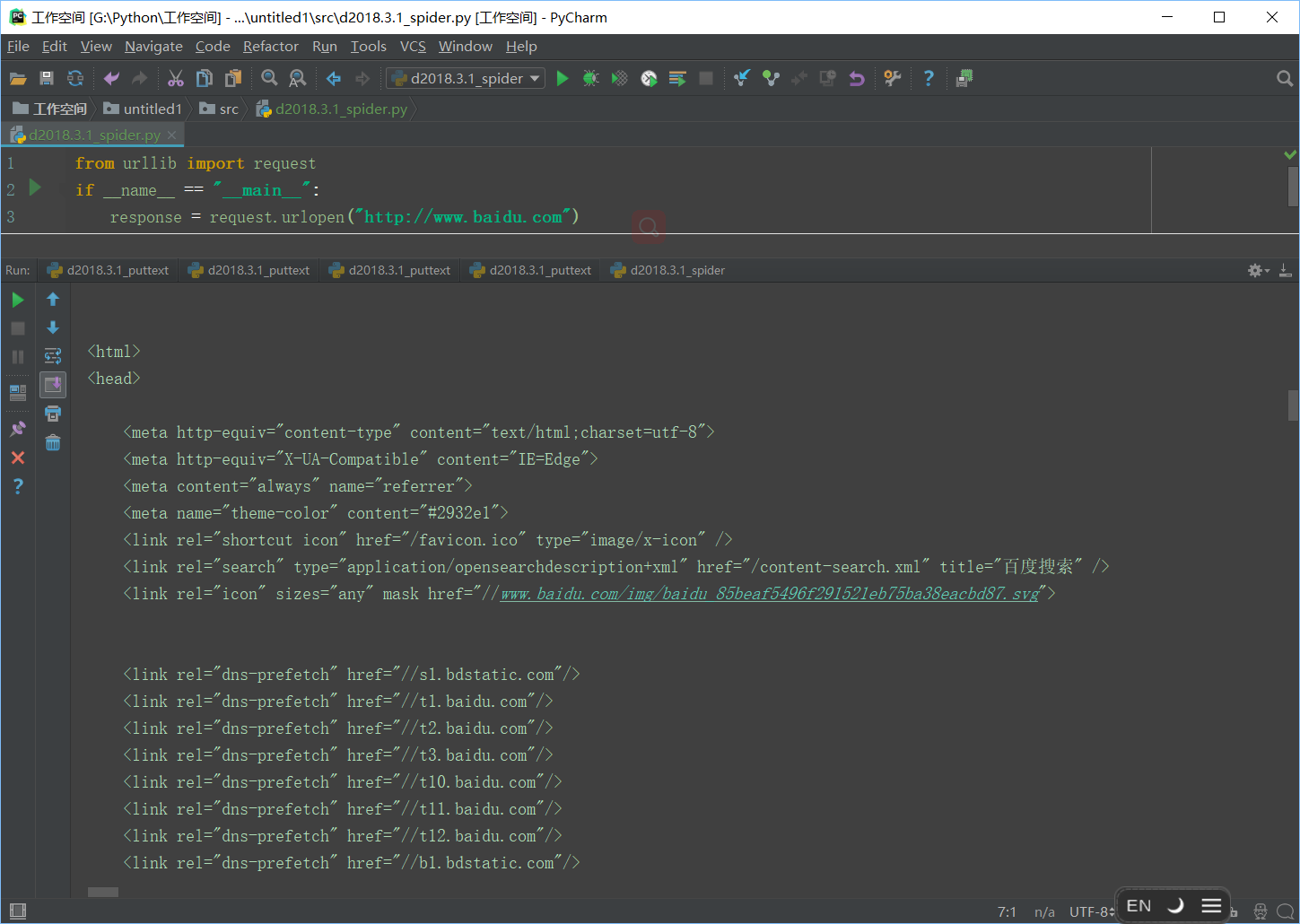

下面来写一个简单的程序实现一下

from urllib import request

if __name__ == "__main__":

response = request.urlopen("http://www.baidu.com")

html = response.read()

print(html)

运行结果(可以看到进度条还能拉倒很远)

这都是些什么鬼玩意呢

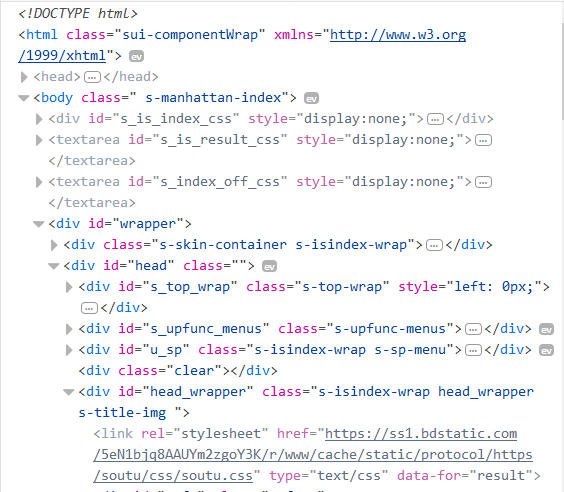

拿来对比一下,浏览器中打开www.baidu.com,查看页面元素,快捷键F12(浏览器最好用火狐或者Chrome)

东西都一样,就是格式有点乱,可以通过简单的decode()命令将网页的信息进行解码并显示出来,在代码中添加一句html=html.decode("utf-8")即可

from urllib import request if __name__ == "__main__":

response = request.urlopen("http://www.fanyi.baidu.com/")

html = response.read()

html = html.decode("utf-8")

print(html)

输出正常的html格式

当然编码方式不是我们猜出来的,是查出来的,在查看元素中找到head标签,打开,看到charset="utf-8",就是编码方式

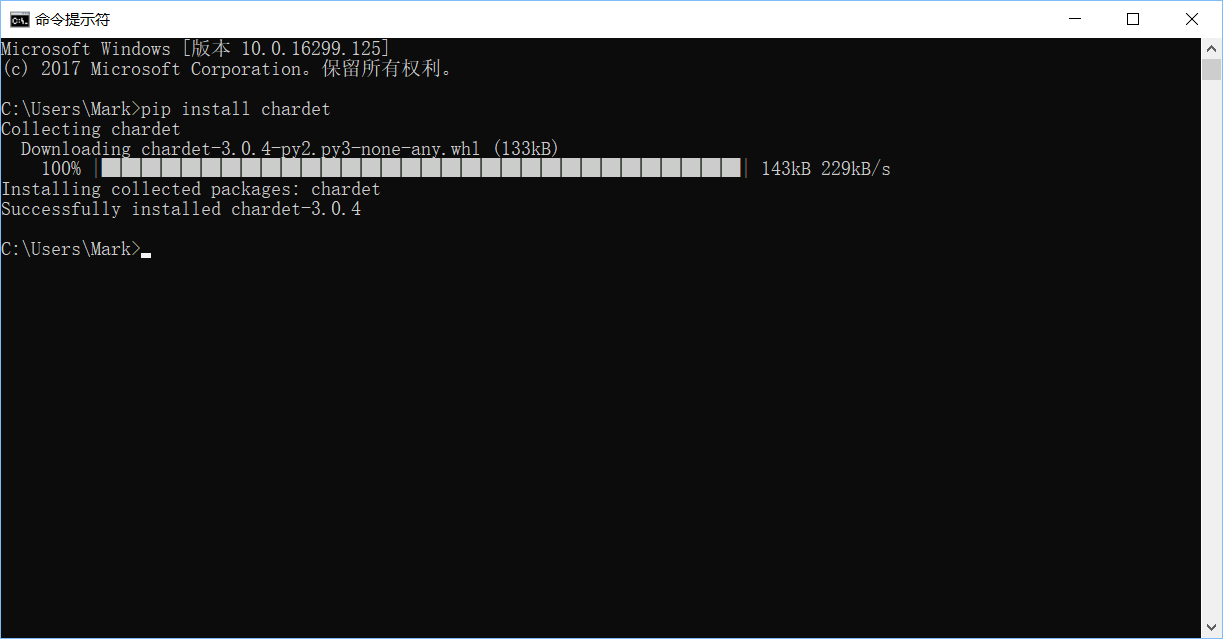

4.自动获取网页编码方式的方法

这里采用第三方库的方法,安装chardet

pip install chardet

对代码稍作修改用来判断网页的编码方式

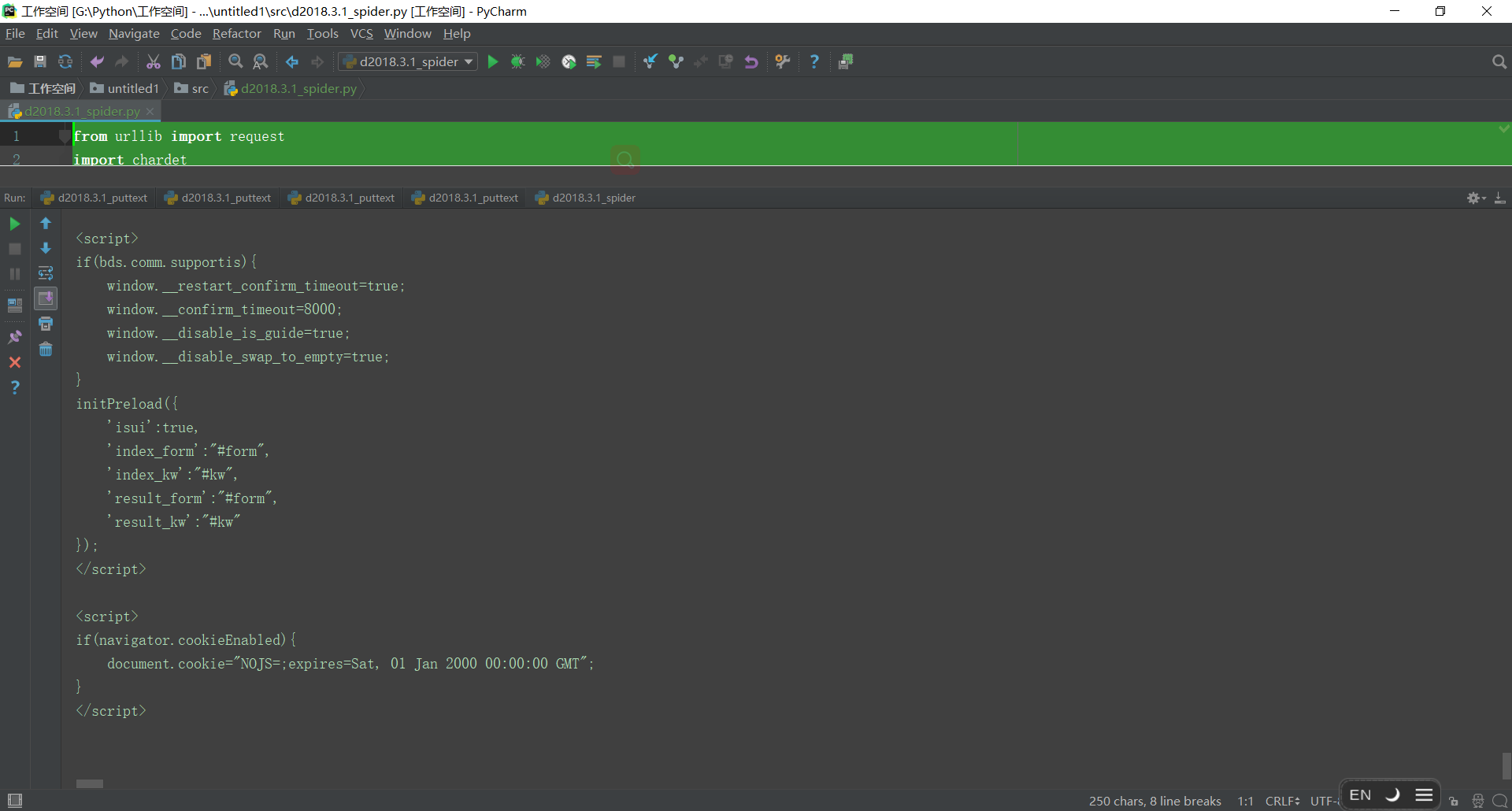

from urllib import request

import chardet

if __name__ == "__main__":

response = request.urlopen("http://www.baidu.com")

html = response.read()

#html = html.decode("utf-8")

charset = chardet.detect(html)

print(charset)

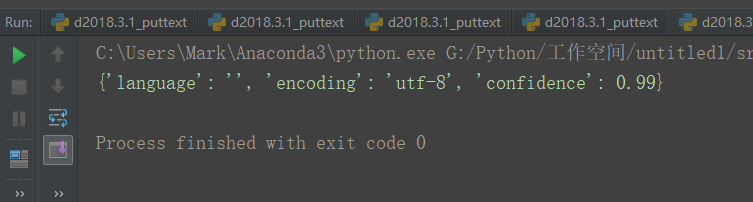

可以看到返回的是字典,最后也可以整合一下

from urllib import request

import chardet

if __name__ == "__main__":

response = request.urlopen("http://www.baidu.com")

html = response.read()

charset = chardet.detect(html)

html = html.decode(charset.get('encoding')) print(html)

完美

Python3网络爬虫(1):利用urllib进行简单的网页抓取的更多相关文章

- Python实现简单的网页抓取

现在开源的网页抓取程序有很多,各种语言应有尽有. 这里分享一下Python从零开始的网页抓取过程 第一步:安装Python 点击下载适合的版本https://www.python.org/ 我这里选择 ...

- 【Python3网络爬虫开发实战】6.4-分析Ajax爬取今日头条街拍美图【华为云技术分享】

[摘要] 本节中,我们以今日头条为例来尝试通过分析Ajax请求来抓取网页数据的方法.这次要抓取的目标是今日头条的街拍美图,抓取完成之后,将每组图片分文件夹下载到本地并保存下来. 1. 准备工作 在本节 ...

- 转:【Python3网络爬虫开发实战】6.4-分析Ajax爬取今日头条街拍美图

[摘要] 本节中,我们以今日头条为例来尝试通过分析Ajax请求来抓取网页数据的方法.这次要抓取的目标是今日头条的街拍美图,抓取完成之后,将每组图片分文件夹下载到本地并保存下来. 1. 准备工作 在本节 ...

- Python3网络爬虫(三):urllib.error异常

运行平台:Windows Python版本:Python3.x IDE:Sublime text3 转载请注明作者和出处:http://blog.csdn.net/c406495762/article ...

- python3一个简单的网页抓取

都是学PYTHON.怎么学都是学,按照基础学也好,按照例子增加印象也好,反正都是学 import urllib import urllib.request data={} data['word']=' ...

- 转:【Python3网络爬虫开发实战】 requests基本用法

1. 准备工作 在开始之前,请确保已经正确安装好了requests库.如果没有安装,可以参考1.2.1节安装. 2. 实例引入 urllib库中的urlopen()方法实际上是以GET方式请求网页,而 ...

- Python3 网络爬虫(请求库的安装)

Python3 网络爬虫(请求库的安装) 爬虫可以简单分为几步:抓取页面,分析页面和存储数据 在页面爬取的过程中我们需要模拟浏览器向服务器发送请求,所以需要用到一些python库来实现HTTP的请求操 ...

- [Python3网络爬虫开发实战] 2.3-爬虫的基本原理

我们可以把互联网比作一张大网,而爬虫(即网络爬虫)便是在网上爬行的蜘蛛.把网的节点比作一个个网页,爬虫爬到这就相当于访问了该页面,获取了其信息.可以把节点间的连线比作网页与网页之间的链接关系,这样蜘蛛 ...

- Python3网络爬虫开发实战PDF高清完整版免费下载|百度云盘

百度云盘:Python3网络爬虫开发实战高清完整版免费下载 提取码:d03u 内容简介 本书介绍了如何利用Python 3开发网络爬虫,书中首先介绍了环境配置和基础知识,然后讨论了urllib.req ...

随机推荐

- Intellij实用技巧

快捷键 Tradition 快捷键 介绍 Ctrl + Z 撤销 Ctrl + Shift + Z 取消撤销 Ctrl + X 剪切 Ctrl + C 复制 Ctrl + S 保存 Tab 缩进 Sh ...

- Luogu4131 WC2005 友好的生物 状压DP

传送门 首先$C_i$是没有意义的,因为可以直接让$d_i \times= C_i$,答案也是一样的 所以我们现在考虑求$(\sum_{i=1}^{K-1} |d_{p,i}-d_{q,i}|) - ...

- SJP's Blog

This is SJP's blog. Here is a mirror web of his blog.

- P1438 无聊的数列

P1438 无聊的数列 链接 分析: 等差数列可加,首项相加,公差相加. 代码: #include<cstdio> #include<algorithm> #include&l ...

- WEB 小案例 -- 网上书城(四)

针对于这个小案例我们今天讲解结账操作,也是有关这个案例的最后一次博文,说实话这个案例的博文写的很糟糕,不知道该如何去表述自己的思路,所以内容有点水,其实说到底还是功力不够. 处理思路 点击结账,发送结 ...

- centos6下redis cluster集群部署过程

一般来说,redis主从和mysql主从目的差不多,但redis主从配置很简单,主要在从节点配置文件指定主节点ip和端口,比如:slaveof 192.168.10.10 6379,然后启动主从,主从 ...

- centos7.2部署vnc服务记录

不做过多介绍了,下面直接记录下centos7系统下安装配置vncserver的操作记录 0)更改为启动桌面或命令行模式 获取当前系统启动模式 [root@localhost ~]# systemctl ...

- mysqldump数据导出问题和客户端授权后连接失败问题

1,使用mysqldump时报错(1064),这个是因为mysqldump版本太低与当前数据库版本不一致导致的.mysqldump: Couldn't execute 'SET OPTION SQL_ ...

- 网络流第一题!!!BZOJ1001

歇逼了一晚上,懵懵懂懂的懂了Dinic算法 大概是一遍BFS+DFS,还不是很懂,明天继续看!!! #include<iostream> #include<stdio.h> # ...

- MySQL主从复制配置遇到的部分问题

网上配置教程很多,我也是参考其他人的教程完成的,主要遇到了以下几个问题,如果以后有人遇到相同的希望能够给大家写提示吧. 1.my.cnf文件配置 Master上的my.cnf中配置的server_id ...