python学习(25) BeautifulSoup介绍和实战

BeautifulSoup是python的html解析库,处理html非常方便

BeautifulSoup 安装

pip install beautifulsoup4

BeautifulSoup 配合的解析器

# python标准库

BeautifulSoup(html,'html.parser')

#lxml HTML 解析器

BeautifulSoup(html,'lxml)

#html5lib

BeautifulSoup(html,'html5lib')

python 标准库解析器不需要第三方库,处理效率一般,lxml比较快,需要C语言库支持,html5lib不依赖第三方库,但是效率比较低,容错好。

导入BeautifulSoup并使用

from bs4 import BeautifulSoup

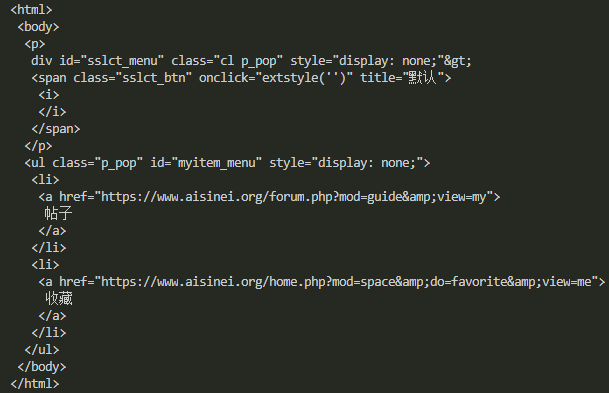

html = '''div id="sslct_menu" class="cl p_pop" style="display: none;">

<span class="sslct_btn" onClick="extstyle('')" title="默认"><i></i></span></div>

<ul id="myitem_menu" class="p_pop" style="display: none;">

<li><a href="https://www.aisinei.org/forum.php?mod=guide&view=my">帖子</a></li>

<li><a href="https://www.aisinei.org/home.php?mod=space&do=favorite&view=me">收藏</a></li>'''

bs = BeautifulSoup(html)

print(bs.prettify())

bs.prettify为格式化输出,效果如下

同样可以用本地的html文本创建,也可以添加解析器lxml

s =BeautifulSoup('test.html','lxml')

print(s.prettify())

效果是一样的

BeautifulSoup属性选择和处理

处理节点tag

html2 = ''' <li class="bus_postbd item masonry_brick">

<div class="bus_vtem">

<a href="https://www.aisinei.org/thread-17846-1-1.html" title="XIUREN秀人网 2018.11.13 NO.1228 猫宝 [50+1P]" class="preview" target="_blank">

"hello world"

<img src="https://i.asnpic.win/block/a4/a42e6c63ef1ae20a914699f183d5204b.jpg" width="250" height="375" alt="XIUREN秀人网 2018.11.13 NO.1228 猫宝 [50+1P]"/>

<span class="bus_listag">XIUREN秀人网</span>

</a>

<a href="https://www.aisinei.org/thread-17846-1-1.html" title="XIUREN秀人网 2018.11.13 NO.1228 猫宝 [50+1P]" target="_blank">

<div class="lv-face"><img src="https://www.aisinei.org/uc_server/avatar.php?uid=2&size=small" alt="发布组小乐"/></div>

<div class="t">XIUREN秀人网 2018.11.13 NO.1228 猫宝 [50</div>

<div class="i"><span><i class="bus_showicon bus_showicon_v"></i>6402</span><span><i class="bus_showicon bus_showicon_r"></i>1</span></div>

</a>

</div>

</li> '''

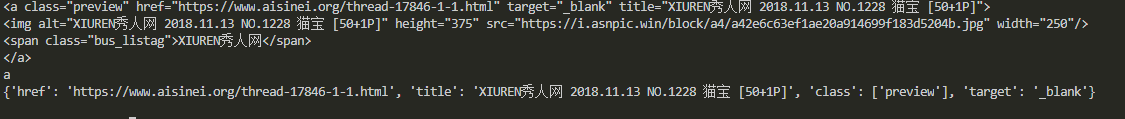

s2 = BeautifulSoup(html2,'lxml')

print(s2.a)

print(s2.a.name)

print(s2.a.attrs)

节点tag 就是li,a,div这类,可以看出通过属性访问,选择出第一个匹配的结果。节点Tag也有名字,通过.name访问。通过.attrs获取节点的属性。

获取节点文本通过.string即可,获取节点的子孙节点的文本可以通过text

print(s2.a.string)

print(s2.a.text)

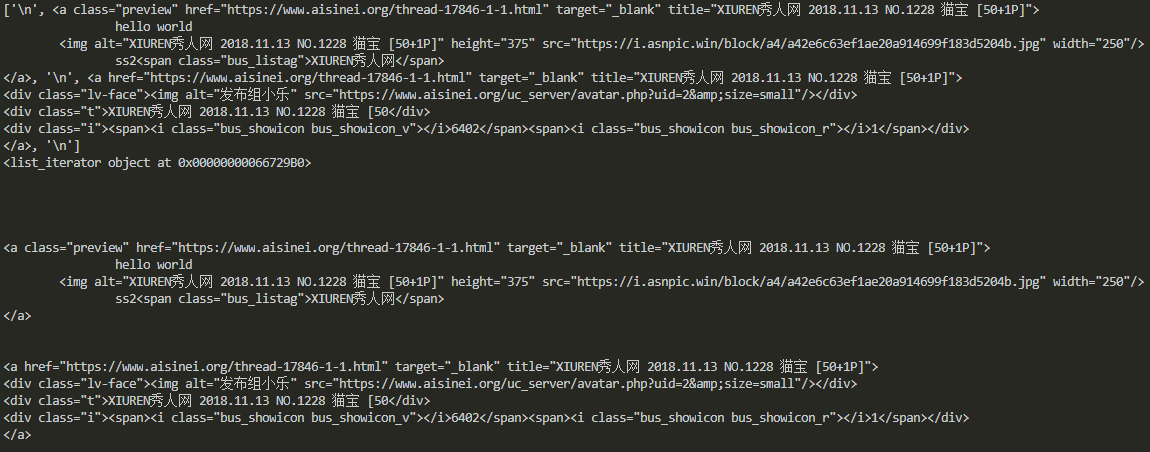

节点的子孙节点

获取节点的子节点,可以用.contents,也可以用.children, .contents返回列表形式的直接子节点, .contents返回的是一个可迭代对象。

print(s2.div.contents)

print(s2.div.children)

print(s2.div.contents[0])

for i in s2.div.children:

print(i)

前两个输出一样,后边的分别取第一个节点,以及遍历每一个节点。同样的道理,子孙节点,父节点,祖父节点,兄弟节点都采用这种方式获取

#孙子节点

print(s2.div.descendants)

#祖先节点

print(s2.div.parents)

#直接父节点

print(s2.div.parent)

#下一个兄弟节点

print(s2.a.next_sibling)

#前一个兄弟节点

print(s2.a.previous_sibling)

节点的属性获取

print(s2.a["href"])

print(s2.a.get("href"))

如上两种方式都能获取属性

方法选择

常用的筛选函数有find_all和find,findall返回所有匹配的结果,find返回匹配结果的

print(s2.find('a'))

print(s2.find_all('a'))

print(s2.find_all(re.compile("^div")))

print(s2.find_all(["div","li"]))

可以看出findall传递参数可以是字符串,正则表达式,列表等等,其他的方法类似属性访问一样,有find_parents(),find_next_siblings()等等,用的时候再查吧。

BeautifulSoup 支持CSS选择器

如果你熟悉css选择器的语法,BeautifulSoup同样支持,而且非常便利。

#查找节点为div的数据

print(s2.select('a'))

#查找class为bus_vtem的节点

print(s2.select('.bus_vtem'))

#查找id为ps的节点

print(s2.select('#ps'))

到目前为止基本的BeautifulSoup已经介绍完,下面实战抓取一段html,并用BeautifulSoup解析提取我们需要的数据,这里解析一段美女图更新首页,提取其中的资源地址。

#-*-coding:utf-8-*-

import requests

import re

import time

from lxml import etree

from bs4 import BeautifulSoup

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0'

COOKIES = '__cfduid=d78f862232687ba4aae00f617c0fd1ca81537854419; bg5D_2132_saltkey=jh7xllgK; bg5D_2132_lastvisit=1540536781; bg5D_2132_auth=479fTpQgthFjwwD6V1Xq8ky8wI2dzxJkPeJHEZyv3eqJqdTQOQWE74ttW1HchIUZpgsyN5Y9r1jtby9AwfRN1R89; bg5D_2132_lastcheckfeed=7469%7C1541145866; bg5D_2132_ulastactivity=2bbfoTOtWWimnqaXyLbTv%2Buq4ens5zcXIiEAhobA%2FsWLyvpXVM9d; bg5D_2132_sid=wF3g17; Hm_lvt_b8d70b1e8d60fba1e9c8bd5d6b035f4c=1540540375,1540955353,1541145834,1541562930; Hm_lpvt_b8d70b1e8d60fba1e9c8bd5d6b035f4c=1541562973; bg5D_2132_lastact=1541562986%09home.php%09spacecp'

class AsScrapy(object):

def __init__(self,pages=1):

try:

self.m_session = requests.Session()

self.m_headers = {'User-Agent':USER_AGENT,

#'referer':'https://www.aisinei.org/',

} self.m_cookiejar = requests.cookies.RequestsCookieJar()

for cookie in COOKIES.split(';'):

key,value = cookie.split('=',1)

self.m_cookiejar.set(key,value)

except:

print('init error!!!')

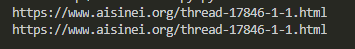

def getOverView(self):

try:

req = self.m_session.get('https://www.aisinei.org/portal.php',headers=self.m_headers, cookies=self.m_cookiejar, timeout=5)

classattrs={'class':'bus_vtem'}

soup = BeautifulSoup(req.content.decode('utf-8'),'lxml')

buslist = soup.find_all(attrs=classattrs)

#print(len(buslist))

for item in buslist:

if(item.a.attrs['title'] == "紧急通知!紧急通知!紧急通知!"):

continue

print(item.a.attrs['title'])

print(item.a.attrs['href'])

time.sleep(1)

pass

except:

print('get over view error') if __name__ == "__main__":

asscrapy = AsScrapy()

asscrapy.getOverView()

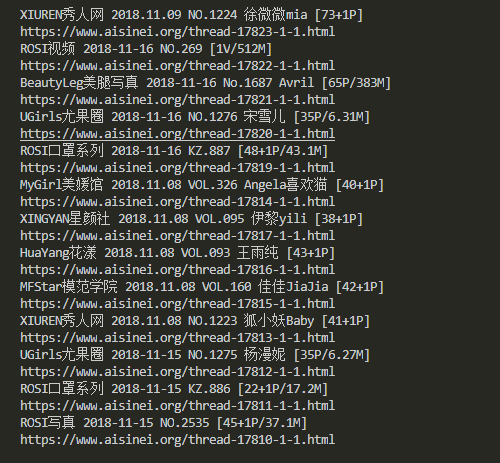

抓取并分析出地址如下

下一篇讲如何利用ajax分析动态网址,实战抓取今日头条的cosplay图片

谢谢关注我的公众号

python学习(25) BeautifulSoup介绍和实战的更多相关文章

- 深度学习框架Keras介绍及实战

Keras 是一个用 Python 编写的高级神经网络 API,它能够以 TensorFlow, CNTK, 或者 Theano 作为后端运行.Keras 的开发重点是支持快速的实验.能够以最小的时延 ...

- Python开发GUI工具介绍,实战:将图片转化为素描画!

欢迎添加华为云小助手微信(微信号:HWCloud002 或 HWCloud003),输入关键字"加群",加入华为云线上技术讨论群:输入关键字"最新活动",获取华 ...

- python学习之——splinter介绍

Splinter是什么: 是一个用 Python 编写的 Web 应用程序进行验收测试的工具. Splinter执行的时候会自动打开你指定的浏览器,访问指定的URL,然后你所开发的模拟的任何行为,都会 ...

- python学习之----BeautifulSoup的find()和findAll()及四大对象

BeautifulSoup 里的find() 和findAll() 可能是你最常用的两个函数.借助它们,你可以通 过标签的不同属性轻松地过滤HTML 页面,查找需要的标签组或单个标签. 这两个函数非常 ...

- Python学习之路:MINST实战第一版

1.项目介绍: 搭建浅层神经网络完成MNIST数字图像的识别. 2.详细步骤: (1)将二维图像转成一维,MNIST图像大小为28*28,转成一维就是784. (2)定义好神经网络的相关参数: # M ...

- Python开发GUI工具介绍,实战:将图片转化为素描画!【华为云技术分享】

版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:https://blog.csdn.net/devcloud/article/detai ...

- python学习之BeautifulSoup模块爬图

BeautifulSoup模块爬图学习HTML文本解析标签定位网上教程多是爬mzitu,此网站反爬限制多了.随意找了个网址,解析速度有些慢.脚本流程:首页获取总页数-->拼接每页URL--> ...

- GO学习-(25) Go操作Redis实战

Go操作Redis实战 安装Redis客户端 Go语言中使用第三方库https://github.com/go-redis/redis连接Redis数据库并进行操作.使用以下命令下载并安装: go ...

- Python学习(25):Python执行环境

转自 http://www.cnblogs.com/BeginMan/p/3191856.html 一.python特定的执行环境 在当前脚本继续进行 创建和管理子进程 执行外部命令或程序 执行需要输 ...

随机推荐

- Daily Scrum4 11.6

昨天的任务按时完成了,但是通过不到两周的时间,我们的工作依旧停留在修改上届学长代码中.今天上课和老师提出了这样的问题,助教在TFS上重新加载了10级学长的代码. 从上届学长代码那里我们发现,他们没有实 ...

- BNUOJ 52303 Floyd-Warshall Lca+bfs最短路

题目链接: https://www.bnuoj.com/v3/problem_show.php?pid=52303 Floyd-Warshall Time Limit: 60000msMemory L ...

- lintcode-513-完美平方

513-完美平方 给一个正整数 n, 找到若干个完全平方数(比如1, 4, 9, ... )使得他们的和等于 n.你需要让平方数的个数最少. 样例 给出 n = 12, 返回 3 因为 12 = 4 ...

- 微信小程序之Flex布局

微信小程序页面布局方式采用的是Flex布局.Flex布局,是W3c在2009年提出的一种新的方案,可以简便,完整,响应式的实现各种页面布局.Flex布局提供了元素在容器中的对齐,方向以及顺序,甚至他们 ...

- WinForm中DataGridView的全选与取消全选

/// <summary> /// 全选 /// </summary> private void SelectAll() { //结束列表的编辑状态,否则可能无法改变Check ...

- FineReport基本使用

FineReport官方开发文档链接:http://help.finereport.com 1.FineReport是帆软软件有限公司自主研发的一款企业级web报表软件产品.FineReport报表软 ...

- 【转】python win32api win32gui win32con 简单操作教程(窗口句柄 发送消息 常用方法 键盘输入)

作者:https://blog.csdn.net/qq_16234613/article/details/79155632 附:https://www.programcreek.com/python/ ...

- python基础(六)python操作excel

一.python操作excel,python操作excel使用xlrd.xlwt和xlutils模块,xlrd模块是读取excel的,xlwt模块是写excel的,xlutils是用来修改excel的 ...

- selenium使用execl实现数据驱动测试

import java.io.FileInputStream;import java.io.IOException;import java.io.InputStream;import java.uti ...

- windows多线程(十) 生产者与消费者问题

一.概述 生产者消费者问题是一个著名的线程同步问题,该问题描述如下:有一个生产者在生产产品,这些产品将提供给若干个消费者去消费,为了使生产者和消费者能并发执行,在两者之间设置一个具有多个缓冲区的缓冲池 ...