PyTorch视觉模型库torchvision.models介绍

安装pytorch时我们一般都是会一并选择安装自带的视觉模型库 torchvision , 该库不仅有经典的视觉模型结构同时还提供了对应参数的下载功能,可以说torchvision库是十分方便于研究视觉的pytorch使用者来使用的。

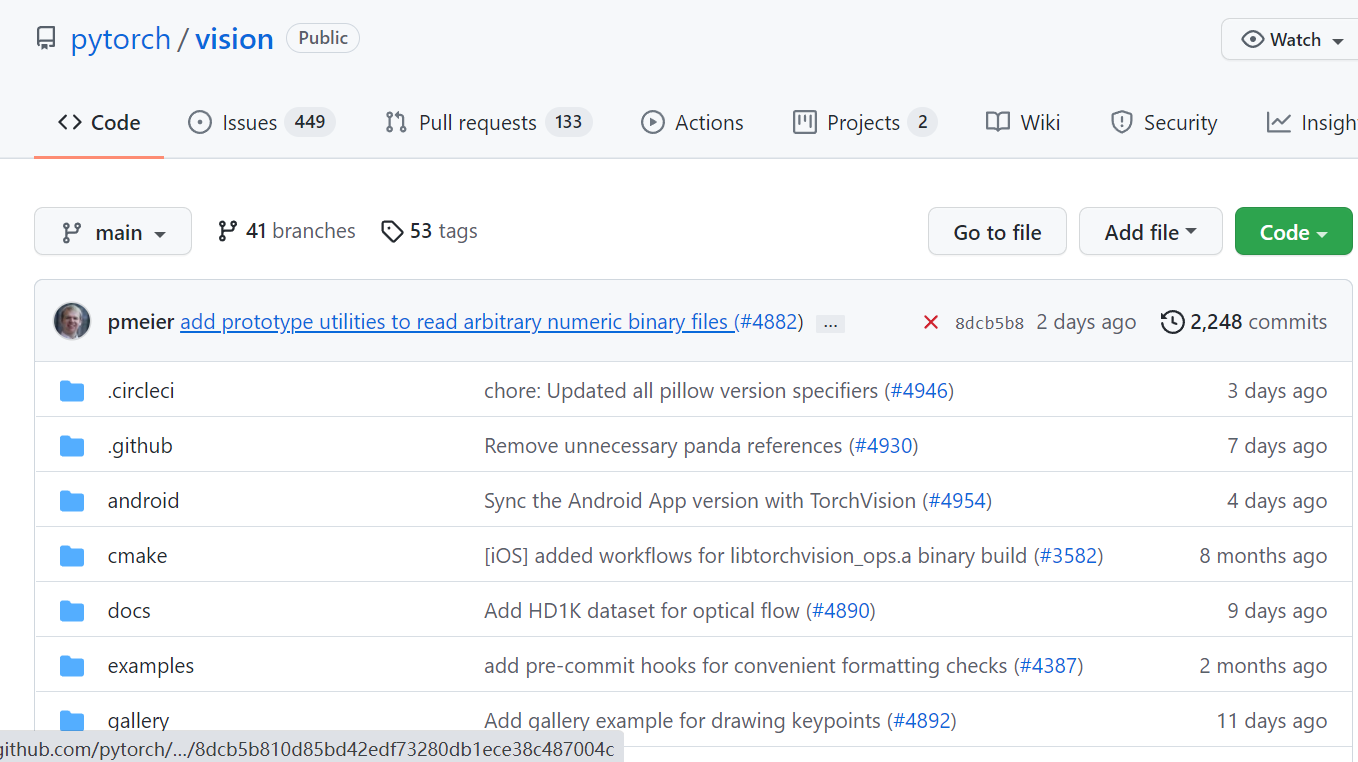

给出pytorch的视觉库torchvision的GitHub地址:

https://github.com/pytorch/vision

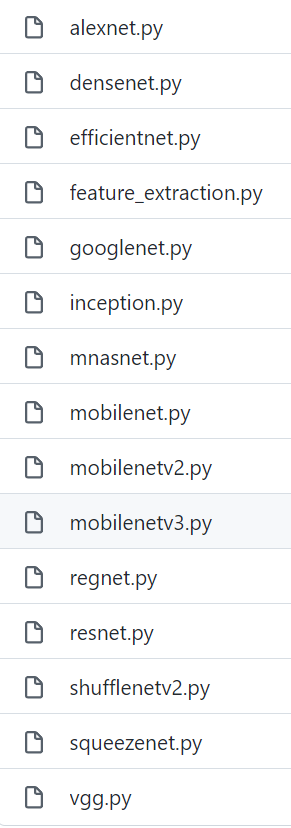

该库中提供的模型结构定义文件:

pytorch官方也给出了对应torchvision库的一些介绍和使用说明:

https://pytorch.org/vision/stable/models.html

使用随机权重的torchvision中的视觉模型:

import torchvision.models as models

resnet18 = models.resnet18()

alexnet = models.alexnet()

vgg16 = models.vgg16()

squeezenet = models.squeezenet1_0()

densenet = models.densenet161()

inception = models.inception_v3()

googlenet = models.googlenet()

shufflenet = models.shufflenet_v2_x1_0()

mobilenet_v2 = models.mobilenet_v2()

mobilenet_v3_large = models.mobilenet_v3_large()

mobilenet_v3_small = models.mobilenet_v3_small()

resnext50_32x4d = models.resnext50_32x4d()

wide_resnet50_2 = models.wide_resnet50_2()

mnasnet = models.mnasnet1_0()

efficientnet_b0 = models.efficientnet_b0()

efficientnet_b1 = models.efficientnet_b1()

efficientnet_b2 = models.efficientnet_b2()

efficientnet_b3 = models.efficientnet_b3()

efficientnet_b4 = models.efficientnet_b4()

efficientnet_b5 = models.efficientnet_b5()

efficientnet_b6 = models.efficientnet_b6()

efficientnet_b7 = models.efficientnet_b7()

regnet_y_400mf = models.regnet_y_400mf()

regnet_y_800mf = models.regnet_y_800mf()

regnet_y_1_6gf = models.regnet_y_1_6gf()

regnet_y_3_2gf = models.regnet_y_3_2gf()

regnet_y_8gf = models.regnet_y_8gf()

regnet_y_16gf = models.regnet_y_16gf()

regnet_y_32gf = models.regnet_y_32gf()

regnet_x_400mf = models.regnet_x_400mf()

regnet_x_800mf = models.regnet_x_800mf()

regnet_x_1_6gf = models.regnet_x_1_6gf()

regnet_x_3_2gf = models.regnet_x_3_2gf()

regnet_x_8gf = models.regnet_x_8gf()

regnet_x_16gf = models.regnet_x_16gf()

regnet_x_32gf = models.regnet_x_32gf()

使用torchvision给出的权重及torchvision中的视觉模型:

import torchvision.models as models resnet18 = models.resnet18(pretrained=True)

alexnet = models.alexnet(pretrained=True)

vgg16 = models.vgg16(pretrained=True)

squeezenet = models.squeezenet1_0(pretrained=True)

densenet = models.densenet161(pretrained=True)

inception = models.inception_v3(pretrained=True)

googlenet = models.googlenet(pretrained=True)

shufflenet = models.shufflenet_v2_x1_0(pretrained=True)

mobilenet_v2 = models.mobilenet_v2(pretrained=True)

mobilenet_v3_large = models.mobilenet_v3_large(pretrained=True)

mobilenet_v3_small = models.mobilenet_v3_small(pretrained=True)

resnext50_32x4d = models.resnext50_32x4d(pretrained=True)

wide_resnet50_2 = models.wide_resnet50_2(pretrained=True)

mnasnet = models.mnasnet1_0(pretrained=True)

efficientnet_b0 = models.efficientnet_b0(pretrained=True)

efficientnet_b1 = models.efficientnet_b1(pretrained=True)

efficientnet_b2 = models.efficientnet_b2(pretrained=True)

efficientnet_b3 = models.efficientnet_b3(pretrained=True)

efficientnet_b4 = models.efficientnet_b4(pretrained=True)

efficientnet_b5 = models.efficientnet_b5(pretrained=True)

efficientnet_b6 = models.efficientnet_b6(pretrained=True)

efficientnet_b7 = models.efficientnet_b7(pretrained=True)

regnet_y_400mf = models.regnet_y_400mf(pretrained=True)

regnet_y_800mf = models.regnet_y_800mf(pretrained=True)

regnet_y_1_6gf = models.regnet_y_1_6gf(pretrained=True)

regnet_y_3_2gf = models.regnet_y_3_2gf(pretrained=True)

regnet_y_8gf = models.regnet_y_8gf(pretrained=True)

regnet_y_16gf = models.regnet_y_16gf(pretrained=True)

regnet_y_32gf = models.regnet_y_32gf(pretrained=True)

regnet_x_400mf = models.regnet_x_400mf(pretrained=True)

regnet_x_800mf = models.regnet_x_800mf(pretrained=True)

regnet_x_1_6gf = models.regnet_x_1_6gf(pretrained=True)

regnet_x_3_2gf = models.regnet_x_3_2gf(pretrained=True)

regnet_x_8gf = models.regnet_x_8gf(pretrained=True)

regnet_x_16gf = models.regnet_x_16gf(pretrained=True)

regnet_x_32gf = models.regnet_x_32gf(pretrained=True)

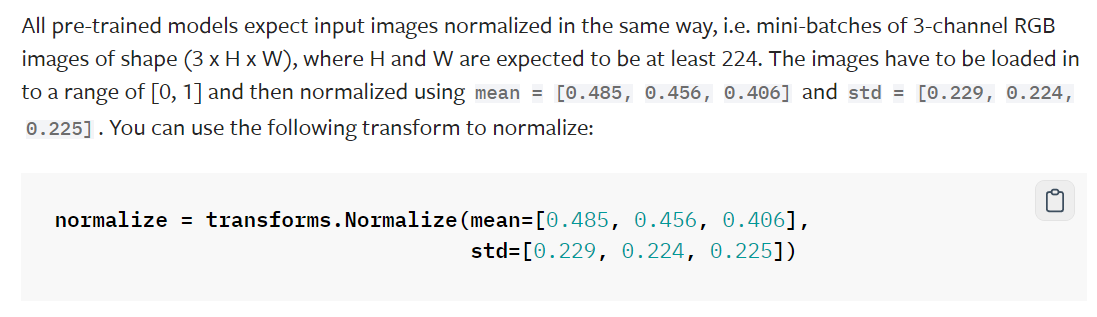

有一点需要注意,那就是这些模型的预训练参数都是对数据进行正则化后再进行训练的,官方具体说明:

不过对于为什么要采用该种方式进行正则数据只给出了简单解释,这里我们暂且可以认为该种正则方式是习惯操作或惯例操作。

import torch

from torchvision import datasets, transforms as T transform = T.Compose([T.Resize(256), T.CenterCrop(224), T.ToTensor()])

dataset = datasets.ImageNet(".", split="train", transform=transform) means = []

stds = []

for img in subset(dataset):

means.append(torch.mean(img))

stds.append(torch.std(img)) mean = torch.mean(torch.tensor(means))

std = torch.mean(torch.tensor(stds))

官方给出的解释是当时他们最原始编写代码时计算了一下数据集的均值与方差,然后并一直用这个数字来进行计算了。

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]

从代码:

transform = T.Compose([T.Resize(256), T.CenterCrop(224), T.ToTensor()])

dataset = datasets.ImageNet(".", split="train", transform=transform)

中可以看到官方原始操作时是将数据集中的数据进行resize,crop操作后在进行均值和方差计算的。

for img in subset(dataset):

means.append(torch.mean(img))

stds.append(torch.std(img))

分别求每张图片R G B三色中每一色像素的均值与方差。

mean = torch.mean(torch.tensor(means))

std = torch.mean(torch.tensor(stds))

对所有图片的R G B均值与方差求数据集范围的统计均值,最终得到:

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]

官方给出补充解释:

Unfortunately, the concrete subset that was used is lost. For more information see this discussion or these experiments.

也就是原始数据集已经找不到了,但是我们即使使用其他数据集也已然按照惯例使用这个均值与方差,如果自己的数据集本身过小那么自己重新求这个均值与方差可能导致泛化性降低,而如果使用大数据集的话进行如此计算也十分耗计算资源,这可能也是领域内现在也惯例使用这个均值方差来进行数据正则的原因。

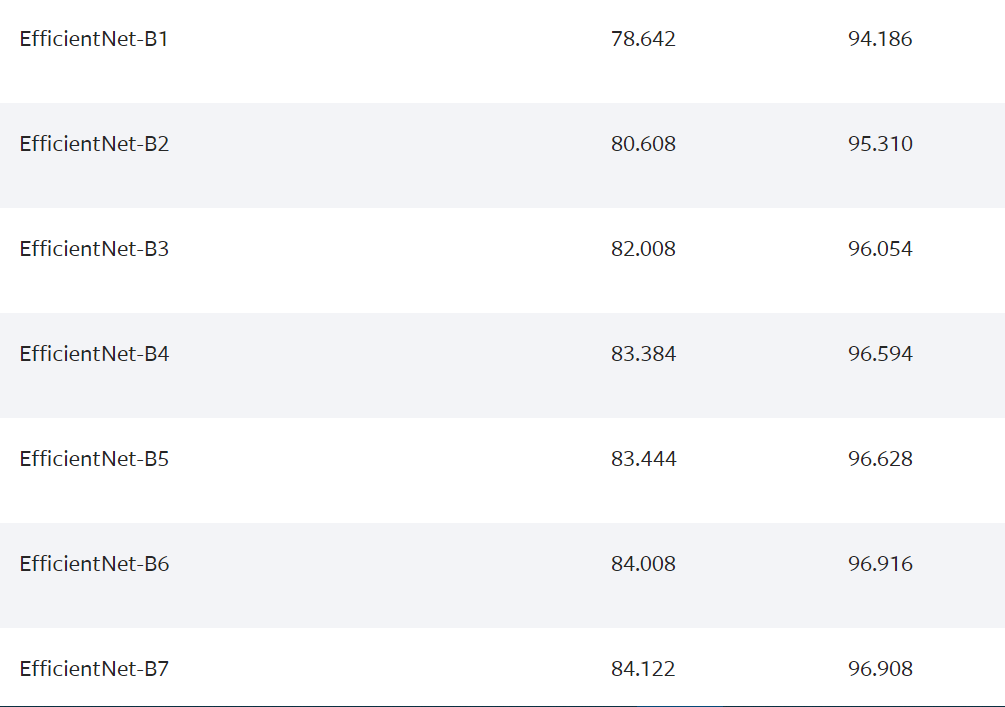

官方给出说明,对于 EfficientNet 网络来说模型的尺寸与变量有关。不过个人解读就是不同版本的EfficientNet模型其crop及input的size也是不同的,具体的size如下给出:

The sizes of the EfficientNet models depend on the variant. For the exact input sizes check here

例子中的代码设置:

====================================================

PyTorch视觉模型库torchvision.models介绍的更多相关文章

- PyTorch源码解读之torchvision.models(转)

原文地址:https://blog.csdn.net/u014380165/article/details/79119664 PyTorch框架中有一个非常重要且好用的包:torchvision,该包 ...

- 0702-计算机视觉工具包torchvision

0702-计算机视觉工具包torchvision 目录 一.torchvision 概述 二.通过 torchvision 加载模型 三.通过 torchvision 加载并处理数据集 四.通过 to ...

- 【小白学PyTorch】5 torchvision预训练模型与数据集全览

文章来自:微信公众号[机器学习炼丹术].一个ai专业研究生的个人学习分享公众号 文章目录: 目录 torchvision 1 torchvision.datssets 2 torchvision.mo ...

- 关于torchvision.models中VGG的笔记

VGG 主要有两种结构,分别是 VGG16 和 VGG19,两者并没有本质上的区别,只是网络深度不一样. 对于给定的感受野,采用堆积的小卷积核是优于采用大的卷积核的,因为多层非线性层可以增加网络深度来 ...

- 【Unity Shaders】Lighting Models 介绍

本系列主要参考<Unity Shaders and Effects Cookbook>一书(感谢原书作者),同时会加上一点个人理解或拓展. 这里是本书所有的插图.这里是本书所需的代码和资源 ...

- Django的models介绍

我们一般会在创建表的类中写一个__str__方法,就会为为了打印这个对象不会打印一大堆的对象的内存地址,而是我们想要他返回的信息,方便我们更直观的知道这个对象是谁,方便显示.比如下面的例子 from ...

- [Pytorch框架] 5.1 kaggle介绍

文章目录 5.1 kaggle介绍 5.1.1 Kaggle 平台简介 比赛介绍 5.1.2 Kaggle板块介绍 Data Rules Team Kernels Discussion Leaderb ...

- PyTorch DataSet Normalization torchvision.transforms.Normalize()

特征缩放, 在这种情况下,我们不仅仅考虑是一个值的数据集,我们考虑的是具有多个特征和相关的值的样本或元素的数据集. 假如正在处理一个人的数据集, 归一化数据集有许多不同的 ...

- 【pytorch报错解决】expected input to have 3 channels, but got 1 channels instead

遇到的问题 数据是png图像的时候,如果用PIL读取图像,获得的是单通道的,不是多通道的.虽然使用opencv读取图片可以获得三通道图像数据,如下: def __getitem__(self, idx ...

- torchvision.transforms模块介绍

torchvision.transforms模块 官网地址:https://pytorch.org/docs/stable/torchvision/transforms.html# torchvisi ...

随机推荐

- requests高级操作

requests的Cookie处理 有时相关的需求会让我们去爬取基于某些用户的相关用户信息,例如爬取张三人人网账户中的个人身份信息.好友账号信息等. 那么这个时候,我们就需要对当前用户进行登录操作,登 ...

- doris wget 地址

wget https://apache-doris-releases.oss-accelerate.aliyuncs.com/apache-doris-2.0.0-alpha1-bin-x86_64. ...

- 14-LNMP搭建

介绍 LNMP: Linux + Nginx + Mysql/Mariadb + PHP 借助LNMP,我们就能搭建一个动态的网页. 安装Nginx 详细nginx教程:https://blog.cs ...

- Linux增加系统调用(亲测成功)

我使用的操作系统是CentOS,其他的操作系统类似. 相关软件和Linux的基础操作这里不再赘述. 实验环境 VMWare Workstation.CentOS-7 实验步骤 ...

- Linux驱动中的异步函数(aio_read和aio_write)

Linux驱动中的异步函数(aio_read和aio_write) 我们可以在signal_handler使用了read和write函数处理设备文件的读写操作.然而这两个函数可以分别用aio_read ...

- 3562-Qt工程编译说明

- UG 2406 python 二次开发环境配置

UG 2406 python 二次开发环境配置 项目地址 https://gitee.com/unm001/nx2406.git 安装python 安装 python 3.10.11 D:\prog\ ...

- Centos7安装Redis详细步骤(配置开机自启)

Redis 获取redis安装包使用tar命令解压. $ tar -zxzf redis-6.2.6.tar.gz 编译和安装redis 进入redis目录,执行make编译. $ cd redis- ...

- Nuxt.js 错误侦探:useError 组合函数

title: Nuxt.js 错误侦探:useError 组合函数 date: 2024/7/14 updated: 2024/7/14 author: cmdragon excerpt: 摘要:文章 ...

- 新一代云原生日志架构 - Loggie的设计与实践

Loggie萌芽于网易严选业务的实际需求,成长于严选与数帆的长期共建,持续发展于网易数帆与网易传媒.中国工商银行的紧密协作.广泛的生态,使得项目能够基于业务需求不断完善.成熟.目前已经开源:https ...