[Stats385] Lecture 04: Convnets from Probabilistic Perspective

本篇围绕“深度渲染混合模型”展开。

- A Probabilistic Framework for Deep Learning

- Semi-Supervised Learning with the Deep Rendering Mixture Model

- A Probabilistic Theory of Deep Learning

13:49 / 1:30:37

GAN的统计意义:统计假设检验

GAN 一定意义上成为了classical statistical hypothesis testing,判断新产生的数据到底属于哪一个model。

CNN vs DRM Model

Weight: dictionaries

Value: sparse coding

Dropout: missing at randam data em algorithm

Back-propagation: m step of generalized em algorithm

Batch normalization: curvature normalization

AutoEncoder: em algorithm with reconstruction

Skip connection: preconditioning

19:30 / 1:30:37

Lecture starts.

先从视觉神经系统找到深度学习的依据;

然后开始提及常见的卷积网络,以及一些缺陷,例如暴雨天识别效果差。

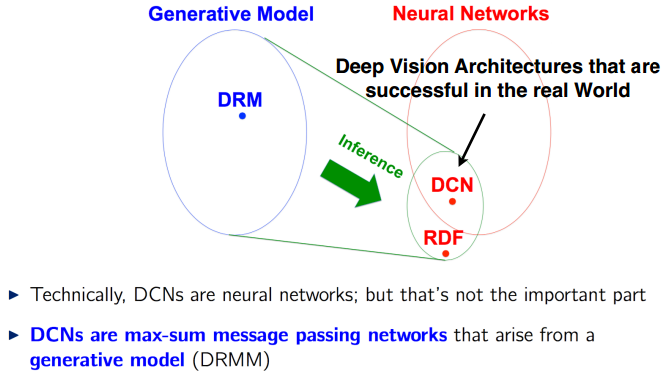

- 从概率生成式模型 Generative Model入手

提到了Deep Rendering Mixture Model,深度渲染混合模型;可通过该链接初步了解:http://www.sohu.com/a/121834092_465975

Each Layer of the DRMM is a Sparse Coding Model.

Inference in the DRMM yields Deep Convnets

作为一种Probabilistic Framework for Deep Learning,更一般化,貌似convNet成了它的特例?

如此,DRM的角色是为人们设计新的神经网络结构作为指导。

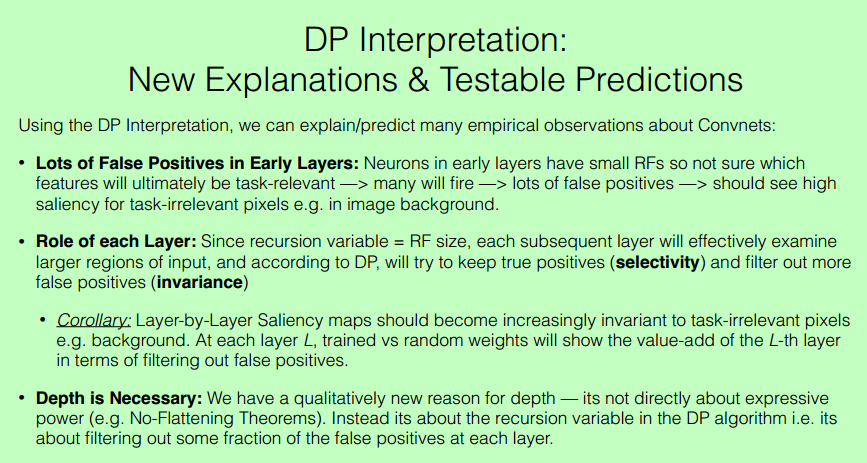

- 从动态规划的角度去认识

The Dynamic Programming Algorithm Interpretation of Convnets

Saliency Maps show Selectivity and Invariance are Built up over Layers

Question: How do Convnets build up invariance to background?

Experiment: Visualize saliency maps for active neurons at each layer.

Observations:

• Neurons in early layers are selective for all detectable features in input, including background.

• Neurons in deeper layers are selective only for small subset of input pixels (those useful for discriminating class)

• Neurons in deep layers are invariant to (almost all) irrelevant pixels e.g. background and below the neck.

次要的特征逐渐被筛掉,相当于逐渐找到了更优路径。

说明关系的一张图,不错。

[Stats385] Lecture 04: Convnets from Probabilistic Perspective的更多相关文章

- [Stats385] Lecture 01-02, warm up with some questions

Theories of Deep Learning 借该课程,进入战略要地的局部战斗中,采用红色字体表示值得深究的概念,以及想起的一些需要注意的地方. Lecture 01 Lecture01: De ...

- [Stats385] Lecture 03, Harmonic Analysis of Deep CNN

大咖秀,注意提问环节大家的表情,深入窥探大咖的心态,很有意思. 之前有NG做访谈,现在这成了学术圈流行. Video: https://www.youtube.com/watch?v=oCohnBbm ...

- [Stats385] Lecture 05: Avoid the curse of dimensionality

Lecturer 咖中咖 Tomaso A. Poggio Lecture slice Lecture video 三个基本问题: Approximation Theory: When and why ...

- 本人AI知识体系导航 - AI menu

Relevant Readable Links Name Interesting topic Comment Edwin Chen 非参贝叶斯 徐亦达老板 Dirichlet Process 学习 ...

- 【机器学习Machine Learning】资料大全

昨天总结了深度学习的资料,今天把机器学习的资料也总结一下(友情提示:有些网站需要"科学上网"^_^) 推荐几本好书: 1.Pattern Recognition and Machi ...

- 【深度学习Deep Learning】资料大全

最近在学深度学习相关的东西,在网上搜集到了一些不错的资料,现在汇总一下: Free Online Books by Yoshua Bengio, Ian Goodfellow and Aaron C ...

- PRML读书会第十章 Approximate Inference(近似推断,变分推断,KL散度,平均场, Mean Field )

主讲人 戴玮 (新浪微博: @戴玮_CASIA) Wilbur_中博(1954123) 20:02:04 我们在前面看到,概率推断的核心任务就是计算某分布下的某个函数的期望.或者计算边缘概率分布.条件 ...

- 优化算法-BFGS

优化算法-BFGS BGFS是一种准牛顿算法, 所谓的"准"是指牛顿算法会使用Hessian矩阵来进行优化, 但是直接计算Hessian矩阵比较麻烦, 所以很多算法会使用近似的He ...

- 提升机器学习数学基础,这7本书一定要读-附pdf资源

文章发布于公号[数智物语] (ID:decision_engine),关注公号不错过每一篇干货. 来源 | KDnuggets 作者 | Ajit Jaokar 转自 | 新智元 编辑 | 大明 [编 ...

随机推荐

- DragonBones的下载和安装

DragonBones也称龙骨,是一款骨骼动画制作软件.DragonBones Pro是由Flash的龙骨骨骼动画插件进化而来的,与传统逐帧动画相比,骨骼动画资源较小且动画效果比较好. DragonB ...

- 微软官方的.net命令行参数库

虽然现在是图形化大行其道的时代,但让程序支持命令行启动对于专业的领域还是有不少需求的..net本身并没有内置对命令行解析的支持,我之前就写过一篇文章让.Net程序支持命令行启动介绍了几个第三方的命令行 ...

- PropertyGrid 重难点总结 转

PropertyGrid的界面组成与不同部分的名称如下图所示. 本博文不算是自己写作的,只是将PropertyGrid中的几项十分有用的功能的应用方面的文字进行一下总结,希望以后大家对Property ...

- ThreadLocal 简介 案例 源码分析 MD

Markdown版本笔记 我的GitHub首页 我的博客 我的微信 我的邮箱 MyAndroidBlogs baiqiantao baiqiantao bqt20094 baiqiantao@sina ...

- python的匿名函数lambda解释及用法

lambda函数的语法只包含一个语句,如下: lambda arg1,arg2,.....argn:expression(主要是看下面的例子)代码示例: #-*- coding:utf-8 -* ...

- windows多线程同步互斥--总结

我的windows多线程系列文章: windows多线程--原子操作 windows多线程同步--事件 windows多线程同步--互斥量 windows多线程同步--临界区 windows多线程同步 ...

- SpringBoot 2.x 整合ElasticSearch的demo

SpringBoot 2.x 整合ElasticSearch的demo 1.配置文件application.yml信息 # Tomcat server: tomcat: uri-encoding: U ...

- 【LeetCode】239. Sliding Window Maximum

Sliding Window Maximum Given an array nums, there is a sliding window of size k which is moving fr ...

- 自动化测试中CSS SELECTOR选择器的一些写法

常见符号: #表示id .表示class >表示子元素,层级 一个空格也表示子元素,但是是所有的后代子元素,相当于xpath中的相对路径 #input 选择id为input的节点 .Volvo ...

- Axure RP for Mac(网站交互式原型设计工具)破解版安装

1.软件简介 Axure RP 是 macOS 系统上一款最知名和最强大的原型设计工具,增加了大量新的特性,如应用多个动画,并同一时间运行一个小部件,如褪色,同时移动等,而且具有全新的图标和界面 ...