tensorflow进阶篇-5(反向传播2)

上面是一个简单的回归算法,下面是一个简单的二分值分类算法。从两个正态分布(N(-1,1)和N(3,1))生成100个数。所有从正态分布N(-1,1)生成的数据目标0;从正态分布N(3,1)生成的数据标为目标类1,模型算法通过sigmoid函数将这些生成的数据转换成目标类数据。换句话讲,模型算法是sigmoid(x+A),其中,A是要拟合的变量,理论上A=-1。假设,两个正态分布的均值分别是m1和m2,则达到A的取值时,它们通过-(m1+m2)/2转换成到0等距离的值。

实现如下:

import matplotlib.pyplot as plt

import numpy as np

import tensorflow as tf

from tensorflow.python.framework import ops ops.reset_default_graph() # 创建计算图

sess = tf.Session() # 生成数据,100个随机数x_vals:50个(-1,1)之间的随机数和50个(1,3)之间的随机数

# 以及100个目标数y_vals:50个0、50个1

x_vals = np.concatenate((np.random.normal(-1, 1, 50), np.random.normal(3, 1, 50)))

y_vals = np.concatenate((np.repeat(0., 50), np.repeat(1., 50)))

# 声明x_data、target占位符

x_data = tf.placeholder(shape=[1], dtype=tf.float32)

y_target = tf.placeholder(shape=[1], dtype=tf.float32) # 声明变量A,(初始值为10附近,远离理论值-1)

A = tf.Variable(tf.random_normal(mean=10, shape=[1])) # 实现sigmoid(x_data+A),这里不必封装sigmoid函数,损失函数中会自动实现

my_output = tf.add(x_data, A) # 为my_output、y_target添加一个维度

my_output_expanded = tf.expand_dims(my_output, 0)

y_target_expanded = tf.expand_dims(y_target, 0) # 初始化所有变量

init = tf.initialize_all_variables()

sess.run(init) # 添加损失函数,Sigmoid交叉熵损失函数。

# L = -actual * (log(sigmoid(pred))) - (1-actual)(log(1-sigmoid(pred)))

# or

# L = max(actual, 0) - actual * pred + log(1 + exp(-abs(actual)))

xentropy = tf.nn.sigmoid_cross_entropy_with_logits(logits=my_output_expanded,labels= y_target_expanded) # 声明变量的优化器

my_opt = tf.train.GradientDescentOptimizer(0.05)

train_step = my_opt.minimize(xentropy) # 训练,将损失值加入数组loss_batch

loss_batch = []

for i in range(1400):

rand_index = np.random.choice(100)

rand_x = [x_vals[rand_index]]

rand_y = [y_vals[rand_index]]

sess.run(train_step, feed_dict={x_data: rand_x, y_target: rand_y})

target=sess.run(xentropy, feed_dict={x_data: rand_x, y_target: rand_y})

print('Step #' + str(i + 1) + ' A = ' + str(sess.run(A)))

print('Loss = ' + str(target))

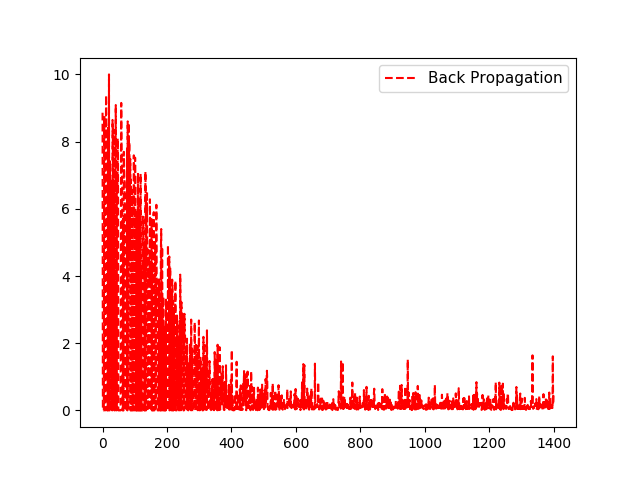

loss_batch.append(float(target)) plt.plot( loss_batch, 'r--', label='Back Propagation')

plt.legend(loc='upper right', prop={'size': 11})

plt.show() # 评估预测

predictions = []

for i in range(len(x_vals)):

x_val = [x_vals[i]]

prediction = sess.run(tf.round(tf.sigmoid(my_output)), feed_dict={x_data: x_val})

predictions.append(prediction[0]) accuracy = sum(x == y for x, y in zip(predictions, y_vals)) / 100.

print('Ending Accuracy = ' + str(np.round(accuracy, 2)))

输出结果:

Step #1 A = [ 9.38409519]

Loss = [[ 8.86125183]]

Step #2 A = [ 9.38409519]

Loss = [[ 2.55701457e-06]]

.........

Step #1398 A = [-1.09940839]

Loss = [[ 1.60983551]]

Step #1399 A = [-1.09107065]

Loss = [[ 0.18104036]]

Step #1400 A = [-1.10927427]

Loss = [[ 0.44608194]]

Ending Accuracy = 0.96

对于损失函数看这里:tensorflow进阶篇-4(损失函数1),tensorflow进阶篇-4(损失函数2),tensorflow进阶篇-4(损失函数3)

tensorflow进阶篇-5(反向传播2)的更多相关文章

- tensorflow进阶篇-5(反向传播1)

这里将讲解tensorflow是如何通过计算图来更新变量和最小化损失函数来反向传播误差的:这步将通过声明优化函数来实现.一旦声明好优化函数,tensorflow将通过它在所有的计算图中解决反向传播的项 ...

- tensorflow学习笔记(2)-反向传播

tensorflow学习笔记(2)-反向传播 反向传播是为了训练模型参数,在所有参数上使用梯度下降,让NN模型在的损失函数最小 损失函数:学过机器学习logistic回归都知道损失函数-就是预测值和真 ...

- 【TensorFlow篇】--反向传播

一.前述 反向自动求导是 TensorFlow 实现的方案,首先,它执行图的前向阶段,从输入到输出,去计算节点值,然后是反向阶段,从输出到输入去计算所有的偏导. 二.具体 1.举例 图是第二个阶段,在 ...

- tensorflow进阶篇-4(损失函数2)

Hinge损失函数主要用来评估支持向量机算法,但有时也用来评估神经网络算法.下面的示例中是计算两个目标类(-1,1)之间的损失.下面的代码中,使用目标值1,所以预测值离1越近,损失函数值越小: # U ...

- tensorflow进阶篇-4(损失函数1)

L2正则损失函数(即欧拉损失函数),L2正则损失函数是预测值与目标函数差值的平方和.L2正则损失函数是非常有用的损失函数,因为它在目标值附近有更好的曲度,并且离目标越近收敛越慢: # L = (pre ...

- tensorflow进阶篇-3

#-*- coding:utf-8 -*- #Tensorflow的嵌入Layer import numpy as np import tensorflow as tf sess=tf.Session ...

- tensorflow进阶篇-4(损失函数3)

Softmax交叉熵损失函数(Softmax cross-entropy loss)是作用于非归一化的输出结果只针对单个目标分类的计算损失.通过softmax函数将输出结果转化成概率分布,然后计算真值 ...

- [2] TensorFlow 向前传播算法(forward-propagation)与反向传播算法(back-propagation)

TensorFlow Playground http://playground.tensorflow.org 帮助更好的理解,游乐场Playground可以实现可视化训练过程的工具 TensorFlo ...

- Tensorflow笔记——神经网络图像识别(一)前反向传播,神经网络八股

第一讲:人工智能概述 第三讲:Tensorflow框架 前向传播: 反向传播: 总的代码: #coding:utf-8 #1.导入模块,生成模拟数据集 import t ...

随机推荐

- 天使投资、A轮、B轮、C轮

一般是这样划分的. A轮融资:公司产品有了成熟模样,开始正常运作一段时间并有完整详细的商业及盈利模式,在行业内拥有一定地位和口碑.公司可能依旧处于亏损状态.资金来源一般是专业的风险投资机构(VC).投 ...

- 20155205 2016-2017-2《Java程序设计》课程总结

20155205 2016-2017-2<Java程序设计>课程总结 目录 一.每周作业链接汇总 二.实验报告链接汇总 三.博客中的经验与收获 - 自认为写得最好一篇博客是?为什么? - ...

- 19) maven 项目结构:聚集

Project Aggregation [,æɡrɪ'ɡeɪʃən] https://maven.apache.org/guides/introduction/introduction-to-the- ...

- 20155326刘美岑 2016-2017-2 《Java程序设计》第5周学习总结

20155326刘美岑 2016-2017-2 <Java程序设计>第5周学习总结 教材学习内容总结 使用 try.catch (1)java中所有的错误都会被打包为对象,如果愿意,可以尝 ...

- C#.NET WebApi返回各种类型(图片/json数据/字符串),.net图片转二进制流或byte

using System.IO; /// <summary> /// WebApi返回图片 /// </summary> public HttpResponseMessage ...

- POJ3692 Kindergarten

Kindergarten Time Limit: 2000MS Memory Limit: 65536K Total Submissions: 6882 Accepted: 3402 Desc ...

- NameNode工作机制

NameNode工作机制

- 省赛在即!最大流问题回顾学习!!DInic

Dinic是很好的算法,但是我还是从ek算法复习起步 面对最大流问题,印象最深的就是反向边的思想,他给我们提供了反悔的机会,其实现在放到实际上来想,可以相当于两边的水都流了这条边,只是方向不一样,放到 ...

- linux 三剑客之awk

#AWK命令 基础显示 打印install.log文件中包含data字段行的第二区域 awk '/data/ {print $2}' install.log 查看num10.txt的第一行 head ...

- 应该知道的Linux技巧【转】

这篇文章来源于Quroa的一个问答<What are some time-saving tips that every Linux user should know?>—— Linux用户 ...