Hadoop基础知识

1.hadoop目录了解

bin:可执行文件,命令启动的脚本等

sbin:系统级可执行文件,服务的启动和停止相关

etc:配置文件

lib:native本地平台相关依赖库(windows用win编译的库,linux用linux编译的库)

share:doc即文档可删除,hadoop目录即jar包分工程的存放目录

2.etc配置文件核心配置项

(1)hadoop-env.sh 环境变量

修改java环境变量

(2)core-site.xml 公共配置项

集群默认的文件系统fs.defaultFS: hdfs://namenode:9000/

hadoop进程在本地的工作目录,namenode存放元数据,datanode存放数据块:/opt/hadoop2.6.0/tmp。namenode会在tmp下创建name文件夹,datanode会在tmp下创建data文件夹。

(3)hdfs-site.xml 与hdfs运行有关参数

副本的数量dfs.replication:3

(4)mapred-site.xml 程序运行

mapreduce程序跑在哪个资源调度框架mapreduce.framework.name:yarn

(5)yarn-site.xml yarn配置项

yarn框架的主节点yarn.resourcemanager.hostname:namenode

中间数据调度机制yarn.nodemanager.aux-services:mapreduce_shuffle

3.hadoop的启动

start-all.sh 启动所有进程,一般启动如下两个:

(1)start-dfs.sh

图中可以看到各个进程监控的端口,如:namenode监听9000(rpc通信端口namenode与datanode通信)及50070(web页面端口),

(2)start-yarn.sh

启动resourcemanager和nodemanager

4.hdfs文件的block块及副本的存放策略

传文件大小大于128M的文件到hdfs一级目录。

在namenode的dfs/name目录中的VERSION文件内容如下

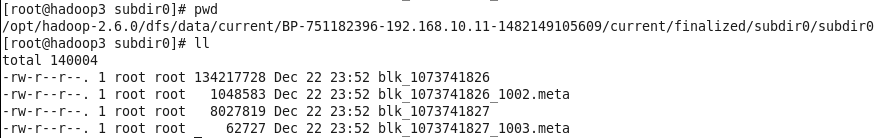

在datanode的dfs/data目录中的current子级有块的信息

可以看到图4中的BP……即图3中的blockpoolID,图4中的两个block块信息即为传输到hdfs的文件,这里被拆分为两个块。第一个块文件大小为134217728/1024/1024=128M。

副本的存放策略:

1.先在客户端所连接的datanode上存放一个副本

2.再在另一个机架上选择一个datanode存放第二个副本

3.最后在本机架根据负载情况随机挑选一个datanode存放第三个副本

5.checkpoint的触发设置

●fs.checkpoint.period 指定两次checkpoint的最大时间间隔,默认3600秒。

●fs.checkpoint.size 规定edits文件的最大值,一旦超过这个值则强制checkpoint,不管是否到达最大时间间隔,默认大小是64M

Hadoop基础知识的更多相关文章

- Hadoop基础知识串烧

YARN资源调度: 三种 FIFO 大任务独占 一堆小任务独占 capacity 弹性分配 :计算任务较少时候可以利用全部的计算资源,当队列的任务多的时候会按照比例进行资源平衡. 容量保证:保证队 ...

- Hadoop 基础知识

Hadoop 数据是存储在HDFS, Mapreduce 是一种计算框架,负责计算处理. HDFS上的数据存储默认是本地节点数据一份,同一机架不同节点一份,不同机架不同节点一份.默认是存储3份 HDF ...

- Hadoop基础(一)

Hadoop 基础知识 大数据已经火了很长很长时间了,从最开始是个公司都说自己公司的数据量很大,我们在搞大数据.到现在大数据真的已经非常成熟并且已经在逐渐的影响我们的生产生活.你可能听过支付宝的金融大 ...

- 零基础学习hadoop开发所必须具体的三个基础知识

大数据hadoop无疑是当前互联网领域受关注热度最高的词之一,大数据技术的应用正在潜移默化中对我们的生活和工作产生巨大的改变.这种改变给我们的感觉是“水到渠成”,更为让人惊叹的是大数据已经仅仅是互联网 ...

- hadoop分布式存储(1)-hadoop基础概念(毕业设计)

hadoop是一种用于海量数据存储.管理.分析的分布式系统.需要hadoop需要储备一定的基础知识:1.掌握一定的linux操作命令 2.会java编程.因此hadoop必须安装在有jdk的linux ...

- Linux基础知识入门

[Linux基础]Linux基础知识入门及常见命令. 前言:最近刚安装了Linux系统, 所以学了一些最基本的操作, 在这里把自己总结的笔记记录在这里. 1,V8:192.168.40.10V1: ...

- 大数据基础知识问答----spark篇,大数据生态圈

Spark相关知识点 1.Spark基础知识 1.Spark是什么? UCBerkeley AMPlab所开源的类HadoopMapReduce的通用的并行计算框架 dfsSpark基于mapredu ...

- IM开发基础知识补课(五):通俗易懂,正确理解并用好MQ消息队列

1.引言 消息是互联网信息的一种表现形式,是人利用计算机进行信息传递的有效载体,比如即时通讯网坛友最熟悉的即时通讯消息就是其具体的表现形式之一. 消息从发送者到接收者的典型传递方式有两种: 1)一种我 ...

- 最全的spark基础知识解答

原文:http://www.36dsj.com/archives/61155 一. Spark基础知识 1.Spark是什么? UCBerkeley AMPlab所开源的类HadoopMapReduc ...

随机推荐

- linux 下如何 makefile

本文目的: 尝试着把makefile讲解清楚.非原创,仅仅是学习笔记和备忘录之用. makefile 的目的和好处: 一个工程中的源文件不计数,其按类型.功能.模块分别放在若干个目录中,makefil ...

- <base>元素

HTML <base> 元素 <base> 标签描述了基本的链接地址/链接目标,该标签作为HTML文档中所有的链接标签的默认链接: <head><base h ...

- C# 该行已经属于另一个表

DataTable dtSource = (DataTable)this.gridControl1.DataSource; DataRow[] dr = dtSource.Select("c ...

- vim 长句子中的上下移动

当一个句子很长的时候,屏幕显示不下,就会分为多行,这个时候,你又想找到中间几行某部分的字母,怎么办?这个时候,先按下一个 g ,在按下 j / k ,就可以实现长句子的上下移动了.

- jquery插件学习之元素顶部悬浮

jquery插件的学习: HTML部分及应用 <!DOCTYPE html> <html> <head> <meta charset="utf-8& ...

- Win7 IIS下启用ASP.NET

问题产生的原因 先装的Win7,未启用IIS, 后启用IIS功能,即使选中开发选项只能默认打开ASP.net 中FrameWork2的支持,其它 版本的FrameWork默认IIS不支持,需要手工开启 ...

- Random随机类(11选5彩票)BigInteger大数据类(华为面试题1000的阶乘)

先上Java Web图 为了简化叙述,只写Java代码,然后控制台输出 使用[Random类]取得随机数 import java.util.Random; public class Fir { pub ...

- insert操作卡死的处理过程

insert操作卡死的处理过程 先看看insert为什么被卡死 SQL> select sql_id from v$sql where sql_text like 'delete from st ...

- 视频直播点播nginx-rtmp开发手册中文版

2016年8月18日12:42:35 参照官方文档https://github.com/arut/nginx-rtmp-module/wiki/Directives 请注意这个是粗翻译版,仅供参考,不 ...

- springboot+dubbo

使用springboot搭建dubbo服务,首先封装出springboot-dubbo的项目,引入在服务上加直接@Service直接使用,方便于拆封统一管理. package hello.dubbo. ...