[Apache Atlas] Atlas 架构设计及源代码简单分析

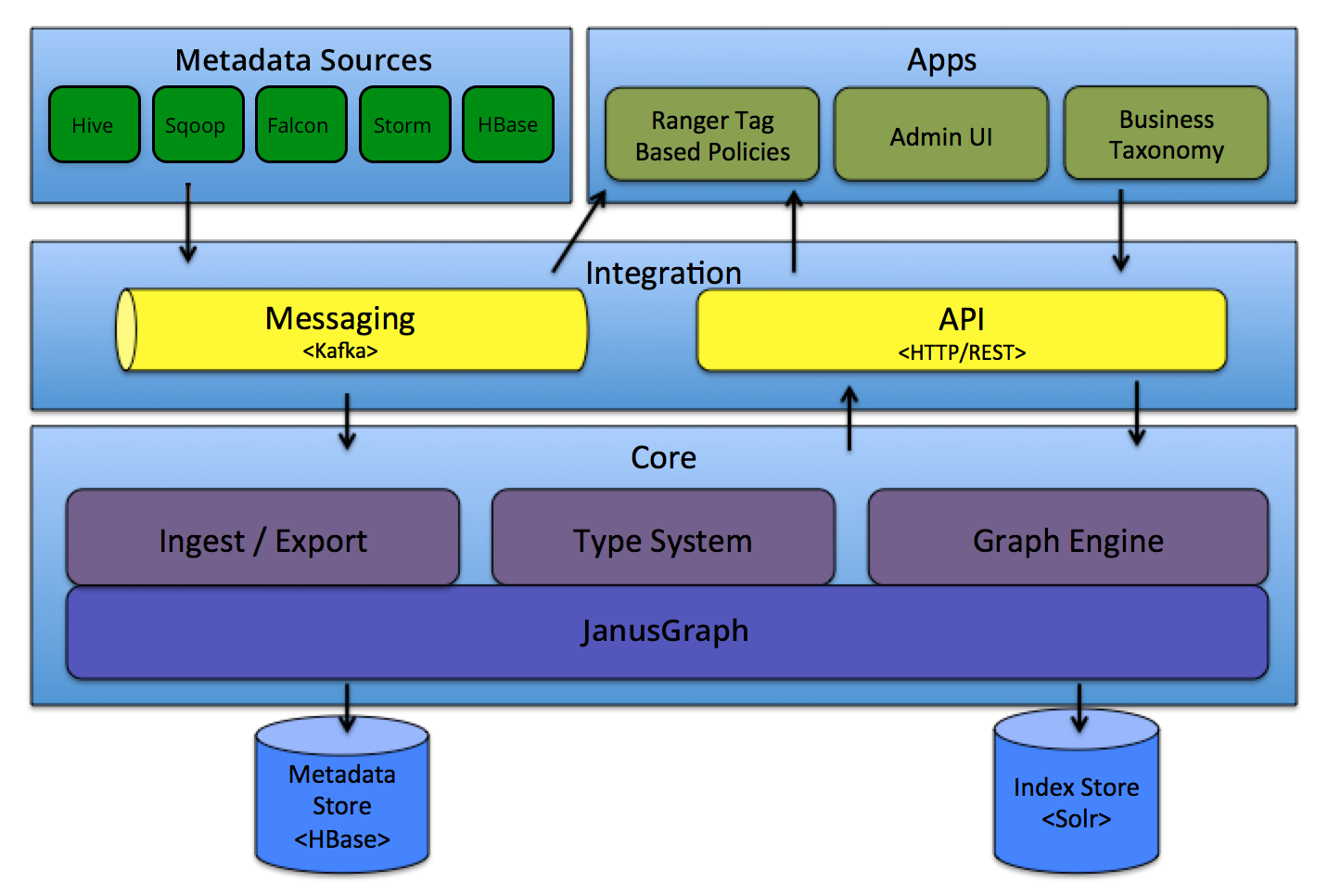

Apache Atlas 架构图

Atlas 支持多数据源接入:Hive、HBase、Storm等

Type System

Type

Atlas 中定义了一些元数据类型

── AtlasBaseTypeDef

│ ├── AtlasEnumDef

│ └── AtlasStructDef

│ ├── AtlasBusinessMetadataDef

│ ├── AtlasClassificationDef

│ ├── AtlasEntityDef

│ └── AtlasRelationshipDef

├── AtlasStructType

│ ├── AtlasBusinessMetadataType

│ ├── AtlasClassificationType

│ ├── AtlasRelationshipType

│ └── AtlasEntityType

│ └── AtlasRootEntityType

├── AtlasType

│ ├── AtlasArrayType

│ ├── AtlasBigDecimalType

│ ├── AtlasBigIntegerType

│ ├── AtlasByteType

│ ├── AtlasDateType

│ ├── AtlasDoubleType

│ ├── AtlasEnumType

│ ├── AtlasFloatType

│ ├── AtlasIntType

│ ├── AtlasLongType

│ ├── AtlasMapType

│ ├── AtlasObjectIdType

│ ├── AtlasShortType

│ ├── AtlasStringType

│ └── AtlasStructType

│ ├── AtlasBusinessMetadataType

│ ├── AtlasClassificationType

│ ├── AtlasEntityType

│ └── AtlasRelationshipType

├── AtlasTypeDefStore

│ └── AtlasTypeDefGraphStore

│ └── AtlasTypeDefGraphStoreV2

└── StructTypeDefinition

└── HierarchicalTypeDefinition

├── ClassTypeDefinition

└── TraitTypeDefinition

Entity

Entity 是基于类型的具体实现

AtlasEntity

├── AtlasEntityExtInfo

│ ├── AtlasEntitiesWithExtInfo

│ └── AtlasEntityWithExtInfo

├── AtlasEntityStore

│ └── AtlasEntityStoreV2

├── AtlasEntityStream

│ └── AtlasEntityStreamForImport

├── AtlasEntityType

│ └── AtlasRootEntityType

└── IAtlasEntityChangeNotifier

├── AtlasEntityChangeNotifier

└── EntityChangeNotifierNop

Attributes

针对模型定义属性

AtlasAttributeDef

└── AtlasRelationshipAttributeDef

AtlasAttributeDef 属性字段:

private String name;

private String typeName;

private boolean isOptional;

private Cardinality cardinality;

private int valuesMinCount;

private int valuesMaxCount;

private boolean isUnique;

private boolean isIndexable;

private boolean includeInNotification;

private String defaultValue;

private String description;

private int searchWeight = DEFAULT_SEARCHWEIGHT;

private IndexType indexType = null;

private List<AtlasConstraintDef> constraints;

private Map<String, String> options;

private String displayName;

具体实现:

db:

"name": "db",

"typeName": "hive_db",

"isOptional": false,

"isIndexable": true,

"isUnique": false,

"cardinality": "SINGLE"

columns:

"name": "columns",

"typeName": "array<hive_column>",

"isOptional": optional,

"isIndexable": true,

“isUnique": false,

"constraints": [ { "type": "ownedRef" } ]

- isComposite - 是否复合

- isIndexable - 是否索引

- isUnique - 是否唯一

- multiplicity - 指示此属性是(必需的/可选的/还是可以是多值)的

System specific types and their significance

Referenceable

This type represents all entities that can be searched for using a unique attribute called qualifiedName.

├── Referenceable

├── ReferenceableDeserializer

├── ReferenceableSerializer

└── V1SearchReferenceableSerializer

Hooks

以Hive元信息采集为例分析采集过程:

全量导入

import-hive.sh

"${JAVA_BIN}" ${JAVA_PROPERTIES} -cp "${CP}"

org.apache.atlas.hive.bridge.HiveMetaStoreBridge $IMPORT_ARGS

importTables

└── importDatabases [addons/hive-bridge/src/main/java/org/apache/atlas/hive/bridge/HiveMetaStoreBridge.java +295]

└── importHiveMetadata [addons/hive-bridge/src/main/java/org/apache/atlas/hive/bridge/HiveMetaStoreBridge.java +289]

上面是调用过程:

importTables -> importTable --> registerInstances

AtlasEntitiesWithExtInfo ret = null;

EntityMutationResponse response = atlasClientV2.createEntities(entities);

List<AtlasEntityHeader> createdEntities = response.getEntitiesByOperation(EntityMutations.EntityOperation.CREATE);

if (CollectionUtils.isNotEmpty(createdEntities)) {

ret = new AtlasEntitiesWithExtInfo();

for (AtlasEntityHeader createdEntity : createdEntities) {

AtlasEntityWithExtInfo entity = atlasClientV2.getEntityByGuid(createdEntity.getGuid());

ret.addEntity(entity.getEntity());

if (MapUtils.isNotEmpty(entity.getReferredEntities())) {

for (Map.Entry<String, AtlasEntity> entry : entity.getReferredEntities().entrySet()) {

ret.addReferredEntity(entry.getKey(), entry.getValue());

}

}

LOG.info("Created {} entity: name={}, guid={}", entity.getEntity().getTypeName(), entity.getEntity().getAttribute(ATTRIBUTE_QUALIFIED_NAME), entity.getEntity().getGuid());

}

}

通过Http Post 的请求将库表数据更新至Atlas

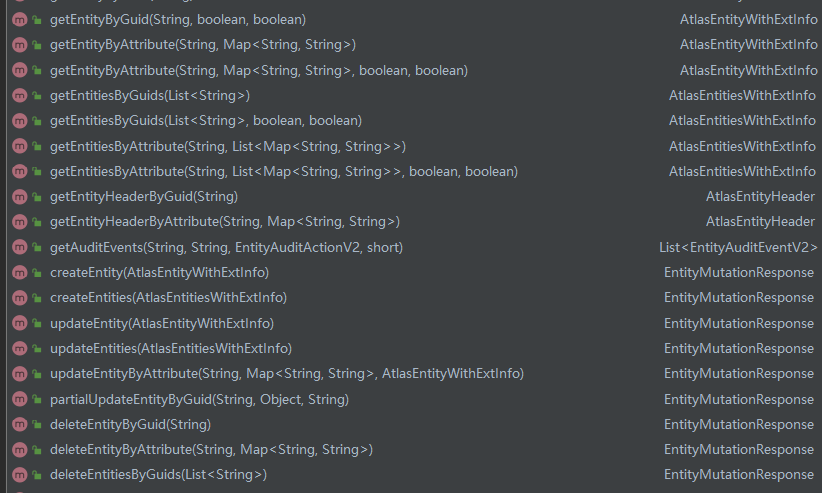

atlasClientV2有很多Http接口

Atlas HTTP 客户端API:

实时监听

HiveHook implements ExecuteWithHookContext

ExecuteWithHookContext is a new interface that the Pre/Post Execute Hook can run with the HookContext.

实现run()方法来对Hive 相关事件做处理

Hive相关事件:

BaseHiveEvent

├── AlterTableRename

├── CreateHiveProcess

├── DropDatabase

├── DropTable

├── CreateDatabase

│ └── AlterDatabase

└── CreateTable

└── AlterTable

└── AlterTableRenameCol

以create database 为例分析流程:

//处理Hook 上下文信息

AtlasHiveHookContext context =

new AtlasHiveHookContext(this, oper, hookContext, getKnownObjects(), isSkipTempTables());

//建库事件处理,提取相关库信息

event = new CreateDatabase(context);

if (event != null) {

final UserGroupInformation ugi = hookContext.getUgi() == null ? Utils.getUGI() : hookContext.getUgi();

super.notifyEntities(ActiveEntityFilter.apply(event.getNotificationMessages()), ugi);

}

public enum HookNotificationType {

TYPE_CREATE, TYPE_UPDATE, ENTITY_CREATE, ENTITY_PARTIAL_UPDATE, ENTITY_FULL_UPDATE, ENTITY_DELETE,

ENTITY_CREATE_V2, ENTITY_PARTIAL_UPDATE_V2, ENTITY_FULL_UPDATE_V2, ENTITY_DELETE_V2

}

//操作用户获取

if (context.isMetastoreHook()) {

try {

ugi = SecurityUtils.getUGI();

} catch (Exception e) {

//do nothing

}

} else {

ret = getHiveUserName();

if (StringUtils.isEmpty(ret)) {

ugi = getUgi();

}

}

if (ugi != null) {

ret = ugi.getShortUserName();

}

if (StringUtils.isEmpty(ret)) {

try {

ret = UserGroupInformation.getCurrentUser().getShortUserName();

} catch (IOException e) {

LOG.warn("Failed for UserGroupInformation.getCurrentUser() ", e);

ret = System.getProperty("user.name");

}

}

主要:

获取实体信息, 传递Hook message的类型、操作用户

notifyEntities 可以看出其他组件HBase、impala也会调用该方法进行消息的发送

public static void notifyEntities(List<HookNotification> messages, UserGroupInformation ugi, int maxRetries) {

if (executor == null) { // send synchronously

notifyEntitiesInternal(messages, maxRetries, ugi, notificationInterface, logFailedMessages, failedMessagesLogger);

} else {

executor.submit(new Runnable() {

@Override

public void run() {

notifyEntitiesInternal(messages, maxRetries, ugi, notificationInterface, logFailedMessages, failedMessagesLogger);

}

});

}

}

消息通知框架:

NotificationInterface

├── AtlasFileSpool

└── AbstractNotification

├── KafkaNotification

└── Spooler

数据写入Kafka中:

@Override

public void sendInternal(NotificationType notificationType, List<String> messages) throws NotificationException {

KafkaProducer producer = getOrCreateProducer(notificationType);

sendInternalToProducer(producer, notificationType, messages);

}

根据NotificationType写入指定topic 中:

private static final Map<NotificationType, String> PRODUCER_TOPIC_MAP = new HashMap<NotificationType, String>() {

{

put(NotificationType.HOOK, ATLAS_HOOK_TOPIC);

put(NotificationType.ENTITIES, ATLAS_ENTITIES_TOPIC);

}

};

NOTIFICATION_HOOK_TOPIC_NAME("atlas.notification.hook.topic.name", "ATLAS_HOOK"),

NOTIFICATION_ENTITIES_TOPIC_NAME("atlas.notification.entities.topic.name", "ATLAS_ENTITIES"),

数据主要写入两个Topic中: ATLAS_ENTITIES、ATLAS_HOOK

ATLAS_HOOK是写入Hook事件消息, 创建库的事件元数据信息会写入该Topic中

如何唯一确定一个库:

public String getQualifiedName(Database db) {

return getDatabaseName(db) + QNAME_SEP_METADATA_NAMESPACE + getMetadataNamespace();

}

dbName@clusterName 确定唯一性

外延应用

一个基于Hive hook 实现Impala 元数据刷新的用例:

AutoRefreshImpala:https://github.com/Observe-secretly/AutoRefreshImpala

参考

[1] Apache Atlas – Data Governance and Metadata framework for Hadoop

[2] Apache Atlas 源码

[Apache Atlas] Atlas 架构设计及源代码简单分析的更多相关文章

- FFmpeg的HEVC解码器源代码简单分析:环路滤波(Loop Filter)

===================================================== HEVC源代码分析文章列表: [解码 -libavcodec HEVC 解码器] FFmpe ...

- FFmpeg的HEVC解码器源代码简单分析:CTU解码(CTU Decode)部分-TU

===================================================== HEVC源代码分析文章列表: [解码 -libavcodec HEVC 解码器] FFmpe ...

- FFmpeg的HEVC解码器源代码简单分析:CTU解码(CTU Decode)部分-PU

===================================================== HEVC源代码分析文章列表: [解码 -libavcodec HEVC 解码器] FFmpe ...

- FFmpeg源代码简单分析:libavdevice的gdigrab

===================================================== FFmpeg的库函数源代码分析文章列表: [架构图] FFmpeg源代码结构图 - 解码 F ...

- FFmpeg源代码简单分析:libavdevice的avdevice_register_all()

===================================================== FFmpeg的库函数源代码分析文章列表: [架构图] FFmpeg源代码结构图 - 解码 F ...

- FFmpeg源代码简单分析:configure

===================================================== FFmpeg的库函数源代码分析文章列表: [架构图] FFmpeg源代码结构图 - 解码 F ...

- FFmpeg源代码简单分析:makefile

===================================================== FFmpeg的库函数源代码分析文章列表: [架构图] FFmpeg源代码结构图 - 解码 F ...

- FFmpeg源代码简单分析:libswscale的sws_scale()

===================================================== FFmpeg的库函数源代码分析文章列表: [架构图] FFmpeg源代码结构图 - 解码 F ...

- FFmpeg源代码简单分析:libswscale的sws_getContext()

===================================================== FFmpeg的库函数源代码分析文章列表: [架构图] FFmpeg源代码结构图 - 解码 F ...

随机推荐

- 字节跳动Android实习面试难吗,应该如何应对?

字节跳动的面试难不难其实很难去非常准确的定义,但是能肯定的一点是,字节跳动的面试题都很有水平,真正考察了该岗位在以后工作中需要的能力. 大学学的Java后面又自学Android方向,跟着老师在实验室做 ...

- java8-stream常用操作(1)

前言 java8的Stream 流式操作,用于对集合进行投影.转换.过滤.排序.去重等,更进一步地说,这些操作能链式串联在一起使用,类似于 SQL 语句,可以大大简化代码.下面我就将平时常用的一些st ...

- 使用Squid部署代理缓存服务(标准正向、透明正反向代理)

正向代理让用户可以通过Squid服务程序获取网站页面等数据,具体工作形式又分为标准代理模式与透明代理模式.标准正向代理模式: 将网站的数据缓存在服务器本地,提高数据资源被再次访问时的效率,但用户必需在 ...

- 一个命令搞定 Web 国际化

背景 随着出海的业务越来越多,web 应用面临越来越多的国际化的工作.如何高效,高质量的完成 Web 前端国际化工作,已经是摆在 web 前端同学的急需解决的问题. i18n-helper-cli 是 ...

- NOIP 模拟 $15\; \text{夜莺与玫瑰}$

题解 一道很妙的题,让求对于一个矩阵中,两点相连成线,有多少条直线,他们的交集是有限集. 转化一下题目,发现水平和竖直的只有 \(n+m\) 条,而左斜和右斜的条数是相同的,所以我们只需求出左或右中的 ...

- 题解 P4111 [HEOI2015]小 Z 的房间

题解 题目大意:给定一个无向图,求它的生成树个数. 一道裸的矩阵树定理,外加一些建图的技巧. 矩阵树定理 对于一个 \(Laplace\) 矩阵,其去掉任意一行后的行列式即为答案. 行列式不会的看这里 ...

- Mybatis框架及原理实例分析

摘要 本篇文章只是个人阅读mybatis源码总结的经验或者个人理解mybatis的基本轮廓,作为抛砖引玉的功能,希望对你有帮助,如果需要深入了解细节还需亲自去阅读源码. mybatis基本架构 myb ...

- mysql开启远程访问权限的设置

MySql-Server 出于安全方面考虑默认只允许本机(localhost, 127.0.0.1)来连接访问. 所以必须给root修改可以远程访问的权限 1.在连接服务器后,操作mysql系统数据库 ...

- JDBC基础篇(MYSQL)——使用CallabeStatement调用存储过程

注意:其中的JdbcUtil是我自定义的连接工具类:代码例子链接: package day04_callable; import java.sql.CallableStatement; import ...

- flink的watermark机制你学会了吗?

大家好,今天我们来聊一聊flink的Watermark机制. 这也是flink系列的的第一篇文章,如果对flink.大数据感兴趣的小伙伴,记得点个关注呀. 背景 flink作为先进的流水计算引擎, ...