PHP curl之爬虫初步

php的curl可以实现模拟http的各种请求,这也是php做网络爬虫的基础,也多用于接口api的调用。

这个时候有人就要发问了:为什么你特么不用file_get_contents?

curl的性能比它好,而且可以完成更多复杂的操作,不仅仅只是获取页面数据。

下面先分别介绍一些常用的函数。

curl_init 初始化一个curl对话

curl_exec 执行请求

curl_close 关闭一个curl对话

curl_setopt 设置curl参数,即传输选项

curl_errno 返回最后一次错误码,php已经定义了诸多错误枚举编码

curl_errror 返回一个保护当前会话最近一次错误的字符串

....

下面我先举一个例子,简单的get获取我博客首页的数据:

<?php

/**

* test get request

* User: freephp

* Date: 2015/10/8

* Time: 15:08

*/ $ch = curl_init(); // 2. 设置选项,包括URL

curl_setopt($ch, CURLOPT_URL, "http://www.cnblogs.com/freephp");

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HEADER, 0);

// 3. 执行并获取HTML文档内容

$output = curl_exec($ch);

// 4. 释放curl句柄

curl_close($ch); print_r($output);

就可以打印出首页的html代码。

也可把内容写入某个文件存储,这不就是爬虫的第一步么? 然后我们正则匹配过滤出文章的url,我封装了一个方法:

/**

* 从html内容中筛选链接

*

* @param string $web_content

* @return array

*/

function filterUrl($web_content){

$reg_tag_a = '/<[a|A].*?class="postTitle2".*?href=[\'\"]{0,1}([^>\'\"\ ]*).*?>/';

$result = preg_match_all($reg_tag_a,$web_content,$match_result);

if($result){

return $match_result[1];

}

} print_r(filterUrl($output));

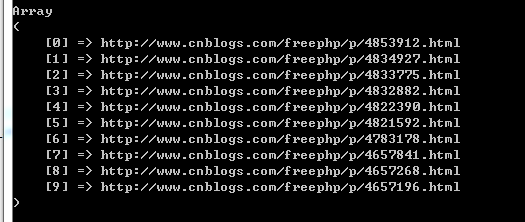

打印出来如图:

然后再遍历去请求这些url,然后拿到所有的文章内容。

(待续.....)

为了复用,我把curl请求发起,内容写入文件,过滤得到文章内容等操作封装成方法。最终的完整代码如下:

<?php

/**

* test get request

* User: freephp

* Date: 2015/10/8

* Time: 15:08

*/ /**

* 获取网页源码

*

* @param $url get方式请求的url

* @return mixed

*/

function getRquest($url)

{

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HEADER, 0);

// 3. 执行并获取HTML文档内容

$output = curl_exec($ch);

// 4. 释放curl句柄

curl_close($ch);

return $output;

} /**

* 从html内容中筛选链接

*

* @param string $web_content

* @return array

*/

function filterUrl($web_content)

{

$reg_tag_a = '/<[a|A].*?class="postTitle2".*?href=[\'\"]{0,1}([^>\'\"\ ]*).*?>/';

$result = preg_match_all($reg_tag_a, $web_content, $match_result);

if ($result) {

return $match_result[1];

}

} /**

* 从html内容中筛选文章内容

*

* @param string $content

* @return array

*/

function filterContent($content)

{ $reg = '/<.*\"cnblogs_post_body\">(.*?)<\/div>/ism';

$result = preg_match_all($reg, $content, $match_result);

if ($result) {

return $match_result[1];

}

} /**

* 抓取文章内容写入文件。

*

* @param string $fileName 存储文件名

* @param string $contents 文章内容

*/

function writeToFile($fileName, $contents)

{

$fp = fopen($fileName, 'w'); fwrite($fp, $contents);

fclose($fp);

} $output = getRquest("http://www.cnblogs.com/freephp"); $articleUrls = filterUrl($output);

if (empty($articleUrls)) {

echo '获取文章url失败';

die();

}

$articleNum = count($articleUrls);

echo '总共文章为:', $articleNum, "\r\n";

foreach ($articleUrls as $url) {

echo '开始爬取url:', $url, "\r\n";

$out = getRquest($url);

$cont = filterContent($out);

$filename = str_replace('.html', '', str_replace('http://www.cnblogs.com/freephp/p/', '', $url));

writeToFile($filename . '.txt', $cont[0]);

echo '完成爬取url:', $url, "\r\n";

}

后面还会用使用post方式等用途的curl,等到那个时候再封装成工具类吧。

PHP curl之爬虫初步的更多相关文章

- python预课04 列表,元祖,统计值计算示例,py文件转为EXE文件,爬虫初步学习

列表,元组 #list l1 = [1, 2, 3, '高弟弟'] #定义一个列表 #增 l1.append("DSB") #最后增加"DSB"的元素 #删 l ...

- python爬虫-初步认识

特此声明: 以下内容来源于博主:http://blog.csdn.net/pleasecallmewhy http://cuiq ...

- PHP之cURL(爬虫)

public static function SendDataByCurl($url,$data=array()){ //对空格进行转义 $url = str_replace(' ','+',$url ...

- curl 做爬虫 用服务器代理ip

有时候会ip会封锁,所以会用一些模拟代理ip进行抓取测试 从网上找了一下代码 function curl_string ($url,$user_agent,$proxy){ $ch = ...

- python预课05 爬虫初步学习+jieba分词+词云库+哔哩哔哩弹幕爬取示例(数据分析pandas)

结巴分词 import jieba """ pip install jieba 1.精确模式 2.全模式 3.搜索引擎模式 """ txt ...

- 爬虫抓取页面数据原理(php爬虫框架有很多 )

爬虫抓取页面数据原理(php爬虫框架有很多 ) 一.总结 1.php爬虫框架有很多,包括很多傻瓜式的软件 2.照以前写过java爬虫的例子来看,真的非常简单,就是一个获取网页数据的类或者方法(这里的话 ...

- python3爬虫初探(一)之urllib.request

---恢复内容开始--- #小白一个,在此写下自己的python爬虫初步的知识.如有错误,希望谅解并指出. #欢迎和大家交流python爬虫相关的问题 #2016/6/18 #----第一把武器--- ...

- 基于php编写的新闻类爬虫,插入WordPress数据库

这个爬虫写的比较久远,很久没有更新博客了. 1.首先思路是:通过php的curl_setopt()函数可以方便快捷的抓取网页. 2.什么样的新闻吸引人呢,当然的热点新闻了.这里选百度的搜索风云榜,获取 ...

- 转:CURL库在程序中的运用浅析

CURL库在程序中的运用浅析-nk_ysg-ChinaUnix博客 http://blog.chinaunix.net/uid-22476414-id-3286638.html 这个目录的文章转载fr ...

随机推荐

- javascript5

调用对象call object: 声明上下文对象declarative environment record; 作用域链scopechain: 变量解析:variable resolution: 引用 ...

- ASP.NET 5+EntityFramework 7

爱与恨的抉择:ASP.NET 5+EntityFramework 7 EF7 的纠缠 ASP.NET 5 的无助 忘不了你的好 一开始列出的这个博文大纲,让我想到了很久之前的一篇博文:恋爱虽易,相 ...

- SQL点滴10—使用with语句来写一个稍微复杂sql语句,附加和子查询的性能对比

原文:SQL点滴10-使用with语句来写一个稍微复杂sql语句,附加和子查询的性能对比 今天偶尔看到sql中也有with关键字,好歹也写了几年的sql语句,居然第一次接触,无知啊.看了一位博主的文章 ...

- automake/autoconf的简单例子

参考文章1:http://loftor.com/archives/automake.html 参考文章2:http://www.blogjava.net/huyi2006/articles/18790 ...

- Lua 5.2 Reference Manual

Lua 5.2 Reference Manual.pdf

- Huffman 压缩和解压缩java实现

附上完整的代码 http://download.csdn.net/download/u010485034/7847447 Huffman编码原理这里就不说了,是.这里来讲讲利用Huffman编码来进行 ...

- HTML 5 在Web SQL 使用演示样本

Web sql 这是一个模拟数据库浏览器.可以使用JS操作SQL完成数据读取和写入,但是这件事情并不多,现在支持的浏览器,而其W3C规格已经停止支持.外形似它的前景不是很亮. W3C 规范:http: ...

- log4net项目中如何配置,以下详解

log4net.config配置文件 <?xml version="1.0" encoding="utf-8"?> <log4net debu ...

- C#实现函数根据返回类型重载

一直以来都很奇怪为何C#不能直接支持函数返回值重载, 比如如下两个函数是编译不过的 Public Class DbHelper { Public Static int ExecuteScalar(); ...

- wcf契约版本处理与异常处理(随记)

-----------版本控制策略:必须支持向后兼容:----就是当服务端发生改变,但客户端未更新会不会发生错误: 一旦契约发布,若要契约发生变化,如何不影响客户端使用: ----wsdl:契约: 服 ...