关于kafka-clients JAVA API的基本使用

首先老规矩, 引入maven依赖

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>1.0.0</version>

</dependency>

关于kafka-clients的消息生产者:

@Slf4j

public class KafkaProducerClient { public static void pushMsg(String msg) throws Exception {

Properties props = new Properties();

props.put("bootstrap.servers", KafkaConstant.KAFKA_SERVER_ADDRESS);

props.put("acks", "0");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer producer = new KafkaProducer(props);

ProducerRecord<String, String> record = new ProducerRecord<>(KafkaConstant.KAFKA_TOPIC_NAME, 0, "123", msg);

producer.send(record, new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception e) {

if (e != null) {

e.printStackTrace();

}

log.info("pushMsg of msg: {}, metadata: {}", msg, metadata);

}

});

producer.close();

} }

关于kafka-clients的消息消费者

@Slf4j

public class KafkaConsumerClient extends Thread { private KafkaConsumerClient() {

} /**

* 初始化consumer

*/

public void initKafkaConsumer () {

log.info("init Kafka Consumer");

new KafkaConsumerClient().start();

} @Override

public void run() {

Properties props = new Properties(); props.put("bootstrap.servers", KafkaConstant.KAFKA_SERVER_ADDRESS);

props.put("group.id", "1");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("session.timeout.ms", "30000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); Consumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList(KafkaConstant.KAFKA_TOPIC_NAME));

consumer.seekToBeginning(new ArrayList<>()); // ===== 拿到所有的topic ===== //

Map<String, List<PartitionInfo>> listTopics = consumer.listTopics();

Set<Map.Entry<String, List<PartitionInfo>>> entries = listTopics.entrySet(); while (true) {

ConsumerRecords<String, String> records = consumer.poll(1000 * 60);

for(ConsumerRecord<String, String> record : records) {

System.out.println("[fetched from partition " + record.partition() + ", offset: " + record.offset() + ", message: " + record.value() + "]");

}

}

}

}

我们需要在项目启动的时候将消费者consumer启动起来

<bean id="initKafkaConsumer" class="com.dywl.zhoushan.kafka.KafkaConsumerClient" init-method="initKafkaConsumer"></bean>

然后调用生产者producer时, 消费者consumer就能拿到消息

如:

@Override

public void pushMsgById(Long id) throws Exception {

User user = new User();

user.setId(id);

user.setUsername("test11111111");

user.setPassword("test22222222");

String str = JsonUtil.toCompactJsonString(user);

log.info("pushMsgById is user: {}", str);

KafkaProducerClient.pushMsg(str);

}

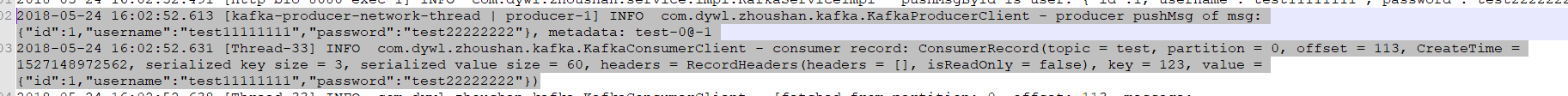

得到结果:

关于kafka-clients JAVA API的基本使用的更多相关文章

- kafka系列五、kafka常用java API

引入maven包 <dependency> <groupId>org.apache.kafka</groupId> <artifactId>kafka- ...

- java api如何获取kafka所有Topic列表,并放置为一个list

kafka内部所有的实现都是通过TopicCommand的main方法,通过java代码调用API,TopicCommand.main(options)的方式只能打印到控制台,不能转换到一个list. ...

- kafka2.9.2的伪分布式集群安装和demo(java api)测试

目录: 一.什么是kafka? 二.kafka的官方网站在哪里? 三.在哪里下载?需要哪些组件的支持? 四.如何安装? 五.FAQ 六.扩展阅读 一.什么是kafka? kafka是LinkedI ...

- ubuntu12.04+kafka2.9.2+zookeeper3.4.5的伪分布式集群安装和demo(java api)测试

博文作者:迦壹 博客地址:http://idoall.org/home.php?mod=space&uid=1&do=blog&id=547 转载声明:可以转载, 但必须以超链 ...

- 4 kafka集群部署及kafka生产者java客户端编程 + kafka消费者java客户端编程

本博文的主要内容有 kafka的单机模式部署 kafka的分布式模式部署 生产者java客户端编程 消费者java客户端编程 运行kafka ,需要依赖 zookeeper,你可以使用已有的 zo ...

- Java API获取topic所占磁盘空间(Kafka 1.0.0)

很多用户都有这样的需求:实时监控某个topic各分区在broker上所占的磁盘空间大小总和.Kafka并没有提供直接的脚本工具用于统计这些数据. 如果依然要实现这个需求,一种方法是通过监控JMX指标得 ...

- Kafka系列三 java API操作

使用java API操作kafka 1.pom.xml <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xs ...

- Kafka笔记整理(二):Kafka Java API使用

下面的测试代码使用的都是下面的topic: $ kafka-topics.sh --describe hadoop --zookeeper uplooking01:,uplooking02:,uplo ...

- kafka java API的使用

Kafka包含四种核心的API: 1.Producer API支持应用将数据流发送到Kafka集群的主题 2.Consumer API支持应用从Kafka集群的主题中读取数据流 3.Streams A ...

- _00017 Kafka的体系结构介绍以及Kafka入门案例(0基础案例+Java API的使用)

博文作者:妳那伊抹微笑 itdog8 地址链接 : http://www.itdog8.com(个人链接) 博客地址:http://blog.csdn.net/u012185296 博文标题:_000 ...

随机推荐

- nginx学习网站收录

1.菜鸟教程 2. Nginx中文 3. Nginx官网 参考:http://www.cnblogs.com/knowledgesea/p/5175711.html

- Python基础教程笔记——第6章:抽象(函数)

(1)计算裴波那契数列: fbis=[0,1] num=int(input("please input the number")) for i in range(num-2): f ...

- 魔咒词典--hdu1880(字符串 暴力)

http://acm.hdu.edu.cn/showproblem.php?pid=1880 不要想其他的 暴力就能过 #include <iostream> #include < ...

- 洛谷 P3879 [TJOI2010]阅读理解

P3879 [TJOI2010]阅读理解 题目描述 英语老师留了N篇阅读理解作业,但是每篇英文短文都有很多生词需要查字典,为了节约时间,现在要做个统计,算一算某些生词都在哪几篇短文中出现过. 输入输出 ...

- canvas仿芝麻信用分仪表盘

这是一个仿支付宝芝麻信用分的一个canvas,其实就是一个动画仪表盘. 首先, 上原图: 这个是在下支付宝上的截图,分低各位见笑了.然后看下我用canvas实现的效果图: <canvas id= ...

- ASP.NET Core 奇淫技巧之动态WebApi

一.前言 接触到动态WebApi(Dynamic Web API)这个词的已有几年,是从ABP框架里面接触到的,当时便对ABP的这个技术很好奇,后面分析了一波,也尝试过从ABP剥离一个出来作为独立组件 ...

- Meteor package.js

在本章中,我们将学习如何创建自己的 meteor 包. 创建包 让我们添加在桌面上的新文件夹用来创建新的包.使用命令提示符窗口执行如下命令. C:\Users\Administrator\Deskto ...

- [Javascript] Use JavaScript's for-in Loop on Objects with Prototypes

Loops can behave differently when objects have chained prototype objects. Let's see the difference w ...

- Navicat for MySQL出现#1045 错误怎么办

#1045 - Access denied for user 'root'@'localhost' (using password: NO)这是因为你连接的时候没有密码或者密码没改对导致的.如下图所示 ...

- 自己定义控件 播放GIF动画

watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQv/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/ ...