kafka服务端实验记录

kafka单机实验:

环境准备:

1、下载kafka,zookeeper,并解压

wget http://mirror.bit.edu.cn/apache/kafka/2.3.0/kafka_2.11-2.3.0.tgz

wget https://apache.org/dist/zookeeper/zookeeper-3.5.5/apache-zookeeper-3.5.5-bin.tar.gz

tar zxvf kafka_2.-2.3..tgz

tar zxvf apache-zookeeper-3.5.-bin.tar.gz

2、配置zookeeper

# 进入zookeeper的conf目录

# 拷贝一份zoo.cfg数据

cp zoo_sample.cfg zoo.cfg

# 编辑zoo.cfg数据

vim zoo.cfg

# 编辑内容,几个节点,添加几条(server.ZKID=ZKIP::),用于zk之间的通信

server.=127.0.0.1::

# zoo.cfg中有个dataDir配置(数据存储的目录),默认为/tmp/zookeeper

# 新建目录/tmp/zookeeper

mkdir /tmp/zookeeper

# 新建文件

vim /tmp/zookeeper/myid

# 编辑内容,一个数字(ZKID),对应zoo.cfg的配置 # 进入zookeeper的bin目录

# 启动zk,并查看zk状态是否正常

./zkServer.sh start

./zkServer.sh status

3、配置kafka

# 进入kafka的config目录

# 备份并编辑server.properties

cp server.properties server.properties.bak

vim server.properties

# 编辑内容,broker.id改为大于0的,不同机器设置的不一样

broker.id=

# 其它配置,有需要自行修改

# 例如zookeeper不在本机,可以通过设置zookeeper.connect

# 进入kafka的bin目录

# 启动kafka

./kafka-server-start.sh ../config/server.properties

开始实验:

1、一个副本一个分区

# 命令:创建一个主题(topic为test,分区为1)

./kafka-topics.sh --create --zookeeper localhost: --replication-factor --partitions --topic test

# 结果:

Created topic test.

# 命令:查看所有主题

./kafka-topics.sh --list --zookeeper localhost:

# 结果:

test

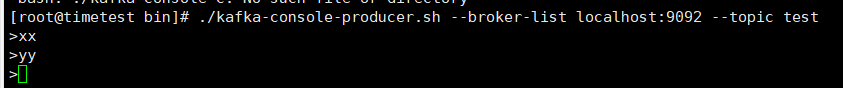

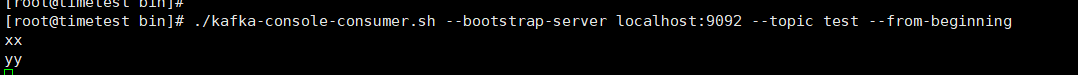

# 命令:启动一个生产者

./kafka-console-producer.sh --broker-list localhost: --topic test

# 命令:另起一个ssh连接服务器,启动一个消费者

./kafka-console-consumer.sh --bootstrap-server localhost: --topic test --from-beginning

# 结果:

在生产者输入消息,在消费者会收到消息

2、一个副本多个分区

# 命令:创建一个主题(topic为test2,分区为3)

./kafka-topics.sh --create --zookeeper localhost: --replication-factor --partitions --topic test2

# 结果:

Created topic test2.

# 命令:查询这个主题(test2)的详细信息

./kafka-topics.sh --describe --zookeeper localhost: --topic test2

# 结果:

# topic为test2,分区数为3,副本集数量为1(单机,只有主副本)

# Partition:不同分区(、、)

# Leader:主副本的节点(负责读写的节点)

# Replicas:分区的复制节点列表(单机,只有主副本)

# Isr:同步状态的复制节点列表(Replicas的子集,存活且赶上主副本的)

Topic:test2 PartitionCount: ReplicationFactor: Configs:

Topic: test2 Partition: Leader: Replicas: Isr:

Topic: test2 Partition: Leader: Replicas: Isr:

Topic: test2 Partition: Leader: Replicas: Isr:

# 命令:启动一个生产者,发几条消息

./kafka-console-producer.sh --broker-list localhost: --topic test2

msg1

msg2

msg3

msg4

msg5

msg6

# 命令:查看分区0的log日志,消息负载均衡到各个分区

strings /tmp/kafka-logs/test2-/.log

# 结果:

msg2

msg5

# 命令:查看分区1的log日志,消息负载均衡到各个分区

strings /tmp/kafka-logs/test2-/.log

# 结果:

msg1

msg4

# 命令:查看分区2的log日志,消息负载均衡到各个分区

strings /tmp/kafka-logs/test2-/.log

# 结果:

msg3

msg6

kafka集群实验:

环境准备:

1、原先机器 其它配置不变,修改kafka配置

# 进入kafka的config目录

# 编辑server.properties,将listeners设置上内网IP(通过ifconfig查看)

listeners=PLAINTEXT://192.168.0.83:9092

# 注意,kafka集群云主机的,客户端自己电脑上,想要生产数据或者消费数据,需要通过外网访问kafka集群

# 因此需要再配置advertised.listeners,配置的地址为外网IP

advertised.listeners=PLAINTEXT://1.6.2.8:9092

# 启动kafka

./kafka-server-start.sh ../config/server.properties

2、第二台机器 配置kafka

# 下载kafka

wget http://mirror.bit.edu.cn/apache/kafka/2.3.0/kafka_2.11-2.3.0.tgz

# 解压kafka

tar zxvf kafka_2.-2.3..tgz

# 进入kafka的config目录

# 备份并编辑server.properties

cp server.properties server.properties.bak

vim server.properties

# 编辑内容,broker.id改为大于0的,不同机器设置的不一样

broker.id=

# 编辑server.properties,将listeners设置上内网IP(通过ifconfig查看)

listeners=PLAINTEXT://192.168.0.5:9092

# 注意,kafka集群云主机的,客户端自己电脑上,想要生产数据或者消费数据,需要通过外网访问kafka集群

# 因此需要再配置advertised.listeners,配置的地址为外网IP

advertised.listeners=PLAINTEXT://1.6.2.4:9092

# 编辑内容,配置zk集群的地址(就第一台机器)

zookeeper.connect=192.168.0.83:

# 进入kafka的bin目录

# 启动kafka

./kafka-server-start.sh ../config/server.properties

开始实验:

1、各个分区在两个机器的负载均衡 以及 kafka集群的高可用

# 在第一台机器操作

# 进入kafka的bin目录

# 命令:创建一个主题(topic为test4,分区为3,副本集为2)

./kafka-topics.sh --create --zookeeper localhost: --replication-factor --partitions --topic test4

# 结果:

Created topic test4.

# 命令:查看topic(test4)的详细信息

./kafka-topics.sh --describe --zookeeper localhost: --topic test4

# 结果:每个分区的主副本负载均衡到两台机器

Topic:test4 PartitionCount: ReplicationFactor: Configs:

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

# 挂掉第二台机器的kafka

# 命令:查看topic(test4)的详细信息

./kafka-topics.sh --describe --zookeeper localhost: --topic test4

# 结果:分区的主副本会转移到第一台机器,Replicas不变,Isr只会有1,表示存活的只有1

Topic:test4 PartitionCount: ReplicationFactor: Configs:

Topic: test4 Partition: Leader: Replicas: , Isr:

Topic: test4 Partition: Leader: Replicas: , Isr:

Topic: test4 Partition: Leader: Replicas: , Isr:

# 命令:启动消费者输几条数据

./kafka-console-producer.sh --broker-list 116.196.92.98: --topic test4

msg1

msg2

msg3

msg4

msg5

msg6

# 恢复第二台机器的kafka

# 命令:查看topic(test4)的详细信息

./kafka-topics.sh --describe --zookeeper localhost: --topic test4

# 结果:主副本没变化,没再负载均衡到第二台机器,但是ISR的列表都加了2,表示第二台机器已存活并追上第一台机器

Topic:test4 PartitionCount: ReplicationFactor: Configs:

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

# 命令:查看下各个分区的日志,数据都已从第一台机器同步过来

strings /tmp/kafka-logs/test4-/.log

msg2

msg5

# 挂掉第一台机器的kafka

# 在第二台机器操作

# 进入kafka的bin目录

# 命令:查看topic(test4)的详细信息

./kafka-topics.sh --describe --zookeeper 192.168.0.83: --topic test4

# 结果:分区的主副本会转移到第二台机器,Replicas不变,Isr只会有2,表示存活的只有2

Topic:test4 PartitionCount: ReplicationFactor: Configs:

Topic: test4 Partition: Leader: Replicas: , Isr:

Topic: test4 Partition: Leader: Replicas: , Isr:

Topic: test4 Partition: Leader: Replicas: , Isr:

# 恢复第一台机器的kafka

# 命令:查看topic(test4)的详细信息

./kafka-topics.sh --describe --zookeeper 192.168.0.83: --topic test4

# 结果:主副本没变化,没再负载均衡到第一台机器,但是ISR的列表都加了1,表示第一台机器已存活并追上第二台机器

Topic:test4 PartitionCount: ReplicationFactor: Configs:

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

# 命令:负载均衡各个分区的主副本

./kafka-preferred-replica-election.sh --zookeeper 192.168.0.83:

# 命令:查看topic(test4)的详细信息

./kafka-topics.sh --describe --zookeeper 192.168.0.83: --topic test4

# 结果:各个分区的主副本进行负载均衡到两个机器

Topic:test4 PartitionCount: ReplicationFactor: Configs:

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

Topic: test4 Partition: Leader: Replicas: , Isr: ,

kafka服务端实验记录的更多相关文章

- Kafka服务端之网络连接源码分析

#### 简介 上次我们通过分析KafkaProducer的源码了解了生产端的主要流程,今天学习下服务端的网络层主要做了什么,先看下 KafkaServer的整体架构图  生产者——服务端网络连接

KafkaServer是Kafka服务端的主类, KafkaServer中和网络层有关的服务组件包括 SocketServer.KafkaApis 和 KafkaRequestHandlerPool后 ...

- kafka 部分问题处理记录

转载请注明原创地址:http://www.cnblogs.com/dongxiao-yang/p/7600561.html 一 broker启动后ReplicaFetcherThread OOM 版 ...

- 利用C#实现OPC-UA服务端

前言 最近接手了一个项目,做一个 OPC-UA 服务端?刚听到这个消息我是一脸懵,发自灵魂的三问“OPC-UA是什么?”.“要怎么做?”.“有什么用?”.我之前都是做互联网相关的东西,这种物联网的还真 ...

- Linux 部署 iSCSI 服务端

Linux 部署 iSCSI 服务端 服务端实验环境 iSCSI-server :RHEL8 IP:192.168.121.10 一.服务端安装 target 服务和 targetcli 命令行工具 ...

- 5种kafka消费端性能优化方法

摘要:带你了解基于FusionInsight HD&MRS的5种kafka消费端性能优化方法. 本文分享自华为云社区<FusionInsight HD&MRSkafka消费端性能 ...

随机推荐

- 开源项目 05 Dapper

using System; using System.Collections.Generic; using System.Linq; using System.Text; using System.T ...

- [RN] React Native 幻灯片效果 Banner

[RN] React Native 幻灯片效果 Banner 1.定义Banner import React, {Component} from 'react'; import {Image, Scr ...

- PHP生成随机数;订单号唯一

//8-12位随机数 function makeRand($num=){ $strand = (; if(strlen($strand)<$num){ $strand = str_pad($st ...

- linux命令之------Wc命令(word count)

Wc命令(word count) 1)作用:用于计算字数: 2)-c或--bytes或--chars只显示Bytes数: 3)-l和—line显示行号: 4)-w或words只显示字数: 5)--he ...

- php保存canvas导出的base64图片

代码如下: <?php $img='data:image/png;base64,iVBORw0KGgoAAAANSUhEUgAAAEYAAABxCAYAAABoUdWRAAAAAXNSR0IAr ...

- java学习笔记(5) 控制语句、键盘输入

控制语句: java控制可以分为7种: *控制选择结构语句: *if if else *switch *控制循环结构语句: *for *while *do while *改变控制语句顺序: *bre ...

- vscode快捷键,让你脱离鼠标,敲代码嗖嗖的

蓝色为本人需要经常用到的,可忽略 vsCode软件相关 显示资源管理器:Ctrl + Shift + E 显示搜索: Ctrl + Shift + F 显示git:Ctrl + Shift + G 显 ...

- leetcode 删除一张表中重复邮箱的数据,并且保留最小id 的 那条

/* create view testview as SELECT subject,MIN(Id) as id FROM test GROUP BY subject; select * FROM te ...

- Django基础之redirect()

参数可以是: 一个模型: 将调用模型的get_absolute_url()函数 一个视图, 可以带有函数: 可以使用urlresolvers.reverse来反向解析名称 一个绝对的或相对的URL, ...

- manjaro系统的回滚操作

作为linux系统的爱好者,自从使用linux后,就喜欢追求新的软件,连系统都换成了滚动升级的版本.manjaro基于arch linux,同时也是kde的支持系统,升级非常频繁.使用了几年,很少碰到 ...