Celery 服务搭建

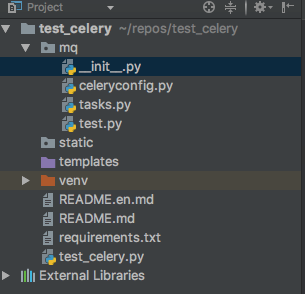

整个项目工程如下

__init__.py

"""

注意点:python3.7 需要执行 pip install --upgrade https://github.com/celery/celery/tarball/master

否则会报 from . import async, base SyntaxError: invalid syntax celery -A __init__ worker --concurrency=5 -l INFO -Q celery,save_redis

celery -A __init__ worker -l info -Q save_mongo

cd /Users/admin/PycharmProjects/function_test/adminSyS/mq&&celery -A __init__ worker --concurrency=5 celery 启动 --autoscale=10,3 当worker不足时自动加3-10个

celery -A __init__ worker --concurrency=5 -l INFO -Q celery,save_redis2,save_redis --autoscale=10,3 supervisor 配置

[program:celery]

directory = /data/app/adminSyS/mq

command = /data/app/adminSyS/venv/bin/celery -A __init__ worker --concurrency=5 -l INFO -Q celery,save_redis

autostart = true

autorestart = true

startsecs = 5

startretries = 3 监控:

文档 https://flower-docs-cn.readthedocs.io/zh/latest/install.html

pip install flower

celery flower --broker=redis://:z1234567@47.93.235.228:6379/5 --port=5555

测试 http://47.93.235.228:9114

"""

import os

import sys

sys.path.append(os.path.abspath(os.path.dirname(__file__)) + "/..")

from celery import Celery app = Celery(include=["mq.tasks"])

app.config_from_object("celeryconfig") # 指定配置文件

celeryconfig.py

import os

import sys sys.path.append(os.path.abspath(os.path.dirname(__file__)) + "/..")

from kombu import Queue, Exchange BROKER_URL = "redis://:redis@127.0.0.1:6379/5" # 消息代理

CELERY_RESULT_BACKEND = "redis://:redis@127.0.0.1:6379/6" # 任务执行结果存放地址

CELERY_TASK_SERIALIZER = "json" # 任务序列化和翻序列化的方案

CELERY_RESULT_SERIALIZER = "json" # 读取任务结果序列化方式

CELERY_TASK_RESULT_EXPIRES = 60 * 60 * 24 # 任务过期时间

CELERY_ACCEPT_CONTENT = ["json", "msgpack"] # 接受的任务类型

BROKER_TRANSPORT_OPTIONS = {'visibility_timeout': 86400} # 任务重发时间

CELERYD_MAX_TASKS_PER_CHILD = 400 # 每个worker执行了多少任务就会自动重启防止内存泄漏 # 指定任务队列 save_redis save_redis2

CELERY_QUEUES = (

Queue("default", Exchange("default"), routing_key="default"),

Queue("save_redis", Exchange("save_redis"), routing_key="save_redis"),

Queue("save_redis2", Exchange("save_redis2"), routing_key="save_redis2")

) # mq.tasks.taskA mq.tasks.taskB 具体函数名

CELERY_ROUTES = {

'mq.tasks.taskA': {"queue": "save_redis", "routing_key": "save_redis"},

'mq.tasks.taskB': {"queue": "save_redis2", "routing_key": "save_redis2"}

}

tasks.py

from mq import app

import redis

import time rds = redis.Redis(

host="localhost",

port=6379,

db=7,

password="redis") # 客户端 @app.task

def taskA(x, y):

time.sleep(10)

rds.setex(name="taskA", value=x + y, time=3600)

return x + y @app.task

def taskB(x, y, c):

time.sleep(10)

rds.setex(name="taskB{}".format(c), value=x + y, time=3600)

return x + y

test.py

import sys

import os sys.path.append(os.path.abspath(os.path.dirname(__file__)) + "/..")

from mq.tasks import taskA, taskB #re1 = taskA.delay(100, 200)

# print(re1)

# print(re1.status) # 服务端 for i in range(10):

re2 = taskB.delay(100, i, i)

print(re2)

print(re2.status)

celery客户端启动 save_redis2,save_redis 代表函数名 --autoscale=10,3 当work不够用时自动起3-10个进程

celery -A __init__ worker --concurrency=5 -l INFO -Q celery,save_redis2,save_redis --autoscale=10,3

#启动方式

../venv/bin/celery -A __init__ worker --concurrency=5 -l INFO -Q celery,save_redis2,save_redis --autoscale=10,3

# 启动方式打印log

command=/home/op/saiyan_game_center/venv/bin/celery -A __init__ worker --concurrency=8 -l INFO -Q upload_box_task --autoscale=5,3 --logfile=/home/op/saiyan_game_center/logs/log.log

celery web监控

文档:https://flower-docs-cn.readthedocs.io/zh/latest/install.html

安装:pip install flower

启动:celery flower --broker=代理url --port=5555

celery flower --broker=redis://:redis@127.0.0.1:6379/5 --port=5555

Celery 服务搭建的更多相关文章

- ServiceStack.Hello——跨平台.net REST api服务搭建

ServiceStack.Hello--跨平台.net REST api服务搭建 自己创建: https://github.com/ServiceStack/ServiceStack/wiki/Cre ...

- WCFRESTFul服务搭建及实现增删改查

WCFRESTFul服务搭建及实现增删改查 RESTful Wcf是一种基于Http协议的服务架构风格, RESTful 的服务通常是架构层面上的考虑. 因为它天生就具有很好的跨平台跨语言的集成能力 ...

- 微信小程序语音识别服务搭建全过程解析(项目开源在github)

silk v3录音转olami语音识别和语义处理的api服务(ubuntu16.04服务器上实现) ## 重要的写在前面 重要事项一: 目前本文中提到的API已支持微信小程序录音文件格式:silk v ...

- 微信小程序语音识别服务搭建全过程解析(https api开放,支持新接口mp3录音、老接口silk录音)

silk v3(或新录音接口mp3)录音转olami语音识别和语义处理的api服务(ubuntu16.04服务器上实现) 重要的写在前面 重要事项一: 所有相关更新,我优先更新到我个人博客中,其它地方 ...

- Git服务搭建及github使用教程

.pos { position: fixed; top: 35%; left: 90% } .pos a { border: 2px solid white; background: #99CCFF; ...

- eureka服务搭建

Server端 引入eureka server的maven依赖 引入依赖时无需给定eureka的版本号,maven会根据当前使用的SpringCloud版本来判断应该引入哪个版本的euraka ser ...

- NodeJs之服务搭建与数据库连接

NodeJs之服务搭建与数据库连接 一,介绍与需求分析 1.1,介绍 Node.js 是一个基于 Chrome V8 引擎的 JavaScript 运行环境. Node.js 使用了一个事件驱动.非阻 ...

- JumpServer1.0 服务搭建

JumpServer1.0 服务搭建 系统环境配置 setenforce 0 systemctl stop iptables.service systemctl stop firewalld.serv ...

- Linux-ftp服务搭建

云服务器ESC 部署vsftpd服务 记一次ftp服务搭建的采坑过程,这个坑一直卡了很久时间,都给忘记了.最近由于公司项目需要部署FTP,经过各种采坑,终于把这个坑给填上了.废话不多说,开干 环境说明 ...

随机推荐

- nmap的使用方法

0x01 Nmap 典型用途: 1.通过对设备或者防火墙的探测来审计它的安全性. 2.探测目标主机所开放的端口. 3.网络存储,网络映射,维护和资产管理.(这个有待深入) 4.通过识别新的服务器审计网 ...

- MySQL 8.0 的xtrabackup备份

xtrabackup 备份语句: fname=`date +%F_%H-%M-%S` mkdir -p /mnt/dbbak/db_$fname xtrabackup --defaults-file= ...

- 一个兼容IE7\IE8,H5的多功能视频播放器,H5视频播放器兼容Flash视频播放器

这里记录一个视频播放器,免费可适当修改:名称:ckplayer视频播放器(免费) 官网地址:http://www.ckplayer.com/ 下载地址:http://www.ckplayer.com/ ...

- Java精通并发-Lock锁方法原理详解

继续上一次https://www.cnblogs.com/webor2006/p/11756563.html的Lock文档说明进行阅读: 以上就是对于Lock类中官方解读,下面再纵览一下它里面的方法: ...

- SpringDataJPA开发环境的搭建

这里简单的介绍一下使用maven工程创建SpringDataJPA的开发环境的搭建 首先引入依赖 <dependencies> <!-- junit单元测试 --> <d ...

- <?php return array(

<?php //test.php return array( 'name' => 'andy', 'sex' => 'male' ); ?> <?php $set = r ...

- where与having 的区别

二者的区别在于作用对象不同. where子句作用于基本表或视图,从中选择满足条件的一行或多行元祖. having短语作用于组,从中选择满足条件的组.这些组应该由group by 短句来进行分组.

- 前端零基础入门:页面结构层HTML(2)

学习笔记 若本号内容有做得不到位的地方(比如:涉及版权或其他问题),请及时联系我们进行整改即可,会在第一时间进行处理. 请点赞!因为你们的赞同/鼓励是我写作的最大动力! 欢迎关注达达的简书! 这是一个 ...

- 【CF1225E Rock Is Push】推岩石

题目描述 你现在在一个\(n×m\)的迷宫的左上角(即点\((1,1)\)),你的目标是到达迷宫的右下角(即点\((n,m)\)).一次移动你只能向右或者是向下移动一个单位.比如在点\((x,y)\) ...

- 矩阵的五种分解的matlab实现

由于这学期修了矩阵分析这门课,课程要求用matlab实现矩阵的5种分解,仅仅是实现了分解,上传到博客存档,万一哪天某位同学就需要了呢.. 1.矩阵的满秩分解 代码实现 %矩阵的满秩分解 clear % ...