Python-将json文件写入ES数据库

1、安装Elasticsearch数据库

PS:在此之前需首先安装Java SE环境

下载elasticsearch-6.5.2版本,进入/elasticsearch-6.5.2/bin目录,双击执行elasticsearch.bat 打开浏览器输入http://localhost:9200 显示以下内容则说明安装成功

安装head插件,便于查看管理(还可以用kibana)

首先安装Nodejs(下载地址https://nodejs.org/en/)

再下载 elasticsearch-head-master包解压到/elasticsearch-6.5.2/下(链接:https://pan.baidu.com/s/1oX9wKuAYrvY2ZRBT0cos6A

提取码:5ik4)

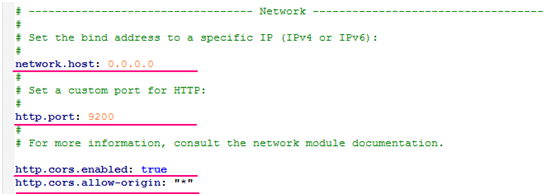

修改配置文件elasticsearch-6.5.2\config\elasticsearch.yml如下:

进入elasticsearch-head-master目录下执行 npm install -g grunt-cli,再执行npm install 安装依赖

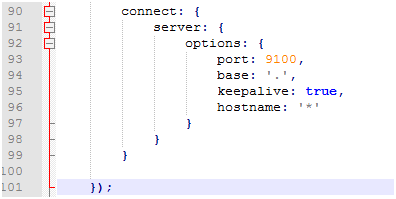

在elasticsearch-head-master目录下找到Gruntfile.js文件修改服务器监听地址如下:

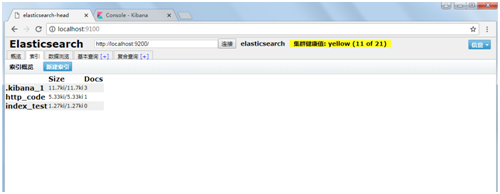

执行grunt server命令启动head服务

访问地址http://localhost:9100/即可访问head管理页面

2、将json文件写入ES数据库(py脚本如下)

# -*- coding: UTF-8 -*- from itertools import islice

import json , sys

from elasticsearch import Elasticsearch , helpers

import threading _index = 'indextest' #修改为索引名

_type = 'string' #修改为类型名

es_url = 'http://192.168.116.1:9200/' #修改为elasticsearch服务器 reload(sys)

sys.setdefaultencoding('utf-8')

es = Elasticsearch(es_url)

es.indices.create(index=_index, ignore=400)

chunk_len = 10

num = 0 def bulk_es(chunk_data):

bulks=[]

try:

for i in xrange(chunk_len):

bulks.append({

"_index": _index,

"_type": _type,

"_source": chunk_data[i]

})

helpers.bulk(es, bulks)

except:

pass with open(sys.argv[1]) as f:

while True:

lines = list(islice(f, chunk_len))

num =num +chunk_len

sys.stdout.write('\r' + 'num:'+'%d' % num)

sys.stdout.flush()

bulk_es(lines)

if not lines:

print "\n"

print "task has finished"

break

Python-将json文件写入ES数据库的更多相关文章

- JSON文件存入MySQL数据库

目标:将不同格式的JSON文件存入MySQL数据库 涉及的点有: 1. java处理JSON对象,直接见源码. 2. java.sql.SQLException: Incorrect string v ...

- Python读取Json字典写入Excel表格的方法

需求: 因需要将一json文件中大量的信息填入一固定格式的Excel表格,单纯的复制粘贴肯定也能完成,但是想偷懒一下,于是借助Python解决问题. 环境: Windows7 +Python2.7 + ...

- python解析jSON文件

一.jSON文件 http://baike.baidu.com/link?url=wYeeLnhpXX-Tt8AoBRSNPh2P7Z2YHyK2tdD1tbBOQMfJIpA-YNHMOg2ZN6a ...

- Python学习笔记——文件写入和读取

1.文件写入 #coding:utf-8 #!/usr/bin/env python 'makeTextPyhton.py -- create text file' import os ls = os ...

- 使用json文件给es中导入数据

使用json文件可以给es中导入数据,10万条左右的数据可以一次导入,数量太大时导入就会报错.大数量的到导入还是需要用bulk方式. accounts.json文件格式如下: {"index ...

- python中json文件处理涉及的四个函数json.dumps()和json.loads()、json.dump()和json.load()的区分

一.概念理解 1.json.dumps()和json.loads()是json格式处理函数(可以这么理解,json是字符串) (1)json.dumps()函数是将一个Python数据类型列表进行js ...

- python 读 json 文件

一个汽车图标的训练集:train.json [{"items": [{"label_id": "0028", "bbox" ...

- python 读写json文件(dump, load),以及对json格式的数据处理(dumps, loads)

JSON (JavaScript Object Notation) 是一种轻量级的数据交换格式.它基于ECMAScript的一个子集. 1.json.dumps()和json.loads()是json ...

- python笔记20-yaml文件写入(ruamel.yaml)

前言 yaml作为配置文件是非常友好的一种格式,前面一篇讲了yaml的一些基础语法和读取方法,本篇继续讲yaml文件写入方法 用yaml模块写入字典嵌套字典这种复杂的数据,会出现大括号{ },不是真正 ...

随机推荐

- linux定时任务cron配置

实现linux定时任务有:cron.anacron.at,使用最多的是cron任务 名词解释 cron--服务名:crond--linux下用来周期性的执行某种任务或等待处理某些事件的一个守护进程,与 ...

- CAS 4.0.x 自定义登录页面

版权声明:本文为博主原创文章,未经博主允许不得转载. 目录(?)[-] CAS默认登录页面 复制一个新的页面管理页面 修改页面引用 修改casproperties 修改casLoginViewjs ...

- S3C6410板子移植 Android2.2

一:Android简介 1.什么是Android: Android是一种基于linux的自由及开放源代码的操作系统,主要适用于移动设备,如智能手机和平板电脑,是由google公司和开放手机联盟领导和开 ...

- Python基础之数据类型、变量、常量

数据类型 整数:任意大小的整数,十六进制用0x前缀 浮点数:浮点数也就是小数,科学计数法1.23x109就是1.23e9,0.000012可以写成1.2e-5 字符串:以单引号'或双引号"括 ...

- SSM-Spring-13:Spring中RegexpMethodPointcutAdvisor正则方法切入点顾问

------------吾亦无他,唯手熟尔,谦卑若愚,好学若饥------------- RegexpMethodPointcutAdvisor:正则方法切入点顾问 核心: <property ...

- python 3 中的raw_input 报错

raw_input() was renamed to input()

- Vector简单介绍

/*枚举就是Vector特有的取出方式发现枚举和迭代器很像其实枚举和迭代是一样的因为枚举的名称以及方法的名称都过长了.所以被迭代器取代了枚举郁郁而终了. */ import java.util.*;c ...

- CentOS7上解决tomcat不能被外部浏览访问的问题?

在linux上开启的tomcat使用浏览器访问不了.主要原因在于防火墙的存在,导致的端口无法访问. CentOS7使用firewall而不是iptables.所以解决这类问题可以通过添加firewal ...

- BZOJ_1798_[AHOI2009]维护序列_线段树

BZOJ_1798_[AHOI2009]维护序列_线段树 题意:老师交给小可可一个维护数列的任务,现在小可可希望你来帮他完成. 有长为N的数列,不妨设为a1,a2,…,aN .有如下三种操作形式: ( ...

- 拿Proxy可以做哪些有意思的事儿

Proxy是什么 首先,我们要清楚,Proxy是什么意思,这个单词翻译过来,就是 代理.可以理解为,有一个很火的明星,开通了一个微博账号,这个账号非常活跃,回复粉丝.到处点赞之类的,但可能并不是真的由 ...