Redis进阶实践之十二 Redis的Cluster集群动态扩容

一、引言

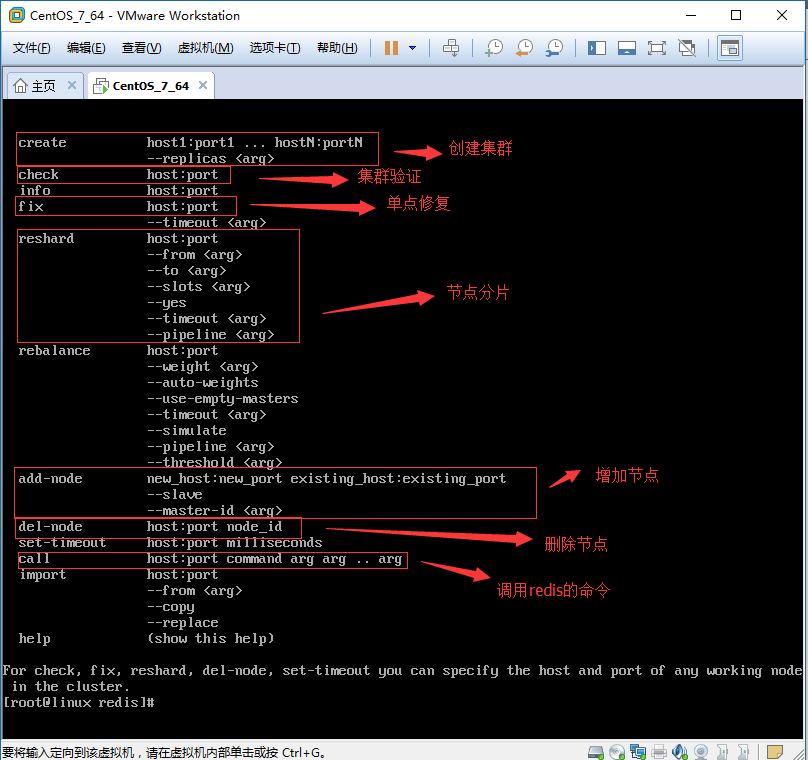

上一篇文章我们一步一步的教大家搭建了Redis的Cluster集群环境,形成了3个主节点和3个从节点的Cluster的环境。当然,大家可以使用 Cluster info 命令查看Cluster集群的状态,也可以使用Cluster Nodes 命令来详细了解Cluster集群每个节点的详细信息和关系。我们可以在主节点上增加数据、操作数据,也可以在从节点上读取数据,这些操作当然都没有问题。我们今天这篇文章主要是讲解一下如何在不停掉Cluster集群环境的情况下,动态的往集群环境中增加主、从节点和动态的从集群环境中删除节点。好了,废话不多说,开始我们今天的讲解。在开始之前,先要说明一下,因为redis的动态扩容操作都是通过redis-trib.rb脚本文件来完成的,所以我们先来看看对这个脚本文件的说明,效果如图:

[root@linux redis] # ruby redis-trib.rb

二、Cluster集群增加操作

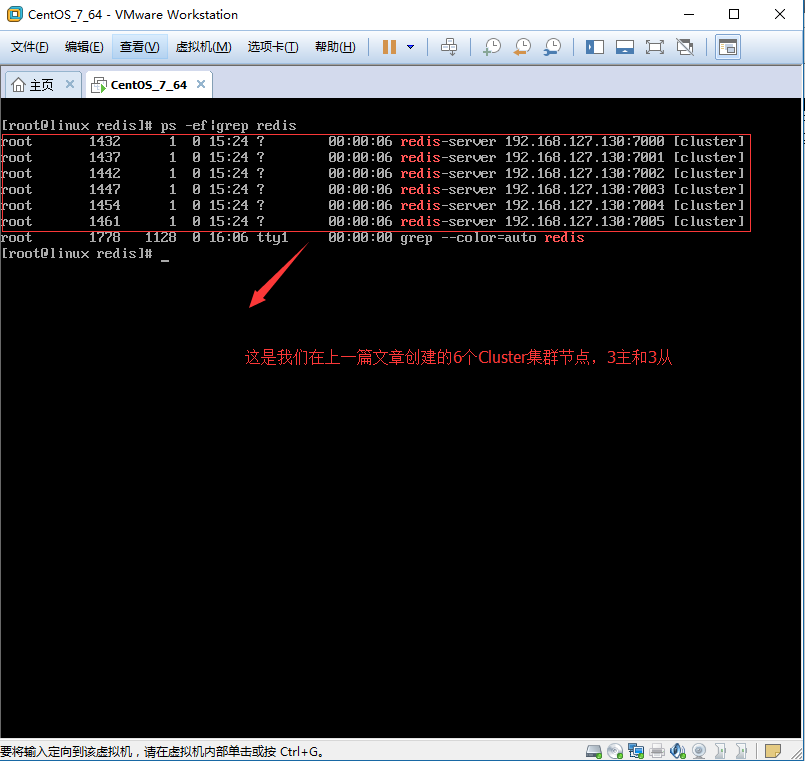

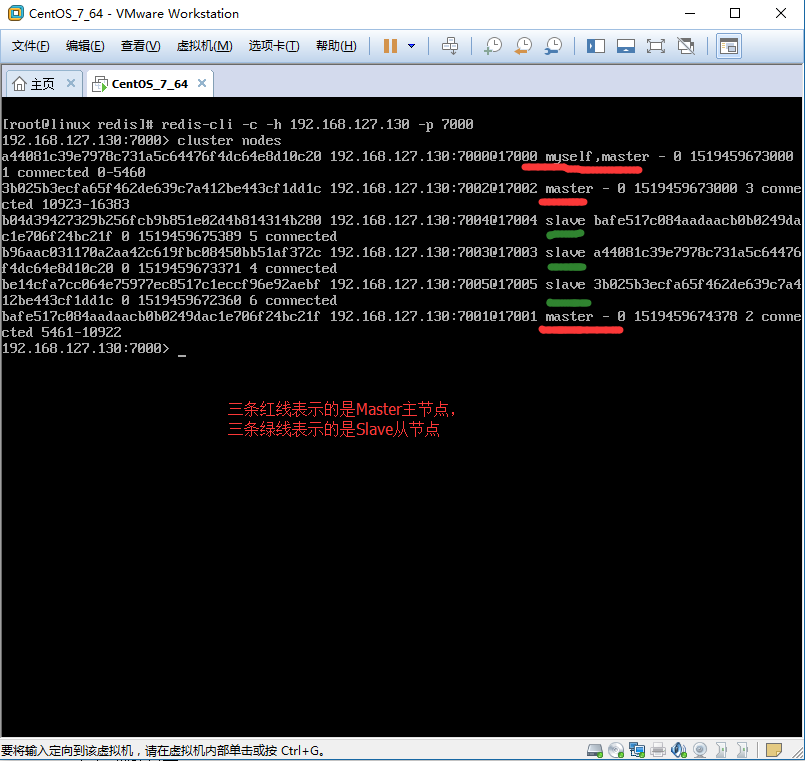

现在正好开始我们的操作,我把增加节点和删除节点分开来写,并且增加或者删除节点,我都分了两个方面来说,一个方面是主节点的操作,另一个方面是从节点的操作,因为主、从节点在操作上会有差异,所以分来来说。增加节点的顺序是先增加Master主节点,然后在增加Slave从节点。当然这篇文章是在上一篇文章所讲的Cluster集群模式的基础之上来讲的,那就让我们先来看看上一篇文章所建立的Cluster集群模式的详细信息。效果如图:

1、动态增加Master主服务器节点

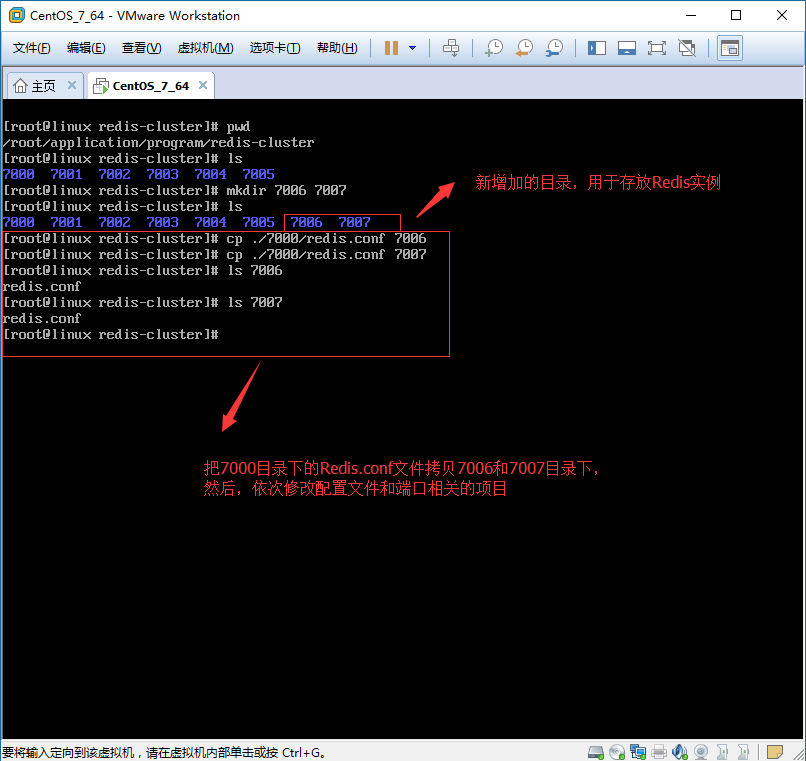

1.1、创建目录7006(Master主节点文件夹)和7007(Slave从节点文件夹),并从以前Cluster集群节点7000-7005任一节点中拷贝配置文件redis.conf到7006和7007目录下。

[root@linux redis-cluster]# pwd

[root@linux redis-cluster]# /root/application/program/redis-cluster/ [root@linux redis-cluster]# mkdir [root@linux redis-cluster]# ls

[root@linux redis-cluster]# cp /redis.conf

[root@linux redis-cluster]# cp /redis.conf

1、创建目录:

2、拷贝配置文件:

1.2、修改配置文件,将7006和7007目录下面的redis.conf配置文件的端口进行相应修改,与自己的目录名称保持一致,修改项目如下:(在linux环境下可以执行如下命令进行全局替换::%s/7000/7006/g,%s/7000/7007/g,保存并退出则可)

1.2.1、7006节点的配置文件:redis.conf

bind 192.168.127.130

port

daemonize yes

pidfile /var/run/redis-.pid

logfile /root/application/program/redis-cluster//redis.log

dir /root/application/program/redis-cluster//

cluster-enabled yes

cluster-config-file nodes-.conf

cluster-node-timeout

appendonly yes

appendfsync always

1.2.2、7007节点的配置文件:redis.conf

bind 192.168.127.130

port

daemonize yes

pidfile /var/run/redis-.pid

logfile /root/application/program/redis-cluster//redis.log

dir /root/application/program/redis-cluster//

cluster-enabled yes

cluster-config-file nodes-.conf

cluster-node-timeout

appendonly yes

appendfsync always

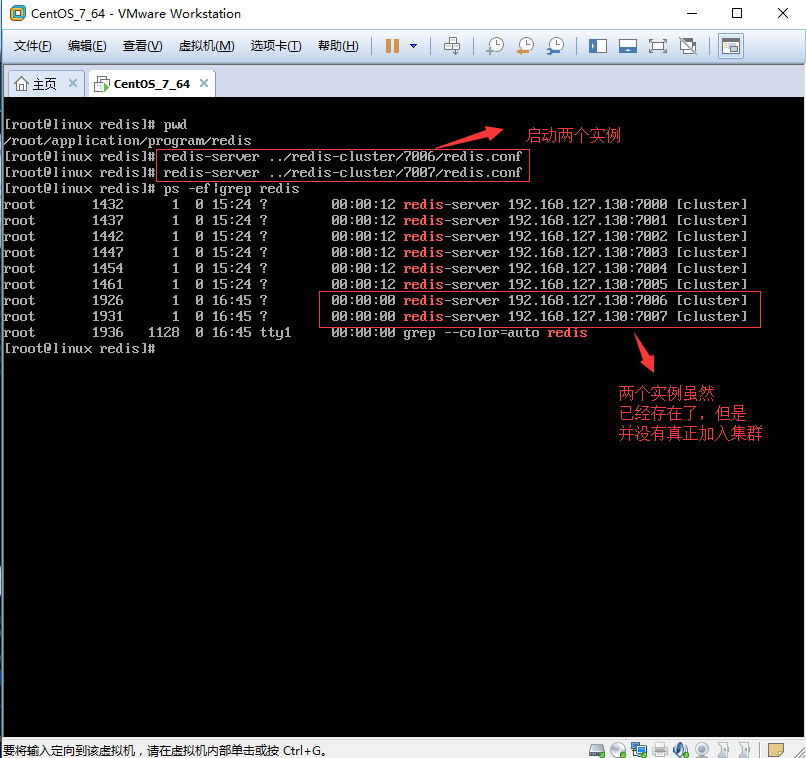

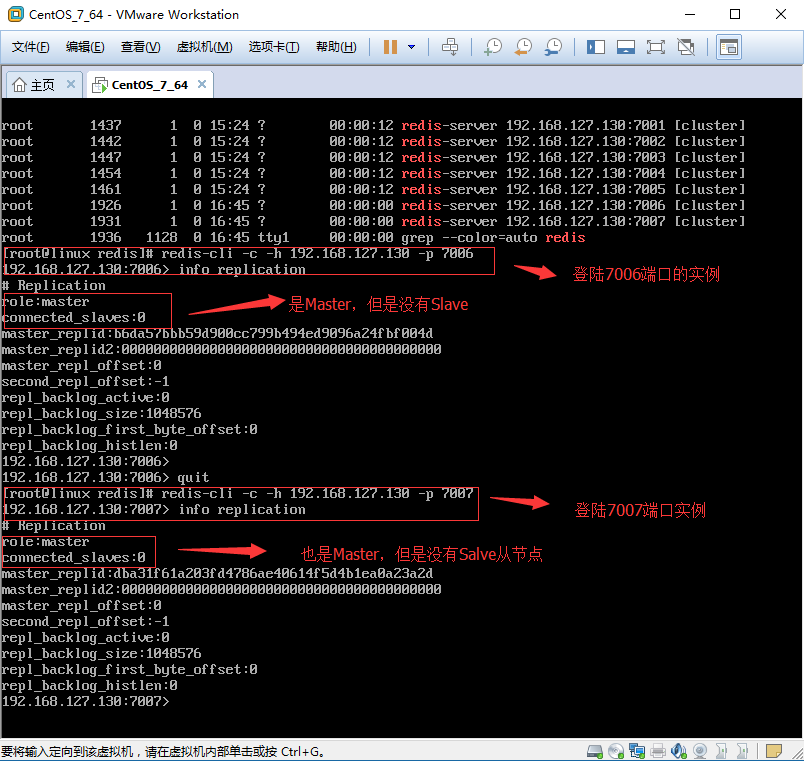

1.3、启动7006和7007目录下Redis实例,并查看效果。

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# redis-server ../redis-cluster//redis.conf

[root@linux redis]# redis-server ../redis-cluster//redis.conf

效果如图:

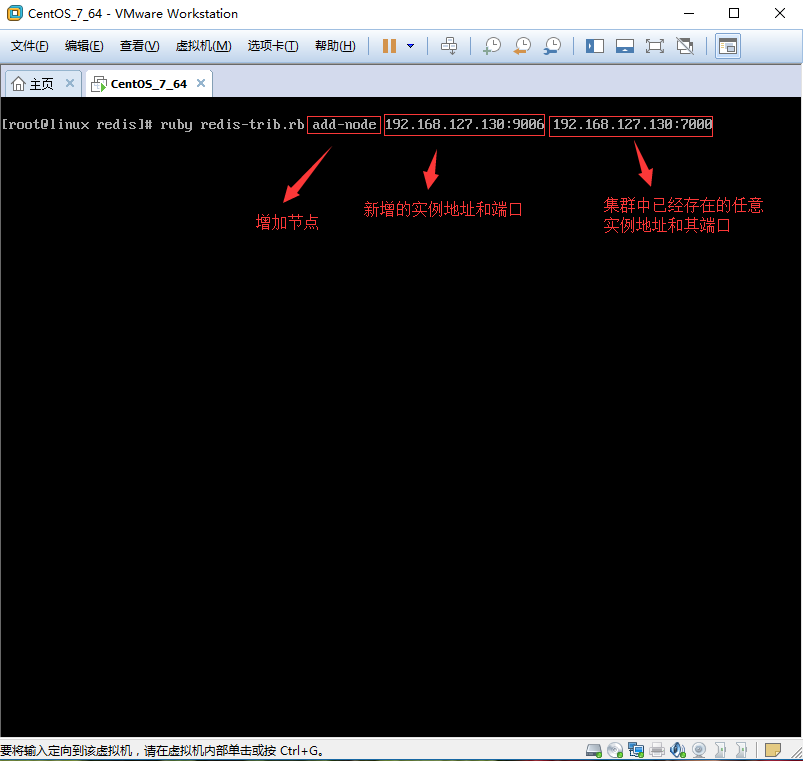

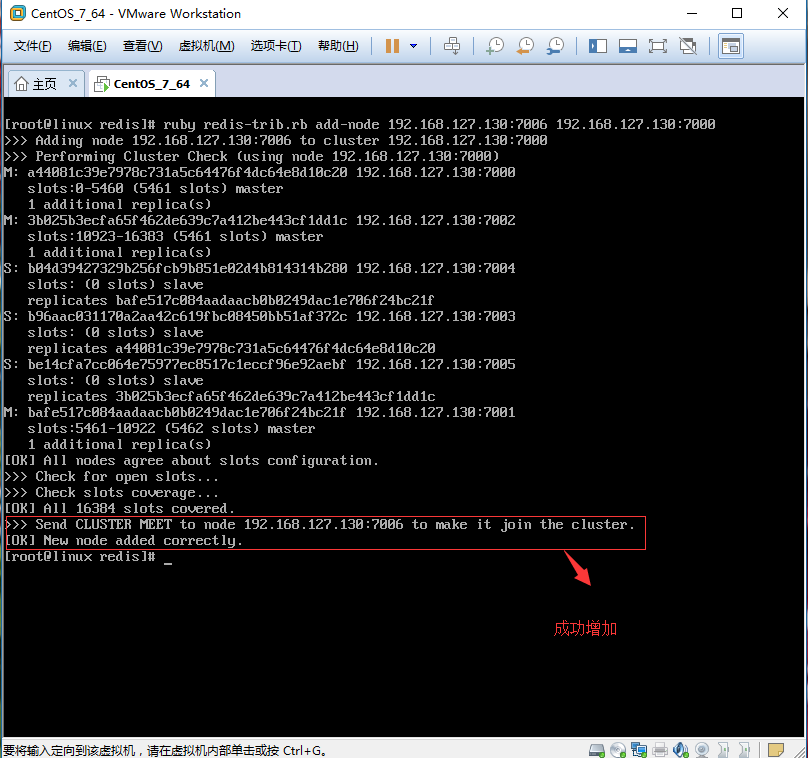

1.4、将7006主节点加入到Cluster集群。

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# ruby redis-trib.rb add-node 192.168.127.130: 192.168.127.130:

注意:当添加新节点成功以后,新的节点不会有任何数据,因为他没有分配任何的数据Slot(哈希slots),这一步需要手动操作。

1.4.1、增加7006:(192.168.127.130:7006,截图地址错误,端口号是7006,不是9006)

1.4.2、节点增加成功。

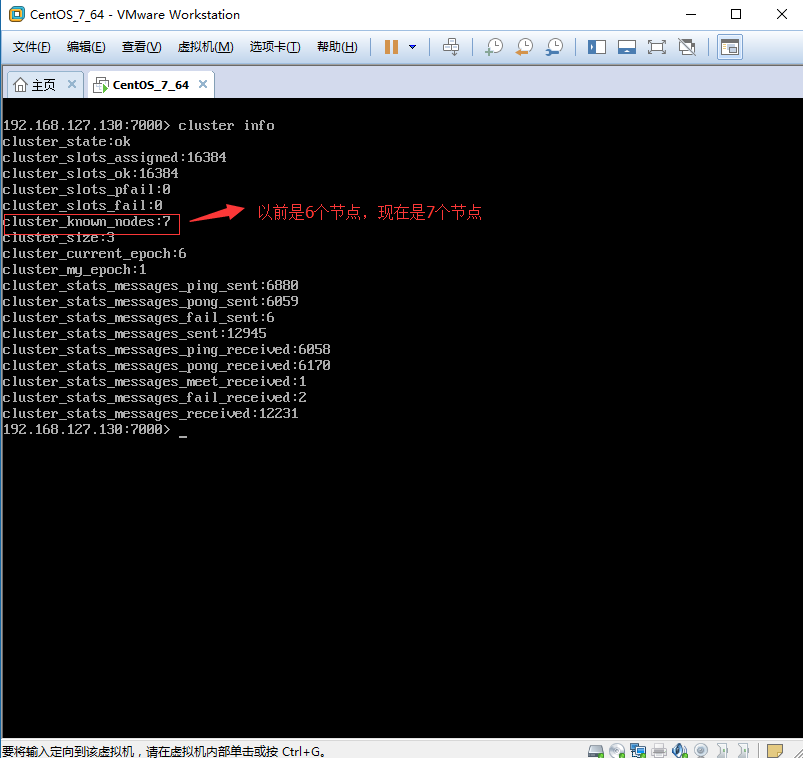

1.4.3、cluster info 验证:

1.4.4、cluster nodes验证:

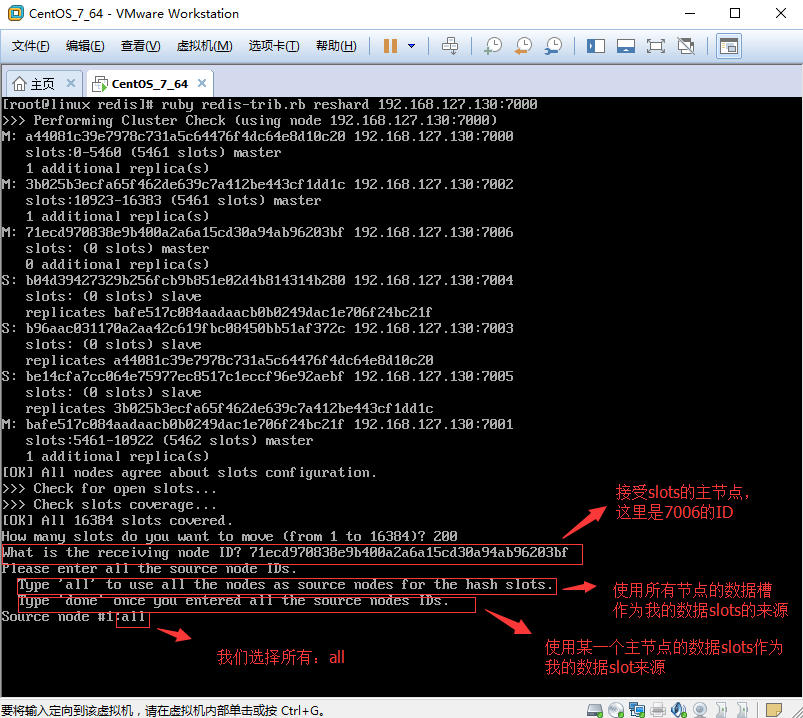

1.5、为7006Master主节点分配数据Slots,分配方法是从集群中知道任何一个主节点(因为只有Master主节点才有数据slots),然后对其进行重新分片工作。

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# ruby redis-trib.rb reshard 192.168.127.130:

1.5.1、分配数据槽:

1.5.2、选择接收数据槽的节点和数据槽产生的方式:

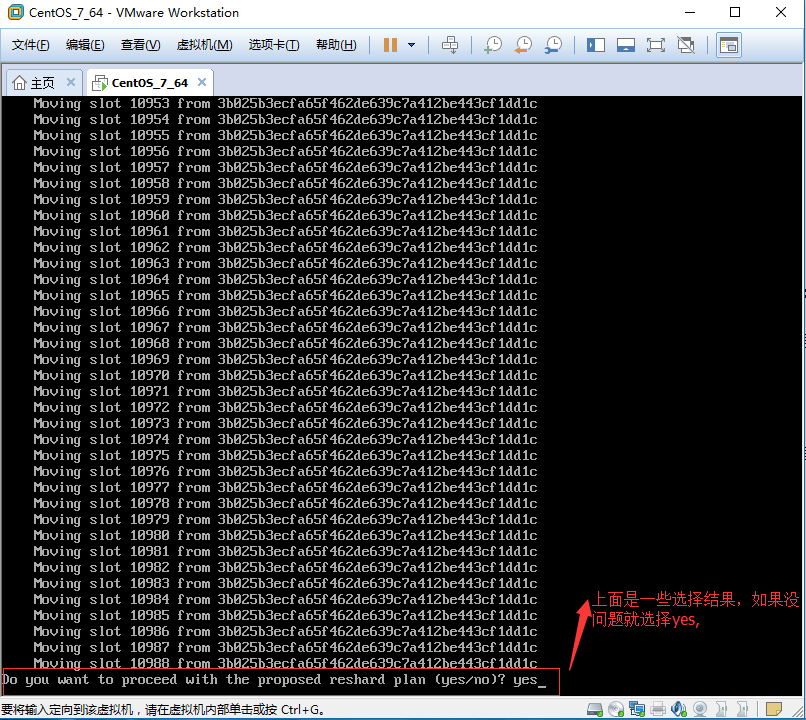

1.5.3、执行分配计划:

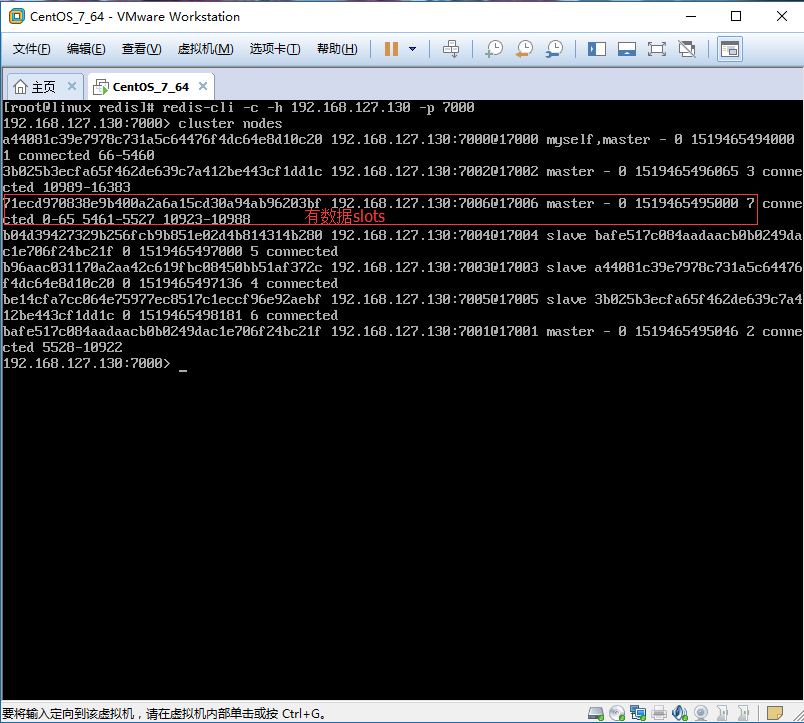

1.5.4、数据槽分配成功:

2、动态增加Slave从服务器节点

在增加主节点7006的时候,前面的3步是共有的,也就是从1.1-1.3,之后才是建立主节点的内容,前面的3步骤针对从节点7007也是必须的,我只是把这些步骤写到了创建主节点7006的步骤里,大家请知晓。

2.1、将7007节点增加到集群中

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# ruby redis-trib.rb add-node 192.168.127.130: 192.168.127.130:

效果如图:

2.2、指定7007节点作为7006的从节点,实现主从的配置。

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# redis-cli -c -h 192.168.127.130 -p //登陆7007

192.168.127.130::>cluster replicate 71ecd970838e9b400a2a6a15cd30a94ab96203bf(主节点的ID,这里是7006)

192.168.127.130::>OK

效果如图:

三、Cluster集群删除操作

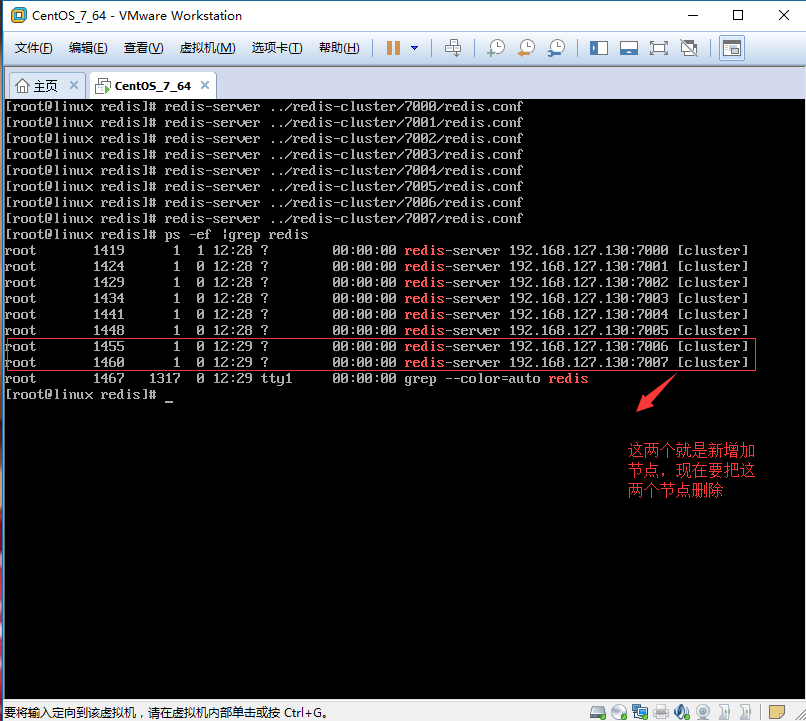

由于我们在上面的步骤里面创建7006和7007两个主从的节点,下面接下来的操作,我就是从这个Cluster集群模式中动态的删除掉这两个节点。删除的顺序是先删除Slave从节点,然后在删除Master主节点,最后还原到我们上一篇文章建立的Cluster集群模式,也就是3个主节点和3个从节点。现在是4个主节点和4个从节点。效果如图:

1、动态删除Slave从服务器节点

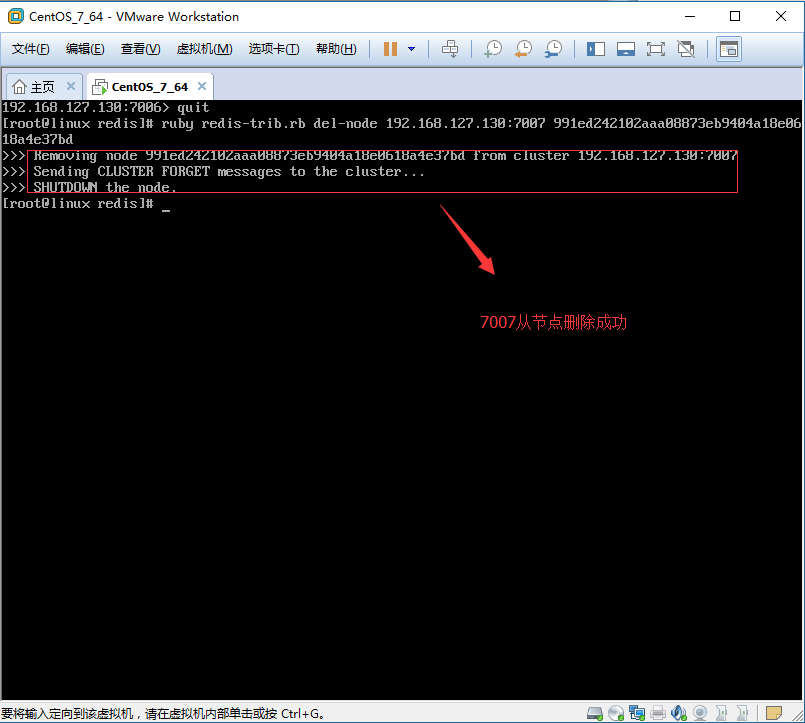

1.1、删除7007从节点,输入del-node命令,指定删除节点的IP地址和Port端口号,同时还要提供该从节点ID名称。

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# ruby redis-trib.rb del-node 192.168.127.130: 991ed242102aaa08873eb9404a18e0618a4e37bd

删除成功如图:

删除前如图:

删除后如图:

2、动态删除Master主服务器节点

要想删除Master主节点,可能要繁琐一些。因为在Master主节点上有数据槽(slots),为了保证数据的不丢失,必须把这些数据槽迁移到其他Master主节点上,然后在删除主节点。

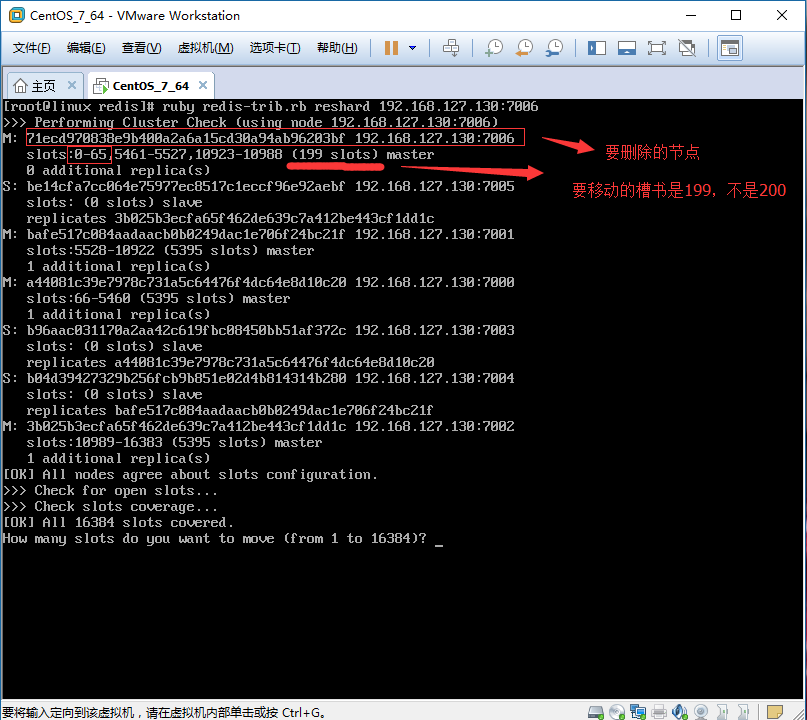

2.1、重新分片,把要删除的Master主节点的数据槽移动到其他Master主节点上,以免数据丢失。

[root@linux redis]# pwd

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# ruby redis-trib.rb reshard 192.168.127.130:

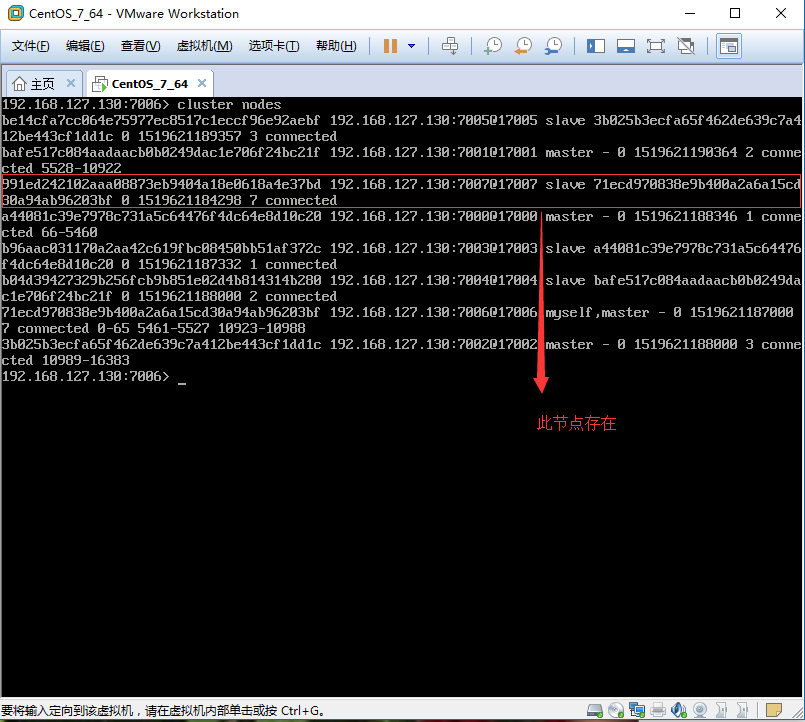

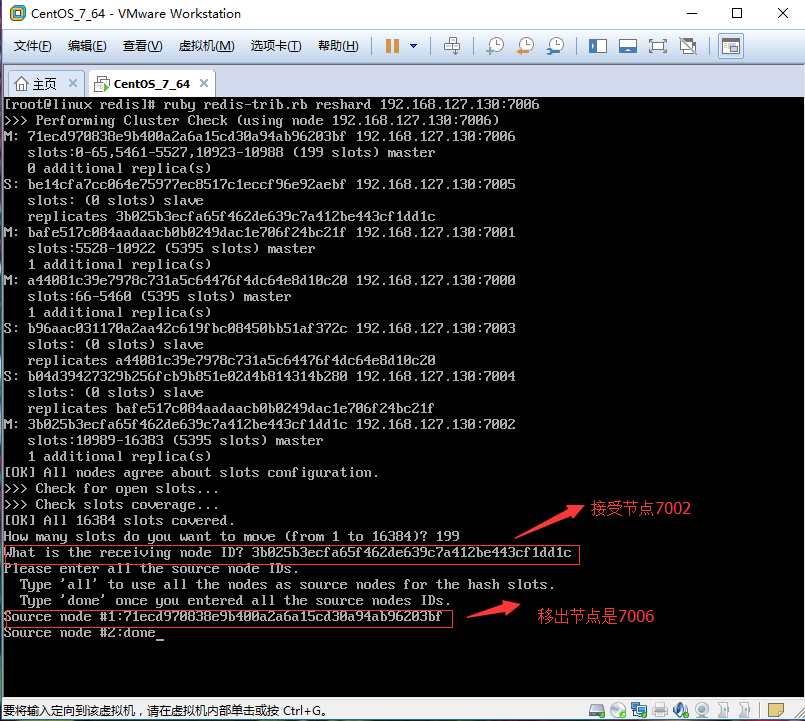

2.1.1、移除多少槽如图:创建输入200,这里要输入199,因为计数是从0开始的,切记。

2.1.2、接受槽的Master主节点ID:这个节点可以是任意一个主节点都可以,我选择7002,ID是:3b025b3ecfa65f462de639c7a412be443cf1dd1c

2.1.3、从哪个主节点移除,该主节点是7006,ID是:71ecd970838e9b400a2a6a15cd30a94ab96203bf

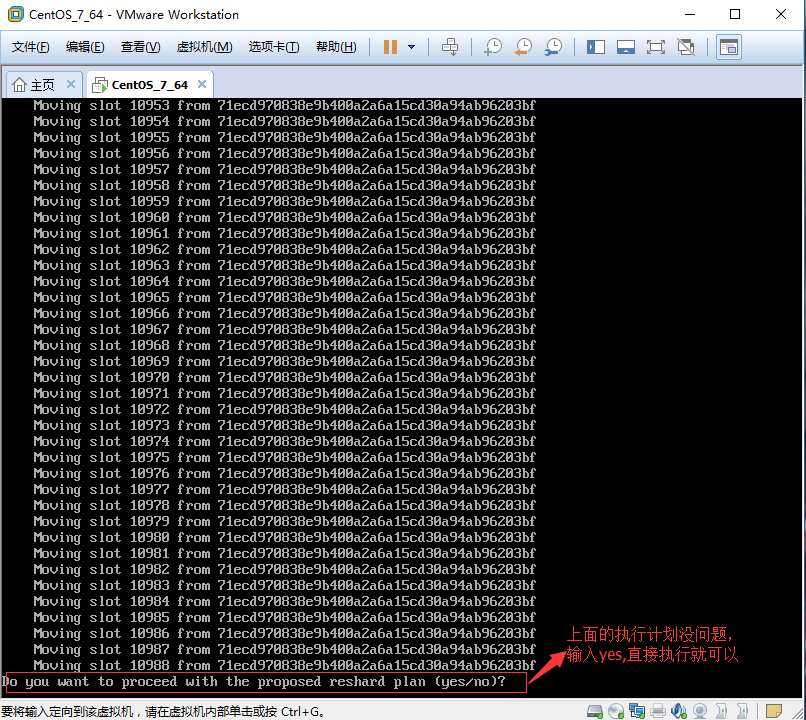

2.1.4、执行分区计划,选择yes。分区完成,效果如图:

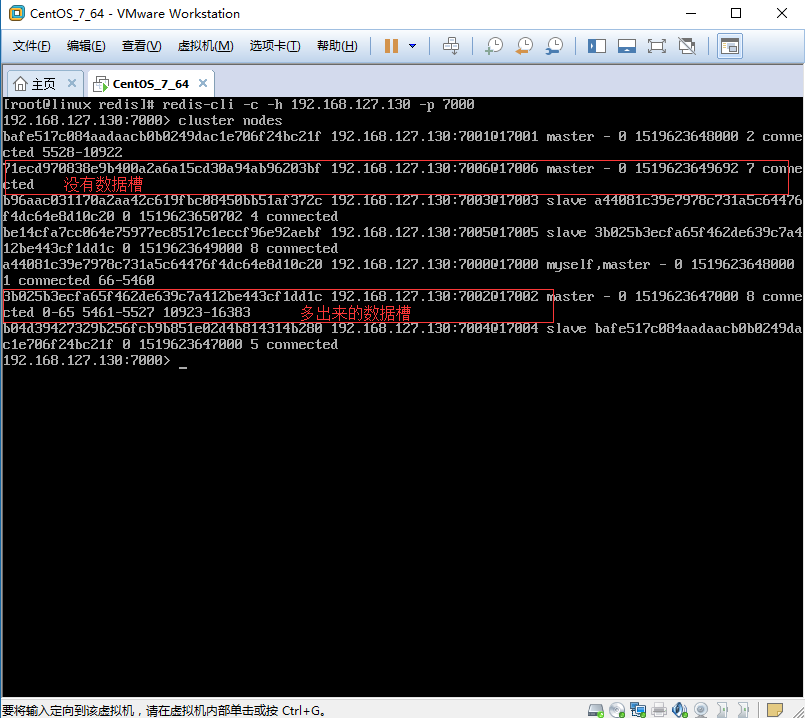

2.1.5、当前7006主节点已经没有数据槽了。

2.2、删除7006主节点,提供要删除节点的IP地址和Port端口,当然还有要删除的节点的ID名称。

[root@linux redis]# pwd

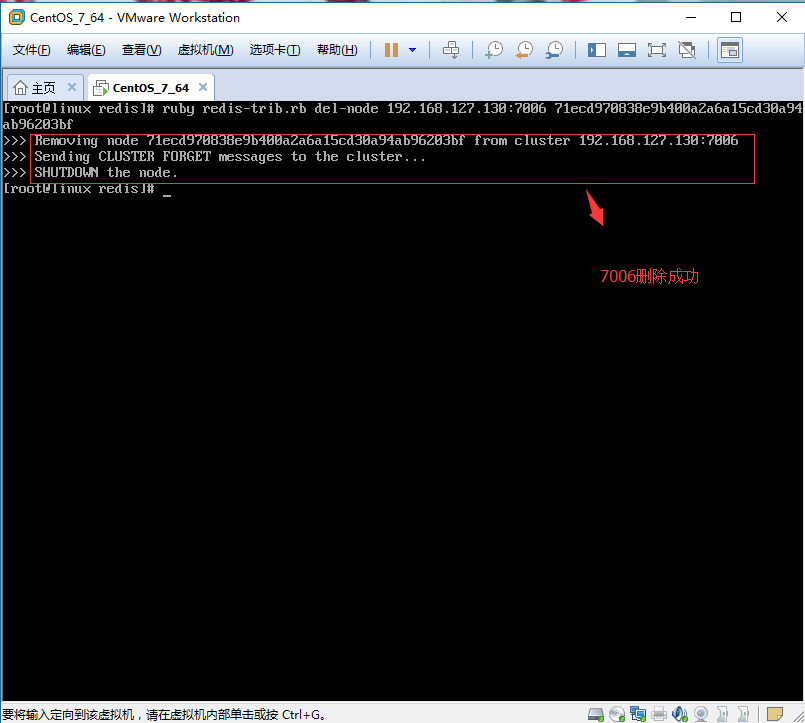

[root@linux redis]# /root/application/program/redis/ [root@linux redis]# ruby redis-trib.rb del-node 192.168.127.130: 71ecd970838e9b400a2a6a15cd30a94ab96203bf

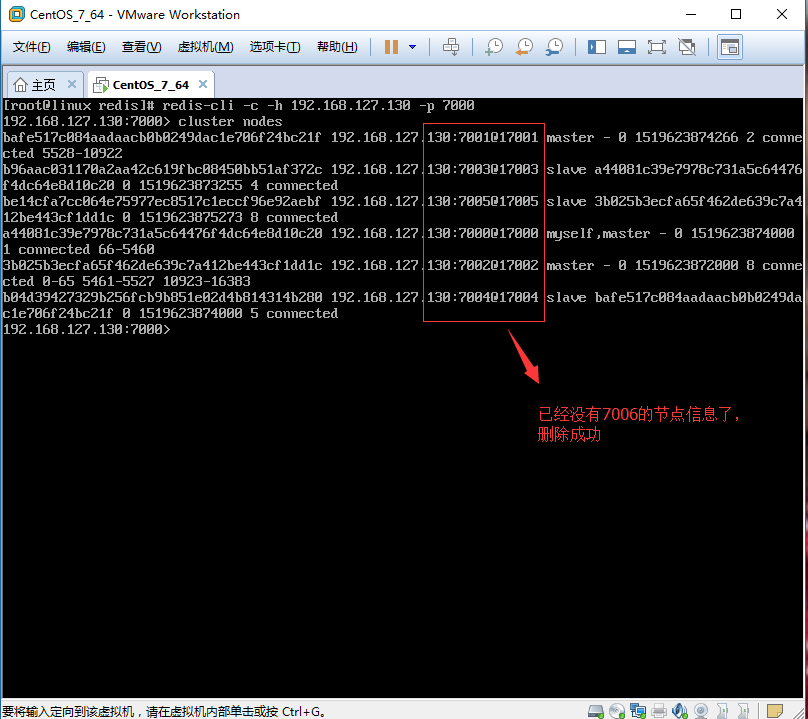

2.2.1、删除成功

2.2.2、查看节点效果

四、总结

今天就写到这里了,做一个小小的总结。主从复制和哨兵模式这两个集群模式由于不能动态扩容,而且主节点之间(有多个主节点的情况)数据完全一样,导致了主节点的容量成了整个集群的瓶颈,如果想扩展集群容量,必须扩展主节点的容量。由于以上的问题,redis在3.0开始Cluster集群模式,这个模式在主节点之间数据是不一样的,数据也可以根据需求自动转向其他节点。这样就可以实现横向动态扩容,新增加的主从节点,用于存储新的数据则可,对以前的节点的数据不会有任何影响。再者说,配置也很简单,这才是我们所需要的集群模式。

Redis进阶实践之十二 Redis的Cluster集群动态扩容的更多相关文章

- Redis进阶实践之十六 Redis大批量增加数据

一.介绍 有时,Redis实例需要在很短的时间内加载大量先前存在或用户生成的数据,以便尽可能快地创建数百万个键.这就是所谓的批量插入,本文档的目标是提供有关如何以尽可能快的速度向Redis提 ...

- Redis进阶实践之十九 Redis如何使用lua脚本

一.引言 redis学了一段时间了,基本的东西都没问题了.从今天开始讲写一些redis和lua脚本的相关的东西,lua这个脚本是一个好东西,可以运行在任何平台上,也可以嵌入 ...

- Redis进阶实践之十八 使用管道模式加速Redis查询

一.引言 学习redis 也有一段时间了,该接触的也差不多了.后来有一天,以为同事问我,如何向redis中批量的增加数据,肯定是大批量的,为了这主题,我从新找起了解决方案.目前 ...

- Redis进阶实践之十八 使用管道模式提高Redis查询的速度

原文:Redis进阶实践之十八 使用管道模式提高Redis查询的速度 一.引言 学习redis 也有一段时间了,该接触的也差不多了.后来有一天,以为同事问我,如何向redis中 ...

- Redis进阶实践之十 Redis主从复制的集群模式

一.引言 Redis的基本数据类型,高级特性,与Lua脚本的整合等相关知识点都学完了,说是学完了,只是完成了当前的学习计划,在以后的时间还需继续深入研究和学习.从今天开始来讲一下有关Re ...

- Redis进阶实践之十 Redis哨兵集群模式

一.引言 上一篇文章我们详细的讲解了Redis的主从集群模式,其实这个集群模式配置很简单,只需要在Slave的节点上进行配置,Master主节点的配置不需要做任何更改,但是有一 ...

- Redis搭建(七):Redis的Cluster集群动态增删节点

一.引言 上一篇文章我们一步一步的教大家搭建了Redis的Cluster集群环境,形成了3个主节点和3个从节点的Cluster的环境.当然,大家可以使用 Cluster info 命令查看Cluste ...

- Redis进阶实践之十四 Redis-cli命令行工具使用详解第一部分

一.介绍 redis学了有一段时间了,以前都是看视频,看教程,很少看官方的东西.现在redis的东西要看的都差不多看完了.网上的东西也不多了.剩下来就看看官网的东西吧,一遍翻译,一遍测试. ...

- Redis进阶实践之十五 Redis-cli命令行工具使用详解第二部分(结束)

一.介绍 今天继续redis-cli使用的介绍,上一篇文章写了一部分,写到第9个小节,今天就来完成第二部分.话不多说,开始我们今天的讲解.如果要想看第一篇文章,地址如下:http: ...

随机推荐

- @synchronized(self)

@synchronized 的作用是创建一个互斥锁,保证此时没有其它线程对self对象进行修改.这个是objective-c的一个锁定令牌,防止self对象在同一时间内被其 它线程访问,起到线程的保护 ...

- spring boot项目编译出来的jar包如何更改端口号

执行的时候更改端口即可 . java -Dserver.port=9999 -jar boot.jar

- flask + Python3 实现的的API自动化测试平台---- IAPTest接口测试平台(总结感悟篇)

前言: 在前进中去发现自己的不足,在学习中去丰富自己的能力,在放弃时想想自己最初的目的,在困难面前想想怎么踏过去.在不断成长中去磨炼自己. 正文: 时间轴 flask + Python3 实现的的AP ...

- Arduino库函数中文说明

#define 常量名 常量值 % 取模运算符 String abc / char abc[n] 定义字符串 pinMode(pin,mode); 用于引脚的初始化 mode包括 INPUT ...

- scrapy_css

css选择器标准格式:reponse.css(css选择器::获取值) css选择器有哪些? * 选择所有节点 #id 选择id的节点 .container ...

- 链表法解决hash冲突

/* @链表法解决hash冲突 * 大单元数组,小单元链表 */ #pragma once #include <string> using namespace std; template& ...

- ECLIPS-S测井系统下的仪器挂接 [TCC模块]

1. 环境 HPUX版本:11.23 Complete Image ECLIPS版本:Rel 5.1i 2. 效果图 3. 用途 为以后在此系统中挂接新仪器打下坚实的基础. 4. 参考资料 ECLIP ...

- SQL Server中的变更捕获技术--简单部署

------准备------ CREATE DATABASE db_test_cdc ,) ,name )); INSERT INTO t1(name)VALUES('test') ------开始- ...

- 【高并发简单解决方案】redis队列缓存 + mysql 批量入库 + php离线整合

需求背景:有个调用统计日志存储和统计需求,要求存储到mysql中:存储数据高峰能达到日均千万,瓶颈在于直接入库并发太高,可能会把mysql干垮. 问题分析 思考:应用网站架构的衍化过程中,应用最新的框 ...

- 【转】用Linux命令行获取本机外网IP地址

$ curl ifconfig.me $ curl icanhazip.com $ curl ident.me $ curl ipecho.net/plain $ curl whatismyip.ak ...