第7章 YARN HA配置

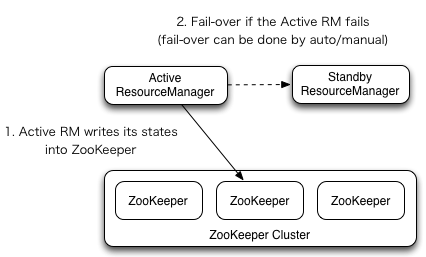

ResourceManager (RM)负责跟踪集群中的资源,以及调度应用程序(例如,MapReduce作业)。在Hadoop 2.4之前,集群中只有一个ResourceManager,当其中一个宕机时,将影响整个集群。高可用性特性增加了冗余的形式,即一个主动/备用的ResourceManager对,以便可以进行故障转移。

YARN HA的架构如下图所示:

本例中,各节点的角色分配如下表所示:

| 节点 | 角色 |

|---|---|

| centos01 | ResourceManager NodeManager |

| centos02 | ResourceManager NodeManager |

| centos03 | NodeManager |

下面将逐步讲解YARN HA的配置步骤。

7.1 yarn-site.xm文件配置

(1)修改yarn-site.xm文件,加入以下内容:

点击展开内容

<!--YARN HA配置-->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>cluster1</value>

</property>

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>centos01</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>centos02</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address.rm1</name>

<value>centos01:8088</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address.rm2</name>

<value>centos02:8088</value>

</property>

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>centos01:2181,centos02:2181,centos03:2181</value>

</property>

<property><!--启用RM重启的功能,默认为false-->

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

上述配置参数解析:

yarn.resourcemanager.ha.enabled:开启RM HA功能。

yarn.resourcemanager.cluster-id:标识集群中的RM。如果设置该选项,需要确保所有的RMs在配置中都有自己的id。

yarn.resourcemanager.ha.rm-ids:RMs的逻辑id列表。可以自定义,此处设置为“rm1,rm2”。后面的配置将引用该id。

yarn.resourcemanager.hostname.rm1:指定RM对应的主机名。另外,可以设置RM的每个服务地址。

yarn.resourcemanager.webapp.address.rm1:指定RM的Web端访问地址。

yarn.resourcemanager.zk-address:指定集成的ZooKeeper的服务地址。

yarn.resourcemanager.recovery.enabled:启用RM重启的功能,默认为false。

yarn.resourcemanager.store.class:用于状态存储的类,默认为org.apache.hadoop.yarn.server.resourcemanager.recovery.FileSystemRMStateStore,基于Hadoop文件系统的实现。还可以为org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore,该类为基于ZooKeeper的实现。此处指定该类。

(2)yarn-site.xm文件配置好后,需要将其发送到集群中其它节点。

(3)接着上一章启动好的HDFS,继续进行启动YARN。

分别在centos01、centos02节点上执行以下命令,启动ResourceManager:

[hadoop@centos01 hadoop-2.7.1]$ sbin/yarn-daemon.sh start resourcemanager

分别在centos01、centos02、centos03节点上执行以下命令,启动nodemanager:

[hadoop@centos01 hadoop-2.7.1]$ sbin/yarn-daemon.sh start nodemanager

(4)YARN启动后,查看各节点Java进程:

[hadoop@centos01 hadoop-2.7.1]$ jps

3360 QuorumPeerMain

4080 DFSZKFailoverController

4321 NodeManager

4834 Jps

3908 JournalNode

3702 DataNode

4541 ResourceManager

3582 NameNode

[hadoop@centos02 hadoop-2.7.1]$ jps

4486 Jps

3815 DFSZKFailoverController

4071 NodeManager

4359 ResourceManager

3480 NameNode

3353 QuorumPeerMain

3657 JournalNode

3563 DataNode

[hadoop@centos03 hadoop-2.7.1]$ jps

3496 JournalNode

4104 Jps

3836 NodeManager

3293 QuorumPeerMain

3390 DataNode

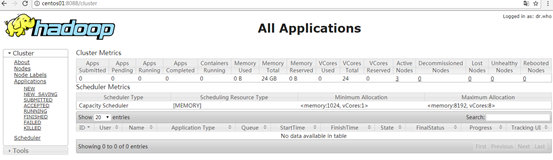

此时浏览器输入地址http://centos01:8088 访问活动状态的ResourceManager,查看YARN的启动状态。如下图所示。

如果访问备份ResourceManager地址:http://centos02:8088 发现自动跳转到了地址http://centos01:8088。这是因为此时活动状态的ResourceManager在centos01节点上。访问备份节点的ResourceManager会自动跳转到活动节点。

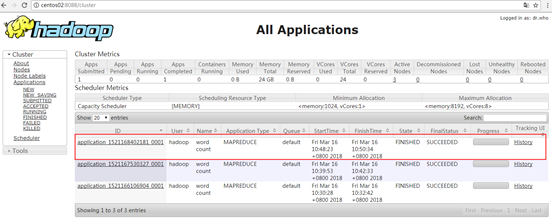

7.2 测试YARN自动故障转移

在centos01节点上执行MapReduce默认的WordCount程序,当正在执行map阶段时,新开一个SSH Shell窗口,杀掉centos01的ResourceManager进程,观察程序执行过程。执行MapReduce默认的WordCount程序的命令如下:

[hadoop@centos01 hadoop-2.7.1]$ bin/yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /input /output

执行结果如下:

[hadoop@centos01 hadoop-2.7.1]$ bin/yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /input /output

18/03/16 10:48:22 INFO input.FileInputFormat: Total input paths to process : 1

18/03/16 10:48:22 INFO mapreduce.JobSubmitter: number of splits:1

18/03/16 10:48:23 INFO mapreduce.JobSubmitter: Submitting tokens for job: job_1521168402181_0001

18/03/16 10:48:23 INFO impl.YarnClientImpl: Submitted application application_1521168402181_0001

18/03/16 10:48:23 INFO mapreduce.Job: The url to track the job: http://centos01:8088/proxy/application_1521168402181_0001/

18/03/16 10:48:23 INFO mapreduce.Job: Running job: job_1521168402181_0001

18/03/16 10:48:56 INFO mapreduce.Job: Job job_1521168402181_0001 running in uber mode : false

18/03/16 10:48:57 INFO mapreduce.Job: map 0% reduce 0%

18/03/16 10:50:21 INFO mapreduce.Job: map 100% reduce 0%

18/03/16 10:50:32 INFO mapreduce.Job: map 100% reduce 100%

18/03/16 10:50:36 INFO mapreduce.Job: Job job_1521168402181_0001 completed successfully

18/03/16 10:50:37 INFO mapreduce.Job: Counters: 49

File System Counters

FILE: Number of bytes read=1321

FILE: Number of bytes written=239335

FILE: Number of read operations=0

FILE: Number of large read operations=0

FILE: Number of write operations=0

HDFS: Number of bytes read=1094

HDFS: Number of bytes written=971

HDFS: Number of read operations=6

HDFS: Number of large read operations=0

HDFS: Number of write operations=2

Job Counters

Launched map tasks=1

Launched reduce tasks=1

Data-local map tasks=1

Total time spent by all maps in occupied slots (ms)=14130

Total time spent by all reduces in occupied slots (ms)=7851

Total time spent by all map tasks (ms)=14130

Total time spent by all reduce tasks (ms)=7851

Total vcore-seconds taken by all map tasks=14130

Total vcore-seconds taken by all reduce tasks=7851

Total megabyte-seconds taken by all map tasks=14469120

Total megabyte-seconds taken by all reduce tasks=8039424

Map-Reduce Framework

Map input records=29

Map output records=109

Map output bytes=1368

Map output materialized bytes=1321

Input split bytes=101

Combine input records=109

Combine output records=86

Reduce input groups=86

Reduce shuffle bytes=1321

Reduce input records=86

Reduce output records=86

Spilled Records=172

Shuffled Maps =1

Failed Shuffles=0

Merged Map outputs=1

GC time elapsed (ms)=188

CPU time spent (ms)=1560

Physical memory (bytes) snapshot=278478848

Virtual memory (bytes) snapshot=4195344384

Total committed heap usage (bytes)=140480512

Shuffle Errors

BAD_ID=0

CONNECTION=0

IO_ERROR=0

WRONG_LENGTH=0

WRONG_MAP=0

WRONG_REDUCE=0

File Input Format Counters

Bytes Read=993

File Output Format Counters

Bytes Written=971

从上述结果中可以看出,虽然ResourceManager进程被杀掉了,但是YARN仍然能够流畅的执行,说明自动故障转移功能生效了,ResourceManager遇到故障后,自动切换到了centos02节点上继续执行。此时浏览器访问备用ResourceManager的Web端地址http://centos02:8088发现可以成功访问了。显示任务成功执行完毕。

到此,YARN HA集群搭建完毕。

第7章 YARN HA配置的更多相关文章

- 第6章 HDFS HA配置

目录 6.1 hdfs-site.xml文件配置 6.2 core-site.xml文件配置 6.3 启动与测试 6.4 结合ZooKeeper进行自动故障转移 在Hadoop 2.0.0之前,一个H ...

- Hadoop2.4.1 64-Bit QJM HA and YARN HA + Zookeeper-3.4.6 + Hbase-0.98.8-hadoop2-bin HA Install

Hadoop2.4.1 64-Bit QJM HA and YARN HA Install + Zookeeper-3.4.6 + Hbase-0.98.8-hadoop2-bin HA(Hadoop ...

- hadoop-2.3.0-cdh5.1.0完全分布式集群配置HA配置

一.安装前准备: 操作系统:CentOS 6.5 64位操作系统 环境:jdk1.7.0_45以上,本次采用jdk-7u55-linux-x64.tar.gz master01 10.10.2.57 ...

- hadoop-2.3.0-cdh5.1.0完全分布式集群配置及HA配置(待)

一.安装前准备: 操作系统:CentOS 6.5 64位操作系统 环境:jdk1.7.0_45以上,本次采用jdk-7u55-linux-x64.tar.gz master01 10.10.2.57 ...

- CentOS7安装CDH 第七章:CDH集群Hadoop的HA配置

相关文章链接 CentOS7安装CDH 第一章:CentOS7系统安装 CentOS7安装CDH 第二章:CentOS7各个软件安装和启动 CentOS7安装CDH 第三章:CDH中的问题和解决方法 ...

- Hadoop 管理工具HUE配置-Yarn Resource Manager HA配置

安装HUE之后,需要配置很多东西才能将这个系统的功能发挥出来,因为Yarn是配置的HA模式,所以在配置HUE的时候,会有些不用,下面一段文字是官网拿来的 # Configuration for YAR ...

- 第九章 搭建Hadoop 2.2.0版本HDFS的HA配置

Hadoop中的NameNode好比是人的心脏,非常重要,绝对不可以停止工作.在hadoop1时代,只有一个NameNode.如果该NameNode数据丢失或者不能工作,那么整个集群就不能恢复了.这是 ...

- 企业级hbase HA配置

1 HBase介绍HBase是一个分布式的.面向列的开源数据库,就像Bigtable利用了Google文件系统(File System)所提供的分布式数据存储一样,HBase在Hadoop之上提供了类 ...

- HAWQ集成Yarn HA作为资源管理服务

一.第一步当然是配置YARN HA,这在使用ambari管理时很简单,这里不在赘述. 二.建立HAWQ的专用资源队列queue 不要手工编辑scheduler设置,最方便的当然是使用queue man ...

随机推荐

- Data Flow ->> Excel Connection遇到错误:[Excel Source [16]] Error: SSIS Error Code DTS_E_CANNOTACQUIRECONNECTIONFROMCONNECTIONMANAGER.....

在SSIS下做Excel导入数据的时候遇到下面的错误 [Excel Source [16]] Error: SSIS Error Code DTS_E_CANNOTACQUIRECONNECTIONF ...

- PLSQL使用绑定变量

想对一个sql做10046trace,结果因为10g数据库无法对sql_id做,只能使用绑定变量的方法,下面sql是如何使用绑定变量运行sql的语句 declare v_sql VARCHAR2( ...

- 【设计模式最终总结】桥接模式 VS 外观模式

差异点 外观模式,是把功能通过一个接口提供出来,方便日后更换实现,或者这种实现可以由多方提供,但同时只用一个.典型例子:@Slf4j 桥接模式,多个维度,每个维度提供一个接口,这些接口集中在一个类中, ...

- [EffectiveC++]item38:通过复合塑膜出has -a 或“根据某物实现出”

Model "has-a"or “is-implemented-in-terms-of” through composition

- 如何理解 Learning to rank

转:http://hi.baidu.com/christole/item/23215e364d8418f896f88deb What is Rank? rank就是排序.IR中需要排序的问题很多,最常 ...

- Myeclipse 自带Tomcat启动8080端口占用

在启动Myeclipse自带的Tomcat发现报错,显示8080端口被占用 第一步:window+r 组合键,调出命令窗口. 第二步:输出命令:netstat -ano|findstr 8080 ...

- Python 输出中文的笔记

import sysreload(sys)sys.setdefaultencoding('utf8') 导入csv乱码: 加入: import codecs csvfile.write(codecs. ...

- css3的代替图片的三角形

1.小三角形(与边框结合,不兼容IE8) .callout{ position: relative; width: 100px; height: 100px; background: #fce6ed; ...

- canny算子求图像边缘,edgebox那部分

过程: 1. 彩色图像转换为灰度图像 2. 对图像进行高斯模糊 3. 计算图像梯度,根据梯度计算图像边缘幅值与角度(这里其实用到了微分边缘检测算子来计算梯度幅 ...

- [转]MFC子线程中更新控件内容的两种办法

一.概述 每个系统中都有线程(至少都有一个主线程),而线程最重要的作用就是并行处理,提高软件的并发率.针对界面来说,还能提高界面的响应能力.一般的,为了应用的稳定性,在数据处理等耗时操作会单独在一个线 ...