Hbase Region合并

业务场景:

Kafka+SparkStreaming+Hbase

由于数据大量的迁移,再加上业务的改动,新增了很多表,导致rerigon总数接近4万(36个节点)

组件版本:

Kafka:2.1.1

Spark:2.2.0-cdh5.12.0

Hbase:1.2.0-cdh5.12.0

问题发现:

CDH界面较多关于web服务器相应时间过长,和队列刷新速度较慢。

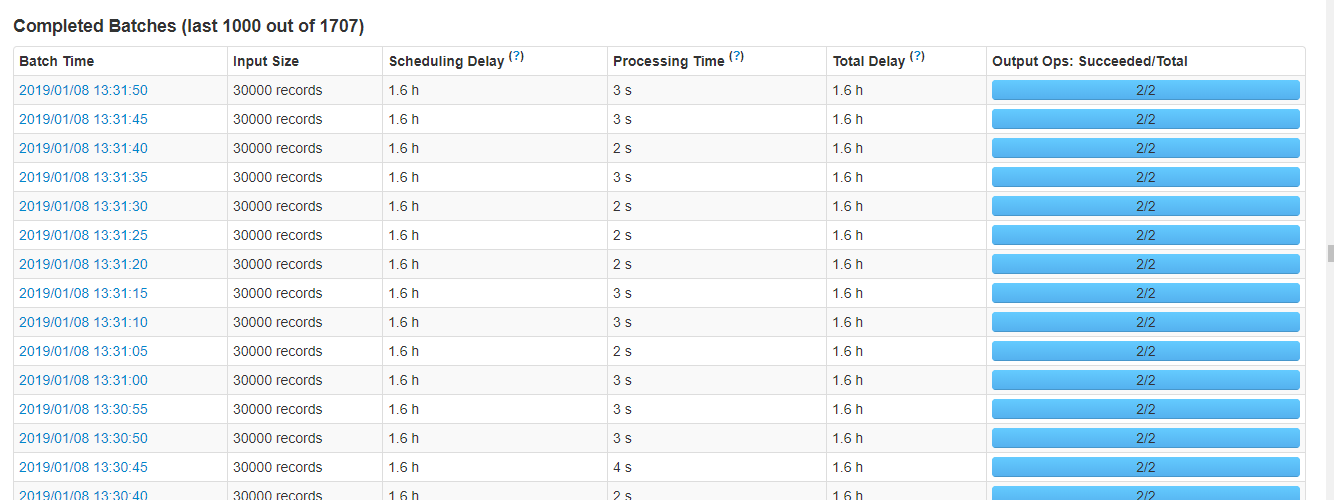

streaming界面,每隔一段时间就会需要较长的处理时间

解决过程:

【1】

首先把一些业务不需要的表disable掉,region下线,最后还剩2.5万个线上region,随后CDH页面无异常信息了,并且streaming处理时间都比较正常了(四类业务表现都相同)

【2】

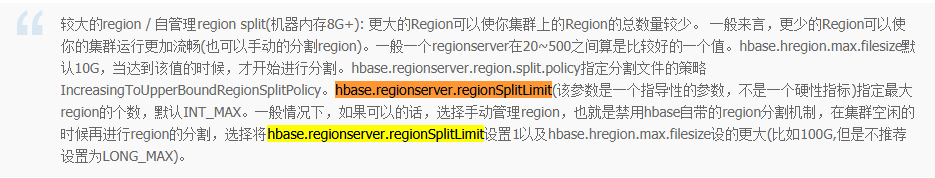

由于业务上每月都会有新表,所以以上的操作不能满足,经过研究,可以在保证表的请求量不高的情况下,把当前表的region合并,从而减少region数。而且Hbase集群目前已经停掉了region自动分裂,所以不会有在合并完之后再分裂的情况。

禁用分裂机制:

集群配置:

理论上讲,现在regionserver分配了64G内存,0.8的写入高水位线,也就是64*0.8=51.2G用作写,每个memstore占用128M,这么算的话理论上也就每个server400多个region的时候,不会造成过早的flush,总共下来400*36个,现在已经是超负荷运行了,所以还需要将Region进行合并。

合并代码:

public class Hbase_Merge {

public static void main(String[] args) throws Exception {

Configuration conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.property.clientPort", "2181");

conf.set("hbase.zookeeper.quorum", "zk1,zk2,zk3");

HBaseAdmin admin = new HBaseAdmin(conf);

List<HRegionInfo> regions = admin.getTableRegions(TableName.valueOf("TableName"));

Collections.sort(regions, new Comparator<HRegionInfo>() {

@Override

public int compare(HRegionInfo o1, HRegionInfo o2) {

return Bytes.compareTo(o1.getStartKey(),o2.getStartKey());

}

});

HRegionInfo regionInfo =null;

for (HRegionInfo r : regions){

int index =regions.indexOf(r);

if(index %2 == 0){

regionInfo = r;

}else{

System.out.println("start to merge two regions,NUM:"+index+" and "+(index+1) );

admin.mergeRegions(regionInfo.getEncodedNameAsBytes(),r.getEncodedNameAsBytes(),false);

System.out.println("merge two regions finished");

}

}

System.out.println("merge all regions finished");

}

}

结果:

最终Region数大量减少,Streaming任务也恢复正常。

后记:

IO高峰为合并region导致的,入Hbase的程序都将受到影响,Streaming批处理时间增长,中间还伴随着Region-In-Transition(此处影响不大)

建议:避开业务高峰期对Region合并

这些都是之前存到有道上了,搬到这里费了好大的劲,还得不断学习,哈哈

Hbase Region合并的更多相关文章

- HBase Region合并分析

1.概述 HBase中表的基本单位是Region,日常在调用HBase API操作一个表时,交互的数据也会以Region的形式进行呈现.一个表可以有若干个Region,今天笔者就来和大家分享一下Reg ...

- hbase优化之region合并和压缩

HBASE操作:(一般先合并region然后再压缩) 一 .Region合并: merge_region 'regionname1','regionname2' ,'true' --true代表 ...

- 【原创】大叔问题定位分享(13)HBase Region频繁下线

问题现象:hive执行sql报错 select count(*) from test_hive_table; 报错 Error: java.io.IOException: org.apache.had ...

- 【转】HBASE Region in Transition issue on Master UI

[From]https://community.hortonworks.com/content/supportkb/244808/hbase-region-in-transition-issue-on ...

- Hbase Region Server整体架构

Region Server的整体架构 本文主要介绍Region的整体架构,后续再慢慢介绍region的各部分具体实现和源码 RegionServer逻辑架构图 RegionServer职责 1. ...

- HBase Region重点剖析

Region的概念 Region是HBase数据管理的基本单位.数据的move,数据的balance,数据的split,都是按照region来进行操作的. region中存储这用户的真实数据,而为了管 ...

- Hbase region 某个regionserver挂掉后的处理

aaarticlea/png;base64,iVBORw0KGgoAAAANSUhEUgAAAwoAAACdCAMAAAAjbX91AAAABGdBTUEAALGPC/xhBQAAAAFzUkdCAK

- hbase region 分配方式

参与 Region 分配的重要对象 在 Region 分配过程中,起着重要作用有如下一些对象. HMaster— 是 HBase 中的 Master server ,仅有一个. HRegionServ ...

- HBase Region级别二级索引

我们会经常谈及二级索引,这是对全表数据进行另外一种方式的组织存储,是针对table级别的.如果要为HBase上的表实现一个强一致性的二级索引,那么就无法逃避分布式事务,而这一直是用户最期待的功能. 而 ...

随机推荐

- MySQL主从重新同步

主从数据不一致,重新配置主从同步也是一种解决方法. 1.从库停止主从复制 stop slave; 2.对主库数据库加锁 flush tables with read lock; 3.备份主库数据 my ...

- Animate..css的一些属性使用

使用基本的代码 <!DOCTYPE html> <html> <head> <meta charset="utf-8"> <t ...

- 持久层之 MyBatis: 第二篇 :动态SQL And多表查询

MyBatis入门到精通 完整CRUD UserDaoImpl 编写UserDao对应的UserDaoMapper.xml 添加UserDao的测试用例 编写UserDao的测试用例 解决数据库字段名 ...

- CentOS8更换国内YUM源

rm -rf /etc/yum.repos.d/* wget -O /etc/yum.repos.d/CentOS-cnnic.repo https://feieryun.oss-cn-zhangji ...

- 微服务 - 服务注册发现(三)Consule

Consul 集群 在consul方案中,每个提供服务的节点上都要部署和运行consul的agent,所有运行consul agent节点的集合构成consul cluster.consul agen ...

- 服务器运行jupyter,本地浏览器打开

https://www.cnblogs.com/wwwhza/p/8821117.html https://blog.csdn.net/qq_29762941/article/details/8063 ...

- Raft算法系列教程4:日志不一致的解决

网络不可能一直处于正常情况,因为Leader或者某个Follower有可能会崩溃,从而导致日志不能一直保持一致.因此存在以下三种情况: (1)Follower缺失当前Leader上存在的日志条目.(2 ...

- Java 为每个原始类型提供了哪些包装类型:

java的包装类型: 原始类型: boolean,char,byte,short,int,long,float,double 包装类型:Boolean,Character,Byte,Short,Int ...

- ThreadLocal解决什么问题

原创文章,转载请务必将下面这段话置于文章开头处(保留超链接).本文转发自技术世界,原文链接 http://www.jasongj.com/java/threadlocal/ ThreadLocal解决 ...

- 关于Byte(1) 与int (1) 比较原理

最近笔者遇到一个问题 Integer cameraType=1 if (cameraType.intValue() == SourceTypeEnum.ANFANG.getType(){ } 枚举值是 ...