python 线程(创建2种方式,锁,死锁,递归锁,GIL锁,守护进程)

###############总结############

线程创建的2种方式(重点)

进程:资源分配单位 线程:cpu执行单位(实体)

线程的创建和销毁的开销特别小

线程之间资源共享,是同一个进程中的资源共享,会涉及到安全问题,所以需要加锁解决

锁:牺牲了效率,保证了数据安全(重点)

死锁现象:出现在嵌套的时候,双方互相抢对方已经拿到的锁,导致双方互相等待(重点)

递归锁: 解决了死锁现象(重点)

rlock 首先本身就是个互斥锁,维护了一个计数器,每次acquire+1,release就-1,当计数器为0的时候,大家才会抢这个锁

守护线程:

守护线程:等待所有非守护线程结束才结束

守护进程: 主进程运行代码结束,守护进程会随之结束

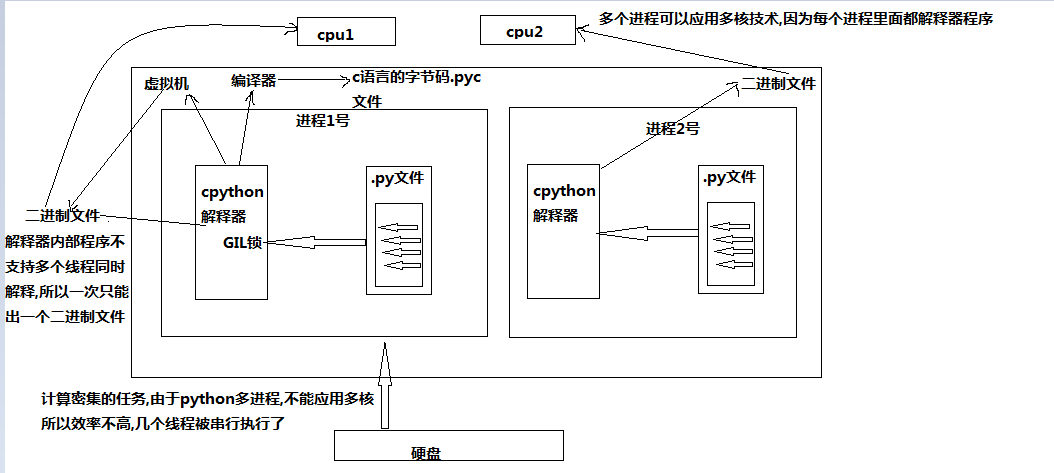

GIL锁:

运行一个py文件 需要开辟一块内存,内存中有 cpython解释器,py文件代码

cpython解释器有 编译器和虚拟机 编译器:编译出来后是c语言的字节码

经过虚拟机后:变成可执行的二进制文件 到cpu里面执行

py文件代码到cpython解释器的时候,会经过一个gil锁,这个锁会把文件中的多个线程变成并行处理的方式

这样的话 一次只能出一个二进制文件导致单核cpu执行,没法做到多线程

如果做到同时处理多核计算形任务了?

使用多进程运用进程运用多核技术,因为每个进程里面都有cpython解释器程序

一个普通的cpu 一秒可以随便执行500万条mps 也就是5亿条指令

如果你的程序是I/O型的(一般你的程序都是这个)(input、访问网址网络延迟、打开/关闭文件读写),

在什么情况下用的到高并发呢(金融计算会用到,人工智能(阿尔法狗),但是一般的业务场景用不到,爬网页,多用户网站、聊天软件、处理文件)

I/O型的操作很少占用CPU

###第一种

from threading import Thread

def f1(n):

print(n)

if __name__ == '__main__':

t1=Thread(target=f1,args=(1,))

t1.start()

###第二种

class mythread(Thread):

def __init__(self,name):

super().__init__()

self.name=name

def run(self):

print('hellow'+self.name)

if __name__ == '__main__':

t=mythread('alex')

t.start()

print('主线程结束') #####################

1

hellowalex

主线程结束

###查看线程的进程id

import os

from threading import Thread

def f1(n):

print('1号',os.getpid())

print('%s号'%n)

def f2(n):

print('2号',os.getpid())

print('%s'%n)

if __name__ == '__main__':

t1=Thread(target=f1,args=(1,))

t2=Thread(target=f2,args=(2,))

t1.start()

t2.start()

print('主进程id',os.getpid())

############

线程ID是一样的

###验证线程是数据共享的

import os

import time

from threading import Thread

num=100

def f1(n):

global num

num=3

print('子线程num',num)

if __name__ == '__main__':

t=Thread(target=f1,args=(1,))

t.start()

t.join()#主进程等待子进程运行完才继续执行

print('主进程的num',num)

###################

子线程num 3

主进程的num 3

###多进程效率对比

import time

from threading import Thread

from multiprocessing import Process

def f1():

for i in range(5):

i=i+i

if __name__ == '__main__':

t_s_time=time.time()

t_list=[]

# 查看一下20个线程执行20个任务的执行时间

for i in range(20):

t=Thread(target=f1,)

t.start()

t_list.append(t)

[tt.join() for tt in t_list]

t_e_time=time.time()

t_dif_time=t_e_time-t_s_time

# print(t_dif_time)

#查看一个20个进程执行的任务时间

##########################################

p_s_time=time.time()

p_list=[]

for i in range(20):

p=Process(target=f1,)

p.start()

p_list.append(p)

[pp for pp in p_list]

p_e_time=time.time()

p_dif_time=p_e_time-p_s_time

print('线程执行的时间%s'%t_dif_time)

print('进程执行的时间%s' % p_dif_time)

###################

线程执行的时间0.003000497817993164

进程执行的时间0.2560145854949951

####锁 牺牲了效率,保证了数据安全(重点)

import time

from multiprocessing import Process

from threading import Thread,Lock

num=100

def f1(loc):

loc.acquire()#没加锁的时候 多个程序会抢一个数据 造成数据不安全

global num

tmp=num

tmp-=1

time.sleep(0.01)#模拟

num=tmp

loc.release()

if __name__ == '__main__':

t_loc=Lock()

t_list=[]

for i in range(10):

t=Thread(target=f1,args=(t_loc,))

t.start()

t_list.append(t)

[tt.join() for tt in t_list]

print('主进程',num)

##############

主进程 90

#####死锁现象 出现在嵌套的时候,双方互相抢对方已经拿到的锁,导致双方互相等待(重点)

import time

from threading import Thread,Lock,RLock

def f1(locA,locB):

locA.acquire()

print('f1>>1号抢到了A锁')

time.sleep(1)

locB.acquire()

print('f1>>1号抢到了B锁')

locB.release()

locA.release()

def f2(locA,locB):

locB.acquire()

print('f2>>2号抢到了B锁')

locA.acquire()

time.sleep(1)

print('f2>>2号抢到了A锁')

locA.release()

locB.release()

if __name__ == '__main__':

locA = Lock()

locB = Lock()

t1 = Thread(target=f1,args=(locA,locB))

t2 = Thread(target=f2,args=(locA,locB))

t1.start()

t2.start()

##################

f1>>1号抢到了A锁

f2>>2号抢到了B锁

递归锁: 解决了死锁现象(重点)

rlock 首先本身就是个互斥锁,维护了一个计数器,每次acquire+1,release就-1,当计数器为0的时候,大家才会抢这个锁

import time

from threading import Thread,Lock,RLock

def f1(LocA,LocB):

# time.sleep(1)

LocA.acquire()

print('f1>>1号抢到a锁')

time.sleep(1)

LocB.acquire()

print('f1>>1号抢到b锁')

LocB.release()

LocA.release()

def f2(LocA, LocB):

# time.sleep(1)

LocB.acquire()

print('f2>>2号抢到b锁')

time.sleep(1)

LocA.acquire()

print('f2>>2号抢到a锁')

LocA.release()

LocB.release()

if __name__ == '__main__':

LockA=Lock()

LockB=Lock()

LockA=LockB=RLock()#递归锁,维护一个计时器,acquire+1 release-1

t1=Thread(target=f1,args=(LockA,LockB))

t2=Thread(target=f2,args=(LockA,LockB))

t1.start()

t2.start()

#######################

f1>>1号抢到a锁

f1>>1号抢到b锁

f2>>2号抢到b锁

f2>>2号抢到a锁

守护线程: 等待所有非守护线程结束才结束

import time

from threading import Thread

def f1():

time.sleep(3)

print('xxxxxx')

def f2():

time.sleep(2)

print('普通子进程的代码')

if __name__ == '__main__':

p=Process(target=f1,)

p.daemon=True

# 等待所有非守护线程结束才结束

p.start() p2=Process(target=f2,)

p2.start()

p2.join()

print('主进程,结束')

####################

普通子进程的代码

主进程,结束

如果把 上面的 f2 改成3s f1改成2s 会打印出xxxx 因为f2执行时间大于f1函数

python 线程(创建2种方式,锁,死锁,递归锁,GIL锁,守护进程)的更多相关文章

- Python创建进程、线程的两种方式

代码创建进程和线程的两种方式 """ 定心丸:Python创建进程和线程的方式基本都是一致的,包括其中的调用方法等,学会一个 另一个自然也就会了. "" ...

- Python并发编程05 /死锁现象、递归锁、信号量、GIL锁、计算密集型/IO密集型效率验证、进程池/线程池

Python并发编程05 /死锁现象.递归锁.信号量.GIL锁.计算密集型/IO密集型效率验证.进程池/线程池 目录 Python并发编程05 /死锁现象.递归锁.信号量.GIL锁.计算密集型/IO密 ...

- 0036 Java学习笔记-多线程-创建线程的三种方式

创建线程 创建线程的三种方式: 继承java.lang.Thread 实现java.lang.Runnable接口 实现java.util.concurrent.Callable接口 所有的线程对象都 ...

- 并发编程8 线程的创建&验证线程之间数据共享&守护线程&线程进程效率对比&锁(死锁/递归锁)

1.线程理论以及线程的两种创建方法 2.线程之间是数据共享的与join方法 3.多线程和多进程的效率对比 4.数据共享的补充线程开启太快 5.线程锁 互斥锁 同步锁 6.死锁现象和递归锁 7.守护线程 ...

- 【java并发】传统线程技术中创建线程的两种方式

传统的线程技术中有两种创建线程的方式:一是继承Thread类,并重写run()方法:二是实现Runnable接口,覆盖接口中的run()方法,并把Runnable接口的实现扔给Thread.这两种方式 ...

- Java创建线程的第二种方式:实现runable接口

/*需求:简单的卖票程序多个窗口买票 创建线程的第二种方式:实现runable接口 *//*步骤1.定义类实现Runable接口2.覆盖Runable接口中的run方法 将线程要运行的代码存放在 ...

- 创建线程的两种方式比较Thread VS Runnable

1.首先来说说创建线程的两种方式 一种方式是继承Thread类,并重写run()方法 public class MyThread extends Thread{ @Override public vo ...

- Java中创建线程的两种方式

创建线程的第一种方式: 创建一个类继承Thread 重写Thread中的run方法 (创建线程是为了执行任务 任务代码必须有存储位置,run方法就是任务代码的存储位置.) 创建子类对象,其实就是在创建 ...

- Java并发编程:Java创建线程的三种方式

目录 引言 创建线程的三种方式 一.继承Thread类 二.实现Runnable接口 三.使用Callable和Future创建线程 三种方式的对比 引言 在日常开发工作中,多线程开发可以说是必备技能 ...

随机推荐

- Codeforces Round #540 Div. 3 F2

考虑将每种颜色构成的极小连通块缩点,然后直接跑树形dp即可,即f[i][0/1]表示子树内是否有颜色向上延伸时删边的方案数.dp时需要去除某点的贡献,最好用前后缀积的做法而不是求逆. 至于如何缩点,假 ...

- bzoj 4542: [Hnoi2016]大数 (莫队)

Description 小 B 有一个很大的数 S,长度达到了 N 位:这个数可以看成是一个串,它可能有前导 0,例如00009312345.小B还有一个素数P.现在,小 B 提出了 M 个询问,每个 ...

- 爬虫_微信小程序社区教程(crawlspider)

照着敲了一遍,,, 需要使用"LinkExtrator"和"Rule",这两个东西决定爬虫的走向. 1.allow设置规则的方法:要能够限制在我们想要的url上 ...

- MT【246】方程根$\backsim$图像交点

已知函数$f(x)=x^2+x-2$,若$g(x)=|f(x)|-f(x)-2mx-2m^2$ 有三个不同的零点,则$m$的取值范围_____ 分析:等价于$h(x)=|f(x)|-f(x),t(x) ...

- php unset对json_encode的影响

先运行一段php代码: $a = Array(0=>'hello world', 1=>'girl', 2=>'boy'); var_dump(json_encode($a)); u ...

- nfs的配置文件/etc/exports

/etc/exports 文件格式 <输出目录> [客户端1 选项(访问权限,用户映射,其他)] [客户端2 选项(访问权限,用户映射,其他)] a. 输出目录:输出目录是指NFS系统中 ...

- 洛谷P3740 【[HAOI2014]贴海报】

(呃...本蒟蒻的第一篇题解qwq)..不废话了讲正题..思路来源于铺地毯(-->传送门)..先算出每一个格子上覆盖的海报并把可见的海报做标记然后算出有多少海报是可见的..但是作为省选题怎么可能 ...

- 【redis】redis配置文件参数解析

redis配置文件路径可以通过info命令找到 Redis配置参数如下daemonize no 默认情况下,redis不是以守护进程的方式运行,一般生产环境,把该项的值更改为 yesrequirepa ...

- Python经典算法片段

将一个正整数分解质因数 #!/bin/env python2 # -*- coding: UTF-8 -*- def reduceNum(n): print '{} = '.format(n), if ...

- 【洛谷P1637】三元上升子序列

题目大意:给定一个长度为 N 的序列,求有多少个三元组满足 \(i<j<k,a_i<a_j<a_k\). 题解:这是一类二维偏序问题,与逆序对问题类似. 对于序列中每个点来说, ...