一、PyTorch 入门实战—Tensor(转)

一、Tensor的创建和使用

1.概念和TensorFlow的是基本一致的,只是代码编写格式的不同。我们声明一个Tensor,并打印它,例如:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([1, 2], [3, 4],[5, 6], [7, 8])

print(a)

print('{}'.format(a))

然后会发现报以下错误:

new() received an invalid combination of arguments - got (list, list, list, list), but expected one of: * (torch.device device) * (torch.Storage storage) * (Tensor other) * (tuple of ints size, torch.device device) * (object data, torch.device device)

意思是接收到无效的参数组合。其实是少写了一对中括号,这是初学者的常用错误。

2.改成如下形式:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(a)

print('{}'.format(a))

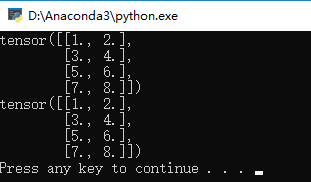

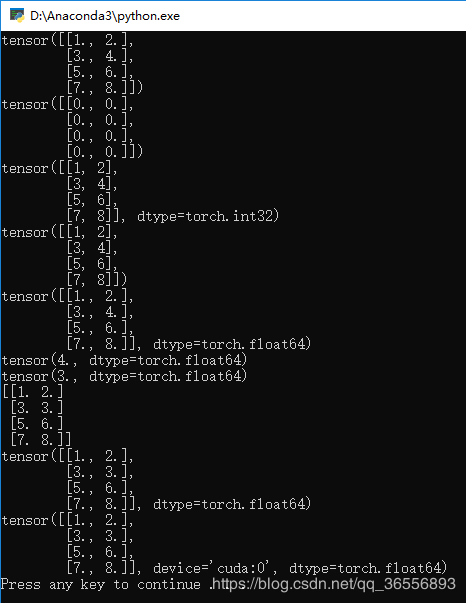

结果为:

3.如果想查看的它的大小可以加一句话:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a.size()))

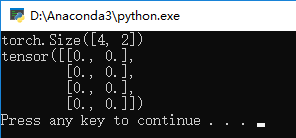

结果为:

即4行2列的矩阵

4.如果想生成一个全为0的矩阵,可以输入如下代码:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a.size()))

b = torch.zeros((4, 2))

print(b)

结果为:

即4行2列数组元素全为0的矩阵

5.如果想生成不同类型的数据,可以改变torch.后面函数名称,例如下面这样:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a))

b = torch.zeros((4, 2))

print(b)

c = torch.IntTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(c)

d = torch.LongTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(d)

e = torch.DoubleTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(e)

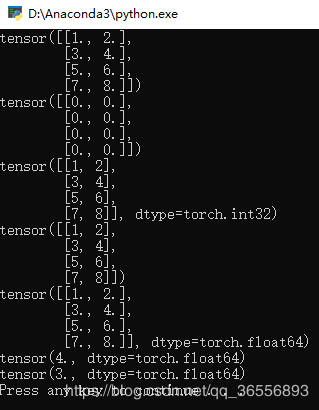

结果为:

6.如果想访问Tensor里的一个元素或者改变它,可以输入如下代码:

print(e[1, 1])

#改变元素值

e[1, 1] = 3

print(e[1, 1])

代码变为:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a))

b = torch.zeros((4, 2))

print(b)

c = torch.IntTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(c)

d = torch.LongTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(d)

e = torch.DoubleTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(e)

print(e[1, 1])

#改变元素值

e[1, 1] = 3

print(e[1, 1])

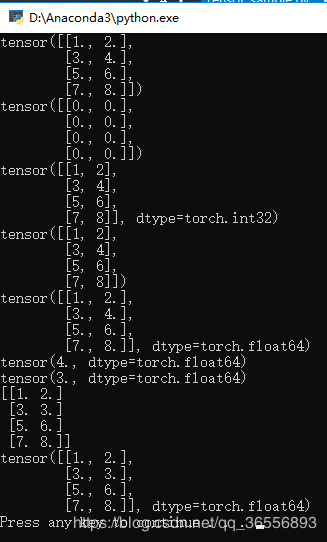

结果为:

说明原来4的位置数值变为了3

7.最重要的是Tensor和Numpy之间的转换,例如我们把e变为numpy类型,添加以下代码:

f = e.numpy()

print(f)

变为:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a))

b = torch.zeros((4, 2))

print(b)

c = torch.IntTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(c)

d = torch.LongTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(d)

e = torch.DoubleTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(e)

print(e[1, 1])

#改变元素值

e[1, 1] = 3

print(e[1, 1])

#转换为Numpy

f = e.numpy()

print(f)

结果为:

可以看到没有tensor()了~

我们再把f变为tensor类型,输入以下代码:

g = torch.from_numpy(f)

print(g)

变为:

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a))

b = torch.zeros((4, 2))

print(b)

c = torch.IntTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(c)

d = torch.LongTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(d)

e = torch.DoubleTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(e)

print(e[1, 1])

#改变元素值

e[1, 1] = 3

print(e[1, 1])

#转换为Numpy

f = e.numpy()

print(f)

#转换为Tensor

g = torch.from_numpy(f)

print(g)

结果为:

可以看到又变成了Tensor类型

二、Tensor放到GPU上执行

1.通过如下代码判断是否支持GPU:

if torch.cuda.is_available():

h = g.cuda()

print(h)

变为

import torch

#定义一个Tensor矩阵

a = torch.Tensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print('{}'.format(a))

b = torch.zeros((4, 2))

print(b)

c = torch.IntTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(c)

d = torch.LongTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(d)

e = torch.DoubleTensor([[1, 2], [3, 4],[5, 6], [7, 8]])

print(e)

print(e[1, 1])

#改变元素值

e[1, 1] = 3

print(e[1, 1])

#转换为Numpy

f = e.numpy()

print(f)

#转换为Tensor

g = torch.from_numpy(f)

print(g)

#将Tensor放在GPU上

if torch.cuda.is_available():

h = g.cuda()

print(h)

2.生成结果会慢一下,然后可以看到多了一个device=‘cuda:0’:

三、Tensor总结

1.Tensor和Numpy都是矩阵,区别是前者可以在GPU上运行,后者只能在CPU上

2.Tensor和Numpy互相转化很方便,类型也比较兼容

3.Tensor可以直接通过print显示数据类型,而Numpy不可以,例如:dtype = torch.float64

一、PyTorch 入门实战—Tensor(转)的更多相关文章

- 二、PyTorch 入门实战—Variable(转)

目录 一.概念 二.Variable的创建和使用 三.标量求导计算图 四.矩阵求导计算图 五.Variable放到GPU上执行 六.Variable转Numpy与Numpy转Variable 七.Va ...

- 超简单!pytorch入门教程(一):Tensor

http://www.jianshu.com/p/5ae644748f21 二.pytorch的基石--Tensor张量 其实标量,向量,矩阵它们三个也是张量,标量是零维的张量,向量是一维的张量,矩阵 ...

- 深度学习入门实战(二)-用TensorFlow训练线性回归

欢迎大家关注腾讯云技术社区-博客园官方主页,我们将持续在博客园为大家推荐技术精品文章哦~ 作者 :董超 上一篇文章我们介绍了 MxNet 的安装,但 MxNet 有个缺点,那就是文档不太全,用起来可能 ...

- [pytorch] Pytorch入门

Pytorch入门 简单容易上手,感觉比keras好理解多了,和mxnet很像(似乎mxnet有点借鉴pytorch),记一记. 直接从例子开始学,基础知识咱已经看了很多论文了... import t ...

- Pytorch入门随手记

Pytorch入门随手记 什么是Pytorch? Pytorch是Torch到Python上的移植(Torch原本是用Lua语言编写的) 是一个动态的过程,数据和图是一起建立的. tensor.dot ...

- pytorch 入门指南

两类深度学习框架的优缺点 动态图(PyTorch) 计算图的进行与代码的运行时同时进行的. 静态图(Tensorflow <2.0) 自建命名体系 自建时序控制 难以介入 使用深度学习框架的优点 ...

- pytorch入门2.0构建回归模型初体验(数据生成)

pytorch入门2.x构建回归模型系列: pytorch入门2.0构建回归模型初体验(数据生成) pytorch入门2.1构建回归模型初体验(模型构建) pytorch入门2.2构建回归模型初体验( ...

- Pytorch入门——手把手教你MNIST手写数字识别

MNIST手写数字识别教程 要开始带组内的小朋友了,特意出一个Pytorch教程来指导一下 [!] 这里是实战教程,默认读者已经学会了部分深度学习原理,若有不懂的地方可以先停下来查查资料 目录 MNI ...

- Pytorch入门上 —— Dataset、Tensorboard、Transforms、Dataloader

本节内容参照小土堆的pytorch入门视频教程.学习时建议多读源码,通过源码中的注释可以快速弄清楚类或函数的作用以及输入输出类型. Dataset 借用Dataset可以快速访问深度学习需要的数据,例 ...

随机推荐

- CS代码代写, 程序代写, java代写, python代写, c/c++代写,csdaixie,daixie,作业代写,代写

互联网一线工程师程序代写 微信联系 当天完成特色: 互联网一线工程师 24-48小时完成.用心代写/辅导/帮助客户CS作业. 客户反馈与评价 服务质量:保证honor code,代码原创.参考课程sl ...

- SpringCloud Sleuth入门介绍

案例代码:https://github.com/q279583842q/springcloud-e-book 一.Sleuth介绍 为什么要使用微服务跟踪?它解决了什么问题? 1.微服务的现状? ...

- mysql索引结构

mysql中索引的数据结构: 1.基本上所有的索引都是B-Tree结构,一部分还有HASH索引. 2.索引分类(功能) 主键索引:一张表中最多有一个主键索引,而且该字段值不能为NULL,不能重复. 唯 ...

- 前端js倒计时(精确到毫秒)

话不多说,直接上代码: 有需要直接拿走, <html> <head> <style> div{ width:100%; text-align:center; fon ...

- canvas 画布基本操作

const canvas = document.getElementById('canvas'); // 2.画笔 --- canvas的上下文对象 const ctx = canvas.getCon ...

- filebeat直连elasticsearch利用pipeline提取message中的字段

这里使用filebeat直连elasticsearch的形式完成数据传输,由于没有logstash,所有对于原始数据的过滤略显尴尬(logstash的filter非常强大). 但是由于业务需求,还是需 ...

- Spring3 springMVC添加注解式WebSocket

Spring3添加注解式WebSocket 推荐升级成spring4以后,spring4已经集成WebSocket. 由于种种原因,项目开发处于快结束的阶段了,升级成spring4不想那么麻烦,但是又 ...

- 嵊州D1T3 睡美人航班

嵊州D1T3 睡美人航班 不知不觉中,我对她的爱意已经达到了 n. 是这样子的,第 1 分钟,我对她的爱意值是 (1, 1). 假如当第 x 分钟时我对她的爱意值是 (a, b),那么第 x + 1 ...

- Java web导出word,文件名为中文,%E6%9D%90%E8%B4%A8%E5%8D%95乱码

因为文件名为中文,导出时会有乱码问题 原代码: String fileName = "文件名.doc"; response.setHeader("Content-Disp ...

- 关于爬虫平台的架构实现和框架的选型(二)--scrapy的内部实现以及实时爬虫的实现

我们接着关于爬虫平台的架构实现和框架的选型(一)继续来讲爬虫框架的架构实现和狂阶的选型. 前面介绍了scrapy的基本操作,下面介绍下scrapy爬虫的内部实现架构如下图 1.Spiders(爬虫): ...