pytorch torch.nn 实现上采样——nn.Upsample

Vision layers

1)Upsample

CLASS torch.nn.Upsample(size=None, scale_factor=None, mode='nearest', align_corners=None)

上采样一个给定的多通道的 1D (temporal,如向量数据), 2D (spatial,如jpg、png等图像数据) or 3D (volumetric,如点云数据)数据

假设输入数据的格式为minibatch x channels x [optional depth] x [optional height] x width。因此对于一个空间spatial输入,我们期待着4D张量的输入,即minibatch x channels x height x width。而对于体积volumetric输入,我们则期待着5D张量的输入,即minibatch x channels x depth x height x width

对于上采样有效的算法分别有对 3D, 4D和 5D 张量输入起作用的 最近邻、线性,、双线性, 双三次(bicubic)和三线性(trilinear)插值算法

你可以给定scale_factor来指定输出为输入的scale_factor倍或直接使用参数size指定目标输出的大小(但是不能同时制定两个)

参数:

size (int or Tuple[int] or Tuple[int, int] or Tuple[int, int, int], optional) – 根据不同的输入类型制定的输出大小

scale_factor (float or Tuple[float] or Tuple[float, float] or Tuple[float, float, float], optional) – 指定输出为输入的多少倍数。如果输入为tuple,其也要制定为tuple类型

mode (str, optional) – 可使用的上采样算法,有

'nearest','linear','bilinear','bicubic'and'trilinear'.默认使用'nearest'align_corners (bool, optional) – 如果为True,输入的角像素将与输出张量对齐,因此将保存下来这些像素的值。仅当使用的算法为

'linear','bilinear'or'trilinear'时可以使用。默认设置为False

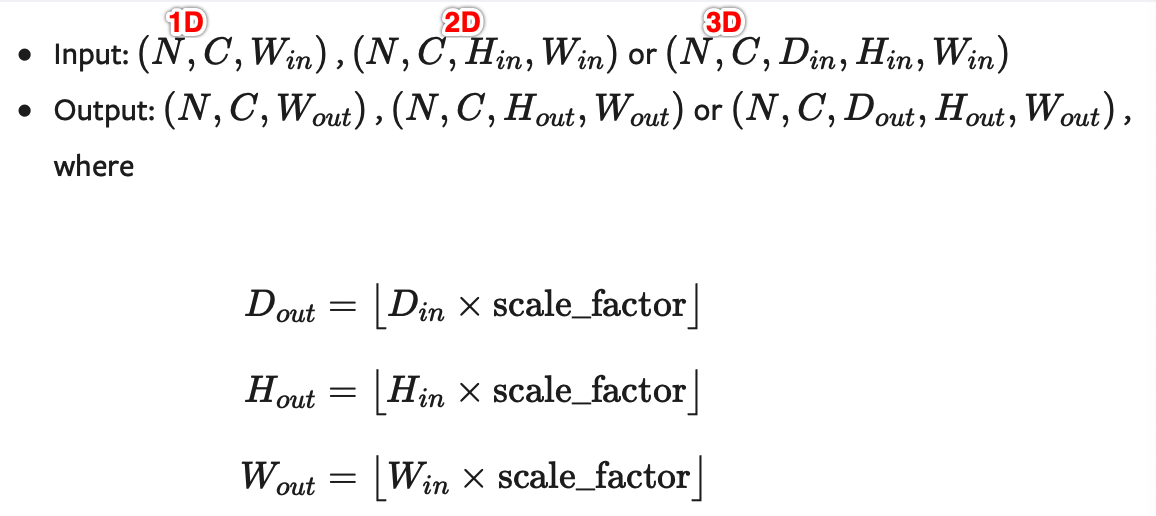

输入输出形状:

注意:

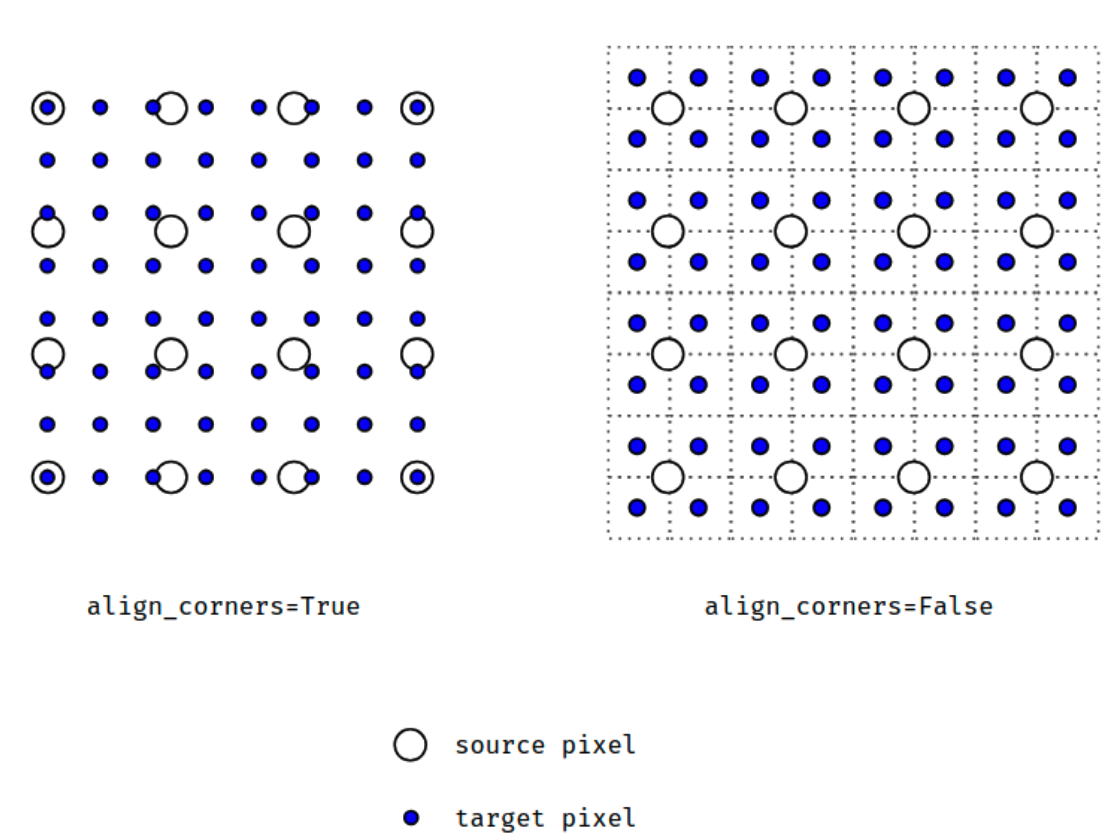

当align_corners = True时,线性插值模式(线性、双线性、双三线性和三线性)不按比例对齐输出和输入像素,因此输出值可以依赖于输入的大小。这是0.3.1版本之前这些模式的默认行为。从那时起,默认行为是align_corners = False,如下图:

上面的图是source pixel为4*4上采样为target pixel为8*8的两种情况,这就是对齐和不对齐的差别,会对齐左上角元素,即设置为align_corners = True时输入的左上角元素是一定等于输出的左上角元素。但是有时align_corners = False时左上角元素也会相等,官网上给的例子就不太能说明两者的不同(也没有试出不同的例子,大家理解这个概念就行了)

如果您想下采样/常规调整大小,您应该使用interpolate()方法,这里的上采样方法已经不推荐使用了。

举例:

import torch

from torch import nn

input = torch.arange(, , dtype=torch.float32).view(, , , )

input

返回:

tensor([[[[., .],

[., .]]]])

m = nn.Upsample(scale_factor=, mode='nearest')

m(input)

返回:

tensor([[[[., ., ., .],

[., ., ., .],

[., ., ., .],

[., ., ., .]]]])

m = nn.Upsample(scale_factor=, mode='bilinear',align_corners=False)

m(input)

返回:

tensor([[[[1.0000, 1.2500, 1.7500, 2.0000],

[1.5000, 1.7500, 2.2500, 2.5000],

[2.5000, 2.7500, 3.2500, 3.5000],

[3.0000, 3.2500, 3.7500, 4.0000]]]])

m = nn.Upsample(scale_factor=, mode='bilinear',align_corners=True)

m(input)

返回:

tensor([[[[1.0000, 1.3333, 1.6667, 2.0000],

[1.6667, 2.0000, 2.3333, 2.6667],

[2.3333, 2.6667, 3.0000, 3.3333],

[3.0000, 3.3333, 3.6667, 4.0000]]]])

m = nn.Upsample(size=(,), mode='bilinear',align_corners=True)

m(input)

返回:

tensor([[[[1.0000, 1.2500, 1.5000, 1.7500, 2.0000],

[2.0000, 2.2500, 2.5000, 2.7500, 3.0000],

[3.0000, 3.2500, 3.5000, 3.7500, 4.0000]]]])

如果你使用的数据都是JPG等图像数据,那么你就能够直接使用下面的用于2D数据的方法:

2)UpsamplingNearest2d

CLASS torch.nn.UpsamplingNearest2d(size=None, scale_factor=None)

专门用于2D数据的线性插值算法,参数等跟上面的差不多,省略

形状:

举例:

m = nn.UpsamplingNearest2d(scale_factor=)

m(input)

input即上面例子的input,返回:

tensor([[[[., ., ., .],

[., ., ., .],

[., ., ., .],

[., ., ., .]]]])

m = nn.UpsamplingNearest2d(size=(,))

m(input)

返回:

tensor([[[[., ., ., ., .],

[., ., ., ., .],

[., ., ., ., .]]]])

3)UpsamplingBilinear2d

CLASS torch.nn.UpsamplingBilinear2d(size=None, scale_factor=None)

专门用于2D数据的双线性插值算法,参数等跟上面的差不多,省略

形状:

注意:最好还是使用nn.functional.interpolate(..., mode='bilinear', align_corners=True)

举例:

m = nn.UpsamplingBilinear2d(scale_factor=)

m(input)

返回:

tensor([[[[1.0000, 1.3333, 1.6667, 2.0000],

[1.6667, 2.0000, 2.3333, 2.6667],

[2.3333, 2.6667, 3.0000, 3.3333],

[3.0000, 3.3333, 3.6667, 4.0000]]]])

m = nn.UpsamplingBilinear2d(size=(,))

m(input)

返回:

tensor([[[[1.0000, 1.2500, 1.5000, 1.7500, 2.0000],

[2.0000, 2.2500, 2.5000, 2.7500, 3.0000],

[3.0000, 3.2500, 3.5000, 3.7500, 4.0000]]]])

更复杂的例子可见:pytorch 不使用转置卷积来实现上采样

pytorch torch.nn 实现上采样——nn.Upsample的更多相关文章

- pytorch 不使用转置卷积来实现上采样

上采样(upsampling)一般包括2种方式: Resize,如双线性插值直接缩放,类似于图像缩放,概念可见最邻近插值算法和双线性插值算法——图像缩放 Deconvolution,也叫Transpo ...

- 上采样和PixelShuffle(转)

有些地方还没看懂, mark一下 文章来源: https://blog.csdn.net/g11d111/article/details/82855946 去年曾经使用过FCN(全卷积神经网络)及其派 ...

- pytorch torch.nn.functional实现插值和上采样

interpolate torch.nn.functional.interpolate(input, size=None, scale_factor=None, mode='nearest', ali ...

- PyTorch : torch.nn.xxx 和 torch.nn.functional.xxx

PyTorch : torch.nn.xxx 和 torch.nn.functional.xxx 在写 PyTorch 代码时,我们会发现一些功能重复的操作,比如卷积.激活.池化等操作.这些操作分别可 ...

- Pytorch——torch.nn.Sequential()详解

参考:官方文档 源码 官方文档 nn.Sequential A sequential container. Modules will be added to it in the order th ...

- 『PyTorch』第十三弹_torch.nn.init参数初始化

初始化参数的方法 nn.Module模块对于参数进行了内置的较为合理的初始化方式,当我们使用nn.Parameter时,初始化就很重要,而且我们也可以指定代替内置初始化的方式对nn.Module模块进 ...

- 上采样 及 Sub-pixel Convolution (子像素卷积)

参考:https://blog.csdn.net/leviopku/article/details/84975282 参考:https://blog.csdn.net/g11d111/article/ ...

- [源码解析] PyTorch 分布式(2) ----- DataParallel(上)

[源码解析] PyTorch 分布式(2) ----- DataParallel(上) 目录 [源码解析] PyTorch 分布式(2) ----- DataParallel(上) 0x00 摘要 0 ...

- 图像的下采样Subsampling 与 上采样 Upsampling

I.目的 缩小图像(或称为下采样(subsampled)或降采样(downsampled))的主要目的: 1.使得图像符合显示区域的大小: 2.生成对应图像的缩略图. 放大图像(或称为上采样(ups ...

随机推荐

- JavaScript和JQuery之战再续

之前写过关于JavaScript和Jquery的之间的比较,现在再看比较偏向于理论知识,还不是很理解.经过这一段时间的项目的锻炼,对JQuery有了新的认识. 原生JavaScript和jQuery的 ...

- 列举 Python2和Python3的区别?

1.print 在python2中,print被视为一个语句而不是一个函数,python3中,print()被视为一个函数 2.整数的除法 在python2中,键入的任何不带小数的数字,将被视为整数的 ...

- Vue模板语法(二)

Vue基础模板语法 二 1. 样式绑定 1.1 class绑定 使用方式:v-bind:class="expression" expression的类型:字符 ...

- 脚本安装redis

#!/bin/bash read -p 'input the version you want(like 5.0.5):' version read -p 'input redis password: ...

- js之大文件断点续传

文件夹上传:从前端到后端 文件上传是 Web 开发肯定会碰到的问题,而文件夹上传则更加难缠.网上关于文件夹上传的资料多集中在前端,缺少对于后端的关注,然后讲某个后端框架文件上传的文章又不会涉及文件夹. ...

- Linux 用户和用户组管理之 修改用户名和用户组;修改用户密码

一.用户账号包括(查看已经存在的账号 | 添加用户账号 | 修改用户账号 | 删除用户账号) 查看存在的账号: more /etc/passwd #或者是 awk -F':' '{ print $1 ...

- C函数指针数组的定义和使用

1.使用函数指针数组来实现计算器 2.通过函数指针变量来调用对应的函数 #include <stdio.h> int add(int a,int b){ return a+b; } int ...

- Comet OJ - Contest #8题解

传送门 \(A\) 咕咕咕 const int N=1005; char s[N][N];int len[N],n,id; inline bool cmp(R int j,R int k){ R in ...

- (3)Angular的开发

Angular CLI是一个命令行界面工具 创建项目.添加文件以及执行一大堆开发任务,比如测试.打包和发布 Angular CLI 功能与常用参数 使用Angular CLI 高效构建angular ...

- [golang]写了一个可以用 go 来写脚本的工具:gosl

转自:https://golangtc.com/t/53cca103320b52060a000030 写了一个可以用 go 来写脚本的工具:gosl 代码和使用说明可以看这里: http://gith ...