Requests+BeautifulSoup+正则表达式爬取猫眼电影Top100(名称,演员,评分,封面,上映时间,简介)

# encoding:utf-8

from requests.exceptions import RequestException

import requests

import re

import json

from multiprocessing import Pool def get_one_page(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.text

return None

except RequestException:

return None def parse_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?name"><a'

+'.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>'

+'.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>',re.S)

items = re.findall(pattern, html)

# print(items)

for item in items:

yield {

'index': item[0],

'image': item[1],

'title': item[2],

'actor': item[3].strip()[3:],

'time': item[4].strip()[5:],

'score': item[5]+item[6]

} def write_to_file(content):

with open('MaoyanTop100.txt', 'a', encoding='utf-8') as f:

f.write(json.dumps(content, ensure_ascii=False)+'\n')

f.close() def main(offset):

url = "http://maoyan.com/board/4?offset="+str(offset)

html = get_one_page(url)

# print(html)

# parse_one_page(html)

for item in parse_one_page(html):

print(item)

write_to_file(item) if __name__ == '__main__':

pool = Pool()

# for i in range(10):

# main(i*10)

# 加快效率

pool.map(main, [i*10 for i in range(10)])

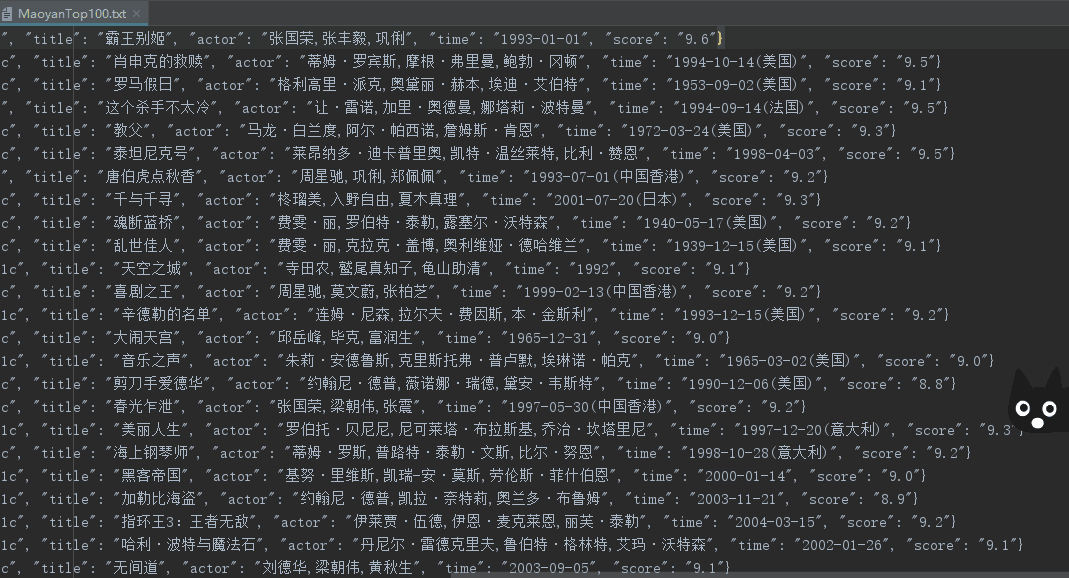

效果图:

更新(获取封面以及影片简介):

# encoding:utf-8

from requests.exceptions import RequestException

import requests

import json

import re

from urllib import request

from bs4 import BeautifulSoup def get_one_page(url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.text

return None

except RequestException:

return None def parse_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(\d+)</i>.*?href="(.*?)".*?data-src="(.*?)".*?name"><a'

+'.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>'

+'.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>',re.S)

items = re.findall(pattern, html)

# print(items)

for item in items:

yield {

'index': item[0],

'jump': item[1],

'image': item[2],

'title': item[3],

'actor': item[4].strip()[3:],

'time': item[5].strip()[5:],

'score': item[6]+item[7]

} def parse_summary_page(url):

# url = 'https://maoyan.com/films/1203'

head = {}

# 使用代理

head['User - Agent'] = 'User-Agent:Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.26 Safari/537.36 Core/1.63.6788.400 QQBrowser/10.3.2843.400'

req = request.Request(url, headers=head)

response = request.urlopen(req)

html = response.read()

# 创建request对象

soup = BeautifulSoup(html, 'lxml')

# 找出div中的内容

soup_text = soup.find('span', class_='dra')

# 输出其中的文本

# print(soup_text.text)

return soup_text def write_to_file(content):

with open('newMaoyanTop100.txt', 'a', encoding='utf-8') as f:

f.write(json.dumps(content, ensure_ascii=False)+'\n')

f.close() def main(offset):

url = "http://maoyan.com/board/4?offset="+str(offset*10)

html = get_one_page(url) for item in parse_one_page(html):

# print(item['number'])

# print(item['jump'])

jump_url = "https://maoyan.com"+str(item['jump'])

item['summary'] = str(parse_summary_page(jump_url)).replace("<span class=\"dra\">","").replace("</span>","")

print(item)

write_to_file(item) # 写txt

# for item in parse_one_page(html):

# write_to_file(item['title']) # 爬取100张图片

# path = 'E:\\myCode\\py_test\\MaoyanTop100\\images\\'

# for item in parse_one_page(html):

# urllib.request.urlretrieve(item['image'], '{}{}.jpg'.format(path, item['index'])) if __name__ == '__main__':

for i in range(10):

main(i)

Requests+BeautifulSoup+正则表达式爬取猫眼电影Top100(名称,演员,评分,封面,上映时间,简介)的更多相关文章

- requests和正则表达式爬取猫眼电影Top100练习

1 import requests 2 import re 3 from multiprocessing import Pool 4 from requests.exceptions import R ...

- python3.6 利用requests和正则表达式爬取猫眼电影TOP100

import requests from requests.exceptions import RequestException from multiprocessing import Pool im ...

- PYTHON 爬虫笔记八:利用Requests+正则表达式爬取猫眼电影top100(实战项目一)

利用Requests+正则表达式爬取猫眼电影top100 目标站点分析 流程框架 爬虫实战 使用requests库获取top100首页: import requests def get_one_pag ...

- 爬虫练习之正则表达式爬取猫眼电影Top100

#猫眼电影Top100import requests,re,timedef get_one_page(url): headers={ 'User-Agent':'Mozilla/5.0 (Window ...

- Requests+正则表达式爬取猫眼电影(TOP100榜)

猫眼电影网址:www.maoyan.com 前言:网上一些大神已经对猫眼电影进行过爬取,所用的方法也是各有其优,最终目的是把影片排名.图片.名称.主要演员.上映时间与评分提取出来并保存到文件或者数据库 ...

- Python爬虫实战之Requests+正则表达式爬取猫眼电影Top100

import requests from requests.exceptions import RequestException import re import json # from multip ...

- python爬虫从入门到放弃(九)之 Requests+正则表达式爬取猫眼电影TOP100

import requests from requests.exceptions import RequestException import re import json from multipro ...

- 整理requests和正则表达式爬取猫眼Top100中遇到的问题及解决方案

最近看崔庆才老师的爬虫课程,第一个实战课程是requests和正则表达式爬取猫眼电影Top100榜单.虽然理解崔老师每一步代码的实现过程,但自己敲代码的时候还是遇到了不少问题: 问题1:获取respo ...

- 14-Requests+正则表达式爬取猫眼电影

'''Requests+正则表达式爬取猫眼电影TOP100''''''流程框架:抓去单页内容:利用requests请求目标站点,得到单个网页HTML代码,返回结果.正则表达式分析:根据HTML代码分析 ...

随机推荐

- 利用Linux的硬连接删除MySQL大文件

利用Linux的硬连接删除MySQL大文件 http://blog.csdn.net/wxliu1989/article/details/22895201 原理:硬链接基础当多个文件共同指向同一ino ...

- Visual Studio使用Web Deploy远程发布网站及其配置

https://blog.csdn.net/yzj_xiaoyue/article/details/60574378 废话不多说,直接进入正题(各个步骤请看图片的序号): IIS配置 1.打开服务器 ...

- aop 日志统一处理

AOP是Aspect Oriented Programing的简称,面向切面编程.AOP适合于那些具有横切逻辑的应用:如性能监测,访问控制,事务管理.缓存.对象池管理以及日志记录.AOP将这些分散在各 ...

- distpicker省市区插件初始化选中值的问题

$('#distpicker1').distpicker('destroy') //当需要重新生成的时候,需要先销毁 $('#distpicker1').distpicker({ province: ...

- gerrit上的commit msg中关联jira单号(含gerrit的安装)

这个问题折腾了很久,前期后后大概一个月吧,终于搞定了,查了很多资料,有的不完整,有的完全就不能用,有的没说完整,所以一定要记录下来,我的心血啊. 由于公司在用的gerrit的是正式环境中的,大家都在使 ...

- 18-Python3 迭代器与生成器

2018-11-22 16:14:01 print('迭代器********************************************************************** ...

- [Java in NetBeans] Lesson 10. For Loops

这个课程的参考视频和图片来自youtube. 主要学到的知识点有:(the same use in C/C++) 1. x++, x += 1; similar x--, x -= 1; x *= 2 ...

- smali加入日志

const-string v0, "aaatag"const-string v1, "msg"invoke-static {v0,v1}, Landroid/u ...

- AIX挂载NFS写入效率低效解决

背景: Linux是NFS的Server端,AIX是NFS的Client端(此外,有一个Linux也作为Client端对比测试). 1.NFS对应的底层设备是闪存卡,本地测试I/O写性能可达2GB/s ...

- ProxySQL(读写分离)部署

proxySQL是MySQL的中间件产品,是灵活强大的代理层,实现读写分离,支持Query路由功能,支持动态指定某个SQL进行缓存,支持动态加载配置,故障切换和一些SQL 过滤功能 环境: 192.1 ...