股票数据定向爬虫.py(亲测有效)

import requests

from bs4 import BeautifulSoup

import traceback

import re def getHTMLText(url,code='utf-8'):

try:

r = requests.get(url,timeout=30)

r.encoding = code

return r.text

except:

return "" def getStockList(lst,stockURL):

html = getHTMLText(stockURL)

soup = BeautifulSoup(html,'html.parser')

a = soup.find_all('tr')

for i in a:

try:

href = i.attrs['id']

lst.append(re.findall(r'[tr]\d{6}',href)[0])

except:

continue def getStockInfo(lst,stockURL,fpath):

count = 0

for stock in lst:

url = stockURL + stock[1:] +".html"

html = getHTMLText(url)

try:

if html == "":

continue

infoDict = {}

soup = BeautifulSoup(html,'html.parser')

stockInfo = soup.find('div',attrs={'class':'merchandiseDetail'})

name = stockInfo.find_all(attrs={'class':'fundDetail-tit'})[0]

infoDict.update({'股票名称':name.text.split()[0]})

keylist = stockInfo.find_all('dt')

valuelist = stockInfo.find_all('dd')

for i in range(len(keylist)):

key = keylist[i].text

print(key)

val = valuelist[i].text

infoDict[key] = val

with open(fpath,'a',encoding='utf-8')as f:

f.write(str(infoDict)+'\n')

count = count+1

print('\r当前速度:{:.2f}%'.format(count*100/len(lst)),end='') except:

count = count + 1

print('\r当前速度:{:.2f}%'.format(count * 100 / len(lst)), end='')

traceback.print_exc()

continue def main():

stock_list_url = 'https://fund.eastmoney.com/fund.html#os_0;isall_0;ft_;pt_1'

stock_info_url = 'https://fund.eastmoney.com/'

output_file = 'D://桌面//BaiduStockInfo.txt'

slist = []

getStockList(slist,stock_list_url)

getStockInfo(slist,stock_info_url,output_file) main()

股票数据定向爬虫.py(亲测有效)的更多相关文章

- 股票数据Scrapy爬虫

功能描述: 技术路线:scrapy 目标:获取上交所和深交所所有股票的名称和交易信息 输出:保存到文件中 数据网站的确定 获取股票列表: 东方财富网:http://quote.eastmoney.co ...

- 爬虫之手机APP抓包教程-亲测HTTP和HTTPS均可实现

当下很多网站都有做自己的APP端产品,一个优秀的爬虫工程师,必须能够绕过难爬取点而取捷径,这是皆大欢喜的.但是在网上收罗和查阅了无数文档和资料,本人亲测无数次,均不能正常获取HTTPS数据,究其原因是 ...

- 实时获取股票数据,免费!——Python爬虫Sina Stock实战

更多精彩内容,欢迎关注公众号:数量技术宅,也可添加技术宅个人微信号:sljsz01,与我交流. 实时股票数据的重要性 对于四大可交易资产:股票.期货.期权.数字货币来说,期货.期权.数字货币,可以从交 ...

- python爬虫成长之路(一):抓取证券之星的股票数据

获取数据是数据分析中必不可少的一部分,而网络爬虫是是获取数据的一个重要渠道之一.鉴于此,我拾起了Python这把利器,开启了网络爬虫之路. 本篇使用的版本为python3.5,意在抓取证券之星上当天所 ...

- Python爬虫 股票数据爬取

前一篇提到了与股票数据相关的可能几种数据情况,本篇接着上篇,介绍一下多个网页的数据爬取.目标抓取平安银行(000001)从1989年~2017年的全部财务数据. 数据源分析 地址分析 http://m ...

- 使用python爬虫爬取股票数据

前言: 编写一个爬虫脚本,用于爬取东方财富网的上海股票代码,并通过爬取百度股票的单个股票数据,将所有上海股票数据爬取下来并保存到本地文件中 系统环境: 64位win10系统,64位python3.6, ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- MATLAB爬虫爬取股票数据

近年来,大数据盛行,有关爬虫的教程层次不穷.那么,爬虫到底是什么呢? 什么是爬虫? 百度百科是这样定义的: 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种 ...

- 本地ES集群数据通过_reindex方式迁移到腾讯云服务器(亲测有效)

本地ES集群数据通过_reindex方式迁移到腾讯云服务器(亲测有效) 随着业务量的增加,本地的ES集群服务器性能和磁盘空间有点不够使用,项目组考虑使用腾讯云服务器,以下是我测试的使用_reindex ...

- 【Python爬虫实战】Scrapy框架的安装 搬运工亲测有效

windows下亲测有效 http://blog.csdn.net/liuweiyuxiang/article/details/68929999这个我们只是正确操作步骤详解的搬运工

随机推荐

- 【APT】Bitter APT组织针对巴基斯坦航空综合部门攻击活动分析

前言 蔓灵花(Bitter)是一个被广泛认为来自印度的APT组织,该组织长期针对我国及巴基斯坦的政府.军工.电力.核等部门发动网络攻击,窃取敏感数据,具有较强的政治背景.本次分享一个蔓灵花组织针对巴基 ...

- C# 使用Enumerable.Range 打印数字

static void Main(string[] args) { var list1 = Enumerable.Range(0, (int)Math.Pow(2, 22)).ToList(); va ...

- vue实现按钮多选

需求是这样: 首先考虑使用elementui中的组建实现,但是有时候会忽略组建.实现方式两种: 1.直接使用element实现 let weekTimeData: [ '星期一', '星期二', '星 ...

- 修改tomcat启动时,修改默认访问的页面

在

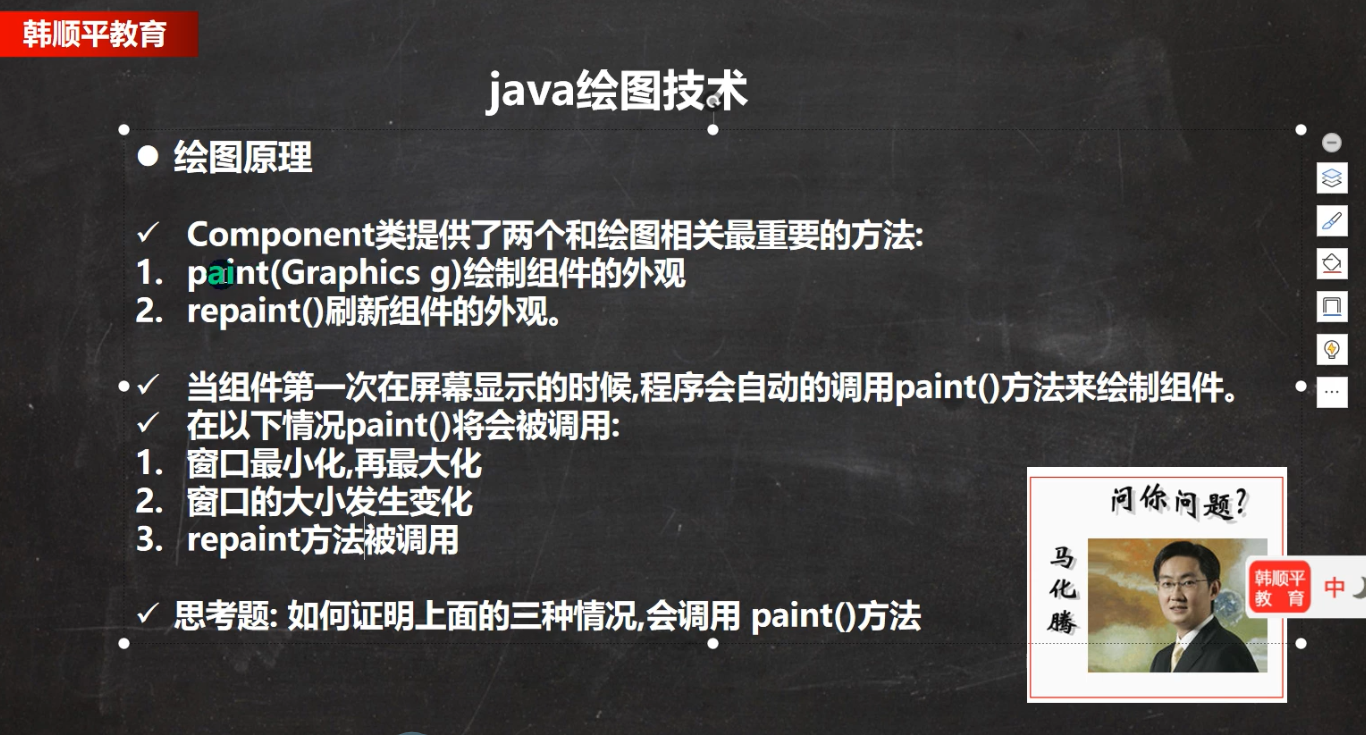

- java绘图技术

- win 子系统导入centos7

之前在应用商店安装过ubuntu的,有钱的建议从商店购买 window配置 , 准备一个centos系统,我是从已有系统导出的,导出命令 tar -cvf ./centos.tar ./ --excl ...

- XML_DTD_20200415

<!-- xml的注释写法 --> 格式良好的xml语言必须具备的几个条件 1.必须有xml声明语句,声明版本号与编码字符集 2.必须有且仅有一个根元素 3.标签大小写敏感 4.属性值 ...

- 安装 TensorFlow 参考过的资料

anaconda 的新环境创建 https://blog.csdn.net/yandajiangjun/article/details/102615912

- DevExpress 模块注入框架

参考地址 模块注入框架(MIF)是一组帮助MVVM应用程序的类.它提供以下功能 将ViewModel连接到视图 页面之间导航 保存和恢复应用程序的可视和逻辑状态 单元测试 模块 模块是应用程序的功能单 ...

- vue再请求头加token

Vue:全局拦截所有请求,并在请求头中添加token - 道祖且长 - 博客园 (cnblogs.com) util.js export function sessionSet(user){ let ...