K-means算法(理论+opencv实现)

写在前面:之前想分类图像的时候有看过k-means算法,当时一知半解的去使用,不懂原理不懂使用规则。。。显然最后失败了,然后看了《机器学习》这本书对k-means算法有了理论的认识,现在通过贾志刚老师的视频有了实际应用的理解。

k-means算法原理

注:还是和之前一样,核心都是别人的,我只是知识的搬运工并且加上了自己的理解。弄完之后发现理论部分都是别人的~~没办法这算法太简单了。。。

k-means含义:无监督的聚类算法。

无监督:就是不需要人干预,拿来一大批东西直接放进算法就可以进行分类。SVM和神经网络都是需要提前训练好然后再进行分类这样就是监督学习。而k-means和K近邻都是无监督学习。

聚类:通过一个中心聚在一起的分类,比如给你一批数据让你分成三类,那就是三个中心,那这三个中心代表的意思就是三个类。

k-means步骤:

这个算法其实很简单,如下图所示: (这里直接复制别人步骤,说的很明白了)

从上图中,我们可以看到,A,B,C,D,E是五个在图中点。而灰色的点是我们的种子点,也就是我们用来找点群的点。有两个种子点,所以K=2。

然后,K-Means的算法如下:

- 随机在图中取K(这里K=2)个种子点。

- 然后对图中的所有点求到这K个种子点的距离,假如点Pi离种子点Si最近,那么Pi属于Si点群。(上图中,我们可以看到A,B属于上面的种子点,C,D,E属于下面中部的种子点)

- 接下来,我们要移动种子点到属于他的“点群”的中心。(见图上的第三步)

- 然后重复第2)和第3)步,直到,种子点没有移动(我们可以看到图中的第四步上面的种子点聚合了A,B,C,下面的种子点聚合了D,E)。

这个算法很简单,但是有些细节我要提一下,求距离的公式我不说了,大家有初中毕业水平的人都应该知道怎么算的。我重点想说一下“求点群中心的算法”。

求点群中心的算法

一般来说,求点群中心点的算法你可以很简的使用各个点的X/Y坐标的平均值。不过,我这里想告诉大家另三个求中心点的的公式:

1)Minkowski Distance公式——λ可以随意取值,可以是负数,也可以是正数,或是无穷大。

2)Euclidean Distance公式——也就是第一个公式λ=2的情况

3)CityBlock Distance公式——也就是第一个公式λ=1的情况

k-means的缺点:

① 在 K-means 算法中 K 是事先给定的,这个 K 值的选定是非常难以估计的。很多时候,事先并不知道给定的数据集应该分成多少个类别才最合适。这也是 K-means 算法的一个不足。

② 在 K-means 算法中,首先需要根据初始聚类中心来确定一个初始划分,然后对初始划分进行优化。这个初始聚类中心的选择对聚类结果有较大的影响,一旦初始值选择的不好,可能无法得到有效的聚类结果,这也成为 K-means算法的一个主要问题。

③ 从 K-means 算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大的。

opencv+K-means

没什么好写的,因为这个k-means比较简单,主要说的就是函数参数的应用而已:

void RNG::fill(InputOutputArray mat, int distType, InputArray a, InputArray b, bool saturateRange=false )

这个函数是对矩阵mat填充随机数,随机数的产生方式有参数2来决定,如果为参数2的类型为RNG::UNIFORM,则表示产生均一分布的随机数,如果为RNG::NORMAL则表示产生高斯分布的随机数。对应的参数3和参数4为上面两种随机数产生模型的参数。比如说如果随机数产生模型为均匀分布,则参数a表示均匀分布的下限,参数b表示上限。如果随机数产生模型为高斯模型,则参数a表示均值,参数b表示方程。参数5只有当随机数产生方式为均匀分布时才有效,表示的是是否产生的数据要布满整个范围(没用过,所以也没仔细去研究)。另外,需要注意的是用来保存随机数的矩阵mat可以是多维的,也可以是多通道的,目前最多只能支持4个通道。

void randShuffle(InputOutputArray dst, double iterFactor=1., RNG* rng=0 )

该函数表示随机打乱1D数组dst里面的数据,随机打乱的方式由随机数发生器rng决定。iterFactor为随机打乱数据对数的因子,总共打乱的数据对数为:dst.rows*dst.cols*iterFactor,因此如果为0,表示没有打乱数据。

Class TermCriteria

类TermCriteria 一般表示迭代终止的条件,如果为CV_TERMCRIT_ITER,则用最大迭代次数作为终止条件,如果为CV_TERMCRIT_EPS 则用精度作为迭代条件,如果为CV_TERMCRIT_ITER+CV_TERMCRIT_EPS则用最大迭代次数或者精度作为迭代条件,看哪个条件先满足。

double kmeans(InputArray data, int K, InputOutputArray bestLabels, TermCriteria criteria, int attempts, int flags, OutputArray centers=noArray() )

该函数为kmeans聚类算法实现函数。参数data表示需要被聚类的原始数据集合,一行表示一个数据样本,每一个样本的每一列都是一个属性;参数k表示需要被聚类的个数;参数bestLabels表示每一个样本的类的标签,是一个整数,从0开始的索引整数;参数criteria表示的是算法迭代终止条件;参数attempts表示运行kmeans的次数,取结果最好的那次聚类为最终的聚类,要配合下一个参数flages来使用;参数flags表示的是聚类初始化的条件。其取值有3种情况,如果为KMEANS_RANDOM_CENTERS,则表示为随机选取初始化中心点,如果为KMEANS_PP_CENTERS则表示使用某一种算法来确定初始聚类的点;如果为KMEANS_USE_INITIAL_LABELS,则表示使用用户自定义的初始点,但是如果此时的attempts大于1,则后面的聚类初始点依旧使用随机的方式;参数centers表示的是聚类后的中心点存放矩阵。该函数返回的是聚类结果的紧凑性,其计算公式为:

注意点一:

这是说个我自己不理解的地方:fill(InputOutputArray mat, int distType, InputArray a, InputArray b, bool saturateRange=false )

这里的InputArray a, InputArray b------>>>分别用了Scalar(center.x, center.y, 0, 0), Scalar(img.cols*0.05, img.rows*0.05, 0, 0)去替换

去查了一下手册:InputArray这个接口类可以是Mat、Mat_<T>、Mat_<T, m, n>、vector<T>、vector<vector<T>>、vector<Mat>。没有提到Scalar()可以使用

特意定义了一个:InputArray test = Scalar(1,1);这个又是可以的,定义Mat不行,Vector也不行,这个真的不知道什么原因,有时间得去看源码a,b的使用。

//----下面的定义都是错误的,运行的结果都不对,原因暂时不知道

Mat a = (Mat_<uchar>(, ) << center.x, center.y);

Mat b = (Mat_<uchar>(, ) << img.cols*0.05, img.rows*0.05); InputArray a1 = Scalar(center.x, center.y);

InputArray b1 = Scalar(img.cols*0.05, img.rows*0.05);

Mat a2 = a1.getMat();

Mat b2 = b1.getMat(); Mat c(, , CV_8UC1);

c = Scalar(center.x, center.y);

Mat c1(, , CV_8UC1);

c1 = Scalar(img.cols*0.05, img.rows*0.05); rng.fill(pointChunk, RNG::NORMAL, a, b, );

注意点二:

kmeans()函数的输入只接受 data0.dims <= 2 && type == CV_32F && K > 0 ,

第一个dims一般都不会越界(三维不行)

第二个参数CV_32F == float,千万别带入CV_8U == uchar

第三个参数不用说了,设置的种类肯定是大于0的

注意点三:

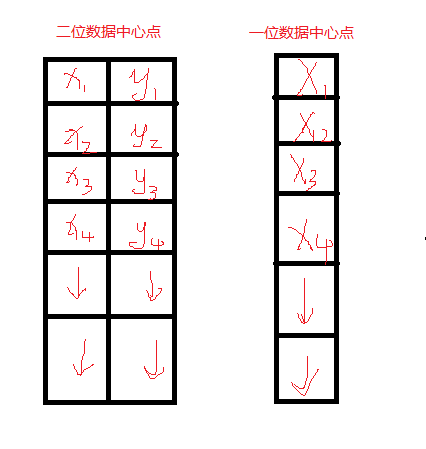

opencv里面k-means函数的样本数据、标签、中心点的存储:

这是正确的代码:(聚类)

#include <opencv2/opencv.hpp>

#include <iostream> using namespace cv;

using namespace std; int main(int argc, char** argv) {

Mat img(, , CV_8UC3);

RNG rng();

const int Max_nCluster = ;

Scalar colorTab[] = {

Scalar(, , ),

Scalar(, , ),

Scalar(, , ),

Scalar(, , ),

Scalar(, , )

};

//InputArray a = Scalar(1,1);

int numCluster = rng.uniform(, Max_nCluster + );//随机类数

int sampleCount = rng.uniform(, );//样本点数量

Mat matPoints(sampleCount, , CV_32FC2);//样本点矩阵:sampleCount X 2

Mat labels;

Mat centers; // 生成随机数

for (int k = ; k < numCluster; k++) {

Point center;//随机产生中心点

center.x = rng.uniform(, img.cols);

center.y = rng.uniform(, img.rows);

Mat pointChunk = matPoints.rowRange( k*sampleCount / numCluster,

(k + )*sampleCount / numCluster);

//-----这句话的意思我不明白作用是什么,没意义啊!

/*Mat pointChunk = matPoints.rowRange(k*sampleCount / numCluster,

k == numCluster - 1 ? sampleCount : (k + 1)*sampleCount / numCluster);*/

//-----符合高斯分布的随机高斯

rng.fill(pointChunk, RNG::NORMAL, Scalar(center.x, center.y, , ), Scalar(img.cols*0.05, img.rows*0.05, , ));

}

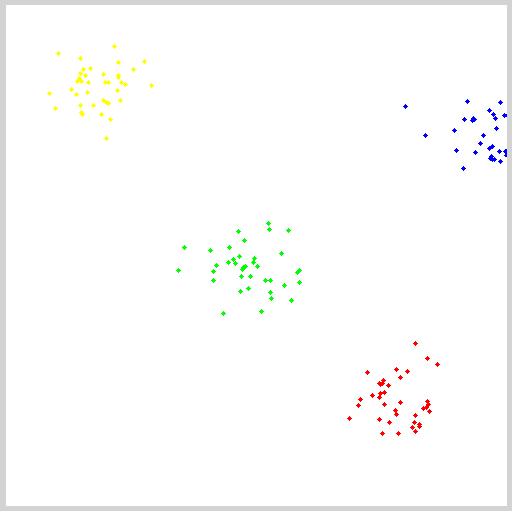

randShuffle(matPoints, , &rng);//打乱高斯生成的数据点顺序 // 使用KMeans

kmeans(matPoints, numCluster, labels, TermCriteria(TermCriteria::EPS + TermCriteria::COUNT, , 0.1), , KMEANS_PP_CENTERS, centers); // 用不同颜色显示分类

img = Scalar::all();

for (int i = ; i < sampleCount; i++) {

int index = labels.at<int>(i);

Point p = matPoints.at<Point2f>(i);

circle(img, p, , colorTab[index], -, );

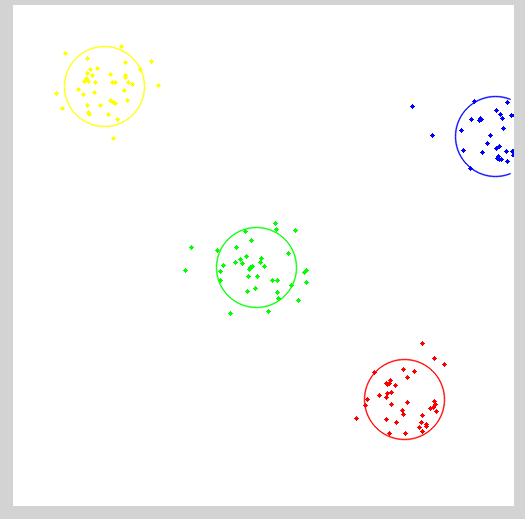

} // 每个聚类的中心来绘制圆

for (int i = ; i < centers.rows; i++) {

int x = centers.at<float>(i, );

int y = centers.at<float>(i, );

printf("c.x= %d, c.y=%d", x, y);

circle(img, Point(x, y), , colorTab[i], , LINE_AA);

} imshow("KMeans-Data-Demo", img);

waitKey();

return ;

}

分类代码:

#include <opencv2/opencv.hpp>

#include <iostream> using namespace cv;

using namespace std; RNG rng();

const int Max_nCluster = ; int main(int argc, char** argv) {

//Mat img(500, 500, CV_8UC3);

Mat inputImage = imread("1.jpg");

assert(!inputImage.data);

Scalar colorTab[] = {

Scalar(, , ),

Scalar(, , ),

Scalar(, , ),

Scalar(, , ),

Scalar(, , )

};

Mat matData = Mat::zeros(Size(inputImage.channels(), inputImage.rows*inputImage.cols), CV_32FC1);

int ncluster = ; //rng.uniform(2, Max_nCluster + 1);//聚类数量

Mat label;//聚类标签

Mat centers(ncluster, , matData.type());

for (size_t i = ; i < inputImage.rows; i++)//把图像存储到样本容器

{

uchar* ptr = inputImage.ptr<uchar>(i);

for (size_t j = ; j < inputImage.cols; j++)

{

matData.at<float>(i*inputImage.cols + j, ) = ptr[j*inputImage.channels()];

matData.at<float>(i*inputImage.cols + j, ) = ptr[j*inputImage.channels() +];

matData.at<float>(i*inputImage.cols + j, ) = ptr[j*inputImage.channels() +];

}

}

Mat result = Mat::zeros(inputImage.size(), inputImage.type());

TermCriteria criteria = TermCriteria(TermCriteria::EPS + TermCriteria::COUNT, , 0.1);

kmeans(matData, ncluster, label, criteria, , KMEANS_PP_CENTERS, centers);

for (size_t i = ; i < inputImage.rows; i++)

{

for (size_t j = ; j < inputImage.cols; j ++)

{

int index = label.at<int>(i*inputImage.cols + j,);

result.at<Vec3b>(i, j)[] = colorTab[index][];

result.at<Vec3b>(i, j)[] = colorTab[index][];

result.at<Vec3b>(i, j)[] = colorTab[index][];

}

}

imshow("", result);

waitKey();

return ;

}

参考: 百度百科

http://www.cnblogs.com/jerrylead/archive/2011/04/06/2006910.html

http://coolshell.cn/articles/7779.html(讲的太好了)

http://www.xuebuyuan.com/414264.html(代码的解释来自这里)

贾老师课程(如果一点不懂得可以看看)

K-means算法(理论+opencv实现)的更多相关文章

- KNN 与 K - Means 算法比较

KNN K-Means 1.分类算法 聚类算法 2.监督学习 非监督学习 3.数据类型:喂给它的数据集是带label的数据,已经是完全正确的数据 喂给它的数据集是无label的数据,是杂乱无章的,经过 ...

- 分水岭算法(理论+opencv实现)

分水岭算法理论 从意思上就知道通过用水来进行分类,学术上说什么基于拓扑结构的形态学...其实就是根据把图像比作一副地貌,然后通过最低点和最高点去分类! 原始的分水岭: 就是上面说的方式,接下来用一幅图 ...

- K-means算法

K-means算法很简单,它属于无监督学习算法中的聚类算法中的一种方法吧,利用欧式距离进行聚合啦. 解决的问题如图所示哈:有一堆没有标签的训练样本,并且它们可以潜在地分为K类,我们怎么把它们划分呢? ...

- 从K近邻算法谈到KD树、SIFT+BBF算法

转自 http://blog.csdn.net/v_july_v/article/details/8203674 ,感谢july的辛勤劳动 前言 前两日,在微博上说:“到今天为止,我至少亏欠了3篇文章 ...

- 从K近邻算法、距离度量谈到KD树、SIFT+BBF算法

转载自:http://blog.csdn.net/v_july_v/article/details/8203674/ 从K近邻算法.距离度量谈到KD树.SIFT+BBF算法 前言 前两日,在微博上说: ...

- <转>从K近邻算法、距离度量谈到KD树、SIFT+BBF算法

转自 http://blog.csdn.net/likika2012/article/details/39619687 前两日,在微博上说:“到今天为止,我至少亏欠了3篇文章待写:1.KD树:2.神经 ...

- 分类算法----k近邻算法

K最近邻(k-Nearest Neighbor,KNN)分类算法,是一个理论上比较成熟的方法,也是最简单的机器学习算法之一.该方法的思路是:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的 ...

- [转]K近邻算法

什么是K近邻算法 何谓K近邻算法,即K-Nearest Neighbor algorithm,简称KNN算法,单从名字来猜想,可以简单粗暴的认为是:K个最近的邻居,当K=1时,算法便成了最近邻算法,即 ...

- 机器学习:k-NN算法(也叫k近邻算法)

一.kNN算法基础 # kNN:k-Nearest Neighboors # 多用于解决分裂问题 1)特点: 是机器学习中唯一一个不需要训练过程的算法,可以别认为是没有模型的算法,也可以认为训练数据集 ...

- 【机器学习】k近邻算法(kNN)

一.写在前面 本系列是对之前机器学习笔记的一个总结,这里只针对最基础的经典机器学习算法,对其本身的要点进行笔记总结,具体到算法的详细过程可以参见其他参考资料和书籍,这里顺便推荐一下Machine Le ...

随机推荐

- ADC内设与外设的区别

ADCCLK最大等于14,采样周期为1.5. ADC分两个通道组:规则通道组和注入通道组.规矩通道组就相当于正常运行,而注入通道就相当于中断. ADC为模数转换,而DAC则为数模转换.在芯片引脚中,所 ...

- CTF之常见的两种关于word的信息隐藏技术

一.利用word本身自带的文字隐藏功能 1.在word中输入文字 2.选中文字,单击右键,选择字体选项 3.单击字体选项后,单击隐藏,确定 查找隐藏信息 1.单击左上角WPS文字后,选择选项按钮单击 ...

- Springboot集成mybatis(mysql),mail,mongodb,cassandra,scheduler,redis,kafka,shiro,websocket

https://blog.csdn.net/a123demi/article/details/78234023 : Springboot集成mybatis(mysql),mail,mongodb,c ...

- ruby -检查json数据类型

HashObj={","language"=>"zh","make"=>"Apple"," ...

- 转 Katana 项目入门

Katana 项目入门 Howard Dierking 当 ASP.NET 首次在 2002 年发布时,时代有所不同. 那时,Internet 仍处于起步阶段,大约有 5.69 亿用户,每个用户平均每 ...

- uml建模工具介绍

应用最广的由两种种1. Rational Rose,它是ibm的 .2.Microsoft的 Microsoft Office Visio® 2003 3.Enterprise Architect.还 ...

- sed 给文件每行末尾追加相同字符

给文件file1每行末尾追加字符 ; sed 's/$/;/' file1

- mysql 官方docker镜像使用教程

首先是pull image,这里我拉取的是5.x版本最新版: docker pull mysql:5 拉下来以后大可以按照官方的说明无脑启动,但是外部无法访问,所以绑定端口:docker run -- ...

- POJ2127 LICS模板

题目:http://poj.org/problem?id=2127 十分费劲地终于记录好了路径……用一个前驱. 这是 n^2 的LICS方法.其实就是 n ^ 2 log n 把“找之前的d [ j ...

- MongoDB配置成系统服务(Win)

bin同级目录下创建文件夹data 进入data创建文件夹db和文件夹logs 进入logs创建文件mongo.log 以管理员权限打开cmd,进入mongo的bin目录下执行命令: mongod - ...