十三:Transparent Encryption in HDFS(转)

透明加密:http://blog.csdn.net/linlinv3/article/details/44963429

hadoop透明加密 kms

HDFS 实现透明,端到端加密。配置完成后,用户往hdfs上存储数据的时候,无需用户做任何程序代码的更改(意思就是调用KeyProvider API ,用于在数据存入到HDFS上面的时候进行数据加密,解密的过程一样)。这意味着数据加密和解密由客户端完成的。HDFS 不会存储或访问未加密的数据或数据加密密钥(由kms管理)。

连接地址:

背景介绍

- 应用程序级加密。这是最安全、最灵活的方法。应用程序最终控制是什么加密,可以准确地反映用户的需求。然而,编写应用程序这样做是很难的。这也不是一个选择为客户现有的应用程序不支持加密。

- 数据库级加密。类似的应用程序级加密的属性。大多数数据库厂商提供某种形式的加密。然而,可能有性能问题。一个例子是,索引不能加密。

- 文件系统级进行加密。该选项提供了高性能、应用程序透明,通常容易部署。但是,它无法模型应用程序级别的一些政策。例如,多租户应用程序基于最终用户可能想要加密。一个数据库可能需要不同的加密设置每一列存储在单个文件中。

- 磁盘级别加密。容易部署和高性能,但也很不灵活。

配置

<!-- KMS Backend KeyProvider -->

<property>

<name>hadoop.kms.key.provider.uri</name>

<value>jceks://file@/${user.home}/kms.keystore</value>

<description>

URI of the backing KeyProvider for the KMS.

</description>

</property>

<property>

<name>hadoop.security.keystore.java-keystore-provider.password-file</name>

<value>kms.keystore</value>

<description>

If using the JavaKeyStoreProvider, the password for the keystore file.

</description>

</property>

<!-- KMS Cache -->

<property>

<name>hadoop.kms.cache.enable</name>

<value>true</value>

<description>

Whether the KMS will act as a cache for the backing KeyProvider.

When the cache is enabled, operations like getKeyVersion, getMetadata,

and getCurrentKey will sometimes return cached data without consulting

the backing KeyProvider. Cached values are flushed when keys are deleted

or modified.

</description>

</property> <property>

<name>hadoop.kms.cache.timeout.ms</name>

<value>600000</value>

<description>

Expiry time for the KMS key version and key metadata cache, in

milliseconds. This affects getKeyVersion and getMetadata.

</description>

</property> <property>

<name>hadoop.kms.current.key.cache.timeout.ms</name>

<value>30000</value>

<description>

Expiry time for the KMS current key cache, in milliseconds. This

affects getCurrentKey operations.

</description>

</property>

Audit logs are aggregated for API accesses to the GET_KEY_VERSION, GET_CURRENT_KEY, DECRYPT_EEK, GENERATE_EEK operations.

<!-- KMS Audit -->

<property>

<name>hadoop.kms.audit.aggregation.window.ms</name>

<value>10000</value>

<description>

Duplicate audit log events within the aggregation window (specified in

ms) are quashed to reduce log traffic. A single message for aggregated

events is printed at the end of the window, along with a count of the

number of aggregated eventsfu.

</description>

</property>

<!-- KMS Security --> <property>

<name>hadoop.kms.authentication.type</name>

<value>simple</value>

<description>

Authentication type for the KMS. Can be either "simple"

or "kerberos".

</description>

</property>

- KMS_HTTP_PORT

- KMS_ADMIN_PORT

- KMS_MAX_THREADS

- KMS_LOG

export KMS_LOG=${KMS_HOME}/logs/kms

export KMS_HTTP_PORT=16000

export KMS_ADMIN_PORT=16001

/etc/hadoop/conf/hdfs-site.xml

<property>

<name>dfs.encryption.key.provider.uri</name>

<value>kms://http@localhost:16000/kms</value>

</property>

/etc/hadoop/confcore-site.xml

<property>

<name>hadoop.security.key.provider.path</name>

<value>kms://http@localhost:16000/kms</value>

</property>

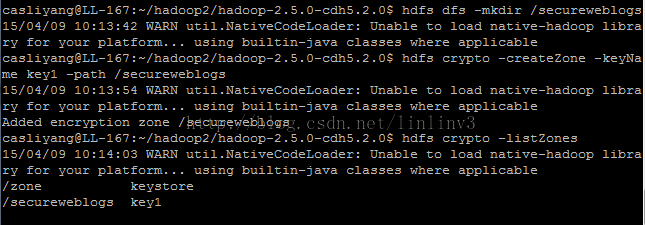

# su - hdfs

# hadoop key create key1

# hadoop key list -metadata

# hdfs dfs -mkdir /secureweblogs

# hdfs crypto -createZone -keyName key1 -path /secureweblogs

# hdfs crypto -listZones

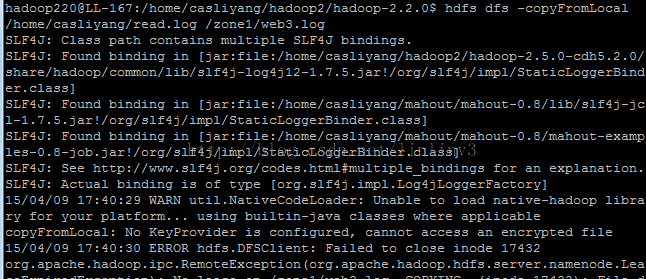

实验结果:

补充说明:

生成秘钥 keytool -delete -alias 'kms.keystore'; 删除别名为kms.keystore的秘钥keytool -genkey -alias 'kms.keystore'; 生成 别名为kms.keystore的秘钥使用生成秘钥的命令后,会在用户根目录下生成相应的文件

hdfs dfs -cat /.reserved/raw/zone1/localfile.dat zone1 是加密区 localfile.dat 是加密文件 ,查看该文件 显示的是被加密的文件(乱码);

十三:Transparent Encryption in HDFS(转)的更多相关文章

- hadoop2.6.0汇总:新增功能最新编译 32位、64位安装、源码包、API下载及部署文档

相关内容: hadoop2.5.2汇总:新增功能最新编译 32位.64位安装.源码包.API.eclipse插件下载Hadoop2.5 Eclipse插件制作.连接集群视频.及hadoop-eclip ...

- 安装部署Apache Hadoop (本地模式和伪分布式)

本节内容: Hadoop版本 安装部署Hadoop 一.Hadoop版本 1. Hadoop版本种类 目前Hadoop发行版非常多,有华为发行版.Intel发行版.Cloudera发行版(CDH)等, ...

- 【转载 Hadoop&Spark 动手实践 2】Hadoop2.7.3 HDFS理论与动手实践

简介 HDFS(Hadoop Distributed File System )Hadoop分布式文件系统.是根据google发表的论文翻版的.论文为GFS(Google File System)Go ...

- [HDFS Manual] CH3 HDFS Commands Guide

HDFS Commands Guide HDFS Commands Guide 3.1概述 3.2 用户命令 3.2.1 classpath 3.2.2 dfs 3.2.3 envvars 3.2.4 ...

- 从零自学Hadoop(12):Hadoop命令中

阅读目录 序 HDFS Commands User Commands Administration Commands Debug Commands 引用 系列索引 本文版权归mephisto和博客园共 ...

- HBASE 基础命令总结

HBASE基础命令总结 一,概述 本文中介绍了hbase的基础命令,作者既有记录总结hbase基础命令的目的还有本着分享的精神,和广大读者一起进步.本文的hbase版本是:HBase 1.2.0-cd ...

- 【大数据系列】hadoop命令指导官方文档翻译

Hadoop Commands Guide Overview Shell Options Generic Options User Commands archive checknative class ...

- Rootkit Hacking Technology && Defence Strategy Research

目录 . The Purpose Of Rootkit . Syscall Hijack . LKM Module Hidden . Network Communication Hidden . Fi ...

- OCP读书笔记(27) - 题库(ExamG)

601.You need to perform a block media recovery on the tools01.dbf data file in the SALES database by ...

随机推荐

- linux chrom 系统无法读取用户偏好配置无需删除.config配置文件

鬼使神差的使用了root权限启用了一下浏览器,再次打开就出现了这样的状况. 百度搜索了一下解决方案 几乎都是同一篇 需要删除/.config/google-chrome文件 才能正常启动. 那么如 ...

- Leecode刷题之旅-C语言/python-169求众数

/* * @lc app=leetcode.cn id=169 lang=c * * [169] 求众数 * * https://leetcode-cn.com/problems/majority-e ...

- IA64与x86-64的区别

win7 sp1下载地址:https://download.microsoft.com/download/0/A/F/0AFB5316-3062-494A-AB78-7FB0D4461357/wind ...

- linux 命令绿色安装

有些电脑不能联网,软件不能使用 apt-get 或 dnf . 从已安装的机器上拷贝命令到这台机器上就可以.设想. **** 以 tree 命令为例: **先从联网的机器上安装 apt-get ins ...

- 04IP编址(网络层)

帧中type为0x0800,送给ip ip报文结构 TTL 生存时间最大为255,经过三层设备就减1 protocol:协议号 version:4,6 source ip address:源ip编 ...

- 为什么我要放弃javaScript数据结构与算法(第九章)—— 图

本章中,将学习另外一种非线性数据结构--图.这是学习的最后一种数据结构,后面将学习排序和搜索算法. 第九章 图 图的相关术语 图是网络结构的抽象模型.图是一组由边连接的节点(或顶点).学习图是重要的, ...

- 钓鱼 洛谷p1717

题目描述 话说发源于小朋友精心设计的游戏被电脑组的童鞋们藐杀之后非常不爽,为了表示安慰和鼓励,VIP999决定请他吃一次“年年大丰收”,为了表示诚意,他还决定亲自去钓鱼,但是,因为还要准备2013NO ...

- 在同一台机器上启动多个tomcat服务(转)

转载:https://blog.csdn.net/wangxy799/article/details/53957770 1.案例:配置一台机上配置三个Tomcat 2.方法1:[只用修改第一个以外To ...

- 长沙Uber优步司机奖励政策(1月11日~1月17日)

滴快车单单2.5倍,注册地址:http://www.udache.com/ 如何注册Uber司机(全国版最新最详细注册流程)/月入2万/不用抢单:http://www.cnblogs.com/mfry ...

- C#中Mutex的用法

C#中Mutex是互斥锁,位于System.Threading 命名空间中. 顾名思义,它是一个互斥的对象,同一时间只有一个线程可以拥有它,该类还可用于进程间同步的同步基元. 如果当前有一个线程拥有它 ...