10分钟入门spark

Spark是硅谷各大公司都在使用的当红炸子鸡,而且有愈来愈热的趋势,所以大家很有必要了解学习这门技术。本文其实是笔者深入浅出hadoop系列的第三篇,标题里把hadoop去掉了因为spark可以不依赖于Hadoop。Spark可以运行在多种持久化系统之上,比如HDFS, Amazon S3, Azure Storage, Cassandra, Kafka。把深入浅出去掉了是因为Spark功能实在太强大(Spark SQL, Spark Streaming, Spark GraphX, Spark MLlib),本文只能抛砖引玉帮大家节省时间入个门,打算以后分专题深入总结一下sql, graph, streaming和machine learning方面的应用。

Spark History

- 2009 project started at UC berkeley's AMP lab

- 2012 first release (0.5)

- 2014 became top level apache project

- 2014 1.0

- 2015 1.5

- 2016 2.0

Spark 起源

map reduce以及之前系统存在的问题

- cluster memory 没有被有效运用

- map reduce重复冗余使用disk I/O,比如前一个job的output存在硬盘中,然后作为下一个job的input,这部分disk I/O如果都在内存中是可以被节省下来的。这一点在ad hoc query上尤为突出,会产生大量的中间文件,而且completion time比中间文件的durability要更为重要。

- map reduce的job要不停重复的做join,算法写起来要不停的tuning很蛋疼。

- 没有一个一站式解决方案,往往需要好几个系统比如mapreduce用来做batch processing,storm用来做stream processing,elastic search用来做交互式exploration。这就造成了冗余的data copy。

- interactive query和stream processing的需求越来越大,比如需要ad hoc analytics和快速的decision-making

- machine learning的需求越来越多

spark的破解方案

- RDD abstraction with rich API

- 充分使用内存

- 一站式提供Spark SQL, Spark Streaming, Spark GraphX, Spark MLlib

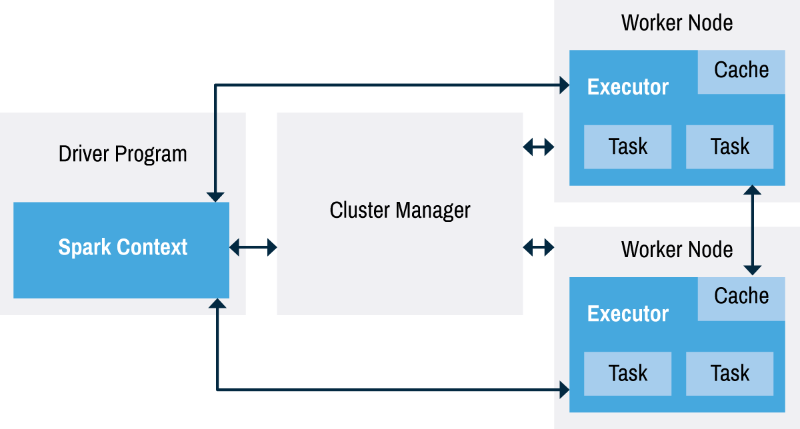

spark 架构

cluster manager: manage to execute tasks could be spark's standalone cluster manager, YARN(参见我之前讲mapreduce的文章) or Mesos。可以用来track当前可用的资源。

Spark applications包括driver process和若干executor processes。driver process是整个spark app的核心,运行main() function, 维护spark application的信息,响应用户输入,分析,distribute并且schedule work across executors。executors用来执行driver分配给它们的task,并把computation state report back to driver。

pyspark 安装

最简单的方式就是在如下地址下载tar包:

https://spark.apache.org/downloads.html

命令行运行:

$ export PYSPARK_PYTHON=python3

$ ./bin/pyspark

Python 3.6.4 (default, Jan 6 2018, 11:51:15)

[GCC 4.2.1 Compatible Apple LLVM 9.0.0 (clang-900.0.39.2)] on darwin

。。。

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/__ / .__/\_,_/_/ /_/\_\ version 2.2.1

/_/ Using Python version 3.6.4 (default, Jan 6 2018 11:51:15)

SparkSession available as 'spark'.

setup:

python setup.py install

导入

from pyspark import SparkConf, SparkContext

RDDs (Resilient Distributed Datasets)

- Resilient: able to withstand failures

- Distributed: spanning across multiple machines

- read-only, partitioned collection of records

RDD 在最新的spark2.x中有逐渐被淡化的趋势,是曾经的主角,现在算作low level API,基本不太可能在生产实践中用到,但是有助于理解spark。新型的RDD需要实现如下接口

- partitions()

- iterator(p: Partition)

- dependencies()

- optional: partitioner for key-value RDD (E.g. RDD is hash-partitioned)

从local collection中创建RDD

>>> mycollection = "Spark Qing Ge Guide : Big Data Processing Made Simple".split(" ")

>>> words = spark.sparkContext.parallelize(mycollection, 2)

>>> words.setName("myWords")

myWords ParallelCollectionRDD[35] at parallelize at PythonRDD.scala:489

>>> words.name()

'myWords'

transformations

distinct:

>>> words.distinct().count()

[Stage 23:> (0 + 0) / 2]

10

filter:

>>> words.filter(lambda word: startsWithS(word)).collect()

['Spark', 'Simple']

map:

>>> words2 = words.map(lambda word: (word, word[0], word.startswith("S")))

>>> words2.filter(lambda record: record[2]).take(5)

[('Spark', 'S', True), ('Simple', 'S', True)]

flatmap:

>>> words.flatMap(lambda word: list(word)).take(5)

['S', 'p', 'a', 'r', 'k']

sort:

>>> words.sortBy(lambda word: len(word) * -1).take(5)

['Processing', 'Simple', 'Spark', 'Guide', 'Qing']

Actions

reduce:

>>> spark.sparkContext.parallelize(range(1,21)).reduce(lambda x, y : x+y)

210

count:

>>> words.count()

10

first:

>>> words.first()

'Spark'

max and min:

>>> spark.sparkContext.parallelize(range(1,21)).max()

20

>>> spark.sparkContext.parallelize(range(1,21)).min()

1

take:

>>> words.take(5)

['Spark', 'Qing', 'Ge', 'Guide', ':']

注意:spark uses lazy transformation, 上文提到的所有transformation都只有在action时才会被调用。

Saving files

>>> words.saveAsTextFile("file:/tmp/words")

$ ls /tmp/words/

_SUCCESS part-00000 part-00001

$ cat /tmp/words/part-00000

Spark

Qing

Ge

Guide

:

$ cat /tmp/words/part-00001

Big

Data

Processing

Made

Simple

Caching

>>> words.cache()

myWords ParallelCollectionRDD[35] at parallelize at PythonRDD.scala:489

options include: memory only(default), disk only, both

CoGroups

>>> import random

>>> distinctChars = words.flatMap(lambda word: word.lower()).distinct()

>>> charRDD = distinctChars.map(lambda c: (c, random.random()))

>>> charRDD2 = distinctChars.map(lambda c: (c, random.random()))

>>> charRDD.cogroup(charRDD2).take(5)

[('s', (<pyspark.resultiterable.ResultIterable object at 0x10ab49c88>, <pyspark.resultiterable.ResultIterable object at 0x10ab49080>)), ('p', (<pyspark.resultiterable.ResultIterable object at 0x10ab49438>, <pyspark.resultiterable.ResultIterable object at 0x10ab49048>)), ('r', (<pyspark.resultiterable.ResultIterable object at 0x10ab494a8>, <pyspark.resultiterable.ResultIterable object at 0x10ab495c0>)), ('i', (<pyspark.resultiterable.ResultIterable object at 0x10ab49588>, <pyspark.resultiterable.ResultIterable object at 0x10ab49ef0>)), ('g', (<pyspark.resultiterable.ResultIterable object at 0x10ab49ac8>, <pyspark.resultiterable.ResultIterable object at 0x10ab49da0>))]

Inner Join

>>> keyedChars = distinctChars.map(lambda c: (c, random.random()))

>>> outputPartitions = 10

>>> chars = words.flatMap(lambda word: word.lower())

>>> KVcharacters = chars.map(lambda letter: (letter, 1))

>>> KVcharacters.join(keyedChars).count()

44

>>> KVcharacters.join(keyedChars, outputPartitions).count()

44

Aggregations

from functools import reduce

>>> def addFunc(left, right):

... return left + right

...

KVcharacters.groupByKey().map(lambda row: (row[0], reduce(addFunc, row[1]))).collect()

[('s', 4), ('p', 3), ('r', 2), ('i', 5), ('g', 5), ('d', 3), ('b', 1), ('c', 1), ('l', 1), ('a', 4), ('k', 1), ('q', 1), ('n', 2), ('e', 5), ('u', 1), (':', 1), ('t', 1), ('o', 1), ('m', 2)]

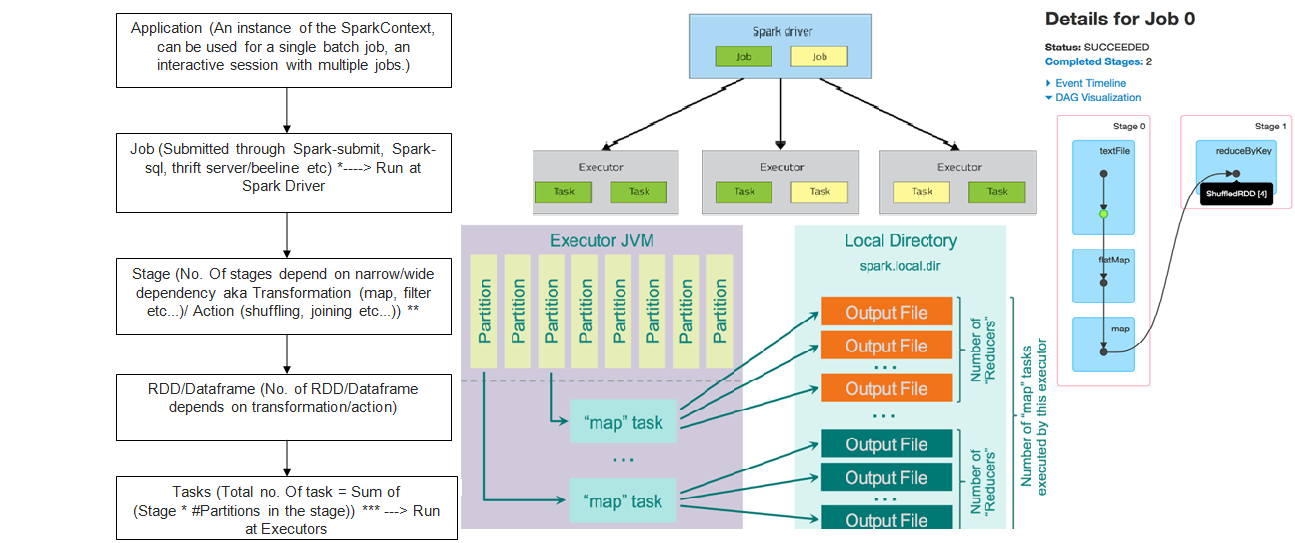

Spark 执行和调度

具体来说就是

- invoke an action...

- ...spawns the job...

- ...that gets divided into the stages by the job scheduler...

- ...and tasks are created for every job stage

其中,stage和task的区别在于:stage是RDD level,不会被立即执行,而task会被立即执行。

Broadcast variables

- read-only shared variables with effective sharing mechanism

- useful to share dictionaries and models

今天就先到这,更多内容以后有机会再聊

10分钟入门spark的更多相关文章

- Apache Shiro系列三,概述 —— 10分钟入门

一.介绍 看完这个10分钟入门之后,你就知道如何在你的应用程序中引入和使用Shiro.以后你再在自己的应用程序中使用Shiro,也应该可以在10分钟内搞定. 二.概述 关于Shiro的废话就不多说了 ...

- JavaScript 10分钟入门

JavaScript 10分钟入门 随着公司内部技术分享(JS进阶)投票的失利,先译一篇不错的JS入门博文,方便不太了解JS的童鞋快速学习和掌握这门神奇的语言. 以下为译文,原文地址:http://w ...

- kafka原理和实践(一)原理:10分钟入门

系列目录 kafka原理和实践(一)原理:10分钟入门 kafka原理和实践(二)spring-kafka简单实践 kafka原理和实践(三)spring-kafka生产者源码 kafka原理和实践( ...

- Markdown - Typora 10分钟入门 - 精简归纳

Markdown - Typora 10分钟入门 - 精简归纳 JERRY_Z. ~ 2020 / 8 / 22 转载请注明出处! 目录 Markdown - Typora 10分钟入门 - 精简归纳 ...

- [入门到吐槽系列] Webix 10分钟入门 一 管理后台制作

前言 本人是服务端程序员,同时需要兼职前端开发.常用的就是原生态的HTML.Javascript,也用过ExtJS.Layui.可是ExtJS变公司后非常难用.Layui上手还行,用过一段时间,会觉得 ...

- [入门到吐槽系列] Webix 10分钟入门 二 表单Form的使用

前言 继续接着上一篇的webix入门:https://www.cnblogs.com/zc22/p/15912342.html.今天完成剩下两个最重要的控件,表单和表格的使用.掌握了这两个,整个Web ...

- Webpack 10分钟入门

可以说现在但凡开发Single page application,webpack是一个不可或缺的工具. WebPack可以看做是一个模块加工器,如上图所示.它做的事情是,接受一些输入,经过加工产生一些 ...

- 「从零单排canal 01」 canal 10分钟入门(基于1.1.4版本)

1.简介 canal [kə'næl],译意为水道/管道/沟渠,主要用途是基于 MySQL 数据库增量日志解析,提供增量数据 订阅 和 消费.应该是阿里云DTS(Data Transfer Servi ...

- python 10分钟入门pandas

本文是对pandas官方网站上<10 Minutes to pandas>的一个简单的翻译,原文在这里.这篇文章是对pandas的一个简单的介绍,详细的介绍请参考:Cookbook .习惯 ...

随机推荐

- 使用express+multer实现node中的图片上传

使用express+multer实现node中的图片上传 在前端中,我们使用ajax来异步上传图片,使用file-input来上传图片,使用formdata对象来处理图片数据,post到服务器中 在n ...

- junit测试延伸--方法的重复测试

在实际编码测试中,我们有的时候需要对一个方法进行多次测试,那么怎么办呢?这个问题和测试套件解决的方案一样,我们总不能不停的去右键run as,那怎么办呢?还好伟大的junit帮我们想到了. OK,现在 ...

- POI--帮助文档

1.创建工作簿 (WORKBOOK) HSSFWorkbook wb = new HSSFWorkbook(); FileOutputStream fileOut = new FileOutputSt ...

- SQL Server错误严重性级别和异常处理

关于SQL Server的错误严重性级别的说明,强烈认真看一下下面的两个链接 脱机帮助 ms-help://MS.SQLCC.v9/MS.SQLSVR.v9.zh-CHS/sqlerrm9/html/ ...

- 重拾Python(2):如何安装第三方库(Windows)

使用python进行数据分析或者数据处理时,往往需要使用一些库,而使用库之前必须安装它.Anaconda内置了很多常用的第三方库,可以满足绝大部分需求,比如numpy.pandas.matplotli ...

- 【转】UNIX时间戳与.net日期类的转换

1 将系统时间转换成UNIX时间戳 DateTime dtStart = TimeZone.CurrentTimeZone.ToLocalTime(new DateTime(1970,1,1)); ...

- NIO笔记---上

小弟前端时间由于开发个管理系统导致断更了近20天!!马上就要春招了,学习了一下NIO,将笔记记录下,希望和我一样的18届毕业生都能找到满意的公司!! 本文记录了NIO与IO的区别,缓冲区的数据存取,直 ...

- 序列化日期(yyyy-MM-dd hh:mm:ss)

var getDateFormat = function() { var _date = new Date(); //实例化一个Date对象 var _complete = function(valu ...

- Django REST framework反向生成url

Django REST framework是一个基于Django的框架,REST framework又是怎么反向生成url的呢?? 在前面的例子中,知道在REST framework中有6种版本控制的 ...

- CentOS下内存使用率查看

freetotal used free shared buffers cachedMem: 1815340 1628680 ...