Gradient Descent 梯度下降法-R实现

梯度下降法:

【转载时请注明来源】:http://www.cnblogs.com/runner-ljt/

Ljt

作为一个初学者,水平有限,欢迎交流指正。

应用:求线性回归方程的系数

目标:最小化损失函数 (损失函数定义为残差的平方和)

搜索方向:负梯度方向,负梯度方向是下降最快的方向

梯度下降法的R实现

#Gradient Descent 梯度下降法

# 在直接设置固定的step时,不宜设置的过大,当步长过大时会报错:

# Error in while ((newerror > error) | (iter < maxiter)) { : missing value where TRUE/FALSE needed

#原因是step过大,会导致在迭代过程中梯度会特别的大,当超过1e+309时就会直接变成无穷Inf #梯度下降法求线性回归方程系数theta

#x为数据矩阵(mxn m:样本数 n:特征数 );y观测值(mx1);error终止条件,相邻两次搜索结果的幅度;

#step为设定的固定步长;maxiter最大迭代次数,alpha,beta为回溯下降法的参数

GradientDescent<-function(x,y,error,maxiter,stepmethod=T,step=0.001,alpha=0.25,beta=0.8)

{

m<-nrow(x)

x<-cbind(matrix(1,m,1),x)

n<-ncol(x)

theta<-matrix(rep(0,n),n,1) #theta初始值都设置为0

iter<-1

newerror<-1 while((newerror>error)|(iter<maxiter)){

iter<-iter+1

h<-x%*%theta

des<-t(t(h-y)%*%x) #梯度

#回溯下降法求步长t

if(stepmethod==T){

sstep=1

new_theta<-theta-sstep*des

new_h<-x%*%new_theta

costfunction<-t(h-y)%*%(h-y) #最小二乘损失函数

new_costfunction<-t(new_h-y)%*%(new_h-y)

#回溯下降法求步长sstep

while(new_costfunction>costfunction-alpha*sstep*sum(des*des)){

sstep<-sstep*beta

new_theta<-theta-sstep*des

new_h<-x%*%new_theta

new_costfunction<-t(new_h-y)%*%(new_h-y)

}

newerror<-t(theta-new_theta)%*%(theta-new_theta)

theta<-new_theta

} #直接设置固定步长

if(stepmethod==F){

new_theta<-theta-step*des

new_h<-x%*%new_theta

# new_costfunction<-t(new_h-y)%*%(new_h-y)

newerror<-t(theta-new_theta)%*%(theta-new_theta)

theta<-new_theta

} }

costfunction<-t(x%*%theta-y)%*%(x%*%theta-y)

result<-list(theta,iter,costfunction)

names(result)<-c('系数','迭代次数','误差')

result

}

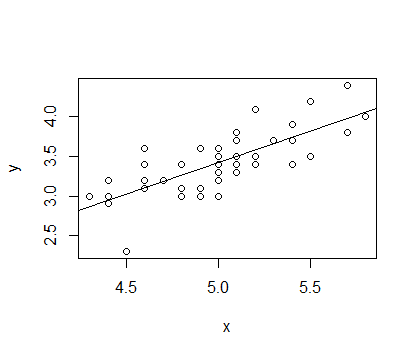

选取 IRIS 数据中种类为setosa的Sepal.Length和Sepal.Width数据分别作为x,y进行拟合,拟合函数为 y=α+βx

结果如下

> x<-matrix(iris[1:50,1],50,1)

> y<-matrix(iris[1:50,2],50,1)

> l<-lm(y~x)

> summary(l) Call:

lm(formula = y ~ x) Residuals:

Min 1Q Median 3Q Max

-0.72394 -0.18273 -0.00306 0.15738 0.51709 Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -0.5694 0.5217 -1.091 0.281

x 0.7985 0.1040 7.681 6.71e-10 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1 Residual standard error: 0.2565 on 48 degrees of freedom

Multiple R-squared: 0.5514, Adjusted R-squared: 0.542

F-statistic: 58.99 on 1 and 48 DF, p-value: 6.71e-10 >

> GradientDescent(x,y,1e-14,1000,stepmethod=T,step=0.001,alpha=0.25,beta=0.8)

$系数

[,1]

[1,] -0.5692863

[2,] 0.7984992 $迭代次数

[1] 23785 $误差

[,1]

[1,] 3.158675 >

> GradientDescent(x,y,1e-14,1000,stepmethod=F,step=0.001,alpha=0.25,beta=0.8)

$系数

[,1]

[1,] -0.5690111

[2,] 0.7984445 $迭代次数

[1] 31882 $误差

[,1]

[1,] 3.158675

Gradient Descent 梯度下降法-R实现的更多相关文章

- 深度学习课程笔记(四)Gradient Descent 梯度下降算法

深度学习课程笔记(四)Gradient Descent 梯度下降算法 2017.10.06 材料来自:http://speech.ee.ntu.edu.tw/~tlkagk/courses_MLDS1 ...

- Stochastic Gradient Descent 随机梯度下降法-R实现

随机梯度下降法 [转载时请注明来源]:http://www.cnblogs.com/runner-ljt/ Ljt 作为一个初学者,水平有限,欢迎交流指正. 批量梯度下降法在权值更新前对所有样本汇总 ...

- ML笔记:Gradient Descent

Review: Gradient Descent Tip 1: Tuning your learning rates eta恰好,可以走到局部最小值点; eta太小,走得太慢,也可以走到局部最小值点; ...

- 【笔记】机器学习 - 李宏毅 - 4 - Gradient Descent

梯度下降 Gradient Descent 梯度下降是一种迭代法(与最小二乘法不同),目标是解决最优化问题:\({\theta}^* = arg min_{\theta} L({\theta})\), ...

- 机器学习基础——梯度下降法(Gradient Descent)

机器学习基础--梯度下降法(Gradient Descent) 看了coursea的机器学习课,知道了梯度下降法.一开始只是对其做了下简单的了解.随着内容的深入,发现梯度下降法在很多算法中都用的到,除 ...

- Gradient Descent 和 Stochastic Gradient Descent(随机梯度下降法)

Gradient Descent(Batch Gradient)也就是梯度下降法是一种常用的的寻找局域最小值的方法.其主要思想就是计算当前位置的梯度,取梯度反方向并结合合适步长使其向最小值移动.通过柯 ...

- One-hot 编码/TF-IDF 值来提取特征,LAD/梯度下降法(Gradient Descent),Sigmoid

1. 多值无序类数据的特征提取: 多值无序类问题(One-hot 编码)把“耐克”编码为[0,1,0],其中“1”代表了“耐克”的中 间位置,而且是唯一标识.同理我们可以把“中国”标识为[1,0],把 ...

- [机器学习] ML重要概念:梯度(Gradient)与梯度下降法(Gradient Descent)

引言 机器学习栏目记录我在学习Machine Learning过程的一些心得笔记,涵盖线性回归.逻辑回归.Softmax回归.神经网络和SVM等等,主要学习资料来自网上的免费课程和一些经典书籍,免费课 ...

- (3)梯度下降法Gradient Descent

梯度下降法 不是一个机器学习算法 是一种基于搜索的最优化方法 作用:最小化一个损失函数 梯度上升法:最大化一个效用函数 举个栗子 直线方程:导数代表斜率 曲线方程:导数代表切线斜率 导数可以代表方向, ...

随机推荐

- 安卓图片Bitmap一些旋转处理

Bitmap convert(Bitmap a, int width, int height) { int w = a.getWidth(); int h = a.getHeight(); Bitma ...

- Minor GC、Major GC和Full GC之间的区别

在 Plumbr 从事 GC 暂停检测相关功能的工作时,我被迫用自己的方式,通过大量文章.书籍和演讲来介绍我所做的工作.在整个过程中,经常对 Minor.Major.和 Full GC 事件的使用感到 ...

- Bootstrap3 栅格系统-Less mixin 和变量

除了用于快速布局的预定义栅格类,Bootstrap 还包含了一组 Less 变量和 mixin 用于帮你生成简单.语义化的布局. 变量 通过变量来定义列数.槽(gutter)宽.媒体查询阈值(用于确定 ...

- Linux 下的一个全新的性能测量和调式诊断工具 Systemtap, 第 2 部分: DTrace

DTrace的原理本系列文章详细地介绍了一个 Linux 下的全新的调式.诊断和性能测量工具 Systemtap 和它所依赖的基础 kprobe 以及促使开发该工具的先驱 DTrace 并给出实际使用 ...

- Texlive 更新命令

设置repository tlmgr repository set http://mirror.hust.edu.cn/CTAN/systems/texlive/tlnet 上面的例子使用的是华中科技 ...

- ROS机器人程序设计(原书第2版)补充资料 (零) 源代码、资料和印刷错误修订等 2017年01月01日更新

ROS机器人程序设计(原书第2版)补充资料 (零) 源代码等 ROS官网 版)部分内容修订 页:第1行,删去$ 页:第6行,float64 y 前面加一个空格 页:中间创建主题:下面程序不用换行,(& ...

- 源码篇——Handler消息机制

Handler消息机制 Message 消息 Message.obtain() Message msg = new Message() Handler new Handler(){ handlerMe ...

- Struts 1 之<bean>标签库

<bean:write>标签 <bean:write>能输出request.session.application.page四个域中能访问到的变量,与EL表达式不同的是,如果变 ...

- iOS中使用iCloud一些需要注意的地方(Xcode7.2)

大熊猫猪·侯佩原创或翻译作品.欢迎转载,转载请注明出处. 如果觉得写的不好请多提意见,如果觉得不错请多多支持点赞.谢谢! hopy ;) 在自己的App中如何使用iCloud有很多文章可以查阅,这里把 ...

- Android上下文菜单ContentView详解

ContentView介绍 上下文菜单继承了android.view.Menu,因此我们可以像操作Options Menu那样给上下文菜单增加菜单项.上下文菜单与Options Menu最大的不同在于 ...