Hive压缩格式

TextFile

- Hive数据表的默认格式,存储方式:行存储。

- 可使用Gzip,Bzip2等压缩算法压缩,压缩后的文件不支持split

- 但在反序列化过程中,必须逐个字符判断是不是分隔符和行结束符,因此反序列化开销会比SequenceFile高几十倍。

--创建数据表:

create table if not exists textfile_table(

site string,

url string,

pv bigint,

label string)

row format delimited fields terminated by '\t'

stored as textfile;

--插入数据:

set hive.exec.compress.output=true; --启用压缩格式

set mapred.output.compress=true;

set mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec; --指定输出的压缩格式为Gzip

set io.compression.codecs=org.apache.hadoop.io.compress.GzipCodec;

insert overwrite table textfile_table select * from T_Name;

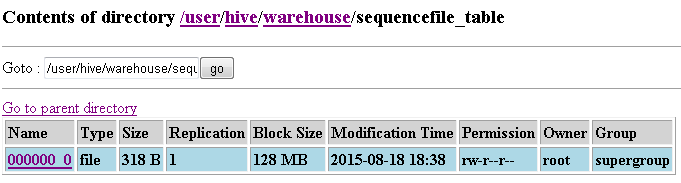

SequenceFile

- Hadoop API提供的一种二进制文件,以<key,value>的形式序列化到文件中。存储方式:行存储。

- 支持三种压缩选择:NONE,RECORD,BLOCK。Record压缩率低,一般建议使用BLOCK压缩。

- 优势是文件和hadoop api中的MapFile是相互兼容的

create table if not exists seqfile_table(

site string,

url string,

pv bigint,

label string)

row format delimited fields terminated by '\t'

stored as sequencefile;

--插入数据操作:

set hive.exec.compress.output=true; --启用输出压缩格式

set mapred.output.compress=true;

set mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec; --指定输出压缩格式为Gzip

set io.compression.codecs=org.apache.hadoop.io.compress.GzipCodec;

SET mapred.output.compression.type=BLOCK; --指定为Block

insert overwrite table seqfile_table select * from T_Name;

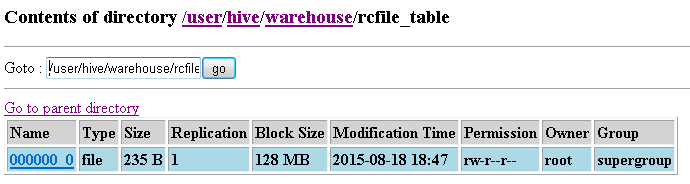

RCFile

存储方式:数据按行分块,每块按列存储。结合了行存储和列存储的优点:

- 首先,RCFile 保证同一行的数据位于同一节点,因此元组重构的开销很低

- 其次,像列存储一样,RCFile 能够利用列维度的数据压缩,并且能跳过不必要的列读取

RCFile的一个行组包括三个部分:

- 第一部分是行组头部的【同步标识】,主要用于分隔 hdfs 块中的两个连续行组

- 第二部分是行组的【元数据头部】,用于存储行组单元的信息,包括行组中的记录数、每个列的字节数、列中每个域的字节数

- 第三部分是【表格数据段】,即实际的列存储数据。在该部分中,同一列的所有域顺序存储。

从图可以看出,首先存储了列 A 的所有域,然后存储列 B 的所有域等。

数据追加:RCFile 不支持任意方式的数据写操作,仅提供一种追加接口,这是因为底层的 HDFS当前仅仅支持数据追加写文件尾部。

行组大小:行组变大有助于提高数据压缩的效率,但是可能会损害数据的读取性能,因为这样增加了 Lazy 解压性能的消耗。而且行组变大会占用更多的内存,这会影响并发执行的其他MR作业。 考虑到存储空间和查询效率两个方面,Facebook 选择 4MB 作为默认的行组大小,当然也允许用户自行选择参数进行配置。

create table if not exists rcfile_table(

site string,

url string,

pv bigint,

label string)

row format delimited fields terminated by '\t'

stored as rcfile;

--插入数据操作:

set hive.exec.compress.output=true;

set mapred.output.compress=true;

set mapred.output.compression.codec=org.apache.hadoop.io.compress.GzipCodec;

set io.compression.codecs=org.apache.hadoop.io.compress.GzipCodec;

insert overwrite table rcfile_table select * from T_Name;

ORCFile

- 存储方式:数据按行分块 每块按照列存储

- 压缩快 快速列存取

- 效率比rcfile高,是rcfile的改良版本

自定义格式

- 用户可以通过实现inputformat和 outputformat来自定义输入输出格式。

hive> create table myfile_table(str STRING)

> stored as

> inputformat 'org.apache.hadoop.hive.contrib.fileformat.base64.Base64TextInputFormat'

> outputformat 'org.apache.hadoop.hive.contrib.fileformat.base64.Base64TextOutputFormat';

OK

Time taken: 0.399 seconds

hive> load data local inpath '/root/hive/myfile_table'

> overwrite into table myfile_table;--加载数据

hive> dfs -text /user/hive/warehouse/myfile_table/myfile_table;--数据文件内容,编码后的格式

aGVsbG8saGl2ZQ==

aGVsbG8sd29ybGQ=

aGVsbG8saGFkb29w

hive> select * from myfile_table;--使用自定义格式进行解码

OK

hello,hive

hello,world

hello,hadoop

Time taken: 0.117 seconds, Fetched: 3 row(s)

总结:

数据仓库的特点:一次写入、多次读取,因此,整体来看,ORCFile相比其他格式具有较明显的优势。

- TextFile 默认格式,加载速度最快,可以采用Gzip、bzip2等进行压缩,压缩后的文件无法split,即并行处理

- SequenceFile 压缩率最低,查询速度一般,三种压缩格式NONE,RECORD,BLOCK

- RCfile 压缩率最高,查询速度最快,数据加载最慢。

Hive压缩格式的更多相关文章

- hive 压缩全解读(hive表存储格式以及外部表直接加载压缩格式数据);HADOOP存储数据压缩方案对比(LZO,gz,ORC)

数据做压缩和解压缩会增加CPU的开销,但可以最大程度的减少文件所需的磁盘空间和网络I/O的开销,所以最好对那些I/O密集型的作业使用数据压缩,cpu密集型,使用压缩反而会降低性能. 而hive中间结果 ...

- Apache Hive 存储方式、压缩格式

简介: Apache hive 存储方式跟压缩格式! 1.Text File hive> create external table tab_textfile ( host string com ...

- Hive 表数据的存储和压缩格式

SerDe * 按行存储 * 按列存储 file_format: : | SEQUENCEFILE 序列化(行存储) | TEXTFILE 文本格式(行存储)- (Default, depending ...

- Hive支持的文件格式和压缩格式及各自特点

Hive中的文件格式 1-TEXTFILE 文本格式,Hive的默认格式,数据不压缩,磁盘开销大.数据解析开销大. 对应的hive API为:org.apache.hadoop.mapred.Text ...

- Hadoop_常用存储与压缩格式

HDFS文件格式 file_format: TEXTFILE 默认格式 RCFILE hive 0.6.0 和以后的版本 ORC hive 0.11.0 和以后的版本 PARQUET hive 0.1 ...

- hadoop中MapReduce中压缩的使用及4种压缩格式的特征的比较

在比较四中压缩方法之前,先来点干的,说一下在MapReduce的job中怎么使用压缩. MapReduce的压缩分为map端输出内容的压缩和reduce端输出的压缩,配置很简单,只要在作业的conf中 ...

- hive压缩

1. 常用 rcfile + gzip parquet + snappy 2. 压缩比,参考 TextFile默认格式,加载速度最快,可以采用Gzip进行压缩,压缩后的文件无法split,即并行处理 ...

- 解读:hadoop压缩格式

Hadoop中用得比较多的4种压缩格式:lzo,gzip,snappy,bzip2.它们的优缺点和应用场景如下: 1). gzip压缩 优点:压缩率比较高,而且压缩/解压速度也比较快:hadoop本身 ...

- Hive 压缩技术Data Compression

Mapreducwe 执行流程 :input > map > shuffle > reduce > output 压缩执行时间,map 之后,压缩,数据存储在本地磁盘,减少磁盘 ...

随机推荐

- python--excel

import xlrd, xlwt # 读取Exceldef read_excel(excel_name, sheet_name): if excel_name and excel_name: all ...

- R语言中的MySQL操作

R语言中,针对MySQL数据库的操作执行其实也有很多中方式.本人觉得,熟练掌握一种便可,下面主要就个人的学习使用情况,总结其中一种情况-----使用RMySQL操作数据库. 1.下载DBI和RMySQ ...

- etcd: request cluster ID mismatch错误解决【只适用于新建etcd集群或无数据集群】

1.报错信息 Mar 29 05:45:31 xxx etcd: request cluster ID mismatch (got 414f8613693e2e2 want cdf818194e3a8 ...

- generateScriptFile.py脚本使用过程中遇到的问题及解决

generateScriptFile.py脚本 #!/usr/bin/env python # -*- coding: utf-8 -*- """ use case: p ...

- PHP程序执行时间过长,超时了怎么办

解决办法:修改php.ini文件,把最大的执行时间改为0,0表示不限制时间. max_execution_time = 0

- keeplived + mysql双主复制部署 --原创

环境: master 1: 192.168.100.10 oracle linux 7.4 mysql 5.7.1 master 2: 192.168.100.11 oracle linux ...

- 推荐系统第6周--- SVD和基于标签的推荐系统

“隐语义”的真正背景 LSA(latent semantic analysis)潜在语义分析,也被称为LSI(latent semantic index),是Scott Deerweste ...

- (转)CreateThread与_beginthread,内存泄漏为何因(原帖排版有些不好 ,所以我稍微整理下)

在写c++代码时,一直牢记着一句话:决不应该调用CreateThread. 应该使用Visual C++运行时库函数_beginthreadex.好像CreateThread函数就 ...

- 用python 实现生成双色球小程序

生成双色球小程序: #输入n,随机产生n条双色球号码,插入n条数据库 #表结构: seq CREATE TABLE `seq` ( `id` int(11) NOT NULL AUTO_INCREME ...

- JavaScript之从头再来

引入文件 1. 引入外部文件 <script type="text/javascript" src="JS文件"></script> 2 ...