在DataFrame数据表里面提取需要的行

在DataFrame数据表里面提取需要的行

代码功能:

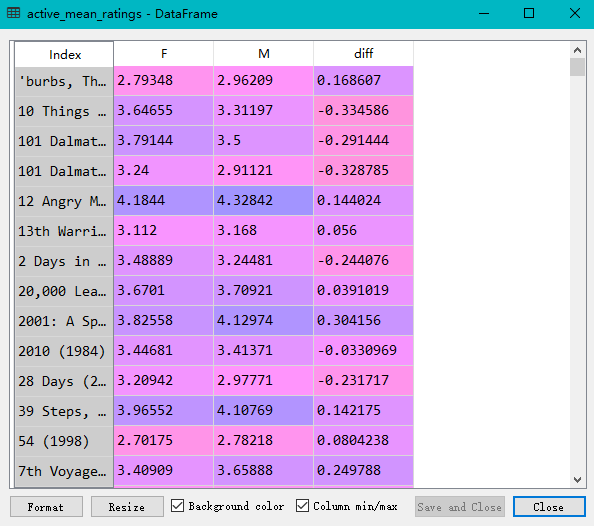

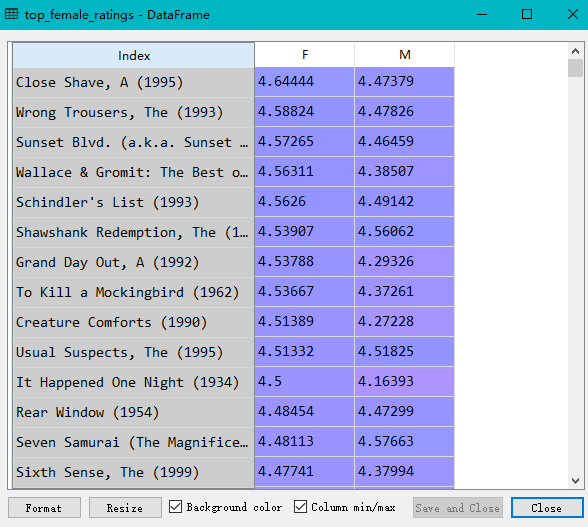

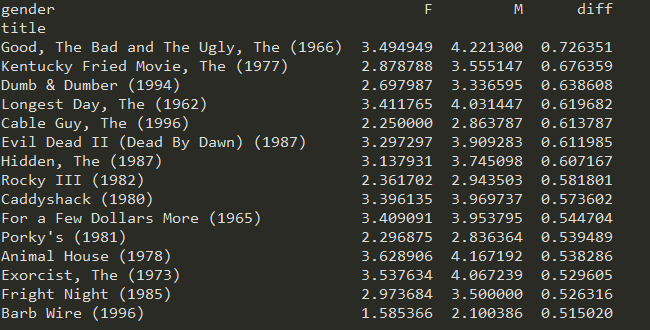

在DataFrame表格中使用loc(),得到我们想要的行,然后根据某一列元素的值进行排序

此代码中还展示了为DataFrame添加列,即直接name_DataFrame['diff']=___即可,同时可以依据新添加的列元素的值,来对dataframe进行排序

import pandas as pd unames = ['user_id', 'gender', 'age','occupation','zip']

users = pd.read_table('users.dat', sep='::',header=None, names=unames) rnames = ['user_id', 'movie_id', 'rating', 'timestamp']

ratings = pd.read_table('ratings.dat', sep='::', header=None, names=rnames) mnames = ['movie_id', 'title', 'genres']

movies = pd.read_table('movies.dat', sep='::', header=None, names=mnames) data = pd.merge(pd.merge(ratings,users),movies) mean_ratings = pd.pivot_table(data,index=['title'],values='rating',columns='gender') print(mean_ratings[:10]) ratings_by_title = data.groupby('title').size() print(ratings_by_title[:10]) active_titles = ratings_by_title.index[ratings_by_title >= 250] print(active_titles) active_mean_ratings = mean_ratings.loc[active_titles] top_female_ratings = active_mean_ratings.sort_index(by='F', ascending=False) active_mean_ratings['diff'] = active_mean_ratings['M'] - active_mean_ratings['F'] sorted_by_diff = active_mean_ratings.sort_index(by='diff') print(sorted_by_diff[::-1][:15]) #注意对dataframe进行倒序访问的方法

在DataFrame数据表里面提取需要的行的更多相关文章

- spark dataframe操作集锦(提取前几行,合并,入库等)

https://blog.csdn.net/sparkexpert/article/details/51042970 spark dataframe派生于RDD类,但是提供了非常强大的数据操作功能.当 ...

- 存储过程获取最后插入到数据表里面的ID

存储过程获取最后插入到数据表里面的ID SET NOCOUNT on;---不返回影响行数提高性能GOcreate proc [sp_bbs_thread_Insert] @id int output ...

- mysql的if用法解决同一张数据表里面两个字段是否相等统计数据量。

MySQL的使用用法如下所示:格式:if(Condition,A,B)意义:当Condition为true时,返回A:当Condition为false时,返回B.作用:作为条件语句使用.mysql的i ...

- Python3 Pandas的DataFrame数据的增、删、改、查

Python3 Pandas的DataFrame数据的增.删.改.查 一.DataFrame数据准备 增.删.改.查的方法有很多很多种,这里只展示出常用的几种. 参数inplace默认为False,只 ...

- Pandas DataFrame数据的增、删、改、查

Pandas DataFrame数据的增.删.改.查 https://blog.csdn.net/zhangchuang601/article/details/79583551 #删除列 df_2 = ...

- spark 将dataframe数据写入Hive分区表

从spark1.2 到spark1.3,spark SQL中的SchemaRDD变为了DataFrame,DataFrame相对于SchemaRDD有了较大改变,同时提供了更多好用且方便的API.Da ...

- Pandas DataFrame 数据选取和过滤

This would allow chaining operations like: pd.read_csv('imdb.txt') .sort(columns='year') .filter(lam ...

- python爬虫的页面数据解析和提取/xpath/bs4/jsonpath/正则(2)

上半部分内容链接 : https://www.cnblogs.com/lowmanisbusy/p/9069330.html 四.json和jsonpath的使用 JSON(JavaScript Ob ...

- 将DataFrame数据如何写入到Hive表中

1.将DataFrame数据如何写入到Hive表中?2.通过那个API实现创建spark临时表?3.如何将DataFrame数据写入hive指定数据表的分区中? 从spark1.2 到spark1.3 ...

随机推荐

- js demo1

三位数求和 单选多选全选及取消 图片切换 验证QQ号 求数组的和 求1-10的偶数和 求数组最小值 和平均值 3个按钮各自切换ABC QQ列表 选项卡1 获取非行间样式的兼容写法 1-10的阶乘

- Linux 使用硬盘

一.硬盘分区规划: swap(交换,掉期交易,互换)分区:虚拟内存使用,不能保存用户信息. boot(引导)分区:保存启动系统得相关文件. root(根)分区:放置系统文件得根,所有文件都保存在该分区 ...

- 看到一个简单的背单词java程序的设计,收藏下

https://blog.csdn.net/qq_40605167/article/details/81023836

- org.apache.commons.lang.exception.NestableRuntimeException

jar包不全 附上一个好的的博客链接→

- c#线程池ThreadPool实例详解

1. 如何查看线程池的最大线程数和最小线程数 static void Main(string[] args) { Console.WriteLine("----------线程池开始,线程I ...

- Lvs Dr 模式配置

1.Dr 安装 ipvsadm # yum -y install ipvsadm # lsmod | grep ip_vs #检查ipvs模块是否加载进系统.把ipvs模块加载进系统,需要我们执 ...

- 【转】Android-Input 键盘设备

https://source.android.com/devices/input/keyboard-devices 键盘设备 Android 支持各种键盘设备,包括特殊功能小键盘(音量和电源控制),紧 ...

- Mysql 设置远程连接

一.问题分析 有时候使用数据库远程连接工具连接MySQL的时候总是连接不上,确认过账号密码正确,端口telnet端口又是通的. Navicat Premium报错如下: 1130 - Host '19 ...

- mysql5.5.28在Linux下的安装

1. 下载mysql 在http://dev.mysql.com/downloads/mysql/ 官网上下载mysql-5.5.28-linux2.6-i686.tar.gz. 2. ...

- c++ — 运算符重载与strcmp自实现

#include <iostream> #include <string.h> #include <stdlib.h> using namespace std; c ...