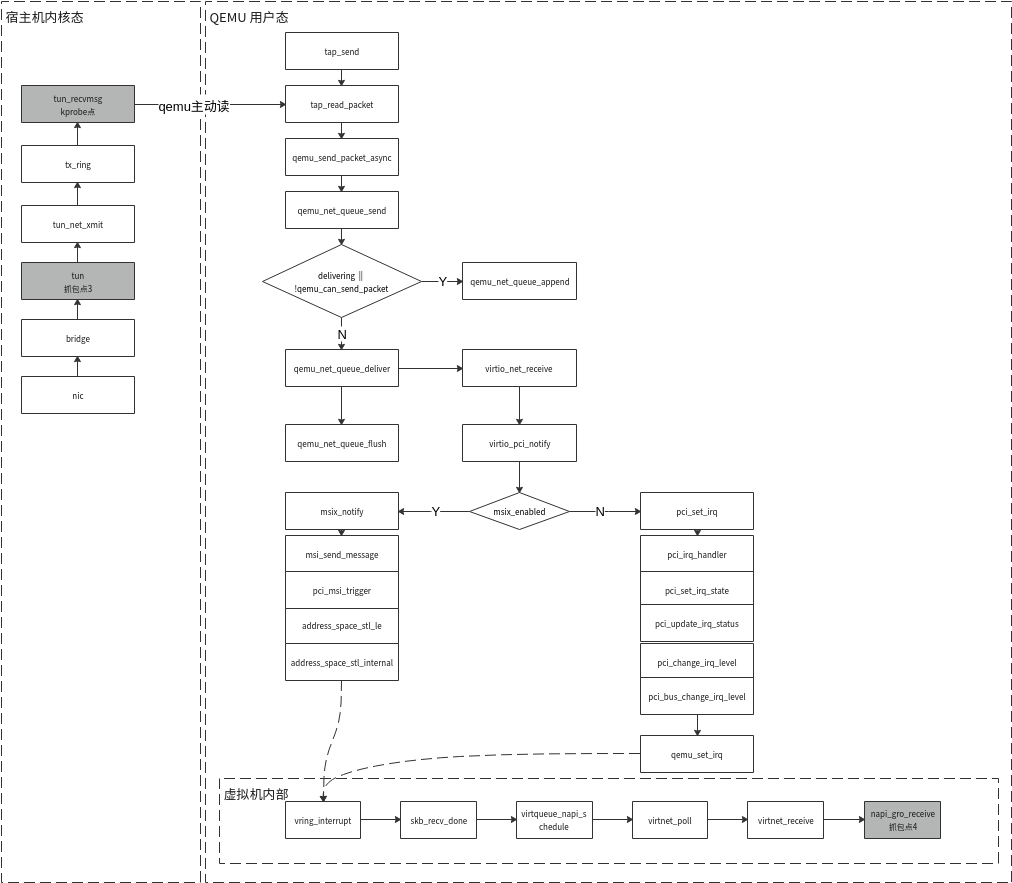

QEMU tap数据接收流程

QEMU直接从tap/tun取数据

QEMU tap数据接收步骤:

- qemu从tun取数据包

- qemu将数据包放入virtio硬件网卡。

- qemu触发中断。

- 虚拟机收到中断,从virtio读取数据。

在qemu中步骤1(tap_read_packet)和步骤2(qemu_send_packet_async)都是在tap_send中完成的,其中步骤2是异步流程。

qemu/net/tap.c

static void tap_send(void *opaque)

{

TAPState *s = opaque;

int size;

int packets = 0;

while (true) {

uint8_t *buf = s->buf;

uint8_t min_pkt[ETH_ZLEN];

size_t min_pktsz = sizeof(min_pkt);

size = tap_read_packet(s->fd, s->buf, sizeof(s->buf));

if (size <= 0) {

break;

}

if (s->host_vnet_hdr_len && !s->using_vnet_hdr) {

buf += s->host_vnet_hdr_len;

size -= s->host_vnet_hdr_len;

}

if (net_peer_needs_padding(&s->nc)) {

if (eth_pad_short_frame(min_pkt, &min_pktsz, buf, size)) {

buf = min_pkt;

size = min_pktsz;

}

}

size = qemu_send_packet_async(&s->nc, buf, size, tap_send_completed);

if (size == 0) {

tap_read_poll(s, false);

break;

} else if (size < 0) {

break;

}

/*

* When the host keeps receiving more packets while tap_send() is

* running we can hog the QEMU global mutex. Limit the number of

* packets that are processed per tap_send() callback to prevent

* stalling the guest.

*/

packets++;

if (packets >= 50) {

break;

}

}

}

qemu通过qemu_net_queue_deliver将数据包发送到virtio_queue,在发送之前若delivering或!qemu_can_send_packet满足,则先将数据包加入packets队列,随后在qemu_net_queue_flush阶段将数据包发送到virtio_queue中,上图中virtio_net_receive就到达virtio虚拟硬件网卡了。

QEMU通过vhost-net从tap/tun取数据

vhost-net驱动加载时会生成/dev/vhost-net设备。

qemu-kvm启动时会open设备/dev/vhost-net,将调用vhost_net_open完成这个过程,vhost_net_open会进行handle_tx_net、handle_rx_net poll函数的初始化。

handle_tx_net、handle_rx_net最终会调用tun_recvmsg、tun_sendmsg进行数据收发。

/drivers/vhost/net.c:

static int vhost_net_open(struct inode *inode, struct file *f)

{

... ...

vhost_poll_init(n->poll + VHOST_NET_VQ_TX, handle_tx_net, EPOLLOUT, dev);

vhost_poll_init(n->poll + VHOST_NET_VQ_RX, handle_rx_net, EPOLLIN, dev);

... ...

}

static void handle_rx_net(struct vhost_work *work)

{

struct vhost_net *net = container_of(work, struct vhost_net,

poll[VHOST_NET_VQ_RX].work);

handle_rx(net);

}

handle_rx函数中recvmsg完成从tun取数据,通过copy_to_iter将msg放入virtio_queue,最后vhost_add_used_and_signal_n实现通知机制,qemu收到数据。

static void handle_rx(struct vhost_net *net)

{

... ...

err = sock->ops->recvmsg(sock, &msg,

sock_len, MSG_DONTWAIT | MSG_TRUNC);

... ...

num_buffers = cpu_to_vhost16(vq, headcount);

if (likely(mergeable) &&

copy_to_iter(&num_buffers, sizeof num_buffers,

&fixup) != sizeof num_buffers) {

vq_err(vq, "Failed num_buffers write");

vhost_discard_vq_desc(vq, headcount);

break;

}

vhost_add_used_and_signal_n(&net->dev, vq, vq->heads,

headcount);

... ...

}

vhost_net通过vhost_worker内核线程进行工作队列的调度用于完成poll,vhost_worker内核线程是qemu通过vhost_dev_ioctl VHOST_SET_OWNER时创建的。

drivers/vhost/vhost.c:

static int vhost_poll_wakeup(wait_queue_entry_t *wait, unsigned mode, int sync,

void *key)

{

struct vhost_poll *poll = container_of(wait, struct vhost_poll, wait);

if (!(key_to_poll(key) & poll->mask))

return 0;

vhost_poll_queue(poll);

return 0;

}

void vhost_work_init(struct vhost_work *work, vhost_work_fn_t fn)

{

clear_bit(VHOST_WORK_QUEUED, &work->flags);

work->fn = fn;

}

EXPORT_SYMBOL_GPL(vhost_work_init);

/* Init poll structure */

void vhost_poll_init(struct vhost_poll *poll, vhost_work_fn_t fn,

__poll_t mask, struct vhost_dev *dev)

{

init_waitqueue_func_entry(&poll->wait, vhost_poll_wakeup);

init_poll_funcptr(&poll->table, vhost_poll_func);

poll->mask = mask;

poll->dev = dev;

poll->wqh = NULL;

vhost_work_init(&poll->work, fn);

}

EXPORT_SYMBOL_GPL(vhost_poll_init);

static int vhost_worker(void *data)

{

... ...

for (;;) {

... ...

node = llist_del_all(&dev->work_list);

if (!node)

schedule();

node = llist_reverse_order(node);

/* make sure flag is seen after deletion */

smp_wmb();

llist_for_each_entry_safe(work, work_next, node, node) {

clear_bit(VHOST_WORK_QUEUED, &work->flags);

__set_current_state(TASK_RUNNING);

work->fn(work);

if (need_resched())

schedule();

}

... ...

}

... ...

}

long vhost_dev_set_owner(struct vhost_dev *dev)

{

... ...

worker = kthread_create(vhost_worker, dev, "vhost-%d", current->pid);

... ...

}

long vhost_dev_ioctl(struct vhost_dev *d, unsigned int ioctl, void __user *argp)

{

... ...

if (ioctl == VHOST_SET_OWNER) {

r = vhost_dev_set_owner(d);

goto done;

}

... ...

}

drivers/vhost/net.c:

static long vhost_net_ioctl(struct file *f, unsigned int ioctl,

unsigned long arg)

{

... ...

switch (ioctl) {

... ...

case VHOST_RESET_OWNER:

return vhost_net_reset_owner(n);

case VHOST_SET_OWNER:

return vhost_net_set_owner(n);

default:

mutex_lock(&n->dev.mutex);

r = vhost_dev_ioctl(&n->dev, ioctl, argp);

if (r == -ENOIOCTLCMD)

r = vhost_vring_ioctl(&n->dev, ioctl, argp);

else

vhost_net_flush(n);

mutex_unlock(&n->dev.mutex);

return r;

}

}

static long vhost_net_set_owner(struct vhost_net *n)

{

... ...

r = vhost_dev_set_owner(&n->dev);

... ...

return r;

}

static const struct file_operations vhost_net_fops = {

.owner = THIS_MODULE,

.release = vhost_net_release,

.read_iter = vhost_net_chr_read_iter,

.write_iter = vhost_net_chr_write_iter,

.poll = vhost_net_chr_poll,

.unlocked_ioctl = vhost_net_ioctl,

#ifdef CONFIG_COMPAT

.compat_ioctl = vhost_net_compat_ioctl,

#endif

.open = vhost_net_open,

.llseek = noop_llseek,

};

static struct miscdevice vhost_net_misc = {

.minor = VHOST_NET_MINOR,

.name = "vhost-net",

.fops = &vhost_net_fops,

};

static int vhost_net_init(void)

{

if (experimental_zcopytx)

vhost_net_enable_zcopy(VHOST_NET_VQ_TX);

return misc_register(&vhost_net_misc);

}

附

主机vhost驱动加载时调用vhost_net_init注册一个MISC驱动,生成/dev/vhost-net的设备文件。

主机qemu-kvm启动时调用open对应的vhost_net_open做主要创建队列和收发函数的挂载,接着调用ioctl启动内核线程vhost,做收发包的处理。

主机qemu通过ioctl配置kvm模块,主要设置通信方式,因为主机vhost和virtio只进行报文的传输,kvm进行提醒。

虚拟机virtio模块注册,生成虚拟机的网络设备,配置中断和NAPI。

虚拟机发包流程如下:

直接从应用层走协议栈最后调用发送接口ndo_start_xmit对应的start_xmit,将报文放入发送队列,vp_notify通知kvm。

kvm通过vmx_handle_exit一系列调用到wake_up_process唤醒vhost线程。

vhost模块的线程激活并且拿到报文,在通过之前绑定的发送接口handle_tx_kick进行发送,调用虚拟网卡的tun_sendmsg最终到netif_rx接口进入主机内核协议栈。

虚拟机收包流程如下:

tap设备的ndo_start_xmit对应的tun_net_xmit最终调用到wake_up_process激活vhost线程,调用handle_rx_kick,将报文放入接收队列。

通过一系列的调用到kvm模块的接口kvm_vcpu_kick,向qemu虚拟机注入中断。

虚拟机virtio模块中断调用接口vp_interrupt,调用virtnet_poll,再调用到netif_receive_skb进入虚拟机的协议栈。

资料来源:https://blog.csdn.net/qq_20817327/article/details/106838029

QEMU tap数据接收流程的更多相关文章

- atheros无线驱动之:数据接收流程

1:数据处理函数tasklet,workqueue在之前的初始化代码中的函数__ath_attach()中,有如下的代码: #ifndef ATH_SUPPORT_HTC#ifdef ADF_SUPP ...

- twemproxy接收流程探索——twemproxy代码分析正编

在这篇文章开始前,大家要做好一个小小的心理准备,由于twemproxy代码是一份优秀的c语言,为此,在twemproxy的代码中会大篇幅使用c指针.但是不论是普通类型的指针还是函数指针,都可以让我们这 ...

- twemproxy接收流程探索——剖析twemproxy代码正编

本文旨在帮助大家探索出twemproxy接收流程的代码逻辑框架,有些具体的实现需要我们在未来抽空去探索或者大家自行探索.在这篇文章开始前,大家要做好一个小小的心理准备,由于twemproxy代码是一份 ...

- stm32 usb数据接收与数据发送程序流程分析

http://blog.csdn.net/u011318735/article/details/17424349 既然学习了USB,那就必须的搞懂USB设备与USB主机数据是怎么通讯的.这里主要讲设备 ...

- Linux内核二层数据包接收流程

本文主要讲解了Linux内核二层数据包接收流程,使用的内核的版本是2.6.32.27 为了方便理解,本文采用整体流程图加伪代码的方式从内核高层面上梳理了二层数据包接收的流程,希望可以对大家有所帮助.阅 ...

- [转帖]Linux TCP/IP协议栈,数据发送接收流程,TCP协议特点

Linux TCP/IP协议栈,数据发送接收流程,TCP协议特点 http://network.51cto.com/art/201909/603780.htm 可以毫不夸张的说现如今的互联网是基于TC ...

- linux 内核网络数据包接收流程

转:https://segmentfault.com/a/1190000008836467 本文将介绍在Linux系统中,数据包是如何一步一步从网卡传到进程手中的. 如果英文没有问题,强烈建议阅读后面 ...

- 内核中用于数据接收的结构体struct msghdr(转)

内核中用于数据接收的结构体struct msghdr(转) 我们从一个实际的数据包发送的例子入手,来看看其发送的具体流程,以及过程中涉及到的相关数据结构.在我们的虚拟机上发送icmp回显请求包,pin ...

- nginx的请求接收流程(二)

在ngx_http_process_request_line函数中,解析完请求行之后,如果请求行的uri里面包含了域名部分,则将其保持在请求结构的headers_in成员的server字段,heade ...

- nginx的请求接收流程(一)

今年我们组计划写一本nginx模块开发以及原理解析方面的书,整本书是以open book的形式在网上会定时的更新,网址为http://tengine.taobao.org/book/index.htm ...

随机推荐

- 为什么有了 HTTP 还要 RPC

哈喽大家好,我是咸鱼 随着互联网技术的发展,分布式架构越来越被人们所采用.在分布式架构下,为了实现复杂的业务逻辑,应用程序需要分布式通信实现远程调用 而这时候就需要一种协议来支持远程过程调用,以便实现 ...

- .cur 图片加载提示 You may need an appropriate loader to handle this file type

最近一个gis 项目需要加载一个.cur的图标,但是编译时提示 You may need an appropriate loader to handle this file type, current ...

- Linux(redhat)镜像

作为一个合格的程序猿,Linux那就是必须得会玩哟呵,搜集了一些镜像分享大家,望笑纳. 云盘地址https://pan.baidu.com/s/1cB-llYI5RdRm9xJDmjFoWg 提取码 ...

- 详解RocketMQ 顺序消费机制

摘要:顺序消息是指对于一个指定的 Topic ,消息严格按照先进先出(FIFO)的原则进行消息发布和消费,即先发布的消息先消费,后发布的消息后消费. 本文分享自华为云社区<RocketMQ 顺序 ...

- 如何制作 Storybook Day 网页上的 3D 效果?

Storybook 刚刚达到了一个重要的里程牌:7.0 版本!为了庆祝,该团队举办了他们的第一次用户大会 - Storybook Day.为了更特别,在活动页面中添加了一个视觉上令人惊叹的 3D 插图 ...

- 深度学习应用篇-推荐系统[12]:经典模型-DeepFM模型、DSSM模型召回排序策略以及和其他模型对比

深度学习应用篇-推荐系统[12]:经典模型-DeepFM模型.DSSM模型召回排序策略以及和其他模型对比 1.DeepFM模型 1.1.模型简介 CTR预估是目前推荐系统的核心技术,其目标是预估用户点 ...

- 【城南】如何识别AI生成图?视觉AIGC伪造检测技术综述

如何识别 AI 生成图片?or 如何识别 AIGC 图?or 如何识别 AI 换脸?or AI生成图伪造检测? 类似的说法有很多种,总之就是利用AI技术来鉴别一张图是不是AI生成的,这种AI技术就是本 ...

- 驱动开发:应用DeviceIoContro模板精讲

在笔者上一篇文章<驱动开发:应用DeviceIoContro开发模板>简单为大家介绍了如何使用DeviceIoContro模板快速创建一个驱动开发通信案例,但是该案例过于简单也无法独立加载 ...

- 从Excel 电子表格中读取数据并插入到数据库的简单方式

using (FileStream fileStreamRead = new FileStream("new.xls" , FileMode.Open )) { //创建工作簿 I ...

- TiDB简述及TiKV的数据结构与存储

1 概述 TiDB 是 PingCAP 公司自主设计.研发的开源分布式关系型数据库,是一款同时支持在线事务处理与在线分析处理 (Hybrid Transactional and Analytical ...