C# SqlBulkCopy 避免插入重复数据(不重复即插入)

之前写过一篇 C# SqlBulkCopy 大量数据导入到数据库 的文章介绍了大量数据导入到数据库的高效方法。

这篇文章与之有些关联,在这之前所想的是做全量插入,每次run这个job就会清空然后插入,但是面对大量的数据,每次产生的流量是很大的,尤其是数据来自一些付费的API时,无疑增大了很多开销。所以我们只获取7天内更新的数据然后再选择未插入的数据插入到表中,对表作增量操作,由此达到控制成本的目的。

在此之前看过多篇博客都介绍了解决这个问题的方法,用到了一些零时表和触发器的知识,本人对此不胜了解,项目也比较紧,未研究,遂放弃,在此介绍一个相对简单的方法。

介绍其他人的正规解决方案一例,SqlBulkCopy与触发器,批量插入表(存在则更新,不存在则插入),有兴趣的可以研究下

//////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

想法:

我们将获取到的需要插入的数据先存放到一个临时表A_tem中(这个临时表是我每次执行就创建,结尾删除的表)

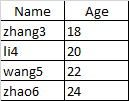

表A 表A_tem

创建一个存储过程

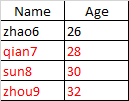

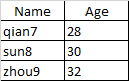

select * from A_tem except select * from A

由此得到需要插入的在表A中不存在的数据

result

-------------------------------------------------------------------------------------------

Code Sample:

string connString = ConfigurationManager.ConnectionStrings["connString"].ToString();

SqlConnection conn = new SqlConnection(connString);

conn.Open();

Logger.LogMessage(string.Format("Createing Temporary table CsvFileVCQData_Tem......")); //Creater Temporary Table

string sql = "CREATE TABLE CsvFileVCQData_Tem( [StringFormatted] [nvarchar](max) NULL, [ProjectName] [nvarchar](256) NULL, [ResID_MD4Hash] [nvarchar](max) NULL, [Wordcount] [numeric](18, 0) NULL, [CharacterCount] [numeric](18, 0) NULL, [SentanceCount] [numeric](18, 0) NULL, [SingleWord] [bit] NULL, [TwoWordsOnly] [bit] NULL, [HasPunctuation] [bit] NULL,[ContainsProductName] [bit]NULL, [HasPlaceholder] [bit] NULL, [EndsInColon] [bit] NULL, [HasVCQ] [bit] NULL,[HasDevComment] [bit] NULL, [HasLocComment] [bit] NULL,[HasScreenshot] [bit] NULL,[IsMobile] [bit] NULL,[IsDesktop] [bit] NULL,[IsWeb] [bit] NULL,[IsConsumer] [bit] NULL,[IsBusiness] [bit] NULL,[TotalSteelheadResults] [nvarchar](256) NULL,[SteelheadPasses] [numeric](18, 0) NULL,[SteelheadFailures] [numeric](18, 0) NULL, [S_Pass_Over_Total] [nvarchar](256) NULL, [S_Failed_Over_Total] [nvarchar](256) NULL,[ScoredLabels] [bit] NULL,[ScoredProbabilities] [nvarchar](256) NULL) ON[PRIMARY] TEXTIMAGE_ON[PRIMARY]";

Execute_Sql(sql); SqlBulkCopy sqlbulkcopy = new SqlBulkCopy(conn);

sqlbulkcopy.DestinationTableName = "CsvFileVCQData_Tem";

//sqlbulkcopy.DestinationTableName = itemTable.TableName;//数据库中的表名

sqlbulkcopy.BulkCopyTimeout = 300; Logger.LogMessage(string.Format("Finding " + itemTable.Rows.Count + " pieces of data"));

Logger.LogMessage(string.Format("Importing into the temporary table......")); DataTable datNew = itemTable.DefaultView.ToTable(false, new string[] {

"StringFormatted","ProjectName","ResID_MD4Hash","Wordcount","CharacterCount",

"SentanceCount","SingleWord","TwoWordsOnly","HasPunctuation","ContainsProductName",

"HasPlaceholder","EndsInColon","HasVCQ","HasDevComment","HasLocComment",

"HasScreenshot","IsMobile","IsDesktop","IsWeb",

"IsConsumer","IsBusiness","Total Steelhead Results","SteelheadPasses","SteelheadFailures",

"S_Pass_Over_Total","S_Failed_Over_Total","Scored Labels","Scored Probabilities"

});

sqlbulkcopy.WriteToServer(datNew); DbHelper DBH = new DbHelper();

DataTable result = DBH.ExecuteDataTable("get_NewData");//调用存储过程 Logger.LogMessage(string.Format("Finding "+result.Rows.Count+" pieces of new data......")); sqlbulkcopy.DestinationTableName = "CsvFileVCQData";

sqlbulkcopy.WriteToServer(result); Logger.LogMessage(string.Format("Droping temporary table CsvFileVCQData_Tem......")); string sql_ = "drop table CsvFileVCQData_Tem";

Execute_Sql(sql_);

conn.Close();

Logger.LogMessage(string.Format("Operation Done!"));

C# SqlBulkCopy 避免插入重复数据(不重复即插入)的更多相关文章

- MySQL插入重复数据

MySQL中批量insert into时防止更新插入重复数据去重的方法,主要是讲到了ignore,Replace,ON DUPLICATE KEY UPDATE三种方法 方案一:使用ignore关键字 ...

- SQL数据库约束行为---防止数据完全重复

防止同一条数据完全重复: 一.主关键字约束:主键约束.1.能够唯一的区分每一行数据.——不许重2.表中的数据按照主键字排序的.——有序3.主键字不能为空——不为空4.一个表只能有一个主键,但可以设置组 ...

- SqlBulkCopy实现大容量数据快速插入数据库中

一般情况下,我们手写sqlhelper类,在此类中定义一个数据插入到数据库的一个方法.将数据库连接密封在using()的语句中.using显示了Idispose接口.可以及时释放数据库连接资源.代码如 ...

- mysql insert插入时实现如果数据表中主键重复则更新,没有重复则插入的四种方法

[CSDN下载] Powerdesigner 设计主键code不能重复等问题 [CSDN博客] Oracle中用一个序列给两个表创建主键自增功能的后果 [CSDN博客] MySQL自增主键删除后重复问 ...

- MO拆分计划行程序中写入PRODUCTIONORDERS表数据出现重复导致报错(BUG)20180502

错误提示:ORA-00001: 违反唯一约束条件 (ABPPMGR.C0248833319_6192)ORA-06512: 在 "STG.FP_MO_SPLIT", line 19 ...

- Mysql 删除数据表重复行

准备示例数据 以下sql创建表,并将示例数据插入到用于演示的contacts表中. CREATE TABLE contacts ( id INT PRIMARY KEY AUTO_INCREMENT, ...

- List 集合中数据不重复的使用

foreach (DataRow dr in dt.Rows) { list.Add(dr["项目组"].ToString()); } list = list.Distinct&l ...

- 使用Linq判断DataTable数据是否重复

我们一般系统在导入数据的时候,一般都是通过NPOI将excel数据转换成DataTable,然后将DataTable导入到数据库.在数据导入的过程中,其实很重要的一部就是检查DataTable中的数据 ...

- Python操作MySQL数据库,插入重复数据

sql = "INSERT INTO test_c(id,name,sex)values(%s,%s,%s)" param = (1,'AJ','MAN') n = cursor ...

随机推荐

- 【读书圈】win7 定时发送OA邮件

因为win7任务计划本身xls邮件调用有问题,会显示只读权限 我用vbs脚本替代了它的邮件功能!(我现在对vbs的CDO概念也没大弄清,还不知道需不需要外网,等我找台别的内网机器试试) (另外我试验了 ...

- 【快学springboot】10.使用@Async注解创建多线程,自定义线程池

说明 使用@Async注解创建多线程非常的方便,还可以通过配置,实现线程池.比直接使用线程池简单太多.而且在使用上跟普通方法没什么区别,加上个@Async注解即可实现异步调用. 用法 AsyncTas ...

- pygame学习的第一天

pygame最小开发框架: import pygame, sys pygame.init() screen = pygame.display.set_mode((600, 480)) pygame.d ...

- Zero 初识Sciter

在浏览有关Sciter技术前,您需要花点时间浏览以下内容. 您是否需要花时间学习Sciter? 如果您的工作或您想从事的工作与桌面应用开发无关,那么您不需要学习Sciter. 如果您不认同HTML\C ...

- lnmp1.5下安装mongodb

一.安装mongodb .下载MongoDB 2.6.0二进制发行版 $ curl -O http://downloads.mongodb.org/linux/mongodb-linux-x86_64 ...

- Java多线程信号量同步类CountDownLatch与Semaphore

信号量同步是指在不同线程之间,通过传递同步信号量来协调线程执行的先后次序.CountDownLatch是基于时间维度的Semaphore则是基于信号维度的. 1:基于执行时间的同步类CountDown ...

- 学习进度-10 python爬虫

学习爬虫的第一个案例是小说爬虫. 小说爬虫首先是解析小说页面源代码,在页面源代码中可以看到小说每章节的内容链接 爬虫的代码: import requests import re url = 'http ...

- kubernetes集群全栈监控报警方案kube-prometheus

参考文档 http://www.servicemesher.com/blog/prometheus-operator-manual/ https://github.com/coreos/prometh ...

- POJ 3371:Flesch Reading Ease 模拟

Flesch Reading Ease Time Limit: 1000MS Memory Limit: 65536K Total Submissions: 2071 Accepted: 60 ...

- 侯捷C++学习(一)

//c++学习//标准库非常重要//要规范自己的代码complex c1(2,1);complex c2;complex* pc = new complex(0,1);string s1(" ...