测试 【子牙-writing】 大模型

参考:姜子牙大模型系列 | 写作模型ziya-writing开源!开箱即用,快来认领专属你的写作小助手吧

封神榜:https://github.com/IDEA-CCNL/Fengshenbang-LM

姜子牙大模型:https://huggingface.co/IDEA-CCNL/Ziya-LLaMA-13B-v1.1

子牙-writing大模型:

https://huggingface.co/IDEA-CCNL/Ziya-Writing-LLaMa-13B-v1 【老版】

https://huggingface.co/IDEA-CCNL/Ziya-Writing-13B-v2 【最新】

安装环境:一张4090(24G),需量化

引言

ziya-writing模型基于底座模型ziya-llama-13B-pretrain-v1,使用了高质量的中文写作指令数据进行SFT,同时人工标注了大量排序数据进行RLHF。经过两个阶段的精心训练,使得ziya-writing具备了优秀的写作能力。

安装

- 下载模型

git lfs install

git clone https://huggingface.co/IDEA-CCNL/Ziya-Writing-13B-v2.git

- 安装环境

pip install -r requirement.txt

# requirement.txt

transformers>=4.28.1

bitsandbytes>=0.39.0

torch>=1.12.1

numpy>=1.24.3

llama-cpp-python>=0.1.62

测试

使用量化8bit

简单

from transformers import AutoTokenizer

from transformers import LlamaForCausalLM

import torch

# device = torch.device("cuda")

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

path = '/home/trimps/llm_model/Ziya-Writing-13B-v2'

query="帮我写一份去西安的旅游计划"

model = LlamaForCausalLM.from_pretrained(path, load_in_8bit=True,torch_dtype=torch.float16)

# 量化

# model = model.quantize(8).cuda()

tokenizer = AutoTokenizer.from_pretrained(path, use_fast=False)

inputs = '<human>:' + query.strip() + '\n<bot>:'

input_ids = tokenizer(inputs, return_tensors="pt").input_ids.to(device)

generate_ids = model.generate(

input_ids,

max_new_tokens=2048,

do_sample = True,

top_p = 0.85,

temperature = 0.85,

repetition_penalty=1.,

eos_token_id=2,

bos_token_id=1,

pad_token_id=0)

output = tokenizer.batch_decode(generate_ids)[0]

print(output)

Web

import json,time

import torch

import streamlit as st

from transformers import AutoModelForCausalLM, AutoTokenizer

from transformers.generation.utils import GenerationConfig

from transformers import LlamaForCausalLM

st.set_page_config(page_title="Ziya-Writing")

st.title("Ziya-Writing")

path = '/home/trimps/llm_model/Ziya-Writing-13B-v2'

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

@st.cache_resource

def init_model():

model = LlamaForCausalLM.from_pretrained(path, load_in_8bit=True,torch_dtype=torch.float16)

tokenizer = AutoTokenizer.from_pretrained(path, use_fast=False)

return model, tokenizer

# 执行模型

def exec_model(model, tokenizer,prompt):

inputs = '<human>:' + prompt.strip() + '\n<bot> '

input_ids = tokenizer(inputs, return_tensors="pt").input_ids.to(device)

generate_ids = model.generate(

input_ids,

max_new_tokens=1024,

do_sample = True,

top_p = 0.85,

temperature = 0.85,

repetition_penalty=1.,

eos_token_id=2,

bos_token_id=1,

pad_token_id=0)

# print(tokenizer.batch_decode(generate_ids)[0].split('<bot>')[1].strip('</s>'))

output = tokenizer.batch_decode(generate_ids)[0].split('<bot>')[1].strip('</s>')

return output

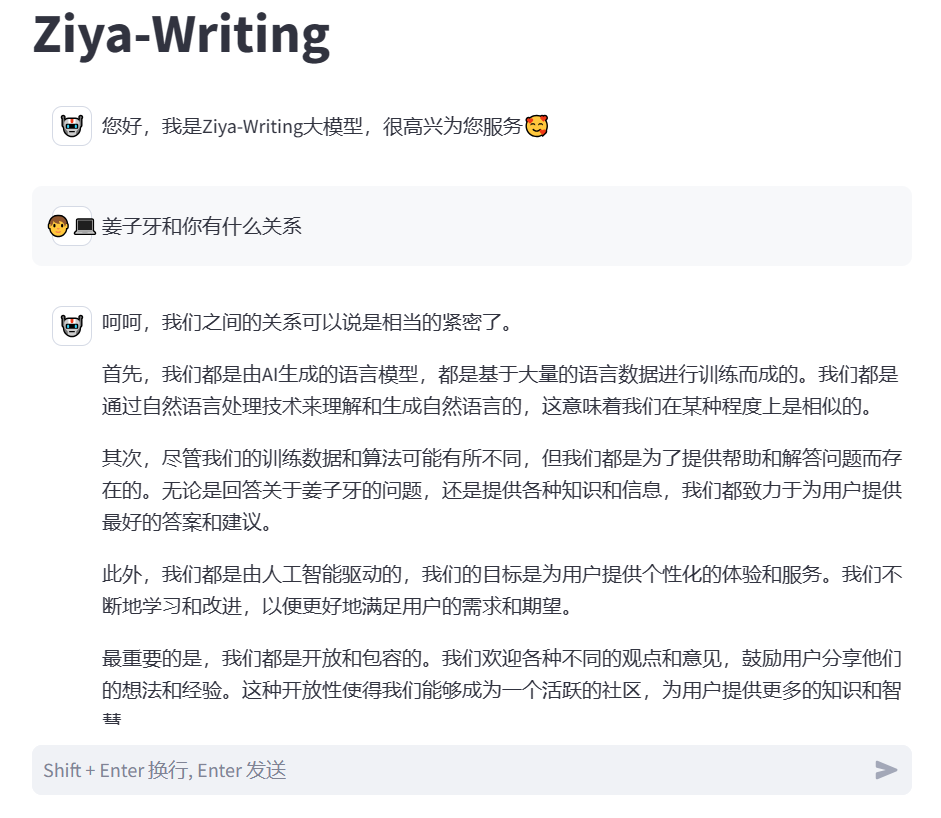

def main():

model, tokenizer = init_model()

with st.chat_message("assistant", avatar=''):

st.markdown("您好,我是Ziya-Writing大模型,很高兴为您服务")

if prompt := st.chat_input("Shift + Enter 换行, Enter 发送"):

with st.chat_message("user", avatar=''):

st.markdown(prompt)

print(f"[user] {prompt}", flush=True)

start = time.time()

with st.chat_message("assistant", avatar=''):

placeholder = st.empty()

response= exec_model(model, tokenizer,prompt)

if torch.backends.mps.is_available():

torch.mps.empty_cache()

placeholder.markdown(response)

end = time.time()

st.write("时间:{}s".format(end-start))

print(response)

if __name__ == "__main__":

main()

- PS:

- 感觉写作能力和通用的模型差不多,比如同体量的(百川2-13B)

- 一张4090跑起来声音快要炸了。

测试 【子牙-writing】 大模型的更多相关文章

- 【测试分析】HTSM模型

◆版权声明:本文出自胖喵~的博客,转载必须注明出处. 转载请注明出处:http://www.cnblogs.com/by-dream/p/5508428.html 概述 HTSM全称Heuristic ...

- 让Quality Center走下神坛--测试管理工具大PK(转)

让Quality Center走下神坛--测试管理工具QC/ALM 和 RQM.Jira.TP.SCTM大PK 在写完了<让QTP走下神坛>之后,现在来谈谈测试管理工具,献给所有正在或打算 ...

- DeepSpeed Chat: 一键式RLHF训练,让你的类ChatGPT千亿大模型提速省钱15倍

DeepSpeed Chat: 一键式RLHF训练,让你的类ChatGPT千亿大模型提速省钱15倍 1. 概述 近日来,ChatGPT及类似模型引发了人工智能(AI)领域的一场风潮. 这场风潮对数字世 ...

- 无插件的大模型浏览器Autodesk Viewer开发培训-武汉-2014年8月28日 9:00 – 12:00

武汉附近的同学们有福了,这是全球第一次关于Autodesk viewer的教室培训. :) 你可能已经在各种场合听过或看过Autodesk最新推出的大模型浏览器,这是无需插件的浏览器模型,支持几十种数 ...

- Android渗透测试Android渗透测试入门教程大学霸

Android渗透测试Android渗透测试入门教程大学霸 第1章 Android渗透测试 Android是一种基于Linux的自由及开放源代码的操作系统,主要用于移动设备,如智能手机.平板等.目前 ...

- PowerDesigner 学习:十大模型及五大分类

个人认为PowerDesigner 最大的特点和优势就是1)提供了一整套的解决方案,面向了不同的人员提供不同的模型工具,比如有针对企业架构师的模型,有针对需求分析师的模型,有针对系统分析师和软件架构师 ...

- 测试TextKit渲染大文本的效率

测试TextKit渲染大文本的效率 TextKit可以用来做精美的电子书,而电子书通常都是txt格式的,那么渲染txt格式的文本的效率如何呢? 以下来进行测试. #import "RootV ...

- PowerDesigner 15学习笔记:十大模型及五大分类

个人认为PowerDesigner 最大的特点和优势就是1)提供了一整套的解决方案,面向了不同的人员提供不同的模型工具,比如有针对企业架构师的模型,有针对需求分析师的模型,有针对系统分析师和软件架构师 ...

- 华为高级研究员谢凌曦:下一代AI将走向何方?盘古大模型探路之旅

摘要:为了更深入理解千亿参数的盘古大模型,华为云社区采访到了华为云EI盘古团队高级研究员谢凌曦.谢博士以非常通俗的方式为我们娓娓道来了盘古大模型研发的"前世今生",以及它背后的艰难 ...

- 文心大模型api使用

文心大模型api使用 首先,我们要获取硅谷社区的连个key 复制两个api备用 获取Access Token 获取access_token示例代码 之后就会输出 作文创作 作文创作:作文创作接口基于文 ...

随机推荐

- 2025年前端面试准备html篇

时光飞逝,一晃已经工作了10年了,2014年一个人背着书包拉着箱子,下火车去做637路公交车的场景历历在目,637路公交车从起点坐到终点,开启了工作的第一站,这趟已经在路上行驶了10年的列车,经历多了 ...

- phpstorm之代码质量工具

在进行php开发的时候, 经常由于编码上的不规范导致了隐藏的bug,这里介绍代码质量工具 PHP CodeSniffer: phpcs [安装] composer require squizla ...

- MySQL之配置my.cnf

1)可以实现直接使用mysql登录MySQL,需要添加配置文件, 进行客户端配置即可 ~/.my.cnf [client] port = 3306 socket = /var/lib/mysql/my ...

- kettle 简单使用

概要 KETTLE 是一个ETL工具,它可以在不同的数据源之间进行数据的抽取转换.下面简单介绍一下他是如何使用的. 下载 https://nchc.dl.sourceforge.net/project ...

- TypeScript 笔记(一)

1. TypeScript 的介绍 完整教程TypeScript 入门教程 TypeScript 是 JavaScript 的一个超集,支持 ECMAScript 6 标准,由微软开发的自由和开源的编 ...

- cve-2021-3156-sudo堆溢出简单分析

调试方式 首先从github下载代码 https://github.com/sudo-project/sudo/archive/SUDO_1_9_5p1.tar.gz 编译 tar xf sudo-S ...

- codeforces 1978 D. Elections

题目链接 https://codeforces.com/problemset/problem/1978/D 题意 对于每个测试用例,共有 \(n\) 个人,每个人的号码分别是 \(1,2,...,n\ ...

- Flutter之GetX之GetBuilder

Flutter之GetX之GetBuilder GetX是Flutter的一个非常强力的三方库,包含了非常多的功能,比如状态管理.路由管理.国际化.路由中间件.主题.数据库等等 今天简单介绍一下状态管 ...

- Http请求报文(请求行,请求头、请求体)

Http请求报文: http请求报文由3部分组成,请求行,请求头,请求体. 一.请求行: 请求方法.URL地址.协议版本 请求方法:POST.GET.DELETE.PUT.HEAD.OPTIONS.T ...

- eShopOnContainer 中 Grpc 服务定义与实现

eShopOnContainer 中 Grpc 服务定义与实现 服务于前端的后端 (BFF) 模式是 API 网关模式的一种变形,针对外部使用者的不同需求,为每种不同的客户端使用者提供一种后端 API ...