关于Java序列化和Hadoop的序列化

import java.io.DataInput;

import java.io.DataOutput;

import java.io.DataOutputStream;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.ObjectOutputStream;

import java.io.Serializable; import org.apache.hadoop.io.Writable; public class Test2 {

public static void main(String[] args) throws IOException {

Student stu = new Student(1, "张三");

FileOutputStream fileOutputStream = new FileOutputStream("d:/111");

ObjectOutputStream objectOutputStream = new ObjectOutputStream(fileOutputStream);

objectOutputStream.writeObject(stu);

objectOutputStream.close();

fileOutputStream.close();

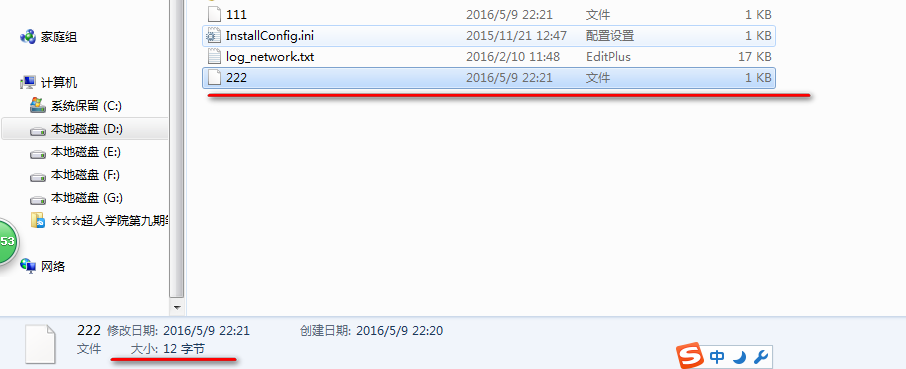

//我们一般只关注stu对象的id和name两个属性总共12个字节.但是Java的序列化到硬盘上的文件有175个字节.

//Java序列化了很多没有必要的信息.如果要序列化的数据有很多,那么序列化到磁盘上的数据会更多,非常的浪费.

//Hadoop没有使用Java的序列化机制.如果采用会造成集群的网络传输的时间和流量都集聚的增长.

//Hadoop中自己定义了一个序列化的接口Writable.

//Java序列化中之所以信息多是因为把 类之间的的继承多态信息都包含了. StuWritable stu2 = new StuWritable(1, "张三");

FileOutputStream fileOutputStream2 = new FileOutputStream("d:/222");

DataOutputStream dataOutputStream2 = new DataOutputStream(fileOutputStream2);

stu2.write(dataOutputStream2);

fileOutputStream2.close();

dataOutputStream2.close();

}

} class Student implements Serializable{

private Integer id;

private String name; public Student() {

super();

}

public Student(Integer id, String name) {

super();

this.id = id;

this.name = name;

}

public Integer getId() {

return id;

}

public void setId(Integer id) {

this.id = id;

}

public String getName() {

return name;

}

public void setNameString(String name) {

this.name = name;

} } class StuWritable implements Writable{

private Integer id;

private String name; public StuWritable() {

super();

}

public StuWritable(Integer id, String name) {

super();

this.id = id;

this.name = name;

}

public Integer getId() {

return id;

}

public void setId(Integer id) {

this.id = id;

}

public String getName() {

return name;

}

public void setNameString(String name) {

this.name = name;

} public void write(DataOutput out) throws IOException {

out.writeInt(id);

out.writeUTF(name);

} public void readFields(DataInput in) throws IOException {

this.id = in.readInt();

this.name = in.readUTF();

} }

使用Java序列化接口对应的磁盘上的文件: 共175个字节

使用Hadoop序列化机制对应的磁盘文件: 共12字节

如果类中有继承关系:

import java.io.DataInput;

import java.io.DataOutput;

import java.io.DataOutputStream;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.ObjectOutputStream;

import java.io.Serializable; import org.apache.hadoop.io.Writable; public class Test2 {

public static void main(String[] args) throws IOException {

//我们一般只关注stu对象的id和name两个属性总共12个字节.但是Java的序列化到硬盘上的文件有175个字节.

//Java序列化了很多没有必要的信息.如果要序列化的数据有很多,那么序列化到磁盘上的数据会更多,非常的浪费.

//Hadoop没有使用Java的序列化机制.如果采用会造成集群的网络传输的时间和流量都集聚的增长.

//Hadoop中自己定义了一个序列化的接口Writable.

//Java序列化中之所以信息多是因为把 类之间的的继承多态信息都包含了.再重新构建的时候可以保持原有的关系. StuWritable stu2 = new StuWritable(1, "张三");

stu2.setSex(true);

FileOutputStream fileOutputStream2 = new FileOutputStream("d:/222");

DataOutputStream dataOutputStream2 = new DataOutputStream(fileOutputStream2);

stu2.write(dataOutputStream2);

fileOutputStream2.close();

dataOutputStream2.close();

}

} class StuWritable extends Person implements Writable{

private Integer id;

private String name; public StuWritable() {

super();

}

public StuWritable(Integer id, String name) {

super();

this.id = id;

this.name = name;

}

public Integer getId() {

return id;

}

public void setId(Integer id) {

this.id = id;

}

public String getName() {

return name;

}

public void setNameString(String name) {

this.name = name;

} public void write(DataOutput out) throws IOException {

out.writeInt(id);

out.writeBoolean(super.isSex());

out.writeUTF(name);

} public void readFields(DataInput in) throws IOException {

this.id = in.readInt();

super.setSex(in.readBoolean());

this.name = in.readUTF();

} } class Person{

private boolean sex; public boolean isSex() {

return sex;

} public void setSex(boolean sex) {

this.sex = sex;

} }

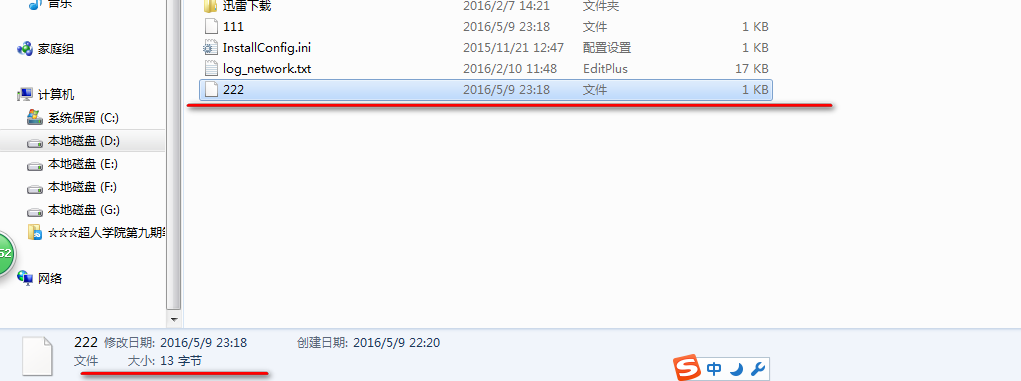

这样序列化到磁盘上的文件: 13个字节 多了一个boolean属性,相比上面多了一个字节.

如果实例化对象中含有类对象.

import java.io.DataInput;

import java.io.DataOutput;

import java.io.DataOutputStream;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.ObjectOutputStream;

import java.io.Serializable; import org.apache.hadoop.io.Writable; public class Test2 {

public static void main(String[] args) throws IOException {

//我们一般只关注stu对象的id和name两个属性总共12个字节.但是Java的序列化到硬盘上的文件有175个字节.

//Java序列化了很多没有必要的信息.如果要序列化的数据有很多,那么序列化到磁盘上的数据会更多,非常的浪费.

//Hadoop没有使用Java的序列化机制.如果采用会造成集群的网络传输的时间和流量都集聚的增长.

//Hadoop中自己定义了一个序列化的接口Writable.

//Java序列化中之所以信息多是因为把 类之间的的继承多态信息都包含了.再重新构建的时候可以保持原有的关系. StuWritable stu2 = new StuWritable(1, "张三");

stu2.setSex(true);

FileOutputStream fileOutputStream2 = new FileOutputStream("d:/222");

DataOutputStream dataOutputStream2 = new DataOutputStream(fileOutputStream2);

stu2.write(dataOutputStream2);

fileOutputStream2.close();

dataOutputStream2.close();

}

} class StuWritable extends Person implements Writable{

private Integer id;

private String name;

private Student student; public StuWritable() {

super();

}

public StuWritable(Integer id, String name) {

super();

this.id = id;

this.name = name;

}

public Integer getId() {

return id;

}

public void setId(Integer id) {

this.id = id;

}

public String getName() {

return name;

}

public void setNameString(String name) {

this.name = name;

} public void write(DataOutput out) throws IOException {

out.writeInt(id);

out.writeBoolean(super.isSex());

out.writeUTF(name);

out.writeInt(student.getId());

out.writeUTF(student.getName());

} public void readFields(DataInput in) throws IOException {

this.id = in.readInt();

super.setSex(in.readBoolean());

this.name = in.readUTF();

this.student = new Student(in.readInt(),in.readUTF());

} } class Person{

private boolean sex; public boolean isSex() {

return sex;

} public void setSex(boolean sex) {

this.sex = sex;

} }

如果我们Student中有个字段是Writable类型的.

怎么样序列化?

关于Java序列化和Hadoop的序列化的更多相关文章

- 为什么hadoop中用到的序列化不是java的serilaziable接口去序列化而是使用Writable序列化框架

继上一个模块之后,此次分析的内容是来到了Hadoop IO相关的模块了,IO系统的模块可谓是一个比较大的模块,在Hadoop Common中的io,主要包括2个大的子模块构成,1个是以Writable ...

- Hadoop 的序列化

1. 序列化 1.1 序列化与反序列化的概念 序列化:是指将结构化对象转化成字节流在网上传输或写到磁盘进行永久存储的过程 反序列化:是指将字节流转回结构化对象的逆过程 1.2 序列化的应用 序列化用于 ...

- Hadoop基础-序列化与反序列化(实现Writable接口)

Hadoop基础-序列化与反序列化(实现Writable接口) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.序列化简介 1>.什么是序列化 序列化也称串行化,是将结构化 ...

- 大数据框架hadoop的序列化机制

Java内建序列化机制 在Windows系统上序列化的Java对象,可以在UNIX系统上被重建出来,不需要担心不同机器上的数据表示方法,也不需要担心字节排列次序. 在Java中,使一个类的实例可被序列 ...

- java中可定制的序列化过程 writeObject与readObject

来源于:[http://bluepopopo.iteye.com/blog/486548] 什么是writeObject 和readObject?可定制的序列化过程 这篇文章很直接,简单易懂.尝试着翻 ...

- java io系列06之 序列化总结(Serializable 和 Externalizable)

本章,我们对序列化进行深入的学习和探讨.学习内容,包括序列化的作用.用途.用法,以及对实现序列化的2种方式Serializable和Externalizable的深入研究. 转载请注明出处:http: ...

- spring mvc返回json字符串数据,只需要返回一个java bean对象就行,只要这个java bean 对象实现了序列化serializeable

1.spring mvc返回json数据,只需要返回一个java bean对象就行,只要这个java bean 对象实现了序列化serializeable 2. @RequestMapping(val ...

- Java中对文件的序列化和反序列化

public class ObjectSaver { public static void main(String[] args) throws Exception { /*其中的 D:\\objec ...

- Java复习——I/O与序列化

File类 java.io.File只用于表示文件(目录)的信息(名称.大小等),不能用于文件内容的访问,我们可以通过通过给其构造函数传一个路径来构建以文件,传入的路径名有一个小问题,就是Window ...

随机推荐

- Winter is coming Just have a little faith. JSF框架简介与实例

JSF 体系结构: JSF 的主要优势之一就是它既是Java Web应用程序的用户界面标准又是严格遵循模型-视图-控制器 (MVC) 设计模式的框架.用户界面代码(视图)与应用程序数据和逻辑(模型)的 ...

- MySQL索引的创建,查看,删除

在执行CREATE TABLE语句时可以创建索引,也可以单独用CREATE INDEX或ALTER TABLE来为表增加索引. 1.ALTER TABLE ALTER TABLE用来创建普通索引.UN ...

- hbase 学习笔记一---基本概念

说在前面,本文部分内容来源于社区官网经过适度翻译,部分根据经验总结,部分是抄袭网络博文,(不一一列举引用,在此致歉)一并列在一起,本文的目的,希望能总结出一些有用的,应该注意到的东西,基本 ...

- HDU 4438 Hunters (数学,概率计算)

题意:猎人A和B要进行一场比赛.现在有两个猎物老虎和狼,打死老虎可以得X分,打死狼可以得Y分.现在有两种情况: (1)如果A与B的预定目标不同,那么他们都将猎到预定的目标. (2)如果A与B的预定目标 ...

- 菜鸟学习 git

到新公司学习和使用 git 有一段时间了.不得不说 git 真的很牛逼,当然,git 的牛逼是建立在 Linux 之父的牛逼的基础上的. 首先跪着推荐 git 学习网站:http://www.liao ...

- Ehcache(02)——ehcache.xml简介

http://haohaoxuexi.iteye.com/blog/2113728 ehcache.xml简介 ehcache.xml文件是用来定义Ehcache的配置信息的,更准确的来说它是定义Ca ...

- Python3.5.2官方文档学习备忘录

网址:https://docs.python.org/3/ 虽然学习官方文档有些耗时,不过看最原版的还是感觉好一点,原汁原味没有曲解没有省略. 从命令行向Python传递参数,运行:python - ...

- vsftpd 权限设置

vsftpd 虚拟用户 多用户不同权限 2010-06-27 00:54:20| 分类: linux大杂绘|举报|字号 订阅 1.需要建立一个用户,这个用户是linux系统的本地用户,各ft ...

- asp.net中使用swfupload上传大文件

转载:http://www.cnblogs.com/niunan/archive/2012/01/12/2320705.html 花了一天多时间研究出来的,其实也就是网上下别人的代码然后再自己修修改改 ...

- java中匿名类的讲解

匿名内部类也就是没有名字的内部类 正因为没有名字,所以匿名内部类只能使用一次,它通常用来简化代码编写 但使用匿名内部类还有个前提条件:必须继承一个父类或实现一个接口 实例1:不使用匿名内部类来实现抽象 ...