Apache下通过shell脚本提交网站404死链

网站运营人员对于死链这个概念一定不陌生,网站的一些数据删除或页面改版等都容易制造死链,影响用户体验不说,过多的死链还会影响到网站的整体权重或排名。

百度站长平台提供的死链提交工具,可将网站存在的死链(协议死链、404页面)进行提交,可快速删除死链,帮助网站SEO优化。在提交死链的文件中逐个手动填写死链的话太麻烦,工作中我们提倡复杂自动化,所以本文我们一起交流分享Apache服务中通过shell脚本整理网站死链,便于我们提交。

1.配置Apache记录搜索引擎

Apache是目前网站建设最为主流的web服务,但是apache的日志文件默认是不记录百度、谷歌等各大搜索引擎的爬取程序的,所以首先需要我们设置Apache的配置文件。

找到Apache的配置文件httpd.conf,在配置文件中找到下面两行:

CustomLog "logs/access_log" common

#CustomLog "logs/access_log" combined

默认采用的是common,这里我们只需要将common这一行前面加#注释掉,然后将combined这一行前的#去掉即可。然后保存重启Apache服务。

注:如果你的服务器上添加了多个站点,每个站点有单独的配置文件,则我们只需要在相应站点的配置文件中设置CustomLog项即可,例如:

vim /usr/local/apache/conf/vhost/www.chanzhi.org.conf

ServerAdmin [email protected] DocumentRoot "/data/wwwroot/www.chanzhi.org"

ServerName www.chanzhi.org

ServerAlias chanzhi.org

ErrorLog "/data/wwwlogs/www.chanzhi.org_error_apache.log"

CustomLog "/data/wwwlogs/www.chanzhi.org_apache.log" combined

SetOutputFilter DEFLATE

Options FollowSymLinks ExecCGI

Require all granted

AllowOverride All

Order allow,deny

Allow from all

DirectoryIndex index.html index.php

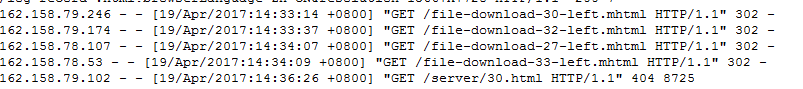

下面是配置前后的网站日志记录格式:

配置前:

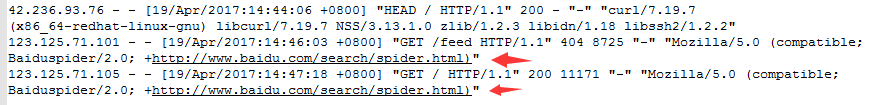

配置后:

2.编写shell脚本

我们通过shell脚本获取网站日志中指定爬虫的抓取记录,然后汇总到一个文件中,便于后期使用。代码如下,比如保存为deathlink.sh

#!/bin/bash

#初始化变量

#定义蜘蛛UA信息(默认是百度蜘蛛)

UA='+http://www.baidu.com/search/spider.html' #前一天的日期(apache日志)

DATE=`date +%Y%m%d -d "1 day ago"` #定义日志路径

logfile=/data/wwwlogs/www.chanzhi.org_apache.log-${DATE}.log #定义死链文件存放路径

deathfile=/data/wwwroot/www.chanzhi.org/deathlink.txt #定义网站访问地址

website=http://www.chanzhi.org #分析日志并保存死链数据

for url in `awk -v str="${UA}" '$9=="404" && $15~str {print $7}' ${logfile}`

do

grep -q "$url" ${deathfile} || echo ${website}${url} >>${deathfile}

done

大家在使用该脚本时,根据自己服务器情况调整下路径和字段即可,然后执行脚本,:

bash deathlink.sh

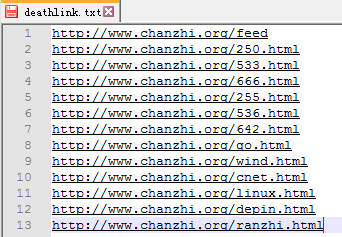

3.提交死链

执行上面脚本时候,就会在指定目录下生成包含所有获取的404页面链接的文件,每个连接占一行。例如:

最后在站长平台提交死链页面中,填写自己的死链文件地址即可,例如:

百度在审核通过之后,会将已经收录的失效链接删除,以避免失效页面链接对网站造成不良的影响。

总结:

本文和大家分享了在Apache服务环境下,如何利用shell脚本自动获取百度蜘蛛等爬虫抓取的死链,并生成汇总文件提交给搜索引擎。如果大家还有其他更好的方法或者疑问,欢迎一起分享交流。

Apache下通过shell脚本提交网站404死链的更多相关文章

- 利用shell脚本批量提交网站404死链给百度

网站运营人员对于死链这个概念一定不陌生,网站的一些数据删除或页面改版等都容易制造死链,影响用户体验不说,过多的死链还会影响到网站的整体权重或排名. 百度站长平台提供的死链提交工具,可将网站存在的死链( ...

- mac终端下运行shell脚本

最近公司要弄关于IOS下自动化打包的东西,研究了用命令行的形式来代替手工的方式来处理.即: 用xcodebuild 和xcrun 语法来进行脚本实现. 但由于语法的结构够了,另一个问题产生了, ...

- Linux下添加shell脚本使得nginx日志每天定时切割压缩

Linux下添加shell脚本使得nginx日志每天定时切割压缩一 简介 对于nginx的日志文件,特别是access日志,如果我们不做任何处理的话,最后这个文件将会变得非常庞大 这时,无论是出现异常 ...

- 【git】之使用shell脚本提交代码

为减少提交步骤,防止提交错误,使用Shell脚本进行git提交不失一件好事 #!/bin/sh # @author Hubal # @Email Hubal@123.com # @createBy - ...

- 在windows下编写shell脚本

注意两点: 1.第一行:#!/bin/bash 2.将文档格式转换为unix,因为在windows下编写shell脚本回车符是\n\r,而linux下的回车符是\n,所以在linux下运行脚本的时候, ...

- shell脚本监控网站状态

shell脚本监控网站状态 #!/bin/sh date=`date +"%Y%m%d-%H%M"` title="status" contentFail=&q ...

- linux下实现shell脚本自动连接mongodb数据库并创建索引

在linux下创建shell脚本

- CentOS下编写shell脚本来监控MySQL主从复制的教程

这篇文章主要介绍了在CentOS系统下编写shell脚本来监控主从复制的教程,文中举了两个发现故障后再次执行复制命令的例子,需要的朋友可以参考下 目的:定时监控MySQL主从数据库是否同步,如果不同步 ...

- 2019.11.13课堂实验之用Linux下的shell脚本完成两文本交替输出

有两个文本如下,实际中并不知道两文本各有多少行: 文本1.txt aaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaaa ccccccccccccccccccccccccccc ...

随机推荐

- python 关于列表的增删改查及个别的命令

names = ["a","b","c","d","e","e","a ...

- httpd2.4常用配置

author:JevonWei 版权声明:原创作品 httpd 2.4配置 切换使用的MPM Centos7:/etc/httpd/conf.modules.d/00-mpm.conf 启用要启用的M ...

- MQ、JMS以及ActiveMQ 关系的理解

详见:http://blog.yemou.net/article/query/info/tytfjhfascvhzxcyt127 Best-text mb-10代码 ms 的一个标准或者说是一个协议. ...

- LDMIA、LDMIB、LDMDB、LDMDA、STMIA、LDMFD、LDMFA、LDMED、LDMEA指令详解

简介: ARM指令中多数据传输共有两种: LDM:(load much)多数据加载,将地址上的值加载到寄存器上 STM:(store much)多数据存储,将寄存器的值存到地址上 主要用途:现场保护 ...

- STEP 7-MicroWIN SMART 西门子PLC再次安装问题

我的电脑第一次安装s7(STEP 7-MicroWIN SMART 西门子PLC)是没有问题的,有一次不小心删除,再次安装却怎么也安装不上.猫那个咪的!Why! 网上各种查资料,完全不能解决问题,有的 ...

- python-分页代码

page.py ''' django内使用方式: all_count = models.UserInfo.objects.all().count() # path_info 当前页的url # all ...

- mpls vpn剩余笔记

将IP地址映射为简单的具有固定长度的标签 用于快速数据包交换 20 3 1 8 在整个转发过程中,交换节点仅根据标记进行转发 标签交换路径(LSP) 多协议标签交换MPLS最初是为了提高转发速度而提出 ...

- 团队作业2--需求分析&原型设计

一.需求分析 1.用户采访 a.采访对象: 分别对本学院同学.其他专业同学.部分老师等总计15人进行了采访调研: b.采访截图: c.采访总结: (1).功能需求 能够将所提供的四个数进 ...

- GUI(JMenuBar+JMenu+JMenuItem)

public class WindowMenu extends JFrame { JMenuBar menubar; JMenu menu,subMenu; JMenuItem item1,item2 ...

- 【Alpha阶段汇总】成果展示与体验总结

一.燃尽图 二.软件截图 三.代码与图片.音乐素材仓库 git仓库 四.问题与总结 1.git提交问题 之前创建的仓库地址是http://git.oschina.net/8265559926/grou ...