神经网络高维互信息计算Python实现(MINE)

论文

Belghazi, Mohamed Ishmael, et al. “ Mutual information neural estimation .” International Conference on Machine Learning . 2018.

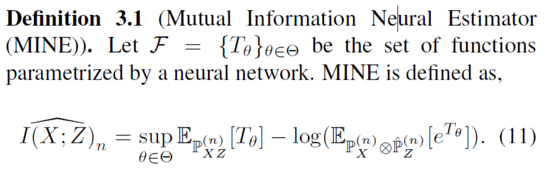

利用神经网络的梯度下降法可以实现快速高维连续随机变量之间互信息的估计,上述论文提出了Mutual Information Neural Estimator (MINE)。NN在维度和样本量上都是线性可伸缩的,MI的计算可以通过反向传播进行训练。

核心

Python实现

现有github上的代码无法计算和估计高维随机变量,只能计算一维随机变量,下面的代码给出的修改方案能够计算真实和估计高维随机变量的真实互信息。

其中,为了计算理论的真实互信息,我们不直接暴力求解矩阵(耗时,这也是为什么要有MINE的原因),我们采用给定生成随机变量的参数计算理论互信息。

SIGNAL_NOISE = 0.2

SIGNAL_POWER = 3

完整代码基于pytorch

# Name: MINE_simple

# Author: Reacubeth

# Time: 2020/12/15 18:49

# Mail: noverfitting@gmail.com

# Site: www.omegaxyz.com

# *_*coding:utf-8 *_*

import numpy as np

import torch

import torch.nn as nn

from tqdm import tqdm

import matplotlib.pyplot as plt

SIGNAL_NOISE = 0.2

SIGNAL_POWER = 3

data_dim = 3

num_instances = 20000

def gen_x(num, dim):

return np.random.normal(0., np.sqrt(SIGNAL_POWER), [num, dim])

def gen_y(x, num, dim):

return x + np.random.normal(0., np.sqrt(SIGNAL_NOISE), [num, dim])

def true_mi(power, noise, dim):

return dim * 0.5 * np.log2(1 + power/noise)

mi = true_mi(SIGNAL_POWER, SIGNAL_NOISE, data_dim)

print('True MI:', mi)

hidden_size = 10

n_epoch = 500

class MINE(nn.Module):

def __init__(self, hidden_size=10):

super(MINE, self).__init__()

self.layers = nn.Sequential(nn.Linear(2 * data_dim, hidden_size),

nn.ReLU(),

nn.Linear(hidden_size, 1))

def forward(self, x, y):

batch_size = x.size(0)

tiled_x = torch.cat([x, x, ], dim=0)

idx = torch.randperm(batch_size)

shuffled_y = y[idx]

concat_y = torch.cat([y, shuffled_y], dim=0)

inputs = torch.cat([tiled_x, concat_y], dim=1)

logits = self.layers(inputs)

pred_xy = logits[:batch_size]

pred_x_y = logits[batch_size:]

loss = - np.log2(np.exp(1)) * (torch.mean(pred_xy) - torch.log(torch.mean(torch.exp(pred_x_y))))

# compute loss, you'd better scale exp to bit

return loss

model = MINE(hidden_size)

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)

plot_loss = []

all_mi = []

for epoch in tqdm(range(n_epoch)):

x_sample = gen_x(num_instances, data_dim)

y_sample = gen_y(x_sample, num_instances, data_dim)

x_sample = torch.from_numpy(x_sample).float()

y_sample = torch.from_numpy(y_sample).float()

loss = model(x_sample, y_sample)

model.zero_grad()

loss.backward()

optimizer.step()

all_mi.append(-loss.item())

fig, ax = plt.subplots()

ax.plot(range(len(all_mi)), all_mi, label='MINE Estimate')

ax.plot([0, len(all_mi)], [mi, mi], label='True Mutual Information')

ax.set_xlabel('training steps')

ax.legend(loc='best')

plt.show()

结果

变量维度为1

变量维度为3

需要指出的是在计算最终的互信息时需要将基数e转为基数2。如果只是求得一个比较值,在真实使用的过程中可以省略。

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理

想要获取更多Python学习资料可以加

QQ:2955637827私聊

或加Q群630390733

大家一起来学习讨论吧!

神经网络高维互信息计算Python实现(MINE)的更多相关文章

- 基于神经网络的混合计算(DNC)-Hybrid computing using a NN with dynamic external memory

前言: DNC可以称为NTM的进一步发展,希望先看看这篇译文,关于NTM的译文:人工机器-NTM-Neutral Turing Machine 基于神经网络的混合计算 Hybrid computing ...

- 北京地铁月度消费总金额计算(Python版)

最近业余时间在学习Python,这是那天坐地铁时突发奇想,想看看我这一个月的地铁费共多少钱,所以简单的构思了下思路,就直接开写了,没想到用Python来实现还挺简单的. 设计思路: 每次乘车正常消费7 ...

- 函数计算 Python 连接 SQL Server 小结

python 连接数据库通常要安装第三方模块,连接 MS SQL Server 需要安装 pymssql .由于 pymsql 依赖于 FreeTDS,对于先于 2.1.3 版本的 pymssql,需 ...

- GIL计算python 2 和 python 3 计算密集型

首先我画了一张图来表示GIL运行的方式: Python 3执行如下计算代码:#-*-conding:utf-8-*-import threading import timedef add(): n = ...

- 计算Python运行时间

可以调用datetime 或者 time库实现得到Python运行时间 方法1 import datetime start_t = datetime.datetime.now() #运行大型代码 e ...

- 机器学习作业(四)神经网络参数的拟合——Python(numpy)实现

题目下载[传送门] 题目简述:识别图片中的数字,训练该模型,求参数θ. 出现了一个问题:虽然训练的模型能够有很好的预测准确率,但是使用minimize函数时候始终无法成功,无论设计的迭代次数有多大,如 ...

- 相似度与距离计算python代码实现

#定义几种距离计算函数 #更高效的方式为把得分向量化之后使用scipy中定义的distance方法 from math import sqrt def euclidean_dis(rating1, r ...

- 计算Python代码运行时间长度方法

在代码中有时要计算某部分代码运行时间,便于分析. import time start = time.clock() run_function() end = time.clock() print st ...

- 菜鸟之路——机器学习之BP神经网络个人理解及Python实现

关键词: 输入层(Input layer).隐藏层(Hidden layer).输出层(Output layer) 理论上如果有足够多的隐藏层和足够大的训练集,神经网络可以模拟出任何方程.隐藏层多的时 ...

随机推荐

- jenkins master/slave模式

master是主机,只有master装jenkins slave是小弟机无需装jenkins,主要执行master分配的任务 一.新建slave 1.新建slave的方法:点击magian jenki ...

- CollectionUtils和StringUtils

1.StringUtils(常用-用来操作String的字符串)1.1 判断某字符串是否为空isEmpty StringUtils.isEmpty(null) = true StringUtils.i ...

- Contest 991

A 先判合法然后容斥. 时间复杂度 \(O\left(1\right)\). B 贪心选最小的实验做成 \(5\) 分. 时间复杂度 \(O\left(n\right)\). 剩下的鸽了.

- JDBC【2】-- JDBC工作原理以及简单封装

目录 1. 工作原理 1.1 加载驱动 1.1.1 类加载相关知识 1.1.2 为什么JDK 1.6之后不需要显示加载了? 1.2 驱动加载完成了,然后呢? 2. 简单封装 1. 工作原理 一般我们主 ...

- 【mq读书笔记】消息消费过程(钩子 失败重试 消费偏移记录)

在https://www.cnblogs.com/lccsblog/p/12249265.html中,PullMessageService负责对消息队列进行消息拉取,从远端服务器拉取消息后将消息存入P ...

- rsync单项同步

配置rsync+inotify实时单向同步 定期同步的缺点: 执行备份的时间固定,延期明显,实时性差 当同步源长期不变化时,密集的定期任务是不必要的(浪费资源) 实时同步的优点: 一旦同步源出现变化, ...

- 【论文解读】【半监督学习】【Google教你水论文】A Simple Semi-Supervised Learning Framework for Object Detection

题记:最近在做LLL(Life Long Learning),接触到了SSL(Semi-Supervised Learning)正好读到了谷歌今年的论文,也是比较有点开创性的,浅显易懂,对比实验丰富, ...

- fist-第八天冲刺随笔

这个作业属于哪个课程 https://edu.cnblogs.com/campus/fzzcxy/2018SE1 这个作业要求在哪里 https://edu.cnblogs.com/campus/fz ...

- JZOJ 11.14 提高B组反思

JZOJ 11.14 提高B组反思 T1 题目虽然有点高大上,但是很容易懂 有一个\(d\)维空间,同时有一个长度为\(2n\)的操作序列,每个操作往某一维的正方向或反方向走一格,问多少种方案使得最后 ...

- CNVD漏洞证书(2)

第二张CNVD的原创漏洞证书. 关于证书申请可以看我之前写的这篇博客: https://www.cnblogs.com/Cl0ud/p/12720413.html 继续加油