filebeat -> logstash -> elasticsearch -> kibana ELK 日志收集搭建

Filebeat 安装参考 http://blog.csdn.net/kk185800961/article/details/54579376

elasticsearch 安装参考http://blog.csdn.net/kk185800961/article/details/54175291

kibana 安装参考 http://blog.csdn.net/kk185800961/article/details/54232097

logstash 安装参考 http://blog.csdn.net/kk185800961/article/details/54430493

我这里用的是 5.6.2 版本,国内下载很慢

这里是我的百度盘分享 Filebeat + logstash + elasticsearch + kibana

链接:http://pan.baidu.com/s/1i5rHXvZ 密码:lisn

使用filebeat,springboot 项目不再需要集成 logstash-logback-encoder ,输出到logstash,再转换为json

关于elasticsearch 安装 需要注意 下面一段操作是需要root权限的

# vi /etc/security/limits.conf

elsearch soft nofile 65536

elsearch hard nofile 65536

elsearch soft nproc 2048

elsearch hard nproc 2048

# vi /etc/sysctl.conf

vm.max_map_count=262144

# sysctl -p

filebeat配置输出到logstash

[root@192 filebeat]# vi filebeat.yml

- input_type: log

# Paths that should be crawled and fetched. Glob based paths.

paths:

- /usr/local/log/*.log #可以配置多个路径 注释

#output.elasticsearch:

# Array of hosts to connect to.

#hosts: ["localhost:9200"] # Optional protocol and basic auth credentials.

#protocol: "https"

#username: "elastic"

#password: "changeme" 解开注释:

output.logstash:

# The Logstash hosts

hosts: ["192.168.1.10:5044"]

index: "filebeat" #索引根名称

创建logstash.conf,启动logstash -f logstash.conf

input{

beats {

port => 5044

codec => json # 直接将filebeat保存在message中的json字串解析出来

}

}

filter {

mutate {

remove_field => ["tags", "beat"]

#删除filebeat自动添加的字段

}

}

output {

elasticsearch {

hosts => ["192.168.1.10:9200"]

index => "logstash" #用这个在kibana页面上创建索引

}

stdout {

codec => rubydebug

}

}

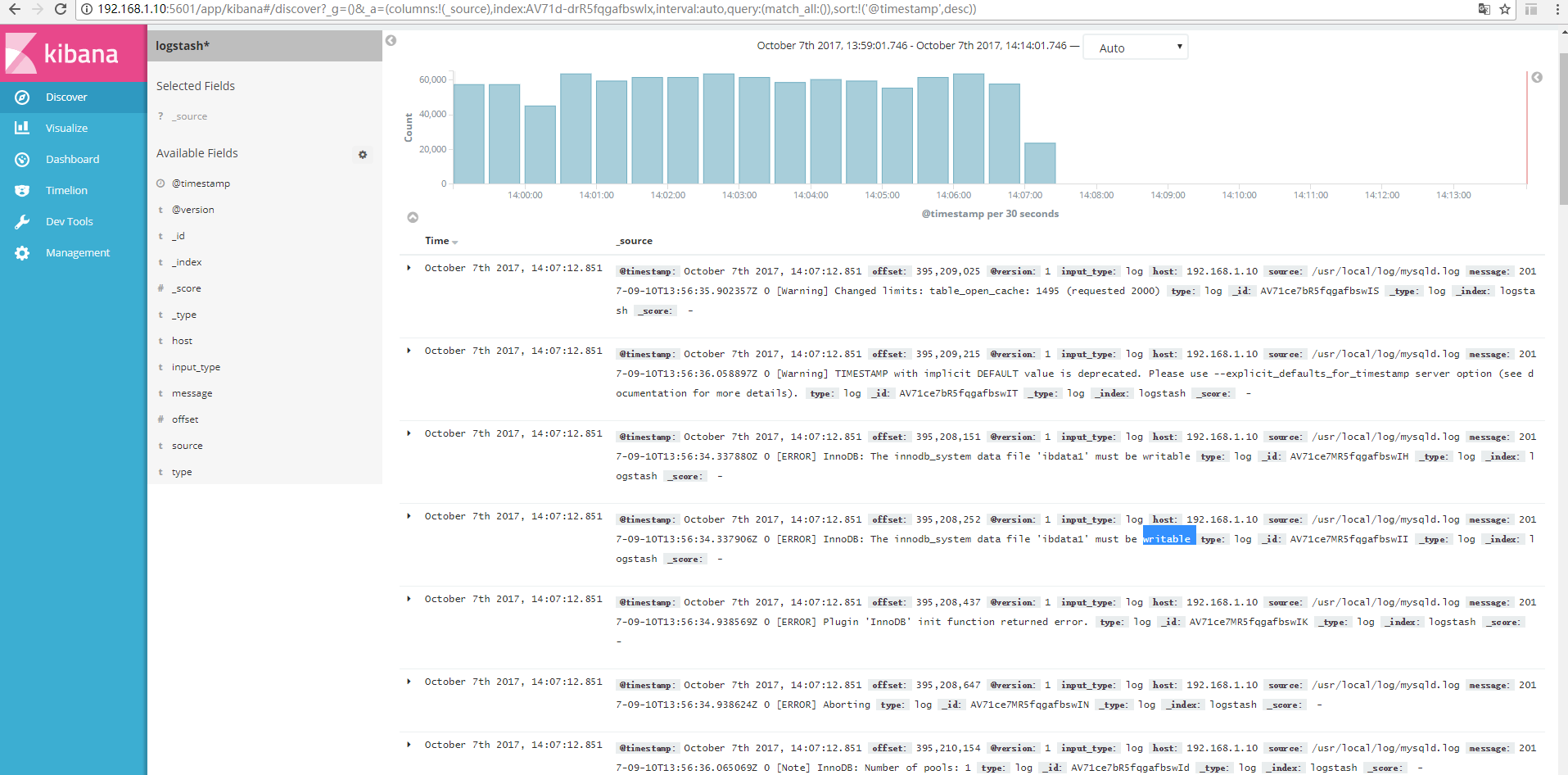

把mysqld.log放入/usr/local/log/ 测试用.

filebeat -> logstash -> elasticsearch -> kibana ELK 日志收集搭建的更多相关文章

- 基于logstash+elasticsearch+kibana的日志收集分析方案(Windows)

一 方案背景 通常,日志被分散的储存不同的设备上.如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志.这样是不是感觉很繁琐和效率低下.开源实时日志分析ELK平台能够完美的 ...

- Nginx filebeat+logstash+Elasticsearch+kibana实现nginx日志图形化展示

filebeat+logstash+Elasticsearch+kibana实现nginx日志图形化展示 by:授客 QQ:1033553122 测试环境 Win7 64 CentOS-7- ...

- Filebeat+Logstash+ElasticSearch+Kibana搭建Apache访问日志解析平台

对于ELK还不太熟悉的同学可以参考我前面的两篇文章ElasticSearch + Logstash + Kibana 搭建笔记.Log stash学习笔记(一),本文搭建了一套专门访问Apache的访 ...

- logstash+elasticsearch+kibana管理日志(安装)

logstash1.先安装jdk2.wget https://download.elastic.co/logstash/logstash/logstash-2.4.0.tar.gz tar -xzvf ...

- FILEBEAT+ELK日志收集平台搭建流程

filebeat+elk日志收集平台搭建流程 1. 整体简介: 模式:单机 平台:Linux - centos - 7 ELK:elasticsearch.logstash.kiban ...

- 使用logstash+elasticsearch+kibana快速搭建日志平台

日志的分析和监控在系统开发中占非常重要的地位,系统越复杂,日志的分析和监控就越重要,常见的需求有: * 根据关键字查询日志详情 * 监控系统的运行状况 * 统计分析,比如接口的调用次数.执行时间.成功 ...

- logstash+elasticsearch+kibana快速搭建日志平台

使用logstash+elasticsearch+kibana快速搭建日志平台 日志的分析和监控在系统开发中占非常重要的地位,系统越复杂,日志的分析和监控就越重要,常见的需求有: 根据关键字查询日 ...

- 【转载】使用logstash+elasticsearch+kibana快速搭建日志平台

原文链接:http://www.cnblogs.com/buzzlight/p/logstash_elasticsearch_kibana_log.html 日志的分析和监控在系统开发中占非常重要的地 ...

- ELK日志框架(2):log4net.ElasticSearch+ Kibana实现日志记录和显示

环境说明 1. windows server 2012 R2 64位 2. log4net.ElasticSearch 3. kibana-5.5.0-windows-x86.zip 架构说明 数据采 ...

随机推荐

- 微信屏蔽js分享、复制链接

页面内引入js(不放在页面内部不起作用) $(function(){ function onBridgeReady() { WeixinJSBridge.call('hideOptionMenu'); ...

- Linux指令--watch,at

watch是一个非常实用的命令,基本所有的Linux发行版都带有这个小工具,如同名字一样,watch可以帮你监测一个命令的运行结果,省得你一遍遍的手动运行.在Linux下,watch是周期性的执行下个 ...

- Linux指令--性能监控和优化命令相关指令

原文出处:http://www.cnblogs.com/peida/archive/2012/12/05/2803591.html.感谢作者无私分享 性能监控和优化命令相关指令有:top,free,v ...

- 【Java SE】如何用Java实现插入排序

摘要:前面三期分别写了三篇简单排序的算法,今天来讲一点稍微难一点的排序算法-----插入排序. 基本思想: 设n个数据已经按照顺序排列好(假定从小排到大). 输入一个数据x,将其放在恰当的位置,使其顺 ...

- text和submit框的border问题

A1:在input框中,为type为text的输入框增加边框,它会在内容区域外额外增添,但是在submit框中,它会占用内容区块的一部分作为边框 <style type="text/c ...

- Centos7.0关闭防火墙

CentOS 7.0默认使用的是firewall作为防火墙,使用iptables必须重新设置一下 1.直接关闭防火墙 systemctl stop firewalld.service #关闭firew ...

- Cypher查询语言--Neo4j 之高级篇 (六)

目录 排序Order by 通过节点属性排序节点 通过多节点属性排序节点 倒序排列节点 空值排序 Skip 跳过前三个 返回中间两个 Limit 返回第一部分 函数Functions 判断 All A ...

- Animations and transitions

在交互式可视化中,有一个词叫reactive,指的是以可视化的方式来响应用户的行为,帮助用户进行可视化并理解其结果.这个很有用.那如何来实现这种交互呢?通过动画. 如果处理得当,动画可以展现出不错的可 ...

- Django(三) ORM操作

一.DjangoORM 创建基本类型及生成数据库表结构 1.简介 ORM:关系对象映射.定义一个类自动生成数据库的表结构. 数据库常用的数据类型 : 数字 字符串 时间 ORM分为两种类型: 主流都是 ...

- ubuntu+mono+PetaPoco+Oracle+.net 程序部署

前言:将windows 下开发的 .net 控制台程序(连接Oracle数据库)部署到 ubuntu 下步骤记录 2017-09-19 实验所用机器为虚拟机Ubuntu16.04 amd64 安装 ...