C#采用vony.Html.AIO插件批量爬MM网站图片

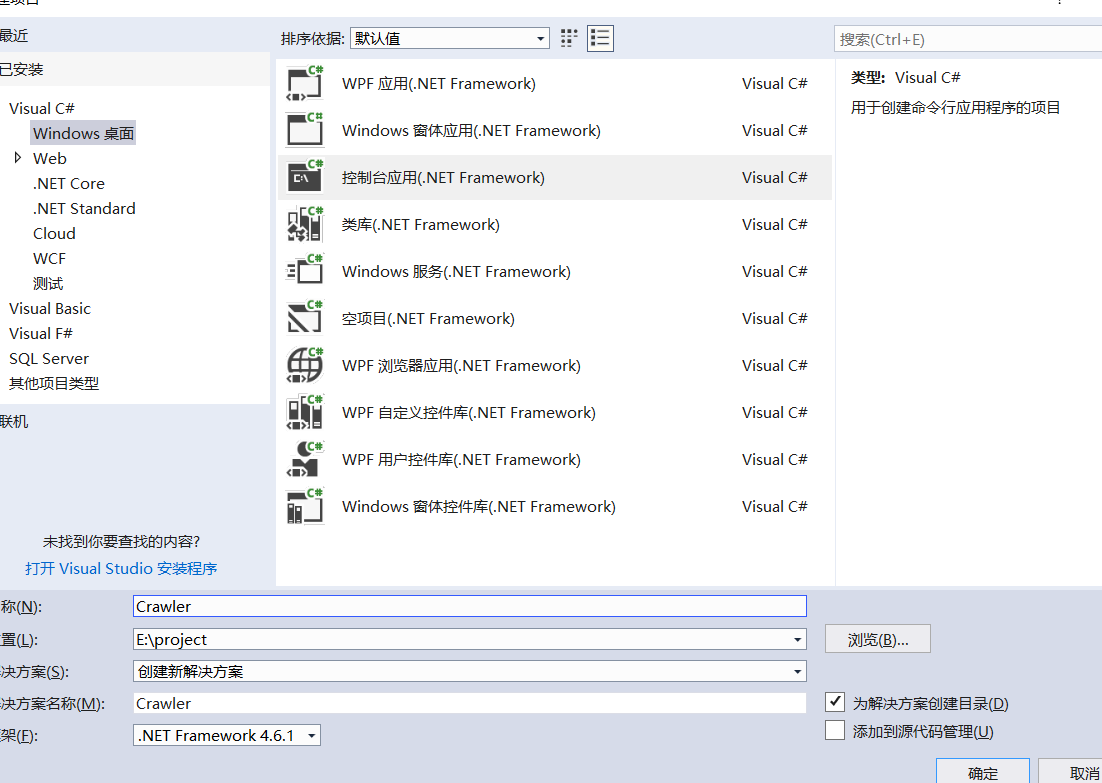

一、创建项目

1.创建一个.netframework的控制台项目命名为Crawler

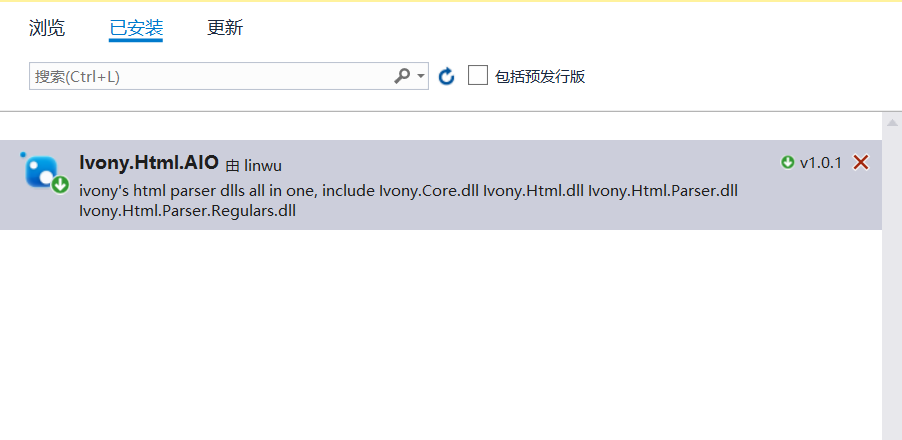

2.安装nuget包搜索名称Ivony.Html.AIO,使用该类库什么方便类似jqury的选择器可以根据类名或者元素类型来匹配元素,无需要写正则表达式。

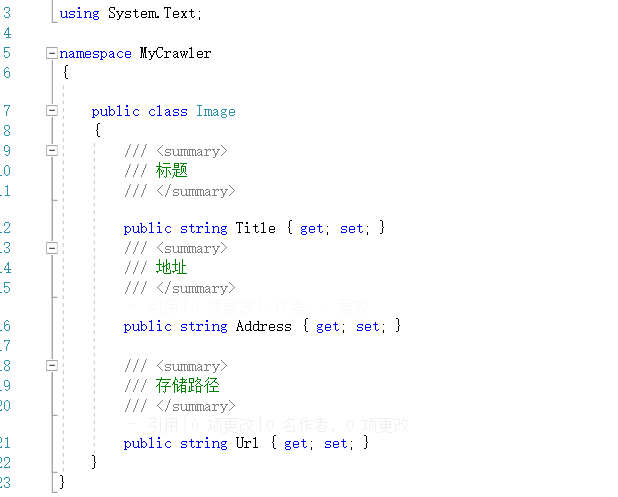

3.创建一个图片类Image

一、抓取页面图片

1.拿到所有图片页面的地址

本次爬取的网站为https://www.mntup.com/,打开页面进入二级目录https://www.mntup.com/SiWa.html,并查页面看源代码,如下图:

图片页都在class=“dana”的div下面,我们要拿去div中超链接的href,如下格式:

<div class="dana"><a href=/Rosimm/liantiyimeizi_4f4d781d.html title=[Rosi写真]NO.2637_红色吊带高叉连体衣妹子床上狗爬式秀浑圆翘臀撩人诱惑写真38P target=_blank>

[Rosi写真]NO.2637_红色吊带高叉连体衣妹子床上狗爬式秀浑圆翘臀撩人诱惑写真38P <b> <font color=ff0000>2019-02-26</b></font>

</a></div>

首先考虑要拿到所有图片页面的超链接,c#代码下:

//需要定义一个list用来存放所有的页面链接

static List<string> categoryUrl = new List<string>();

//加载url到文档

IHtmlDocument source = new JumonyParser().LoadDocument("https://www.mntup.com/XiuRen.html", System.Text.Encoding.GetEncoding("utf-8"));

//获取所有class=dana的的a标签

var divLinks = source.Find(".dana a");

foreach (var aLink in divLinks)

{

var categoryName = aLink.Attribute("href").Value(); //获取a中的链接

categoryUrl.Add(categoryName);

}

2.打开图片页,发现是带有分页的,那就要获取所有的分页的链接了。分页的地址都在页面当中,所以我们直接匹配就好。

由于每个图片页都有分页地址,所以直接匹配分页地址,C#代码如下:

foreach (var url in categoryUrl)

{

//获取图片也的的文档

IHtmlDocument html = new JumonyParser().LoadDocument($"{address}{url}", System.Text.Encoding.GetEncoding("utf-8"));

//获取每个分页面并下载

var pageLink = html.Find(".page a");

foreach (var alingk in pageLink)

{

string href = alingk.Attribute("href").Value();

Console.WriteLine($"获取分页地址{href}");

}

}

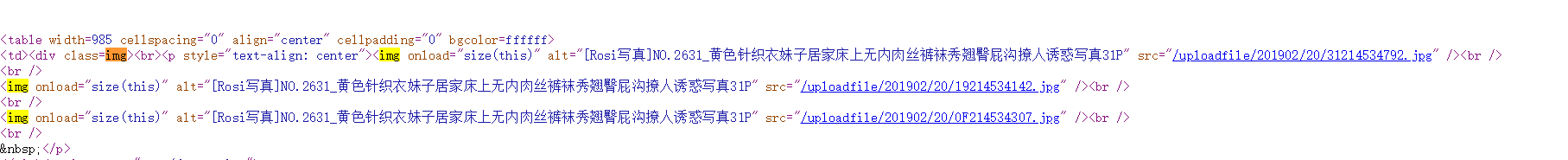

3.所有分页都获取到了,接下来就是要获取页面中的每张图片了,打开页面查看源代码:

观察发现,所有的图片都在class=img的div下面,那就可以从每个分页中直接下载所有的图片了,代码如下:

//获取每一个分页的文档模型

IHtmlDocument htm2 = new JumonyParser().LoadDocument($"{address}{href}", System.Text.Encoding.GetEncoding("utf-8"));

//获取class=img的div下的img标签

var aLink = htm2.Find(".img img");

foreach (var link in aLink)

{

var imgsrc = link.Attribute("src").Value();

Console.WriteLine("获取到图片路径" + imgsrc);

Console.WriteLine($"开始下载图片{imgsrc}>>>>>>>");

DownLoadImg(new Image { Address = address + imgsrc, Title = url });

}

}

图片下载方法如下,为防止下载的时候阻塞主进程,下载采用异步:

/// <summary>

/// 异不下载图片

/// </summary>

/// <param name="image"></param>

async static void DownLoadImg(Image image)

{

using (WebClient client = new WebClient())

{

try

{

int start = image.Address.LastIndexOf("/") + 1;

string fileName = image.Address.Substring(start, image.Address.Length - start);

//图片目录采用页面地址作为文件名

string directory = "c:/images/" + image.Title.Replace("/", "-").Replace("html", "") + "/";

if (!Directory.Exists(directory))

{

Directory.CreateDirectory(directory);

}

await client.DownloadFileTaskAsync(new Uri(image.Address), directory + fileName);

}

catch (Exception)

{

Console.WriteLine($"{image.Address}下载失败");

File.AppendText(@"c:/log.txt");

}

Console.WriteLine($"{image.Address}下载成功");

}

}

三、抓取图片

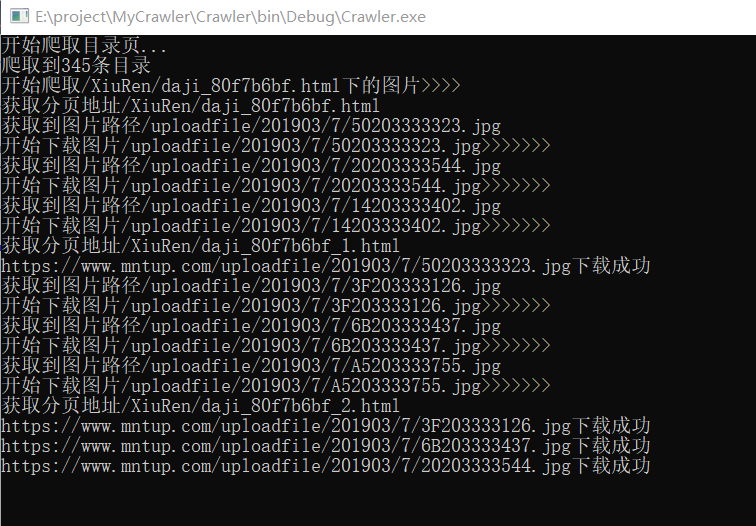

由于编码格式的问题,无法获取到中文标题,所有就采取了页面链接作为目录名称,下面是一张我抓取图片的截图:

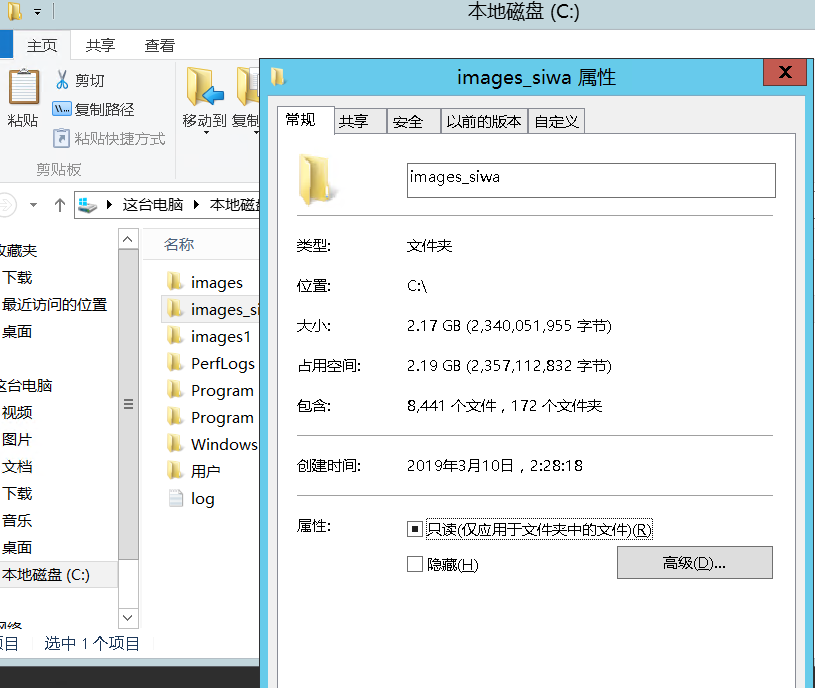

最后的战果:

最后奉上代码如下:https://github.com/peijianmin/MyCrawler.git

C#采用vony.Html.AIO插件批量爬MM网站图片的更多相关文章

- 【Python】批量爬取网站URL测试Struts2-045漏洞

1.概述都懒得写了.... 就是批量测试用的,什么工具里扣出来的POC,然后根据自己的理解写了个爬网站首页URL的代码... #!/usr/bin/env python # -*- coding: u ...

- Python:爬取网站图片并保存至本地

Python:爬取网页图片并保存至本地 python3爬取网页中的图片到本地的过程如下: 1.爬取网页 2.获取图片地址 3.爬取图片内容并保存到本地 实例:爬取百度贴吧首页图片. 代码如下: imp ...

- Python3批量爬取网页图片

所谓爬取其实就是获取链接的内容保存到本地.所以爬之前需要先知道要爬的链接是什么. 要爬取的页面是这个:http://findicons.com/pack/2787/beautiful_flat_ico ...

- 使用Python批量爬取美女图片

运行截图 实列代码: from bs4 import BeautifulSoup import requests,re,os headers = { 'User-Agent': 'Mozilla/5. ...

- 使用ajax爬取网站图片()

以下内容转载自:https://www.makcyun.top/web_scraping_withpython4.html 文章关于网站使用Ajaxj技术加载页面数据,进行爬取讲的很详细 大致步骤如下 ...

- Day11 (黑客成长日记) 爬取网站图片

#导入第三方库# coding:utf-8import requests,re #找到需要爬取的网站'http://www.qqjia.com/sucai/sucai1210.htm' #1>获 ...

- 使用python来批量抓取网站图片

今天"无意"看美女无意溜达到一个网站,发现妹子多多,但是可恨一个page只显示一张或两张图片,家里WiFi也难用,于是发挥"程序猿"的本色,写个小脚本,把图片扒 ...

- webmagic 二次开发爬虫 爬取网站图片

webmagic的是一个无须配置.便于二次开发的爬虫框架,它提供简单灵活的API,只需少量代码即可实现一个爬虫. webmagic介绍 编写一个简单的爬虫 webmagic的使用文档:http://w ...

- 使用Jsoup爬取网站图片

package com.test.pic.crawler; import java.io.File; import java.io.FileOutputStream; import java.io.I ...

随机推荐

- 在C++98基础上学习C++11新特性

自己一直用的是C++98规范来编程,对于C++11只闻其名却没用过其特性.近期因为工作的需要,需要掌握C++11的一些特性,所以查阅了一些C++11资料.因为自己有C++98的基础,所以从C++98过 ...

- Python_csv电子表格

import csv with open('test.csv','w',newline='')as fp: test_writer=csv.writer(fp,delimiter=' ',quotec ...

- Spring Boot实战笔记(八)-- Spring高级话题(条件注解@Conditional)

一.条件注解@Conditional 在之前的学习中,通过活动的profile,我们可以获得不同的Bean.Spring4提供了一个更通用的基于条件的Bean的创建,即使用@Conditional注解 ...

- 关于二叉查找树的一些事儿(bst详解,平衡树入门)

最近刚学了平衡树,然后突发奇想写几篇博客纪念一下,可能由于是刚学的缘故,还有点儿生疏,望大家海涵 说到平衡树,就不得不从基础说起,而基础,正是二叉查找树 什么是二叉查找树?? 大家观察一下下面的这棵二 ...

- Zepto源码(2016)——Zepto模块(核心模块)

// Zepto.js // (c) 2010-2016 Thomas Fuchs // Zepto.js may be freely distributed under the MIT licens ...

- spring(一)--spring/springmvc/spring+hibernate(mybatis)配置文件

这篇文章用来总结一下spring,springmvc,spring+mybatis,spring+hibernate的配置文件 1.web.xml 要使用spring,必须在web.xml中定义分发器 ...

- 最短寻道优先算法----SSTF算法

请珍惜小编劳动成果,该文章为小编原创,转载请注明出处. 该算法选择这样的进程,其要求访问的磁道与当前磁头所在的磁道距离最近,以使每次的寻道时间最短 java代码实现如下: import java.ut ...

- java判断一个字符串是否是数字的三种方法

参考https://blog.csdn.net/ld_flex/article/details/7699161 1 用JAVA自带的函数 public static boolean isNumeric ...

- dqname.go

package nsqd func getBackendName(topicName, channelName string) string { // backend names, for u ...

- 深入讨论channel timeout

深入讨论channel timeout Go 语言的 channel 本身是不支持 timeout 的,所以一般实现 channel 的读写超时都采用 select,如下: select { case ...