CDH目录

配置文件都在:/etc/服务名, 看hadoop的classpath

|grep conf

/etc/hadoop/conf

log都在: /var/log/服务名

看scm的log:

tail -1000 /var/log/cloudera-scm-server/cloudera-scm-server.log |grep error

hive:

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/hive as HIVE_HOME

hadoop:

/opt/cloudera/parcels/CDH/lib/hadoop as HADOOP_HOME

spark:

/opt/cloudera/parcels/CDH/lib/spark

parcels的目录:

/opt/cloudera/parcels

/opt/cloudera/parcels/CDH/jars

#jar包目录/opt/cloudera/parcels/CDH/lib(你装cdh的路径),找到lib目录对应的那些组件里面

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/hive/lib

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/hive/lib |grep uhadoop*

uhadoop-1.0-SNAPSHOT.jar

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/hadoop/lib |grep uhadoop*

uhadoop-1.0-SNAPSHOT.jar

/opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/hadoop/lib |grep ufile

ufilesdk-1.0-SNAPSHOT.jar

CDH组件目录:

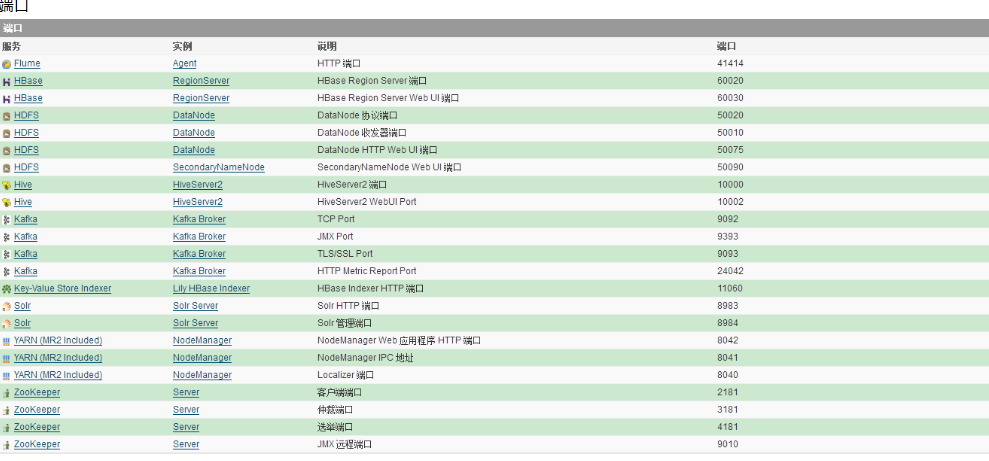

namenode: 8020

1.cloudera manager软件安装目录是在/opt/cloudera/parcels/CDH-5.7.1-1.cdh5.7.1.p0.11/lib中,其余的配置,命令其实都是来自这里和在这里生效的

2.cloudera manager配置分发就是把新配置发送到/etc/alternatives/hadoop中和/etc/hadoop中,然后各个服务再使用此配置。

cd /etc/alternatives可看到都是软链接

[root@node1 alternatives]# ll

total 0

lrwxrwxrwx 1 root root 67 Apr 16 2019 avro-tools -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/avro-tools

lrwxrwxrwx 1 root root 64 Apr 16 2019 beeline -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/beeline

lrwxrwxrwx 1 root root 79 Apr 16 2019 bigtop-detect-javahome -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/bigtop-detect-javahome

lrwxrwxrwx 1 root root 65 Apr 16 2019 catalogd -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/catalogd

lrwxrwxrwx 1 root root 39 Apr 16 2019 cifs-idmap-plugin -> /usr/lib64/cifs-utils/cifs_idmap_sss.so

lrwxrwxrwx 1 root root 63 Apr 16 2019 cli_mt -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/cli_mt

lrwxrwxrwx 1 root root 63 Apr 16 2019 cli_st -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/cli_st

lrwxrwxrwx 1 root root 65 Apr 16 2019 flume-ng -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/flume-ng

lrwxrwxrwx 1 root root 76 Apr 16 2019 flume-ng-conf -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/etc/flume-ng/conf.empty

lrwxrwxrwx 1 root root 63 Apr 16 2019 hadoop -> /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/bin/hadoop

3.cloudera manager各个服务的命令来自/opt/cloudera/parcels/CDH-5.7.1-1.cdh5.7.1.p0.11/lib中各个服务,有一部分命令发布到/usr下了。只不过是软链接到各个服务的bin下面的命令罢了

cd /usr/bin

lrwxrwxrwx 1 root root 34 Apr 16 2019 zookeeper-client -> /etc/alternatives/zookeeper-client

lrwxrwxrwx 1 root root 46 Apr 16 2019 zookeeper-security-migration -> /etc/alternatives/zookeeper-security-migration

lrwxrwxrwx 1 root root 34 Apr 16 2019 zookeeper-server -> /etc/alternatives/zookeeper-server

lrwxrwxrwx 1 root root 42 Apr 16 2019 zookeeper-server-cleanup -> /etc/alternatives/zookeeper-server-cleanup

lrwxrwxrwx 1 root root 45 Apr 16 2019 zookeeper-server-initialize -> /etc/alternatives/zookeeper-server-initialize

lrwxrwxrwx. 1 root root 6 Nov 7 2018 zsoelim -> soelim

4/ cloudera manager的spark服务器安装成功,但是启动spark shell时报错:SparkDeploySchedulerBackend: Application has been killed. Reason: Master removed our application: FAILED。这是因为多次为集群添加spark服务时,需要将spark的目录清理干净,因为我没有清理/var/run/spark/work,这个目录可能前几次添加失败时,导致这个目录的所有者不是spark,所以spark无法往这里写入内容,所以需要先删除此目录。

5/安装完了各种服务之后,需要将各个服务角色的内存调整一下,cloudera manager默认调整的不是很好。

CDH目录的更多相关文章

- 使用阿里云主机离线部署CDH步骤详解

一.Linux文件系统准备 1. 拍摄快照 登录阿里云控制台,拍摄快照,注意有几个关键点尽量拍摄快照,系统初始状态.CM环境准备完成.CM安装完成.CDH安装完成. 2. 挂载设备 三个主机都执行. ...

- 《OD大数据实战》Kafka入门实例

官网: 参考文档: Kafka入门经典教程 Kafka工作原理详解 一.安装zookeeper 1. 下载zookeeper-3.4.5-cdh5.3.6.tar.gz 下载地址为: http://a ...

- Presto集群部署和配置

参考文档:1.https://blog.csdn.net/zzq900503/article/details/79403949 prosto部署与连接hive使用 2. ...

- 离线安装Cloudera Manager 5和CDH5(最新版5.9.3) 完全教程(六)CM的安装

一.角色分配 Cloudera Manager Agent:向server端报告当前机器服务状态. Cloudera Manager Server:接受agent角色报告服务状态,以视图界面展现,方便 ...

- 大数据技术之_14_Oozie学习_Oozie 的简介+Oozie 的功能模块介绍+Oozie 的部署+Oozie 的使用案列

第1章 Oozie 的简介第2章 Oozie 的功能模块介绍2.1 模块2.2 常用节点第3章 Oozie 的部署3.1 部署 Hadoop(CDH版本的)3.1.1 解压缩 CDH 版本的 hado ...

- CDH5.10 添加kafka服务

简介: CDH的parcel包中是没有kafka的,kafka被剥离了出来,需要从新下载parcel包安装.或者在线安装,但是在线安装都很慢,这里使用下载parcel包离线安装的方式. PS:kafk ...

- CDH-5.12.2安装教程

CDH是Cloudera公司提供的Hadoop发行版,它在原生开源的Apache Hadoop基础之上,针对特定版本的Hadoop以及Hadoop相关的软件,如Zookeeper.HBase.Flum ...

- Sqoop框架基础

Sqoop框架基础 本节我们主要需要了解的是大数据的一些协作框架,也是属于Hadoop生态系统或周边的内容,比如: ** 数据转换工具:Sqoop ** 文件收集库框架:Flume ** 任务调度框架 ...

- 快速搭建Hadoop-Hive-Zoopkeeper-Sqoop环境进入Sqoop学习环境

原文链接: https://www.toutiao.com/i6771763211927552523/ CDH简单了解 CDH: C:cloudera(公司) D:distribute H:Hadoo ...

随机推荐

- 课时5:POW,POS,DPOS(矿工/矿机,工作证明)

比特币钱包

- mysql explain 执行计划详解

1).id列数字越大越先执行,如果说数字一样大,那么就从上往下依次执行,id列为null的就表是这是一个结果集,不需要使用它来进行查询. 2).select_type列常见的有: A:simple ...

- javaScript高级程序设计第3版笔记

<script src = "xxx.js" defer = "defer"> </script> 在引用外部script时,<s ...

- OpenCV使用Cmake来管理工程

写篇入门级别的文章,对于配置OpenCV很多人不知道有这种方法,其实这种方法在OpenCV编译过程中已经使用到的了,如果有手动编译OpenCV经验的同学可以很快的学会这种工程管理方法 方法优点,只要有 ...

- 一、基本的bash shell命令(基于Ubuntu实现)

一.基本的bash shell命令(基于Ubuntu实现) /etc/passwd文件包含了所有系统用户账户列表以及每个用户的基本配置信息. man命令 在想要查找的工具的名称前输入man命令,就可以 ...

- AcWing:142. 前缀统计(字典树)

给定N个字符串S1,S2…SNS1,S2…SN,接下来进行M次询问,每次询问给定一个字符串T,求S1S1-SNSN中有多少个字符串是T的前缀. 输入字符串的总长度不超过106106,仅包含小写字母. ...

- python-获取程序的路径

python获取当前路径 import os,sys 使用sys.path[0].sys.argv[0].os.getcwd().os.path.abspath(file).os.path.realp ...

- php项目权限系统设计

原文地址:https://blog.csdn.net/u013090676/article/details/77893237 说起php的权限,很多人都容易想起rbac,这里不多介绍.下面介绍一种通用 ...

- 石川es6课程---4、箭头函数

石川es6课程---4.箭头函数 一.总结 一句话总结: 相当于函数的简写,类似python lambda 函数,先了解即可 let show1 = function () { console.log ...

- laravel 中first和find区别(总结一)

检索单个模型/集合 除了从指定的数据表检索所有记录外,你也可以通过 find 或 first 方法来检索单条记录.这些方法不是返回一组模型,而是返回一个模型实例: // 通过主键取回一个模型... $ ...