吴裕雄--天生自然HADOOP操作实验学习笔记:hbase的javaAPI应用

实验目的

进一步了解hbase的操作

熟悉使用IDEA进行java开发

熟悉hbase的javaAPI

实验原理

前面已经了解通过hbase的shell操作hbase,确实比较难以使用,另外通过hive也可以操作hbase,今天我们学习通过javaAPI操作hbase。

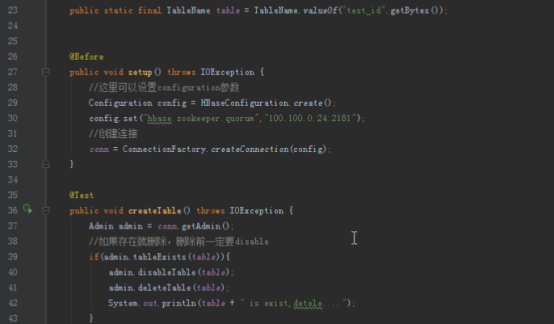

1.创建连接

我们以前在hbase简介的时候讲过,客户端操作hbase,实际上不需要和master打交道,因为寻址地址都保存在zookeeper里面,所以只需要知道zookeeper的地址就可以了。hbase创建连接的API为:

Configuration config = HBaseConfiguration.create();

//连上zookeeper

config.set("hbase.zookeeper.quorum","zookeeper服务器IP:2181");

//创建连接

Connection conn = ConnectionFactory.createConnection(config);

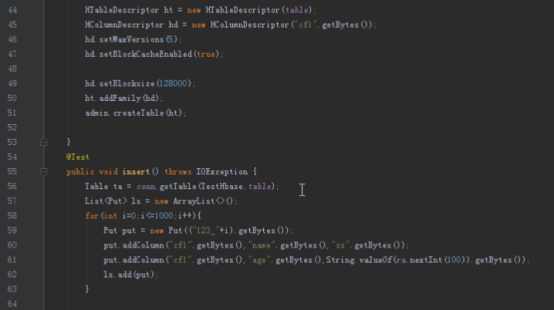

2.创建表格

//得到一个admin

Admin admin = conn.getAdmin();

/**表名,转化为字节数组*/

public static final TableName table = TableName.valueOf("test".getBytes());

//创建table的描述类

HTableDescriptor ht = new HTableDescriptor(table);

//创建列族的描述类

HColumnDescriptor hd = new HColumnDescriptor("cf1".getBytes());

//设置列族属性

hd.setMaxVersions(5);

hd.setBlockCacheEnabled(true);

hd.setBlocksize(128000);

//添加列族

ht.addFamily(hd);

//创建,如果存在会抛异常

admin.createTable(ht);

3.插入数据

//得到table的引用

Table ta = conn.getTable(TestHbase.table);

List<Put> ls = new ArrayList<>();

//新建Put并赋值,参数是rowkey

Put put = new Put(("123_").getBytes());

put.addColumn("cf1".getBytes(),"name".getBytes(),"zs".getBytes());

put.addColumn("cf1".getBytes(),"age".getBytes(),String.valueOf(20).getBytes());

//通过list批量导入

ls.add(put);

ta.put(ls);

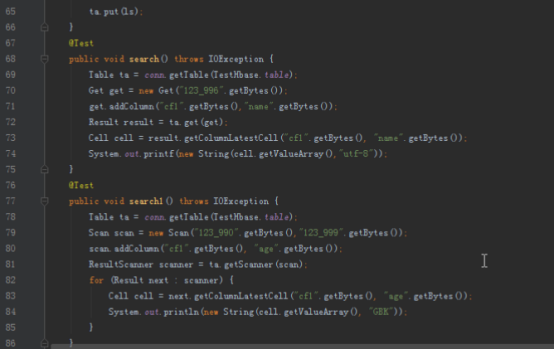

4.单条查询

//得到表格引用

Table ta = conn.getTable(TestHbase.table);

//新建get并赋值,参数是rowkey

Get get = new Get("123_996".getBytes());

get.addColumn("cf1".getBytes(),"age".getBytes());

//得到一个result

Result result = ta.get(get);

//取出result的cell

Cell cell = result.getColumnLatestCell("cf1".getBytes(), "age".getBytes());

System.out.printf(new String(cell.getValueArray(),"GBK"));

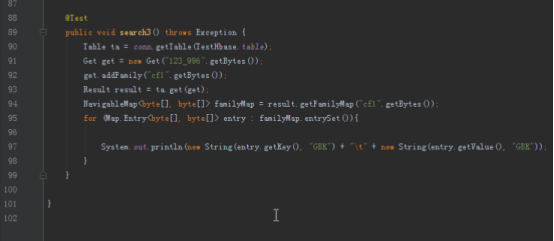

5.多条查询

//获得连接

Table ta = conn.getTable(TestHbase.table);

//新建一个scan,传入scan

Scan scan = new Scan("123_990".getBytes(),"123_999".getBytes());

scan.addColumn("cf1".getBytes(), "age".getBytes());

//得到ResultScanner,遍历

ResultScanner scanner = ta.getScanner(scan);

for (Result next : scanner) {

Cell cell = next.getColumnLatestCell("cf1".getBytes(), "age".getBytes());

System.out.println(new String(cell.getValueArray(), "GBK"));

}

6.删除表格

//获得admin

Admin admin = conn.getAdmin();

//如果存在就删除,删除前一定要disable

if(admin.tableExists(table)){

admin.disableTable(table);

admin.deleteTable(table);

}

实验环境

1.操作系统

服务器:Linux_Centos

操作机:Windows_7

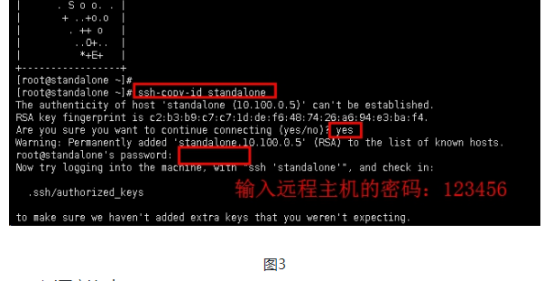

服务器默认用户名:root,密码:123456

操作机默认用户名:hongya,密码:123456

2.实验工具

1.Xshell

Xshell是一个强大的安全终端模拟软件,它支持SSH1, SSH2, 以及Microsoft Windows 平台的TELNET 协议。Xshell 通过互联网到远程主机的安全连接以及它创新性的设计和特色帮助用户在复杂的网络环境中享受他们的工作。 Xshell可以在Windows界面下用来访问远端不同系统下的服务器,从而比较好的达到远程控制终端的目的。实验中我们用到XShell5,其新增功能有:

1.有效保护信息安全性;Xshell支持各种安全功能,如SSH1/SSH2协议,密码,和DSA和RSA公开密钥的用户认证方法,并加密所有流量的各种加密算法。重要的是要保持用户的数据安全与内置Xshell安全功能,因为像Telnet和Rlogin这样的传统连接协议很容易让用户的网络流量受到任何有网络知识的人的窃取。Xshell将帮助用户保护数据免受黑客攻击。

2.最好的终端用户体验;终端用户需要经常在任何给定的时间中运用多个终端会话,以及与不同主机比较终端输出或者给不同主机发送同一组命令。Xshell则可以解决这些问题。此外还有方便用户的功能,如标签环境,广泛拆分窗口,同步输入和会话管理,用户可以节省时间做其他的工作。

3.代替不安全的Telnet客户端;Xshell支持VT100,VT220,VT320,Xterm,Linux,Scoansi和ANSI终端仿真和提供各种终端外观选项取代传统的Telnet客户端。

4. Xshell在单一屏幕实现多语言;Xshell中的UTF-8在同类终端软件中是第一个运用的。用Xshell,可以将多种语言显示在一个屏幕上,无需切换不同的语言编码。越来越多的企业需要用到UTF-8格式的数据库和应用程序,有一个支持UTF-8编码终端模拟器的需求在不断增加。Xshell可以帮助用户处理多语言环境。 5. 支持安全连接的TCP/IP应用的X11和任意;在SSH隧道机制中,Xshell支持端口转发功能,无需修改任何程序,它可以使所有的TCP/IP应用程序共享一个安全的连接。

2.Hadoop

Hadoop实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS。HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上;而且它提供高吞吐量(high throughput)来访问应用程序的数据,适合那些有着超大数据集(large data set)的应用程序。HDFS放宽了(relax)POSIX的要求,可以以流的形式访问(streaming access)文件系统中的数据。 Hadoop的框架最核心的设计就是:HDFS和MapReduce。HDFS为海量的数据提供了存储,则MapReduce为海量的数据提供了计算

3.Hbase

HBase是一个分布式的、面向列的开源数据库,该技术来源于 Fay Chang 所撰写的Google论文“Bigtable:一个结构化数据的分布式存储系统”。就像Bigtable利用了Google文件系统(File System)所提供的分布式数据存储一样,HBase在Hadoop之上提供了类似于Bigtable的能力。HBase是Apache的Hadoop项目的子项目。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。另一个不同的是HBase基于列的而不是基于行的模式。

HBase–Hadoop Database,是一个高可靠性、高性能、面向列、可伸缩的分布式存储系统,利用HBase技术可在廉价PC Server上搭建起大规模结构化存储集群。

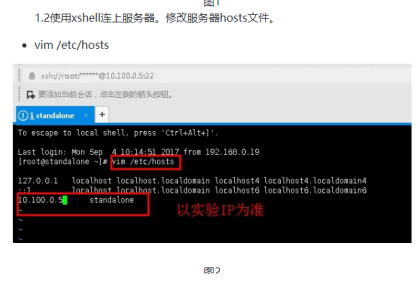

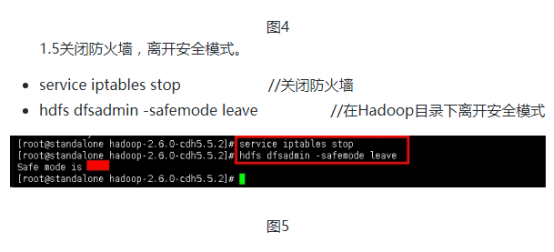

步骤1:连接服务器,启动集群

本次实验会提供一个伪分布式的集群,装好了zookeeper、hadoop、hbase,另外提供IDEA进行开发,代码已经完成,放在项目的hellohadoop的hbase模块中,供大家遇到问题时参考。

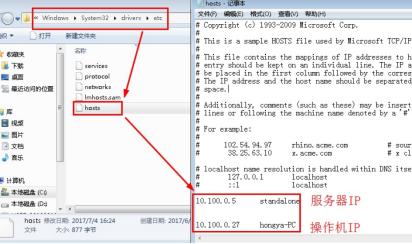

1.1进入操作机,编辑本地hosts文件(C:\Windows\System32\drivers\etc)。

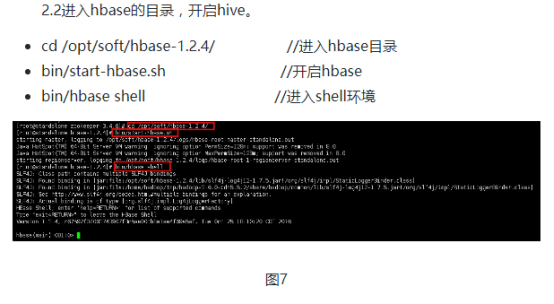

步骤2:启动zookeeper和hbase服务

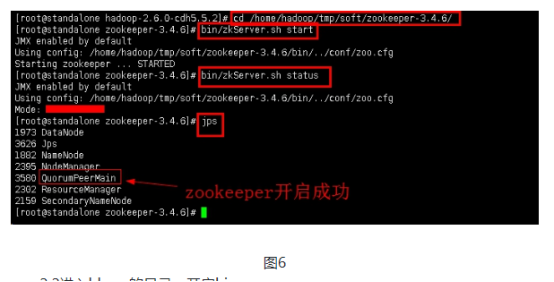

2.1开启zookeeper。

cd /home/hadoop/tmp/soft/zookeeper-3.4.6/ //进入zookeeper目录

bin/zkServer.sh start //开启zookeeper服务

bin/zkServer.sh status //查看zookeeper服务状态

jps //查看进程

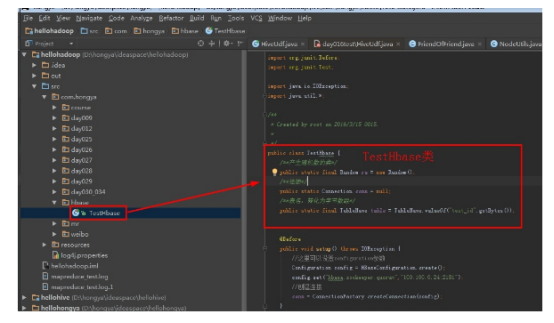

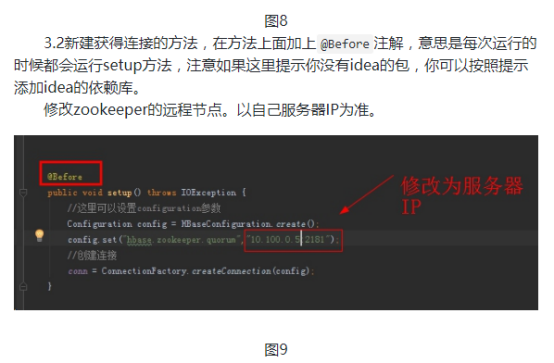

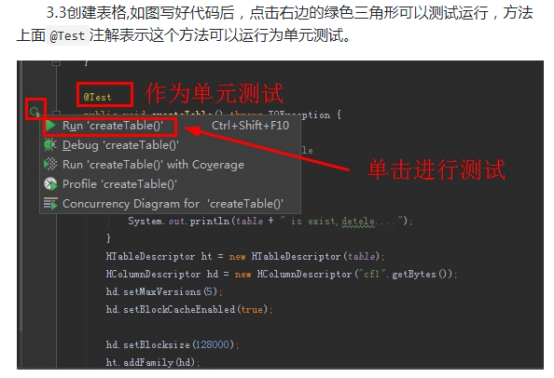

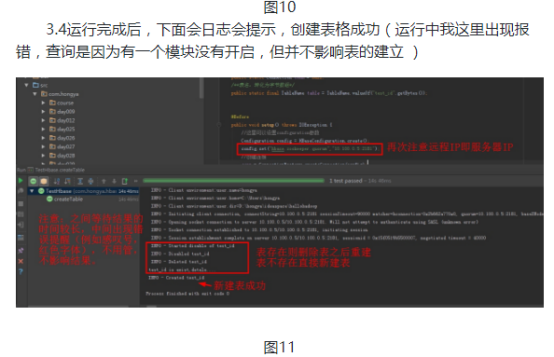

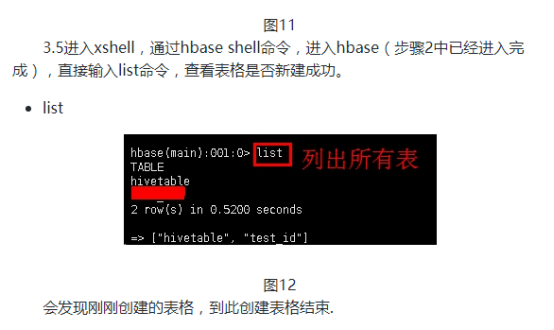

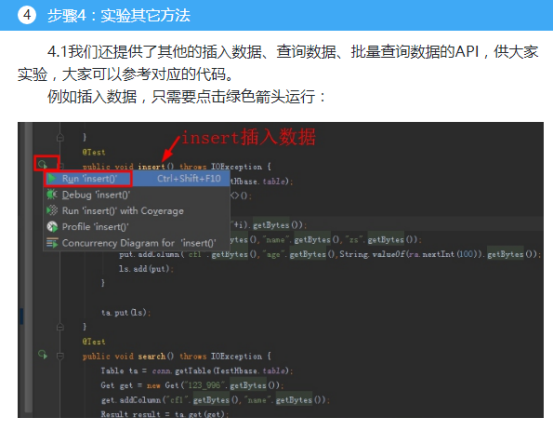

步骤3:进行测试

本次实验我们将采用idea作为工具。代码已经完成,放在项目的hellohadoop的hbase模块中,因为我们主要是学习如何通过javaAPI操作hbase,所以实验中我们重点学习操作过程以及对结果的分析,对代码的分析我们就不多做介绍。

若同学想要自行输入代码进行实验的分析,可以复习之前学习创建项目和模块的内容:双击IDEA,打开后按照以前试验过的内容,按Ctrl+Alt+Shift+S进入project structure新建项目模块(你也可以新建项目,但是我们建议新建模块,这是企业的做法),然后新建一个名为hbase的library,引入上面的hbase的依赖jar包。建好项目后,创建包和类,进行代码编写。这里不做过多介绍。

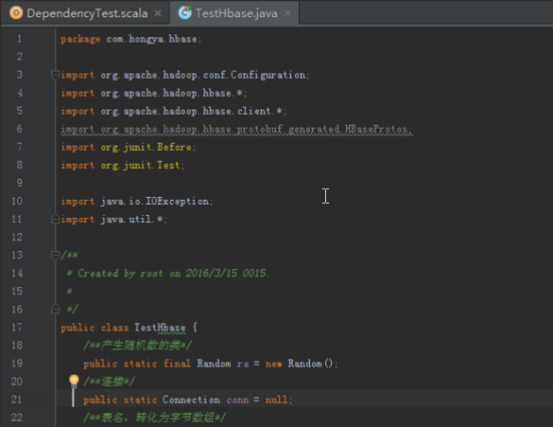

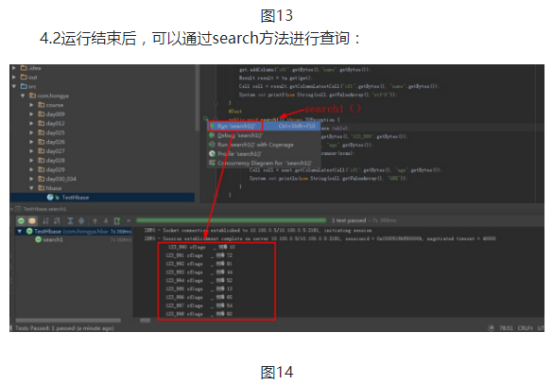

3.1查看代码:如图新建了一个TestHbase的类,创建了三个类属性(表名可以自己随意取)。

结果有乱码,乱码是hbase很容易出现的情况,因为hbase存的数据都是字节,所以需要序列化和反序列化,这需要一开始就插入、删除都统一字符集,当然这也不能避免乱码的情况,有关怎么解决,我们后面再讨论。

吴裕雄--天生自然HADOOP操作实验学习笔记:hbase的javaAPI应用的更多相关文章

- 吴裕雄--天生自然HADOOP操作实验学习笔记:使用hive操作hbase

实验目的 熟悉hive和hbase的操作 熟悉hadoop.hbase.hive.zookeeper的关系 熟练大数据环境的搭建 学会分析日志排除问题 实验原理 1.hive整合hbase原理 前面大 ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hbase微博案例

实验目的 熟悉hbase表格设计的方法 熟悉hbase的javaAPI 通过API理解掌握hbase的数据的逻辑视图 了解MVC的服务端设计方式 实验原理 上次我们已经初步设计了学生选课案例的,具体功 ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:mapreduce代码编程

实验目的 深入了解mapreduce的底层 了解IDEA的使用 学会通过本地和集群环境提交程序 实验原理 1.回忆mapreduce模型 前面进行了很多基础工作,本次实验是使用mapreduce的AP ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:分布式及RPC通信简介

实验目的 掌握GOF设计模式的代理模式 了解掌握socket编程.java反射.动态代理 了解NIO.多线程 掌握hadoop的RPC框架使用API 实验原理 1.什么是RPC 在hadoop出现以前 ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hbase学生选课案例

实验目的 复习hbase的shell操作和javaAPI操作 了解javaWeb项目的MVC设计 学会dao(数据库访问对象)和service层的代码编写规范 学会设计hbase表格 实验原理 前面我 ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hbase的shell应用v2.0

HRegion 当表的大小超过设置值的时候,HBase会自动地将表划分为不同的区域,每个区域包含所有行的一个子集.对用户来说,每个表是一堆数据的集合,靠主键来区分.从物理上来说,一张表被拆分成了多块, ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hive DDL

实验目的 了解hive DDL的基本格式 了解hive和hdfs的关系 学习hive在hdfs中的保存方式 学习一些典型常用的hiveDDL 实验原理 有关hive的安装和原理我们已经了解,这次实验我 ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:mapreduce和yarn命令

实验目的 了解集群运行的原理 学习mapred和yarn脚本原理 学习使用Hadoop命令提交mapreduce程序 学习对mapred.yarn脚本进行基本操作 实验原理 1.hadoop的shel ...

- 吴裕雄--天生自然HADOOP操作实验学习笔记:hdfs简单的shell命令

实验目的 了解bin/hadoop脚本的原理 学会使用fs shell脚本进行基本操作 学习使用hadoop shell进行简单的统计计算 实验原理 1.hadoop的shell脚本 当hadoop集 ...

随机推荐

- nginx命令行及演示:重载、热部署、日志切割

重载配置文件 nginx -s reload 热部署(升级nginx) 首先备份二进制文件 cp nginx nginx.old 拷贝新版本的nginx替换以前的nginx二进制文件 cp ngi ...

- Java中的8种基本数据类型

JAVA中的8种基本数据类型:byte short int long float double char boolean 特别说明: 1)char类型占2个字节,可以表示汉字.汉字和英文字符都占2个字 ...

- android项目上传github

很简单

- Codeforces Round #470 (Div. 2) A Protect Sheep (基础)输入输出的警示、边界处理

Bob is a farmer. He has a large pasture with many sheep. Recently, he has lost some of them due to w ...

- Go语言实现:【剑指offer】构建乘积数组

该题目来源于牛客网<剑指offer>专题. 给定一个数组A[0,1,-,n-1],请构建一个数组B[0,1,-,n-1],其中B中的元素B[i]=A[0] * A[1] * - * A[i ...

- 如何开始阅读ASP.NET Core源代码

背景 当我们对ASP.Net Core内部的某些方法.类的实现感兴趣时,有很多方法可以去了解,看书,看各种文章,但是最直接也是最深入的办法就是去阅读源代码.ASP.NET Core的源代码托管在Git ...

- LeetCode29 Medium 不用除号实现快速除法

本文始发于个人公众号:TechFlow,原创不易,求个关注 链接 Divide Two Integers 难度 Medium 描述 给定两个整数,被除数和除数,要求在不使用除号的情况下计算出两数的商 ...

- VFP CursorAdapter 起步一(作者:Doug Hennig 译者:fbilo)

CursorAdapter 类是 VFP 8 中最重要的新功能之一,因为它提供了一种简单易用.接口统一的访问远程数据源方式.在这个月的文章里,Dung Hennig 将向你展示 CursorAdapt ...

- MD5加密常用js库:crypto-js

学习链接:https://github.com/brix/crypto-js

- 惊讶!缓存刚Put再Get居然获取不到?

最近一直在老家远程办公,微信突然响了下,有同事说遇到了一个奇怪的问题,让我帮忙看下. 现象就是标题所说的缓存获取不到的问题,我一听感觉这个问题挺有意思的,决定一探究竟. 下面给出部分代码还原下案发现场 ...