C#网络爬虫--多线程处理强化版

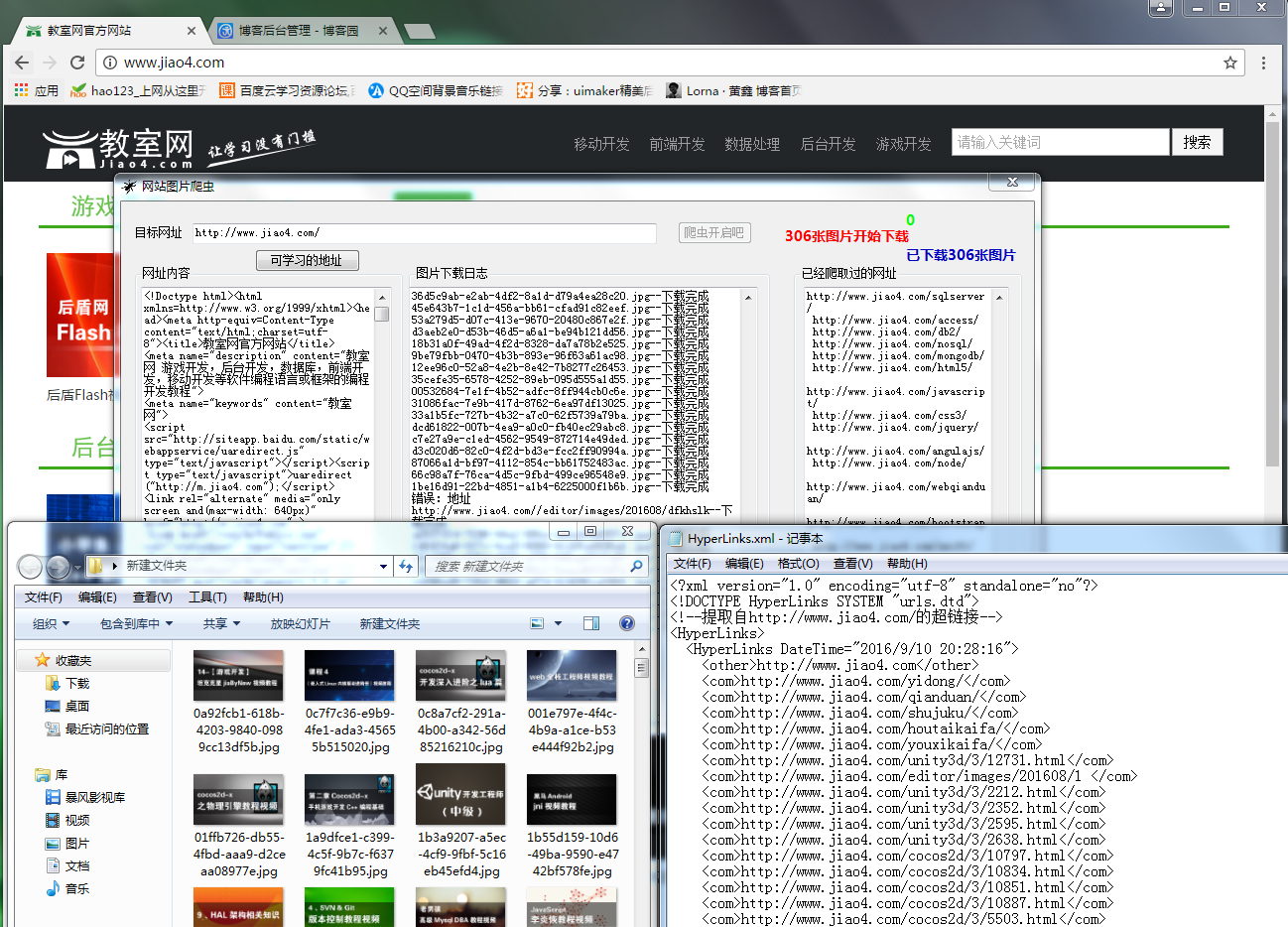

上次做了一个帮公司妹子做了爬虫,不是很精致,这次公司项目里要用到,于是有做了一番修改,功能添加了网址图片采集,下载,线程处理界面网址图片下载等。

说说思路:首相获取初始网址的所有内容 在初始网址采集图片 去初始网址采集链接 把采集到的链接放入队列 继续采集图片,然后继续采集链接,无限循环

还是上图片大家看一下,在上代码!

处理网页内容抓取跟网页网址爬取都做了改进,下面还是大家来看看代码,有不足之处,还请之处!

网页内容抓取HtmlCodeRequest,

网页网址爬取GetHttpLinks,用正则去筛选html中的Links

图片抓取GetHtmlImageUrlList,用正则去筛选html中的Img

都写进了一个封装类里面 HttpHelper

/// <summary>

/// 取得HTML中所有图片的 URL。

/// </summary>

/// <param name="sHtmlText">HTML代码</param>

/// <returns>图片的URL列表</returns>

public static string HtmlCodeRequest(string Url)

{

if (string.IsNullOrEmpty(Url))

{

return "";

}

try

{

//创建一个请求

HttpWebRequest httprequst = (HttpWebRequest)WebRequest.Create(Url);

//不建立持久性链接

httprequst.KeepAlive = true;

//设置请求的方法

httprequst.Method = "GET";

//设置标头值

httprequst.UserAgent = "User-Agent:Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.0.3705";

httprequst.Accept = "*/*";

httprequst.Headers.Add("Accept-Language", "zh-cn,en-us;q=0.5");

httprequst.ServicePoint.Expect100Continue = false;

httprequst.Timeout = ;

httprequst.AllowAutoRedirect = true;//是否允许302

ServicePointManager.DefaultConnectionLimit = ;

//获取响应

HttpWebResponse webRes = (HttpWebResponse)httprequst.GetResponse();

//获取响应的文本流

string content = string.Empty;

using (System.IO.Stream stream = webRes.GetResponseStream())

{

using (System.IO.StreamReader reader = new StreamReader(stream, System.Text.Encoding.GetEncoding("utf-8")))

{

content = reader.ReadToEnd();

}

}

//取消请求

httprequst.Abort();

//返回数据内容

return content;

}

catch (Exception)

{ return "";

}

}

/// <summary>

/// 提取页面链接

/// </summary>

/// <param name="html"></param>

/// <returns></returns>

public static List<string> GetHtmlImageUrlList(string url)

{

string html = HttpHelper.HtmlCodeRequest(url);

if (string.IsNullOrEmpty(html))

{

return new List<string>();

}

// 定义正则表达式用来匹配 img 标签

Regex regImg = new Regex(@"<img\b[^<>]*?\bsrc[\s\t\r\n]*=[\s\t\r\n]*[""']?[\s\t\r\n]*(?<imgUrl>[^\s\t\r\n""'<>]*)[^<>]*?/?[\s\t\r\n]*>", RegexOptions.IgnoreCase); // 搜索匹配的字符串

MatchCollection matches = regImg.Matches(html);

List<string> sUrlList = new List<string>(); // 取得匹配项列表

foreach (Match match in matches)

sUrlList.Add(match.Groups["imgUrl"].Value);

return sUrlList;

} /// <summary>

/// 提取页面链接

/// </summary>

/// <param name="html"></param>

/// <returns></returns>

public static List<string> GetHttpLinks(string url)

{

//获取网址内容

string html = HttpHelper.HtmlCodeRequest(url);

if (string.IsNullOrEmpty(html))

{

return new List<string>();

}

//匹配http链接

const string pattern2 = @"http(s)?://([\w-]+\.)+[\w-]+(/[\w- ./?%&=]*)?";

Regex r2 = new Regex(pattern2, RegexOptions.IgnoreCase);

//获得匹配结果

MatchCollection m2 = r2.Matches(html);

List<string> links = new List<string>();

foreach (Match url2 in m2)

{

if (StringHelper.CheckUrlIsLegal(url2.ToString()) || !StringHelper.IsPureUrl(url2.ToString()) || links.Contains(url2.ToString()))

continue;

links.Add(url2.ToString());

}

//匹配href里面的链接

const string pattern = @"(?i)<a\s[^>]*?href=(['""]?)(?!javascript|__doPostBack)(?<url>[^'""\s*#<>]+)[^>]*>"; ;

Regex r = new Regex(pattern, RegexOptions.IgnoreCase);

//获得匹配结果

MatchCollection m = r.Matches(html);

foreach (Match url1 in m)

{

string href1 = url1.Groups["url"].Value;

if (!href1.Contains("http"))

{

href1 = Global.WebUrl + href1;

}

if (!StringHelper.IsPureUrl(href1) || links.Contains(href1)) continue;

links.Add(href1);

}

return links;

}

这边下载图片有个任务条数限制,限制是200条。如果超过的话线程等待5秒,这里下载图片是异步调用的委托

public string DownLoadimg(string url)

{

if (!string.IsNullOrEmpty(url))

{

try

{

if (!url.Contains("http"))

{

url = Global.WebUrl + url;

}

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Timeout = ;

request.UserAgent = "User-Agent:Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.0.3705";

//是否允许302

request.AllowAutoRedirect = true;

WebResponse response = request.GetResponse();

Stream reader = response.GetResponseStream();

//文件名

string aFirstName = Guid.NewGuid().ToString();

//扩展名

string aLastName = url.Substring(url.LastIndexOf(".") + , (url.Length - url.LastIndexOf(".") - ));

FileStream writer = new FileStream(Global.FloderUrl + aFirstName + "." + aLastName, FileMode.OpenOrCreate, FileAccess.Write);

byte[] buff = new byte[];

//实际读取的字节数

int c = ;

while ((c = reader.Read(buff, , buff.Length)) > )

{

writer.Write(buff, , c);

}

writer.Close();

writer.Dispose();

reader.Close();

reader.Dispose();

response.Close();

return (aFirstName + "." + aLastName);

}

catch (Exception)

{

return "错误:地址" + url;

}

}

return "错误:地址为空";

}

话不多说,更多的需要大家自己去改进咯!欢迎读者来与楼主进行交流。如果本文对您有参考价值,欢迎帮博主点下文章下方的推荐,谢谢

有兴趣可加入企鹅群一起进步:495104593

下面源码送上:嘿嘿要分的哦!

http://download.csdn.net/detail/nightmareyan/9627215

C#网络爬虫--多线程处理强化版的更多相关文章

- C# 多线程网络爬虫

原文 C#制作多线程处理强化版网络爬虫 上次做了一个帮公司妹子做了爬虫,不是很精致,这次公司项目里要用到,于是有做了一番修改,功能添加了网址图片采集,下载,线程处理界面网址图片下载等. 说说思路:首相 ...

- swing版网络爬虫-丑牛迷你采集器2.0

swing版网络爬虫-丑牛迷你采集器2.0 http://www.javacoo.com/code/704.jhtml 整合JEECMS http://bbs.jeecms.com/fabu/3186 ...

- 用Python写网络爬虫 第二版

书籍介绍 书名:用 Python 写网络爬虫(第2版) 内容简介:本书包括网络爬虫的定义以及如何爬取网站,如何使用几种库从网页中抽取数据,如何通过缓存结果避免重复下载的问题,如何通过并行下载来加速数据 ...

- Java版网络爬虫基础(转)

网络爬虫不仅仅可以爬取网站的网页,图片,甚至可以实现抢票功能,网上抢购,机票查询等.这几天看了点基础,记录下来. 网页的关系可以看做是一张很大的图,图的遍历可以分为深度优先和广度优先.网络爬虫采取的广 ...

- Java版网络爬虫基础

网络爬虫不仅仅可以爬取网站的网页,图片,甚至可以实现抢票功能,网上抢购,机票查询等.这几天看了点基础,记录下来. 网页的关系可以看做是一张很大的图,图的遍历可以分为深度优先和广度优先.网络爬虫采取的广 ...

- Atitit.数据检索与网络爬虫与数据采集的原理概论

Atitit.数据检索与网络爬虫与数据采集的原理概论 1. 信息检索1 1.1. <信息检索导论>((美)曼宁...)[简介_书评_在线阅读] - dangdang.html1 1.2. ...

- iOS开发——网络实用技术OC篇&网络爬虫-使用青花瓷抓取网络数据

网络爬虫-使用青花瓷抓取网络数据 由于最近在研究网络爬虫相关技术,刚好看到一篇的的搬了过来! 望谅解..... 写本文的契机主要是前段时间有次用青花瓷抓包有一步忘了,在网上查了半天也没找到写的完整的教 ...

- GJM:用C#实现网络爬虫(二) [转载]

上一篇<用C#实现网络爬虫(一)>我们实现了网络通信的部分,接下来继续讨论爬虫的实现 3. 保存页面文件 这一部分可简单可复杂,如果只要简单地把HTML代码全部保存下来的话,直接存文件就行 ...

- HTTP请求中的User-Agent 判断浏览器类型的各种方法 网络爬虫的请求标示

我们知道,当用户发送一个http请求的时候,浏览的的版本信息也包含在了http请求信息中: 如上图所示,请求 google plus 请求头就包含了用户的浏览器信息: User-Agent:Mozil ...

随机推荐

- Linux下SVN配置hook经验总结

前几天给实验室搭建了一个内部测试的开发环境,LAMP.svn提交以及自动部署. 之前没干过这事儿,到最终搞定还是颇费了些周折.总结一下我的经验,主要是hook的自动执行问题. 拿我的post-comm ...

- PCA in MLLib

SVD分解: \(A=U\Sigma V^T\),变换:\(\hat{A}=A\cdot V=U\Sigma\) 分解时先计算\(A^TA=U\Sigma^2U^T\),再进行SVD分解 /** * ...

- MVC和WEBAPI(一)

什么是MVC (模型 视图 控制器)? MVC是一个架构模式,它分离了表现与交互.它被分为三个核心部件:模型.视图.控制器.下面是每一个部件的分工: 视图是用户看到并与之交互的界面. 模型表示业务数据 ...

- 关于css3中的flex

参考几篇文章: Flex 布局语法教程 IE10中的Flexible Box("Flexbox")布局 “老”的Flexbox和“新”的Flexbox 一个可以练习的地方: NEW ...

- mysql添加外键的4种方式

今天开始复习,在过后的几天里开始在博客上记录一下平时疏忽的知识点,温故而知新 屁话不多--直接上货 创建主表: 班级 CREATE TABLE class(cid INT PRIMARY KEY AU ...

- Java并发编程总结2——慎用CAS

一.CAS和synchronized适用场景 1.对于资源竞争较少的情况,使用synchronized同步锁进行线程阻塞和唤醒切换以及用户态内核态间的切换操作额外浪费消耗cpu资源:而CAS基于硬件实 ...

- hadoop集群搭建(hdfs)

(搭建hadoop集群的前提是服务器已成功安装jdk以及服务器之间已设置免密码登录,服务器之间的免密码登录可参考<linux服务器间ssh免密码登录>) 1.下载hadoop安装包 wge ...

- python--使用pickle序列化对象

pickle序列化对象 如果希望透明地存储 Python 对象,而不丢失其身份和类型等信息,则需要某种形式的对象序列化:它是一个将任意复杂的对象转成对象的文本或二进制表示的过程. 同样,必须能够将对象 ...

- Docker三剑客之Docker Compose

一.什么是Docker Compose Compose 项目是Docker官方的开源项目,负责实现Docker容器集群的快速编排,开源代码在https://github.com/docker/comp ...

- odoo 开发基础 -- postgresql重新启动、状态查看

场景描述: 当遇到数据库不能正常访问的时候,我们首先想到的是,查看相关的告警日志,一般先查看系统的日志,然后查看数据库的日志,Linux平台下,postgresql的日志文件存放目录在如下路径: te ...