Glusterfs初试

Gluster的模式及介绍在此不表,这里只记录安装及配置过程。

1.整体环境

server1 : gfs1.cluster.com

server2 : gfs2.cluster.com

Client:

2.安装Gluster

- 下载软件

https://access.redhat.com/downloads/content/186/ver=3/rhel---7/3.4/x86_64/product-software

下载 Red Hat Gluster Storage Server 3.4 on RHEL 7 Installation DVD

安装RHEL 7.6的最小软件安装,将iso文件mount成cdrom, 然后修改yum源

mkdir -p /repo/base

mount /dev/cdrom /repo/base

vi /etc/yum.repos.d/base.repo

[rhel7.]

name=rhel7.

baseurl=file:///repo/base/

enabled=

gpgcheck=

- 安装

yum install -y redhat-storage-server

systemctl start glusterd

systemctl enable glusterd

systemctl status glusterd验证一下

[root@gfs1 mnt]# systemctl status glusterd

● glusterd.service - GlusterFS, a clustered file-system server

Loaded: loaded (/usr/lib/systemd/system/glusterd.service; enabled; vendor preset: disabled)

Active: active (running) since Fri -- :: CST; 6min ago

Process: ExecStart=/usr/sbin/glusterd -p /var/run/glusterd.pid --log-level $LOG_LEVEL $GLUSTERD_OPTIONS (code=exited, status=/SUCCESS)

Main PID: (glusterd)

Tasks:

CGroup: /system.slice/glusterd.service

├─ /usr/sbin/glusterd -p /var/run/glusterd.pid --log-level INFO

├─ /usr/sbin/glusterfs -s localhost --volfile-id gluster/glustershd -p /var/run/gluster/glustershd/glustershd.pid -l /var/lo...

└─ /usr/sbin/glusterfsd -s gfs1.cluster.com --volfile-id gv0.gfs1.cluster.com.data-gluster-gv0 -p /var/run/gluster/vols/gv0/... Feb :: gfs1.cluster.com systemd[]: Starting GlusterFS, a clustered file-system server...

Feb :: gfs1.cluster.com systemd[]: Started GlusterFS, a clustered file-system server.

- 配置防火墙

简单起见直接关闭了,以后补充开放具体网段

systemctl stop firewalld

systemctl disable firewalld

- 修改主机名以及/etc/hosts

每台机器执行,并修改/etc/hosts

hostnamectl set-hostname gfs1.cluster.com

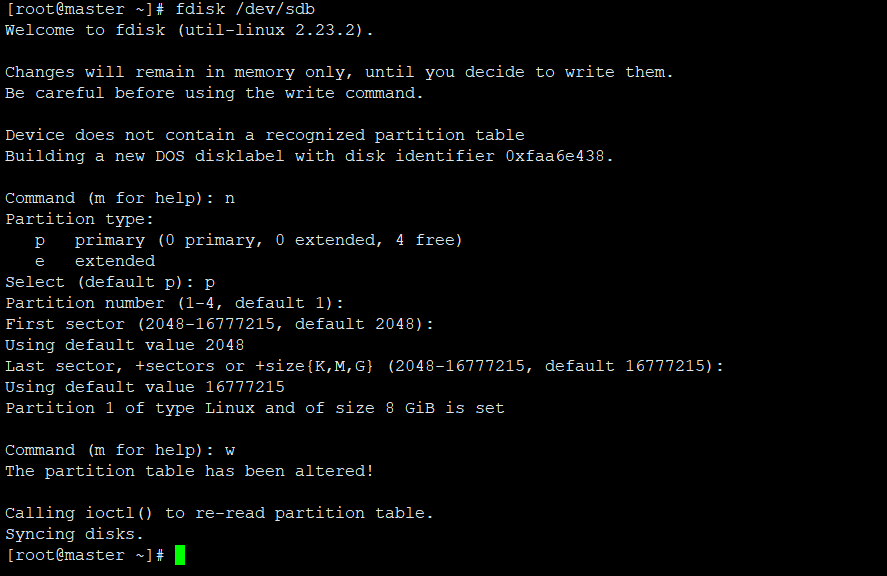

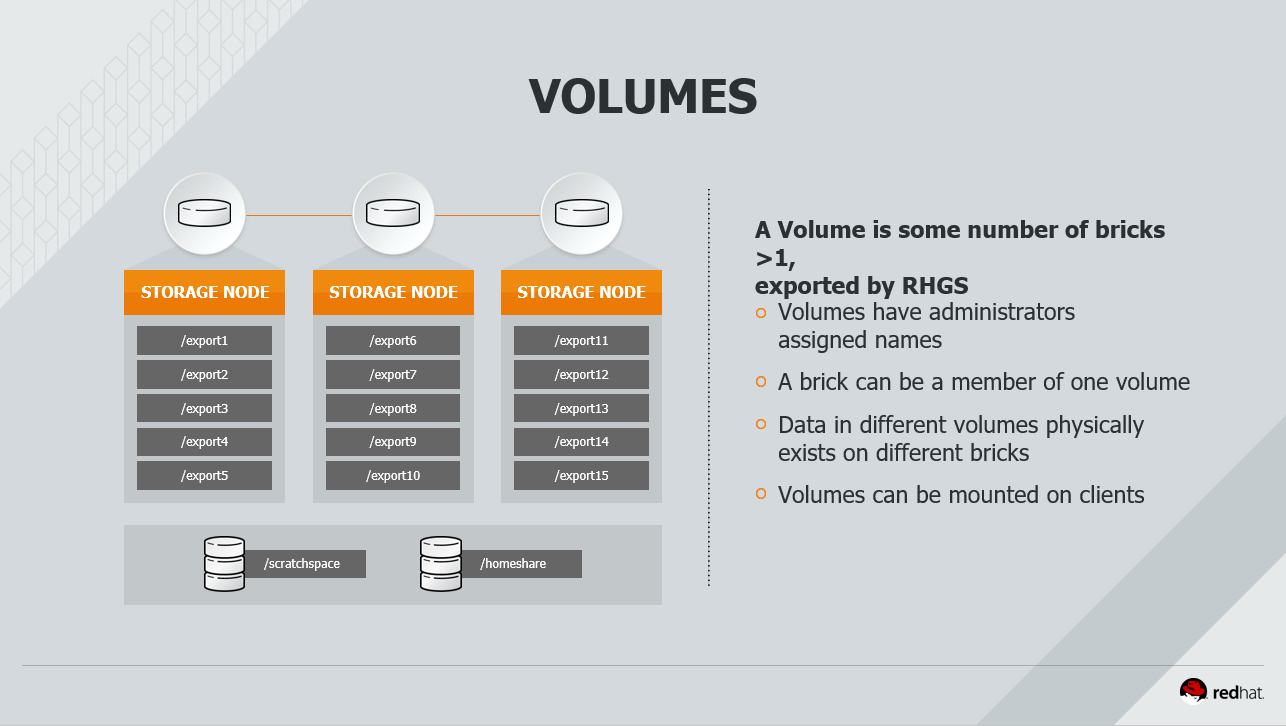

- 添加存储

在每台glusterfs的server上加入一块存储盘,并进行初始化

fdisk /dev/sdb

mkfs.ext4 /dev/sdb1

在每个节点上运行以下命令挂载

mkdir -p /data/gluster

mount /dev/sdb1 /data/gluster

echo "/dev/sdb1 /data/gluster ext4 defaults 0 0" | tee --append /etc/fstab

3.配置Glusterfs

在节点1上运行

gluster peer probe gfs2.cluster.com

验证

[root@gfs1 mnt]# gluster peer status

Number of Peers: Hostname: gfs2.cluster.com

Uuid: 818cc628-85a7-4f5e-bd4e-34932c05de97

State: Peer in Cluster (Connected) [root@gfs1 mnt]# gluster pool list

UUID Hostname State

818cc628-85a7-4f5e-bd4e-34932c05de97 gfs2.cluster.com Connected

dbcc01fc-3d2c-466f--57c46a9974be localhost Connected

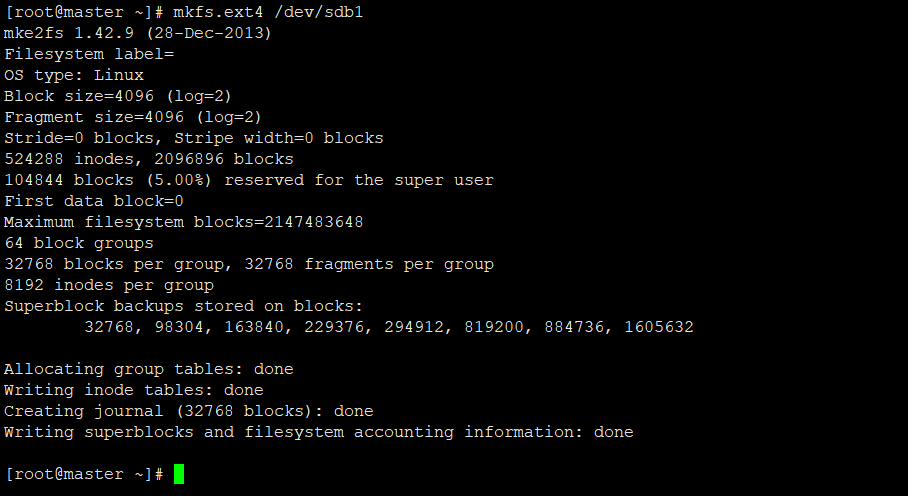

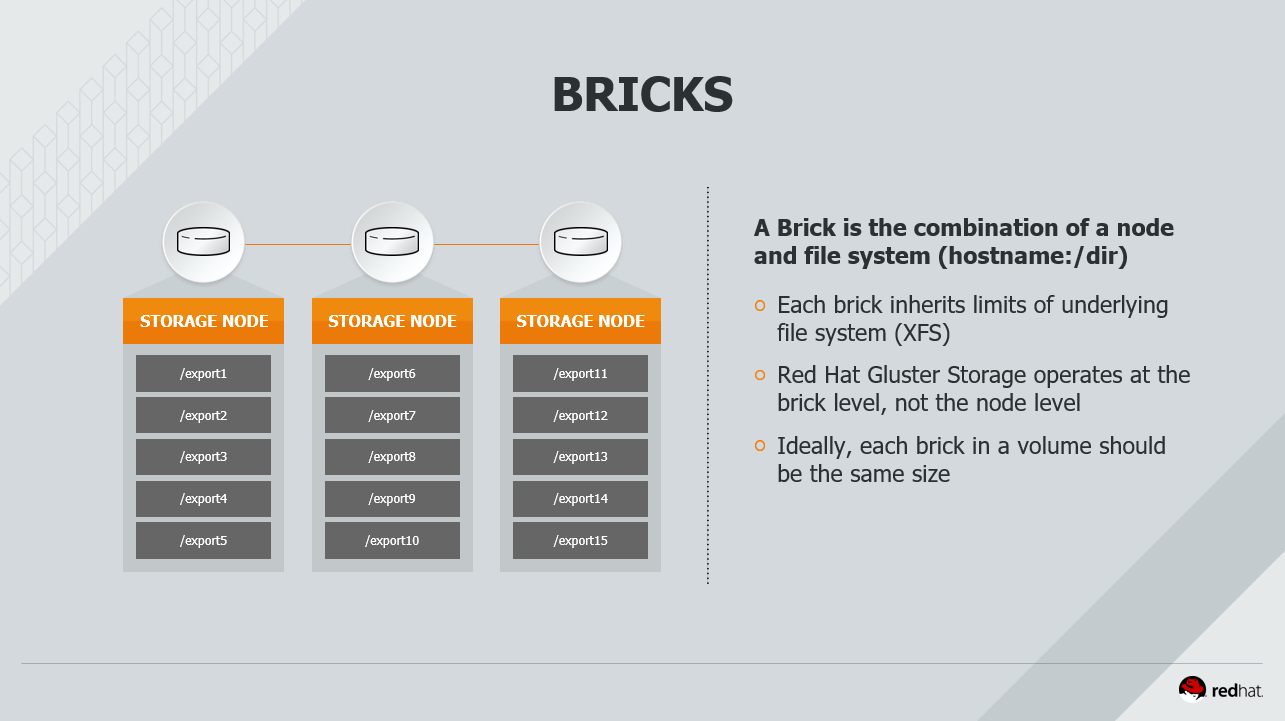

volume和brick的概念

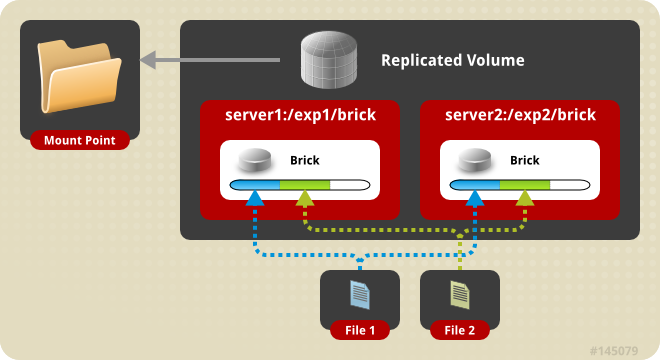

3.1 复制卷

创建GFS卷gv0并配置复制模式

mkdir -p /data/gluster/gv0(在gfs1和gfs2上都建立brick)

gluster volume create gv0 replica gfs1.cluster.local:/data/gluster/gv0 gfs2.cluster.local:/data/gluster/gv0

启动gv0卷

gluster volume start gv0

gluster volume info gv0

[root@gfs1 mnt]# gluster volume info gv0 Volume Name: gv0

Type: Replicate

Volume ID: 26d05ac6---ada4-5a423793fa20

Status: Started

Snapshot Count:

Number of Bricks: x =

Transport-type: tcp

Bricks:

Brick1: gfs1.cluster.com:/data/gluster/gv0

Brick2: gfs2.cluster.com:/data/gluster/gv0

Options Reconfigured:

performance.client-io-threads: off

nfs.disable: on

transport.address-family: inet

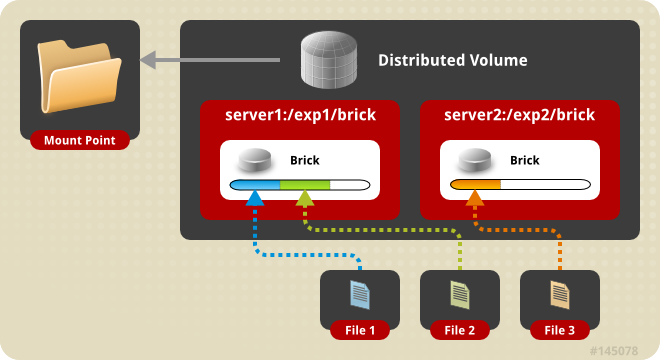

3.2 分布式卷(Distributed volume)

mkdir -p /data/gluster/brick gluster volume create gv1 gfs1.cluster.com:/data/gluster/brick gfs2.cluster.com:/data/gluster/brick gluster volume start gv1

[root@gfs1 mnt]# mkdir -p /data/gluster/brick

[root@gfs1 mnt]# gluster volume create gv1 gfs1.cluster.com:/data/gluster/brick gfs2.cluster.com:/data/gluster/brick

volume create: gv1: success: please start the volume to access data

[root@gfs1 mnt]# gluster volume start gv1

volume start: gv1: success

[root@gfs1 mnt]# gluster volume info gv1 Volume Name: gv1

Type: Distribute

Volume ID: 4782dd87-a411-44b3--70dfb072b5d0

Status: Started

Snapshot Count:

Number of Bricks:

Transport-type: tcp

Bricks:

Brick1: gfs1.cluster.com:/data/gluster/brick

Brick2: gfs2.cluster.com:/data/gluster/brick

Options Reconfigured:

transport.address-family: inet

nfs.disable: on

3.3 条带化卷(Stripe Volume)

mkdir -p /data/gluster/stripebrick gluster volume create gv3 stripe transport tcp gfs1.cluster.com:/data/gluster/stripebrick gfs2.cluster.com:/data/gluster/stripebrick gluster volume start gv3

[root@gfs1 mnt]# mkdir -p /data/gluster/stripebrick

[root@gfs1 mnt]# gluster volume create gv3 stripe transport tcp gfs1.cluster.com:/data/gluster/stripebrick gfs2.cluster.com:/data/gluster/stripebrick

volume create: gv3: success: please start the volume to access data

[root@gfs1 mnt]# gluster volume start gv3

volume start: gv3: success

[root@gfs1 mnt]# gluster volume info gv3 Volume Name: gv3

Type: Stripe

Volume ID: c25a10b8-a943-4c40-93be-088b972cbbaa

Status: Started

Snapshot Count:

Number of Bricks: x =

Transport-type: tcp

Bricks:

Brick1: gfs1.cluster.com:/data/gluster/stripebrick

Brick2: gfs2.cluster.com:/data/gluster/stripebrick

Options Reconfigured:

transport.address-family: inet

nfs.disable: on

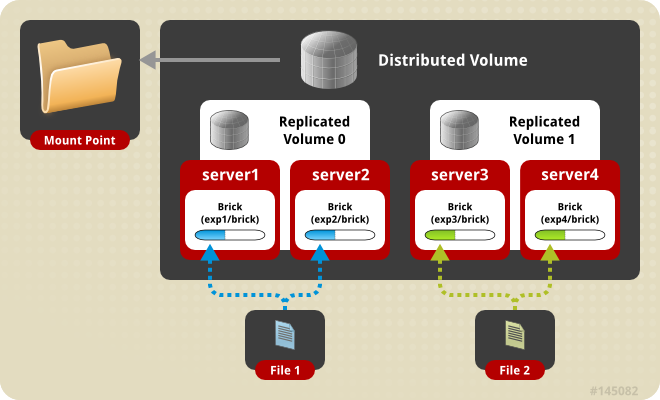

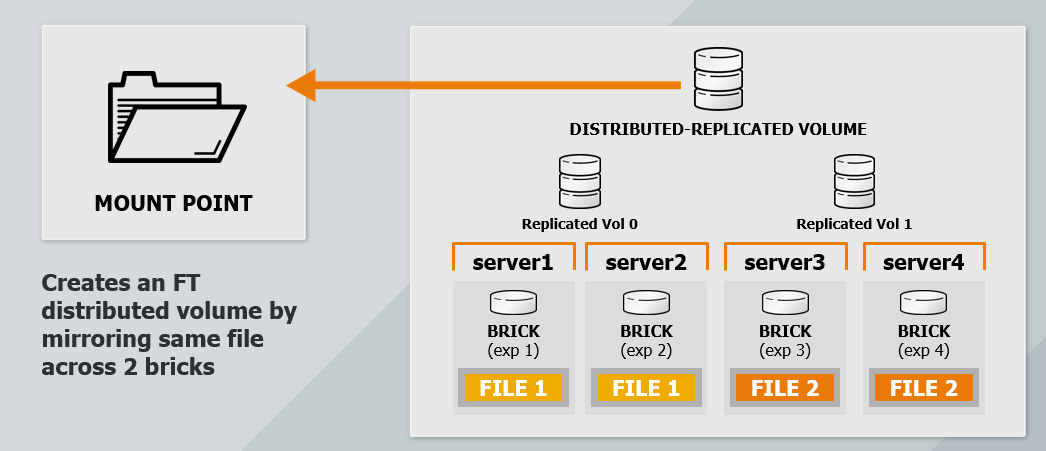

3.4 分布式复制卷

更详细拓扑结构和管理说明参考官方文档,值得你阅读

https://access.redhat.com/documentation/en-us/red_hat_gluster_storage/3/html/administration_guide/

4.客户端配置

支持的客户端协议

yum install -y glusterfs-client

mkdir -p /mnt/glusterfs

mount -t glusterfs gfs1.cluster.com:/gv0 /mnt/glusterfs

验证挂载

[root@master ~]# df -hP /mnt/glusterfs

Filesystem Size Used Avail Use% Mounted on

gfs1.cluster.com:/gv0 .8G 136M .2G % /mnt/glusterfs

在node1和node2上也mount上glusterfs gv0,便于查看里面内容

[root@gfs1 ~]# mount -t glusterfs gfs2.cluster.com:/gv0 /mnt

[root@gfs2 ~]# mount -t glusterfs gfs1.cluster.com:/gv0 /mnt

然后基于客户端进行文件创建删除,同时将node1进行停机的高可用测试。

Glusterfs初试的更多相关文章

- CentOS 6 部署GlusterFS

首先需要关闭CentOS的防火墙和selinux,否则glusterfs将可能无法正常工作. /etc/init.d/iptables status 会得到一系列信息,说明防火墙开着. /etc/in ...

- Ubuntu Server 12.04下部署glusterfs

1.安装环境 Linux:Ubuntuserver 12.04.1 LTS 64bit 2台 分布式文件系统:Gluster 测试环境:一台作文件服务器端(192.168.56.133),一台作客户端 ...

- glusterFS系统中文管理手册(转载)

GlusterFS系统中文管理手册 1文档说明 该文档主要内容出自 www.gluster.org 官方提供的英文系统管理手册<Gluster File System 3.3.0 A ...

- caffe初试(一)happynear的caffe-windows版本的配置及遇到的问题

之前已经配置过一次caffe环境了: Caffe初试(一)win7_64bit+VS2013+Opencv2.4.10+CUDA6.5配置Caffe环境 但其中也提到,编译时,用到了cuda6.5,但 ...

- centos7 搭建GlusterFS

centos7 搭建GlusterFS 转载http://zhaijunming5.blog.51cto.com/10668883/1704535 实验需求:4台机器安装GlusterFS组成一个集群 ...

- glusterfs 中的字典查询

glusterfs文件系统是一个分布式的文件系统,但是与很多分布式文件系统不一样,它没有元数服务器,听说swift上也是应用了这个技术的.glusterfs中每个xlator的配置信息都是用dict进 ...

- glusterfs 内存管理方式

glusterfs中的内存管理方式: 首先来看看glusterfs的内存管理结构吧: struct mem_pool { struct list_head list; int hot_count; i ...

- 初试Nodejs——使用keystonejs创建博客网站2(修改模板)

上一篇(初试Nodejs——使用keystonejs创建博客网站1(安装keystonejs))讲了keystonejs的安装.安装完成后,已经具备了基本的功能,我们需要对页面进行初步修改,比如,增加 ...

- 项目中初试PHP单元测试

只能叫初试,前面虽然做了一些PHPUnit与团队所用框架的整合,但在整个团队还没有人可以主动推动这个事情,而作为Leader最重要的一种能力应该是"让正确的事情发生",所以今天开始 ...

随机推荐

- Loadrunner乱码问题

在LoadRunner中录制脚本时,出现乱码的问题解决 我在录制一个Web的脚本时,出现中文乱码. 原因为Web中采用的是UTF-8编码,而录制脚本的选项默认没有把支持UTF8选中. 方法:1. To ...

- SQLite数据库、ListView控件的使用

android下数据库的创建(重点) 在Android平台上,集成了一个轻量级嵌入式关系型数据库—SQLite,SQLite3支持 NULL.INTEGER.REAL(浮点数字).TEXT(字符串文本 ...

- tp5总结(二)

1.简化路由[一方面可以更好的让搜索引擎抓取:另一方面简化路由,利于记忆] 1-1.在[public/]下面创建admin.php 复制index.php 然后绑定前后台模块define('BIND_ ...

- [CodeForces]CodeForces - 1025F Disjoint Triangles

题意: 给出平面上n个点,问能在其中选出6个点,组成两个三角形,使得其互不相交 问有多少种选法 大致思路 考虑枚举一条直线,将所有得点分为左右两部分,其中有两个点在直线上, 以这两个点为顶点,分别统 ...

- Swift2.0语言教程之类的方法

Swift2.0语言教程之类的方法 Swift2.0语言的方法 方法其实就是函数,只不过它被定义在了类中.在Swift中,根据被使用的方式不同,方法分为了实例方法和类型方法两种.这两种方法的定义也和O ...

- tensorflow模块安装

有时候,我们的电脑上或许会同时安装多个python的环境,譬如,我的电脑上同时装了anaconda2和3. 在安装的时候,譬如,我想在python3中装tensorflow,则需要在 C:\Progr ...

- CSS HTML 常用属性备忘录

学习软件设计有一年多了,明年五月就要毕业了.回头看看发现自己其实挺差劲的. 最近开通了博客所以就整理了一下笔记,在这里发布一下自己以前学习css时总是记不住去翻书又很常用的属性,都是一些很基础的. 大 ...

- 快速排序之C++实现

快速排序之C++实现 一趟快速排序的算法是: 1)设置两个变量i.j,排序开始的时候:i=0,j=N-1: 2)以第一个数组元素作为关键数据,赋值给key,即key=A[0]: 3)从j开始向前搜索, ...

- 「JSOI2018」战争

「JSOI2018」战争 解题思路 我们需要每次求给一个凸包加上一个向量后是否与另外一个凸包相交,也就是说是否存在 \[ b\in B,(b+w)\in A \] 这里 \(A, B\) 表示凸包内部 ...

- bzoj4399 魔法少女LJJ 线段树合并

只看题面绝对做不出系列.... 注意到\(c \leqslant 7\),因此不会有删边操作(那样例删边干嘛) 注意到\(2, 5\)操作十分的有趣,启示我们拿线段树合并来做 操作\(7\)很好处理 ...