springboot中实现kafa指定offset消费

kafka消费过程难免会遇到需要重新消费的场景,例如我们消费到kafka数据之后需要进行存库操作,若某一时刻数据库down了,导致kafka消费的数据无法入库,为了弥补数据库down期间的数据损失,有一种做法我们可以指定kafka消费者的offset到之前某一时间的数值,然后重新进行消费。

首先创建kafka消费服务

@Service

@Slf4j

//实现CommandLineRunner接口,在springboot启动时自动运行其run方法。

public class TspLogbookAnalysisService implements CommandLineRunner {

@Override

public void run(String... args) {

//do something

}

}

kafka消费模型建立

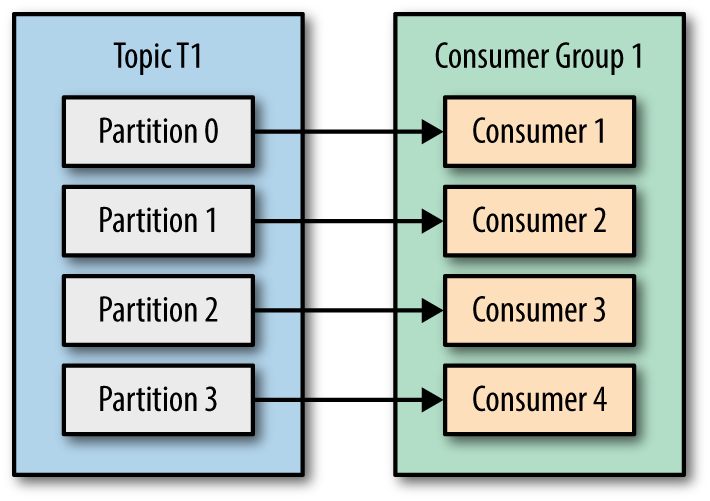

kafka server中每个主题存在多个分区(partition),每个分区自己维护一个偏移量(offset),我们的目标是实现kafka consumer指定offset消费。

在这里使用consumer-->partition一对一的消费模型,每个consumer各自管理自己的partition。

@Service

@Slf4j

public class TspLogbookAnalysisService implements CommandLineRunner {

//声明kafka分区数相等的消费线程数,一个分区对应一个消费线程

private static final int consumeThreadNum = 9;

//特殊指定每个分区开始消费的offset

private List<Long> partitionOffsets = Lists.newArrayList(1111,1112,1113,1114,1115,1116,1117,1118,1119);

private ExecutorService executorService = Executors.newFixedThreadPool(consumeThreadNum);

@Override

public void run(String... args) {

//循环遍历创建消费线程

IntStream.range(0, consumeThreadNum)

.forEach(partitionIndex -> executorService.submit(() -> startConsume(partitionIndex)));

}

}

kafka consumer对offset的处理

声明kafka consumer的配置类

private Properties buildKafkaConfig() {

Properties kafkaConfiguration = new Properties();

kafkaConfiguration.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "");

kafkaConfiguration.put(ConsumerConfig.GROUP_ID_CONFIG, "");

kafkaConfiguration.put(ConsumerConfig.MAX_POLL_RECORDS_CONFIG, "");

kafkaConfiguration.put(ConsumerConfig.AUTO_COMMIT_INTERVAL_MS_CONFIG, "");

kafkaConfiguration.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "");

kafkaConfiguration.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "");

kafkaConfiguration.put(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG,"");

kafkaConfiguration.put(ConsumerConfig.ENABLE_AUTO_COMMIT_CONFIG, "");

...更多配置项

return kafkaConfiguration;

}

创建kafka consumer,处理offset,开始消费数据任务

private void startConsume(int partitionIndex) {

//创建kafka consumer

KafkaConsumer<String, byte[]> consumer = new KafkaConsumer<>(buildKafkaConfig());

try {

//指定该consumer对应的消费分区

TopicPartition partition = new TopicPartition(kafkaProperties.getKafkaTopic(), partitionIndex);

consumer.assign(Lists.newArrayList(partition));

//consumer的offset处理

if (collectionUtils.isNotEmpty(partitionOffsets) && partitionOffsets.size() == consumeThreadNum) {

Long seekOffset = partitionOffsets.get(partitionIndex);

log.info("partition:{} , offset seek from {}", partition, seekOffset);

consumer.seek(partition, seekOffset);

}

//开始消费数据任务

kafkaRecordConsume(consumer, partition);

} catch (Exception e) {

log.error("kafka consume error:{}", ExceptionUtils.getFullStackTrace(e));

} finally {

try {

consumer.commitSync();

} finally {

consumer.close();

}

}

}

消费数据逻辑,offset操作

private void kafkaRecordConsume(KafkaConsumer<String, byte[]> consumer, TopicPartition partition) {

while (true) {

try {

ConsumerRecords<String, byte[]> records = consumer.poll(TspLogbookConstants.POLL_TIMEOUT);

//具体的处理流程

records.forEach((k) -> handleKafkaInput(k.key(), k.value()));

//

springboot中实现kafa指定offset消费的更多相关文章

- spark streaming从指定offset处消费Kafka数据

spark streaming从指定offset处消费Kafka数据 -- : 770人阅读 评论() 收藏 举报 分类: spark() 原文地址:http://blog.csdn.net/high ...

- springboot中RedisTemplate的使用

springboot中RedisTemplate的使用 参考 了解 Redis 并在 Spring Boot 项目中使用 Redis--以IBM为学习模板 springboot之使用redistemp ...

- javascript中常用坐标属性offset、scroll、client

原文:javascript中常用坐标属性offset.scroll.client 今天在学习js的时候觉得这个问题比较容易搞混,所以自己画了一个简单的图,并且用js控制台里面输出测试了下,便于理解. ...

- SpringBoot(四)SpringBoot中lombok使用

lombok概述 lombok简介 Lombok想要解决了的是在我们实体Bean中大量的Getter/Setter方法,以及toString, hashCode等可能不会用到,但是某些时候仍然需要复写 ...

- SpringBoot 中常用注解@PathVaribale/@RequestParam/@GetMapping介绍

SpringBoot 中常用注解@PathVaribale/@RequestParam/@GetMapping介绍 本篇博文将介绍几种如何处理url中的参数的注解@PathVaribale/@Requ ...

- SpringBoot中对于异常处理的提供的五种处理方式

1.自定义错误页面 SpringBoot 默认的处理异常机制:SpringBoot默认的已经提供了一套处理异常的机制.一旦程序中出现了异常,SpringBoot会向/error的url发送请求.在Sp ...

- Spring-boot中@ConfigurationProperties,@Value,@PropertySource

1.利用@ConfigurationProperties获取配置的值,@ConfigurationProperties是springboot提供的基于安全类型的配置放置. application.pr ...

- Springboot中使用Xstream进行XML与Bean 相互转换

在现今的项目开发中,虽然数据的传输大部分都是用json格式来进行传输,但是xml毕竟也会有一些老的项目在进行使用,正常的老式方法是通过获取节点来进行一系列操作,个人感觉太过于复杂.繁琐.推荐一套简单的 ...

- springBoot中实现自定义属性配置、实现异步调用、多环境配置

springBoot中其他相关: 1:springBoot中自定义参数: 1-1.自定义属性配置: 在application.properties中除了可以修改默认配置,我们还可以在这配置自定义的属性 ...

随机推荐

- 二、netcore跨平台之 Linux部署nginx代理webapi

上一章,我们讲了在linux上安装netcore环境,以及让netcore在linux上运行. 这一章我们开始讲在linux上配置nginx,以及让nginx反向代理我们的webapi. 什么ngin ...

- 达梦关键字(如:XML,EXCHANGE,DOMAIN,link等)配置忽略

背景:在使用达梦数据库时,查询SQL中涉及XML,EXCHANGE,DOMAIN,link字段,在达梦中是关键字,SQL报关键词不能使用的错误. 解决办法: 配置达梦安装文件E:\MyJava\dmd ...

- 2019-9-17:基础学习,windows server 2008 r2,搭建web服务器和FTP服务器

一.信息服务iis管理器安装 1,点击打开“服务器管理器”-->选择“角色”-->选择“添加角色”,打开“添加角色向导” 2,点击“下一步”-->勾选“web服务器(IIS)”--& ...

- oracle表结构

表管理 新建表 语法 create table 表名 ( 列名1 类型(长度), 列名2 类型(长度), 列名3 类型(长度) ); create table:关键字,建表 后跟新建表的表名,表名长度 ...

- Stream系列(七)distinct方法使用

EmployeeTestCase.java package com.example.demo; import lombok.Data; import lombok.ToString; import l ...

- nginx-(三)基本模块1

nginx常用模块介绍 ngx_http_access_module模块的配置(基于IP的访问控制) allow address | CIDR | unix: | all; deny address ...

- 题解 P3954 【成绩】

题目评级: ★ (水题) 内容及算法: 无,简单模拟计算即可 代码: /** *@author little_frog */ #include <bits/stdc++.h> using ...

- 题解 P1226 【【模板】快速幂||取余运算】

1.题目分析 原题 本题在于快速幂的使用,以及对long long的应用问题. 2.解题思路 快速幂 求幂常见用法: int pow(int a,int b) { int ans; for(int i ...

- 01_Numpy基本使用

1.Numpy读取txt/csv文件 读取数据 import numpy as np # numpy打开本地txt文件 world_alcohol = np.genfromtxt("D:\\ ...

- 二叉查找树的平衡(DSW算法)

树适合于表示某些领域的层次结构(比如Linux的文件目录结构),使用树进行查找比使用链表快的多,理想情况下树的查找复杂度O(log(N)),而链表为O(N),但理想情况指的是什么情况呢?一般指树是完全 ...