spark streaming 接收kafka消息之一 -- 两种接收方式

源码分析的spark版本是1.6。

首先,先看一下 org.apache.spark.streaming.dstream.InputDStream 的 类说明:

This is the abstract base class for all input streams. This class provides methods start() and stop()

which is called by Spark Streaming system to start and stop receiving data. Input streams that can

generate RDDs from new data by running a service/thread only on the driver node (that is, without

running a receiver on worker nodes), can be implemented by directly inheriting this InputDStream.

For example, FileInputDStream, a subclass of InputDStream, monitors a HDFS directory from the driver

for new files and generates RDDs with the new files. For implementing input streams that requires

running a receiver on the worker nodes, use org.apache.spark.streaming.dstream.ReceiverInputDStream

as the parent class.

翻译如下:

所有输入stream 的抽象父类,这个类提供了 start 和 stop 方法, 这两个方法被spark streaming系统来开始接收或结束接收数据。

两种接收数据的两种方式:

在driver 端接收数据;

1. 输入流通过在driver 节点上运行一个线程或服务,从新数据产生 RDD,继承自 InputDStream 的子类

2. 输入流通过运行在 worker 节点上的一个receiver ,从新数据产生RDD , 继承自 org.apache.spark.streaming.dstream.ReceiverInputDStream

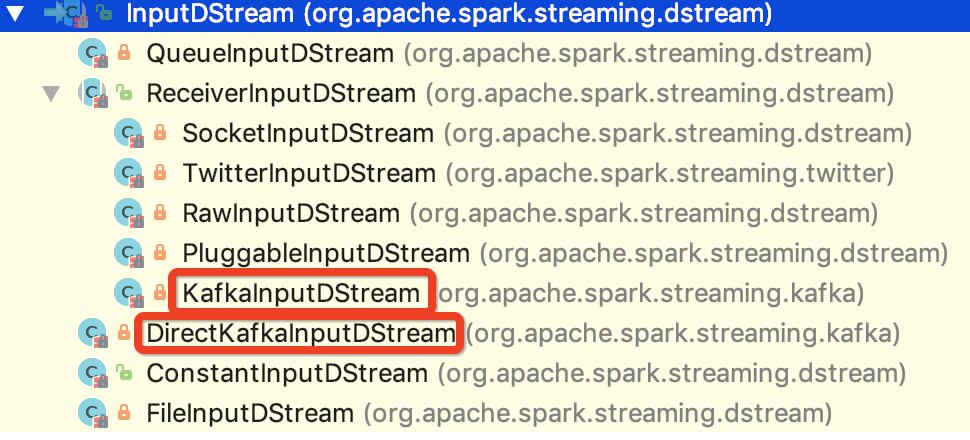

也就是说 spark 1.6 版本的输入流的抽象父类就是 org.apache.spark.streaming.dstream.InputDStream,其子类如下图所示:

与kafka 对接的两个类已经 在上图中标明。

现在对两种方式做一下简单的比较:

相同点:

1.内部都是通过SimpleConsumer 来获取消息,在获取消息之前,在获取消息之前,from offset 和 until offset 都已经确定。

2.都需要在构造 FetchRequest之前,确定leader, offset 等信息。

3. 其内部都有一个速率评估器,起到平衡速率的作用

不同点:

1. offset 的管理不同。

DirectKafkaInputStream 可以通过外部介质来管理 offset, 比如 redis, mysql等数据库,也可以是hbase等。

KafkaInputStream 则需要使用zookeeper 来管理consumer offset数据, 其内部需要监控zookeeper 的状态。

2. receiver运行的节点不同。

DirectKafkaInputStream 对应的 receiver 是运行在 driver 节点上的。

KafkaInputStream 对应的 receiver 是运行在非driver 的executor 上的。

3. 内部对应的RDD不一样。

DirectKafkaInputStream 对应的是 KafkaRDD,内部的迭代器是KafkaRDDIterator

KafkaInputStream 对应的是 WriteAheadLogBackedBlockRDD 或者是 BlockRDD,内部的迭代器 是自定义的 NextIterator

4. 保证Exactly-once 语义的机制不一样。

DirectKafkaInputStream 是根据 offset 和 KafkaRDD 的机制来保证 exactly-once 语义的

KafkaInputStream 是根据zookeeper的 offset 和WAL 机制来保证 exactly-once 语义的,接收到消息之后,会先保存到checkpoint 的 WAL 中

spark streaming 接收kafka消息之一 -- 两种接收方式的更多相关文章

- SparkStreaming与Kafka,SparkStreaming接收Kafka数据的两种方式

SparkStreaming接收Kafka数据的两种方式 SparkStreaming接收数据原理 一.SparkStreaming + Kafka Receiver模式 二.SparkStreami ...

- Spark Streaming中空batches处理的两种方法(转)

原文链接:Spark Streaming中空batches处理的两种方法 Spark Streaming是近实时(near real time)的小批处理系统.对给定的时间间隔(interval),S ...

- spark streaming 接收kafka消息之五 -- spark streaming 和 kafka 的对接总结

Spark streaming 和kafka 处理确保消息不丢失的总结 接入kafka 我们前面的1到4 都在说 spark streaming 接入 kafka 消息的事情.讲了两种接入方式,以及s ...

- Spark Streaming与Kafka集成

Spark Streaming与Kafka集成 1.介绍 kafka是一个发布订阅消息系统,具有分布式.分区化.多副本提交日志特点.kafka项目在0.8和0.10之间引入了一种新型消费者API,注意 ...

- Spark Streaming 交互 Kafka的两种方式

一.Spark Streaming连Kafka(重点) 方式一:Receiver方式连:走磁盘 使用High Level API(高阶API)实现Offset自动管理,灵活性差,处理数据时,如果某一时 ...

- spark streaming集成kafka接收数据的方式

spark streaming是以batch的方式来消费,strom是准实时一条一条的消费.当然也可以使用trident和tick的方式来实现batch消费(官方叫做mini batch).效率嘛,有 ...

- Spark Streaming和Kafka整合保证数据零丢失

当我们正确地部署好Spark Streaming,我们就可以使用Spark Streaming提供的零数据丢失机制.为了体验这个关键的特性,你需要满足以下几个先决条件: 1.输入的数据来自可靠的数据源 ...

- spark streaming 整合 kafka(一)

转载:https://www.iteblog.com/archives/1322.html Apache Kafka是一个分布式的消息发布-订阅系统.可以说,任何实时大数据处理工具缺少与Kafka整合 ...

- Spark Streaming使用Kafka保证数据零丢失

来自: https://community.qingcloud.com/topic/344/spark-streaming使用kafka保证数据零丢失 spark streaming从1.2开始提供了 ...

随机推荐

- 多线程下使用使用 UniDAC+MSSQL 需要注意的问题(使用CoInitialize)

ADO线程不安全,UniDAC 在使用MSSQL也是如此.其实这是微软COM问题,不怪Devart公司. 一般解决方法是在线程开始启用 CoInitialize(nil),线程结束调用 CoUnini ...

- Qt 自定义事件(三种方法:继承QEvent,然后Send Post就都可以了,也可以覆盖customEvent函数,也可覆盖event()函数)

Qt 自定义事件很简单,同其它类库的使用很相似,都是要继承一个类进行扩展.在 Qt 中,你需要继承的类是 QEvent. 继承QEvent类,你需要提供一个QEvent::Type类型的参数,作为自定 ...

- JSON格式的服务接口

电商接口 京东获取单个商品价格接口: http://p.3.cn/prices/mgets?skuIds=J_商品ID&type=1 用例 ps:商品ID这么获取:http://item.jd ...

- oracle备份和升级数据库

同oracle用户登录数据库驻留server.例如,主文件夹/home./oracle.运行以下命令来执行备份操作. sqlplus /nolog connect /as sysdba sql> ...

- LeetCode OJ平台Sort Colors讨论主题算法

原题如下面,这意味着无序排列(由0,1,2组成).一号通.组织成若干阵列0-几个1-几个2这样的序列. Given an array with n objects colored red, white ...

- git clone命令简介

git clone: 正如上图,当我们打开终端的情况下,默认我们所在的目录是在/home/shiyanlou的,大家可以在终端输入以下命令把目录切换到桌面cd /home/Desktop这个时候输入 ...

- vim for windows download and installation

这是vim皇冠vim简要 ------------------------------------------------- WHAT IS VIM Vim is an almost compatib ...

- ShopNC本地生活o2o网站的源代码,没有域名限制

较前某VIP源代码论坛分享了套ShopNC本地生活o2o站点系统.下载过来却发现根本不能用,所以一直没分享出来.今天咱们这边分享的这套ShopNC本地生活o2o站点源代码,无不论什么的限制,直接ins ...

- 解决popup不随着window一起移动的问题

原文:解决popup不随着window一起移动的问题 当我们设置Popup的StayOpen="True"时,会发现移动窗体或者改变窗体的Size的时候,Popup并不会跟随着一起 ...

- 安德鲁斯Toast它们的定义和防止重复显示器

Toast安卓系统,当用户错误或功能运行完成,提示,要求用户,它不集中,并且将在一定时间内消失.然而,在用户继续误(如登录,password错)当次,将有多个Toast创建.系统会把这些toast放进 ...