【Python3爬虫】网易云音乐歌单下载

一、目标:

下载网易云音乐热门歌单

二、用到的模块:

requests,multiprocessing,re。

三、步骤:

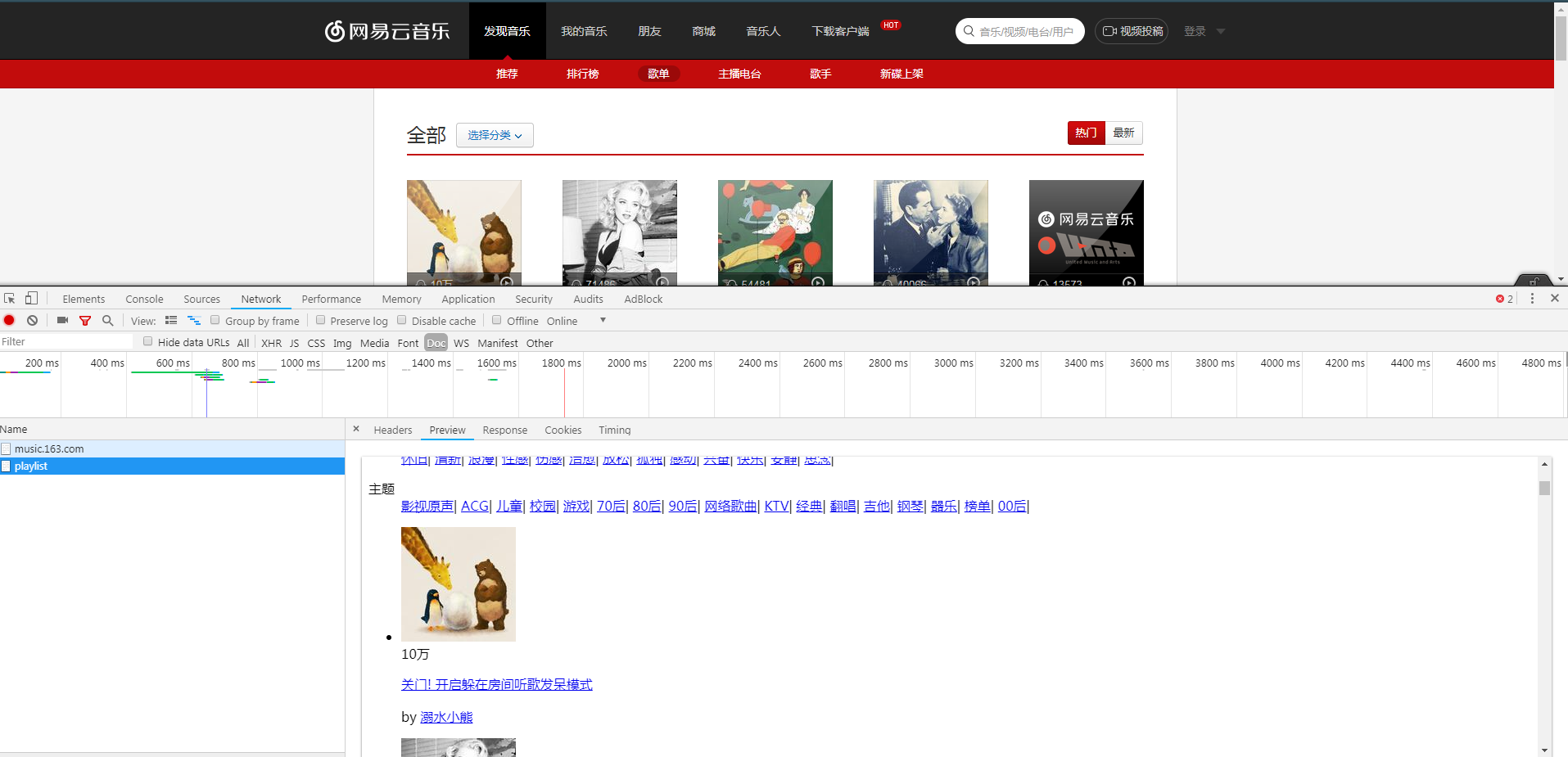

(1)页面分析:首先打开网易云音乐,选择热门歌单,可以看到以下歌单列表,然后打开开发者工具

因此我们需要请求的url就是https://music.163.com/discover/playlist,然后用requests.get()方法请求页面,对于返回的结果,用正则表达式进行解析,得到歌单名字和歌单id,解析的正则表达式如下:

res = requests.get(url, headers=headers)

data = re.findall('<a title="(.*?)" href="/playlist\?id=(\d+)" class="msk"></a>', res.text)

(2)得到歌单名字和歌单id后,构造歌单的url,然后模仿步骤(1)可以得到歌曲名字和歌曲id,解析的正则表达式如下:

re.findall(r'<a href="/song\?id=(\d+)">(.*?)</a>', res.text)

再得到歌曲id后,构造歌曲的url,然后用requests.get().content方法下载歌曲,歌曲的url构造方法如下:

"http://music.163.com/song/media/outer/url?id=%s" %(歌曲id)

(3)由于部分歌曲的名字并不能作为文件名保存下来,所以用到了try...except,对于不能保存为文件名的歌曲,我选择pass掉==

(4)因为要下载多个歌单,一个歌单里又有很多歌曲,所以用到了multiprocessing模块的Pool方法,提高程序运行的效率。

四、具体代码

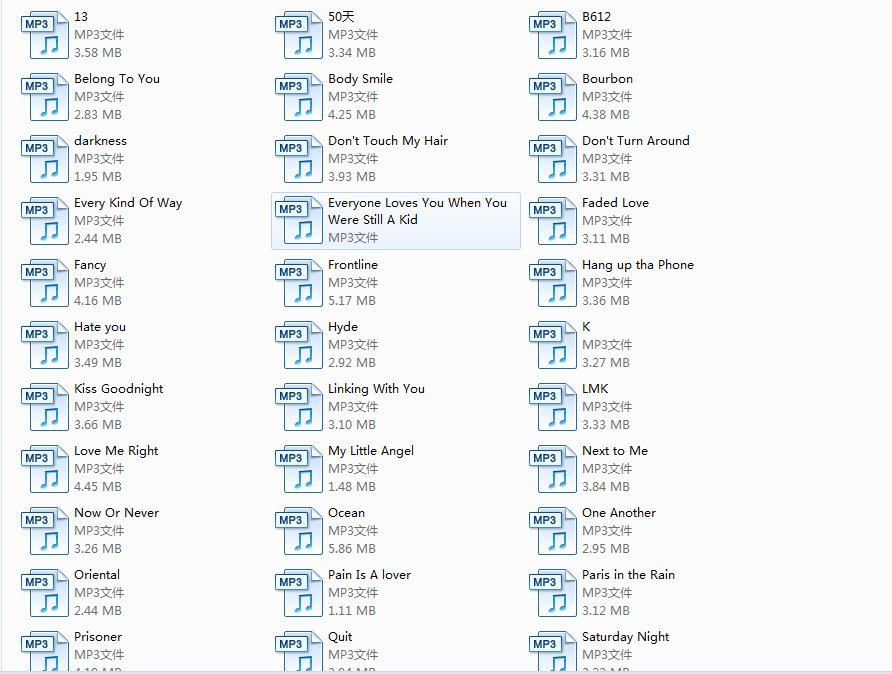

因为下载所有歌单会需要很长时间,所以我们先下载前三个歌单试试==

import requests

import re

from multiprocessing import Pool headers = {

'Referer': 'https://music.163.com/',

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.89 "

"Safari/537.36"

} def get_page(url):

res = requests.get(url, headers=headers)

data = re.findall('<a title="(.*?)" href="/playlist\?id=(\d+)" class="msk"></a>', res.text) pool = Pool(processes=4)

pool.map(get_songs, data[:3])

print("下载完毕!") def get_songs(data):

playlist_url = "https://music.163.com/playlist?id=%s" % data[1]

res = requests.get(playlist_url, headers=headers)

for i in re.findall(r'<a href="/song\?id=(\d+)">(.*?)</a>', res.text):

download_url = "http://music.163.com/song/media/outer/url?id=%s" % i[0]

try:

with open('music/' + i[1]+'.mp3', 'wb') as f:

f.write(requests.get(download_url, headers=headers).content)

except FileNotFoundError:

pass

except OSError:

pass if __name__ == '__main__':

hot_url = "https://music.163.com/discover/playlist/?order=hot"

get_page(hot_url)

五、运行结果

【Python3爬虫】网易云音乐歌单下载的更多相关文章

- 使用python3下载网易云音乐歌单歌曲,附源代码

""" 用selenium+PhantomJS配合,不需要进行逆向工程 python 3下的selenium不能默认安装,需要指定版本2.48.0 "" ...

- python爬取网易云音乐歌单音乐

在网易云音乐中第一页歌单的url:http://music.163.com/#/discover/playlist/ 依次第二页:http://music.163.com/#/discover/pla ...

- python3爬虫-网易云排行榜,网易云歌手及作品

import requests, re, json, os, time from fake_useragent import UserAgent from lxml import etree from ...

- 《云阅》一个仿网易云音乐UI,使用Gank.Io及豆瓣Api开发的开源项目

CloudReader 一款基于网易云音乐UI,使用GankIo及豆瓣api开发的符合Google Material Desgin阅读类的开源项目.项目采取的是Retrofit + RxJava + ...

- Python爬取网易云音乐歌手歌曲和歌单

仅供学习参考 Python爬取网易云音乐网易云音乐歌手歌曲和歌单,并下载到本地 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经做 ...

- 网易云音乐 歌词制作软件 BesLyric (最新版本下载)

导读 BesLyric , 一款专门制作 网易云音乐 LRC 滚动歌词的软件! 搜索.下载.制作 歌词更方便! 哈哈,喜欢网易云音乐,又愁于制作歌词的童鞋有福啦!Beslyric 为你排忧解难! 本文 ...

- 在Ubuntu18.04.2LTS上使用wine安装qq,微信,迅雷,百度网盘,网易云音乐等软件

在Ubuntu18.04.2LTS上使用wine安装qq,微信,迅雷,百度网盘,网易云音乐等软件 一.前言 在Linux上办公有一点一直是大家的痛,那就是这些系统上没有我们常用的一些软件,比如QQ,微 ...

- python3爬虫应用--爬取网易云音乐(两种办法)

一.需求 好久没有碰爬虫了,竟不知道从何入手.偶然看到一篇知乎的评论(https://www.zhihu.com/question/20799742/answer/99491808),一时兴起就也照葫 ...

- 【Python3爬虫】网易云音乐爬虫

此次的目标是爬取网易云音乐上指定歌曲所有评论并生成词云 具体步骤: 一:实现JS加密 找到这个ajax接口没什么难度,问题在于传递的数据,是通过js加密得到的,因此需要查看js代码. 通过断掉调试可以 ...

随机推荐

- Gatsby上手指南 - 让你的静态网站用react来高逼格的写

注意:Gatsby V2版本安装及使用问题请移步<Gastby V2安装过程中常见问题>,此文较旧,主要针对V1版Gatsby而介绍 前言 一直以来都是用之前比较流行的静态网站生成器Hex ...

- iOS调用系统发送短信和邮件分享

//发送邮件 -(void)sendMail:(NSString*)subject content:(NSString*)content{ MFMailComposeViewController*co ...

- python+matplotlib+绘制不同图标类型

#==================================================================#首先需要导入两个文件import matplotlib.pypl ...

- PBRT笔记(7)——反射模型

基础术语 表面反射可以分为4大类: diffuse 漫反射 glossy specular 镜面反射高光 perfect specular 完美反射高光 retro-reflective distri ...

- CentOS下SVN服务的启动与关闭

CentOS下SVN服务的启动与关闭 操作系统:CentOS 6.5 SVN版本:1.8.11 启动SVN服务: svnserve -d -r /home/svn /home/svn 为版本库的根 ...

- vue-router的学习

一.路由的概述. vue-router是vue.js官方的路由插件,它和vue.js是深度集成的,适用于构建单页面.vue的单页面应用是基于路由和组件的,路由是用于设定访问路径,并将路径和组件映射起来 ...

- JavaScript经典作用域问题(转载)

题目 var a = 10; function test(){ a = 100; console.log(a); console.log(this.a); var a; console.log(a); ...

- RTN 实操

创建房间 test-rtn 10001 e2uii6r7r 8LfwOcreM76OiV1V1y8jXrMG_BNa-cmktpWUznRa:kdYdsEpcYLc5ceWEHPaK0ZDI7Qc=: ...

- nvidia-smi GPU异常消失 程序中断

GPU型号为NVIDIA的1080Ti,最近出现的状况的是某一个GPU突然就出问题了,如果在该GPU上有运行程序的话则程序中断,nvidia-smi显示出来的GPU则少了这一个. 1.一开始怀疑是温度 ...

- sublime No packages available for installation

package control user-setting 中添加: "channels": [ "C:\\channel_v3.json" ], channel ...