6 zookeeper实现分布式锁

zookeeper实现分布式锁

仓库地址:https://gitee.com/J_look/ssm-zookeeper/blob/master/README.md

- 锁:我们在多线程中接触过,作用就是让当前的资源不会被其他线程访问!

我的日记本,不可以被别人看到。所以要锁在保险柜中

当我打开锁,将日记本拿走了,别人才能使用这个保险柜 - 在zookeeper中使用传统的锁引发的 “羊群效应” :1000个人创建节点,只有一个人能成功,999

人需要等待! - 羊群是一种很散乱的组织,平时在一起也是盲目地左冲右撞,但一旦有一只头羊动起来,其他的羊

也会不假思索地一哄而上,全然不顾旁边可能有的狼和不远处更好的草。羊群效应就是比喻人都有

一种从众心理,从众心理很容易导致盲从,而盲从往往会陷入骗局或遭到失败。

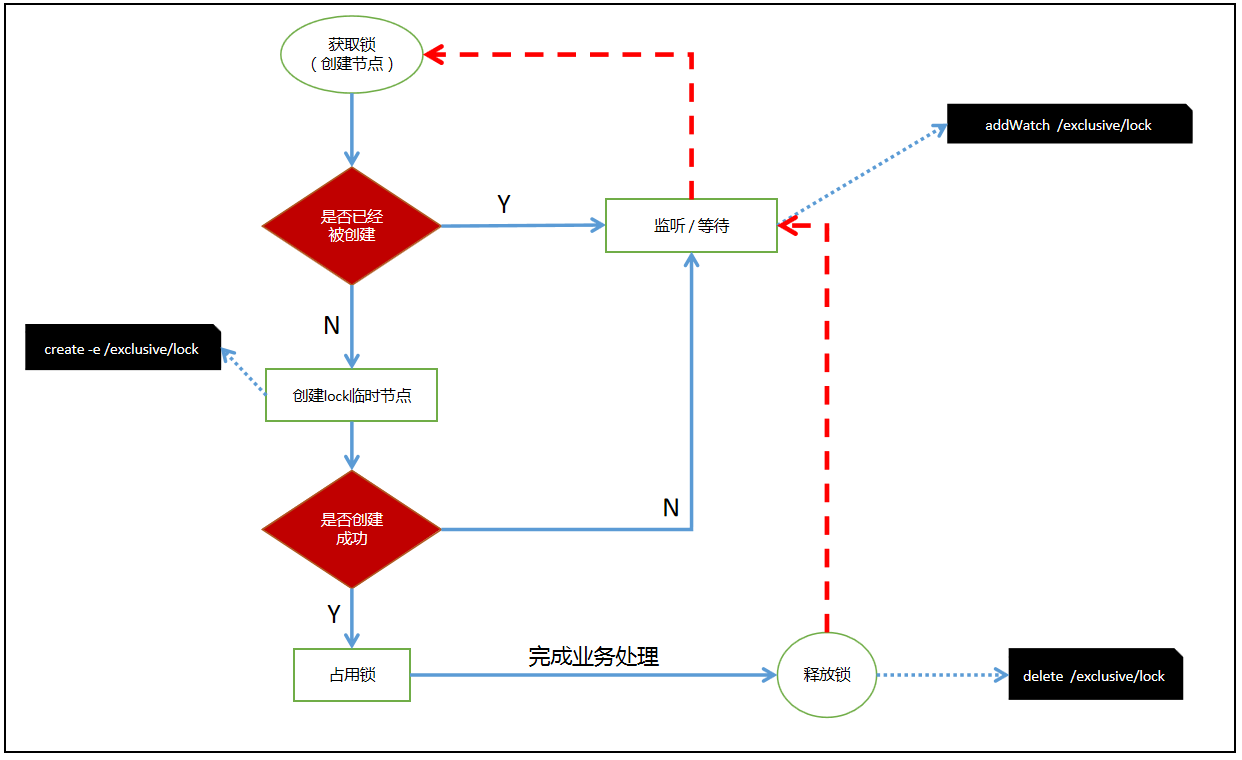

实现分布式锁大致流程

整体思路

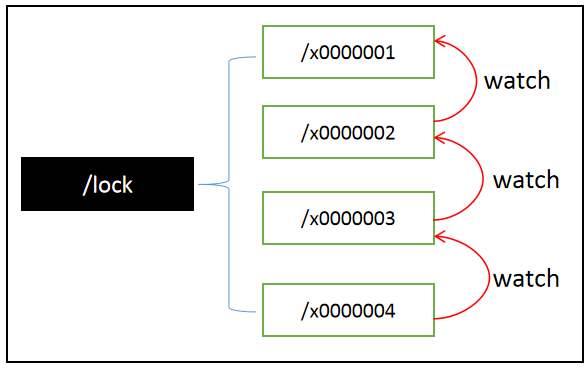

所有请求进来,在/lock下创建 临时顺序节点 ,放心,zookeeper会帮你编号排序

判断自己是不是/lock下最小的节点

是,获得锁(创建节点)

否,对前面小我一级的节点进行监听

获得锁请求,处理完业务逻辑,释放锁(删除节点),后一个节点得到通知(比你年轻的死了,你

成为最嫩的了)重复步骤2

安装nginx

安装nginx运行所需的库

//一键安装上面四个依赖

yum -y install gcc zlib zlib-devel pcre-devel openssl openssl-devel

下载nginx

在那个目录下执行这个命令 就会下载到哪个目录下

//下载tar包

wget http://nginx.org/download/nginx-1.13.7.tar.gz

解压

注意哦

解压出来的文件 我们还需要安装哦

下面所有的命令 都是在nginx-1.13.7文件夹里面进行哦

tar -zxvf nginx-1.13.7.tar.gz

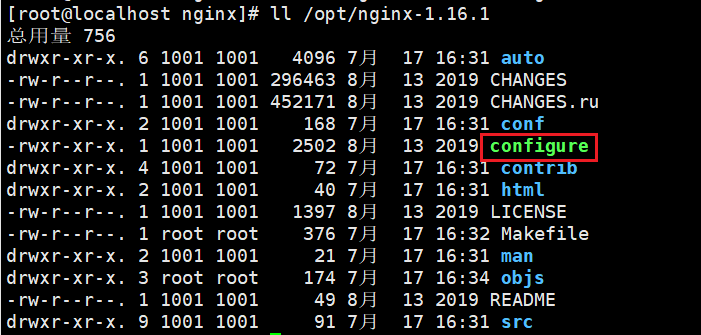

查看解压出来的文件

ll ./nginx-1.13.7

安装

创建一个文件夹,也就是nginx需要

安装到的位置

mkdir /usr/local/nginx

执行命令 考虑到后续安装ssl证书 添加两个模块

./configure --with-http_stub_status_module --with-http_ssl_module

执行make install命令

make install

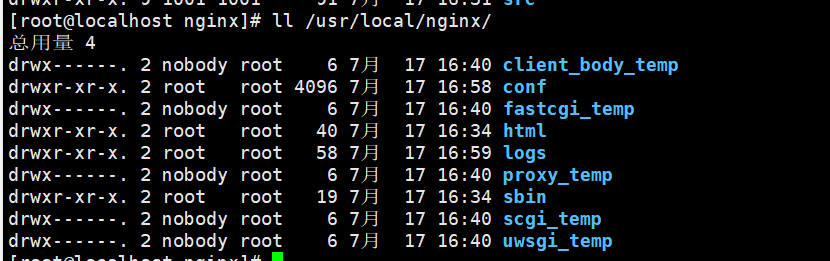

- 我们可以来到nginx安装到的目录下查看

- 你们没有我这么多目录 conf 配置 sbin 启动nginx

博主技术有限,还没有深入去学习nginx的 大致这样介绍吧

启动nginx服务

我这个是在/ 目录底下执行的 你们可以根据 自己所在的目录去执行

/usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.conf

访问nginx

nginx的默认端口是80

配置nginx

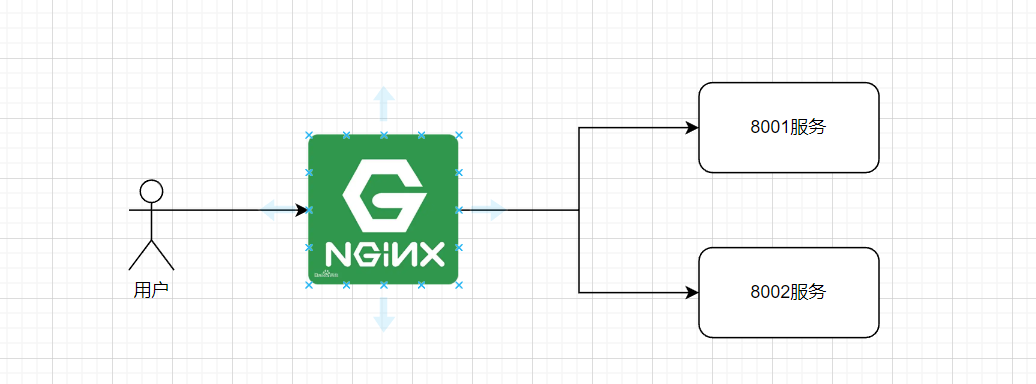

我们所做的配置大概就是

- 当有请求去访问我们服务器,

- 然后负载到我们处理请求的服务器 我这里是两台

- 为了方便 处理请求的这两台服务器 是在我Windows上

打开配置文件

# 打开配置文件

vim /usr/local/nginx/conf/nginx.conf

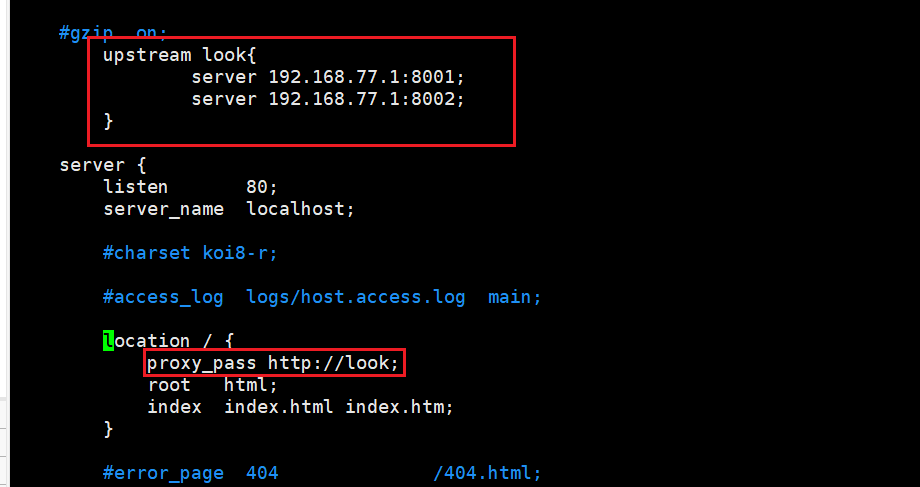

- 图中

红框的位置是需要添加的内容 - 配置含义: 我们的nginx监听的是服务器的80端口 当有请求访问时 会负载到 look代理里面 server是处理请求的两台服务器

查看本机ipWindows ==>ipconfig linux ==> ip a(ip address)

upstream look{

server 192.168.204.1:8001; //192.168.204.1是我本机的ip地址,8001是tomcat的端口号

server 192.168.204.1:8002; //8002是另外一个工程的tomcat端口号

}

server {

listen 80;

server_name localhost;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

proxy_pass http://look;

root html;

index index.html index.htm;

}

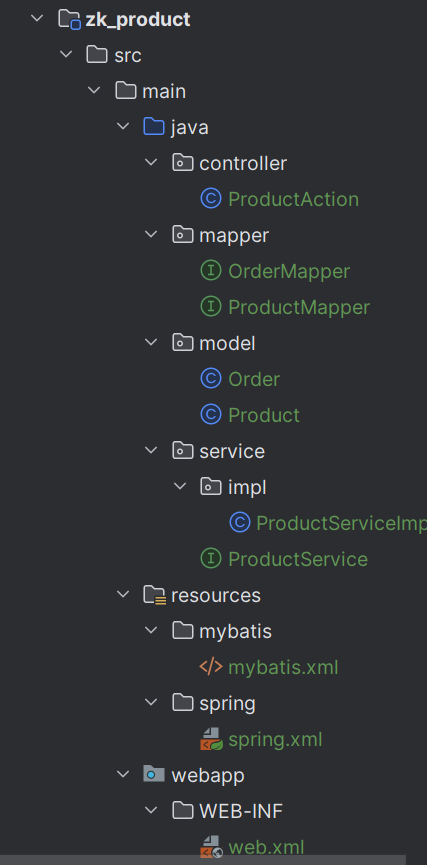

工程的搭建

搭建ssm框架 有时间推出springboot的版本

- 创建一个maven项目(普通maven项目即可)

创建数据库:

-- 商品表

create table product(

id int primary key auto_increment, -- 商品编号

product_name varchar(20) not null, -- 商品名称

stock int not null, -- 库存

version int not null -- 版本

)

insert into product (product_name,stock,version) values('锦鲤-清空购物车-大奖',5,0)

-- 订单表

create table `order`(

id varchar(100) primary key, -- 订单编号

pid int not null, -- 商品编号

userid int not null -- 用户编号

)

- 项目目录结构

添加依赖

简单解释一下build

- 我们引入的是tomcat7的插件

- configuration 配置的是端口 和根目录

- 注意哦 记得刷新pom文件 build里面会有爆红 不要紧张 不用管他 后面的配置他会自己消失

<properties>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<spring.version>5.2.7.RELEASE</spring.version>

</properties>

<packaging>war</packaging>

<dependencies>

<!-- Spring -->

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-context</artifactId>

<version>${spring.version}</version>

</dependency>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-beans</artifactId>

<version>${spring.version}</version>

</dependency>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-webmvc</artifactId>

<version>${spring.version}</version>

</dependency>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-jdbc</artifactId>

<version>${spring.version}</version>

</dependency>

<!-- Mybatis -->

<dependency>

<groupId>org.mybatis</groupId>

<artifactId>mybatis</artifactId>

<version>3.5.10</version>

</dependency>

<dependency>

<groupId>org.mybatis</groupId>

<artifactId>mybatis-spring</artifactId>

<version>2.0.7</version>

</dependency>

<!-- 连接池 -->

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>druid</artifactId>

<version>1.2.11</version>

</dependency>

<!-- 数据库 -->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.29</version>

</dependency>

<!-- junit -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>1.18.24</version>

</dependency>

</dependencies>

<build>

<plugins>

<!-- maven内嵌的tomcat插件 -->

<plugin>

<groupId>org.apache.tomcat.maven</groupId>

<!-- 目前apache只提供了tomcat6和tomcat7两个插件 -->

<artifactId>tomcat7-maven-plugin</artifactId>

<configuration>

<port>8002</port>

<path>/</path>

</configuration>

<executions>

<execution>

<!-- 打包完成后,运行服务 -->

<phase>package</phase>

<goals>

<goal>run</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

mybatis.xml

注意哦 :仔细查看上面的项目结构 创建相应的文件夹

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE configuration PUBLIC "-//mybatis.org//DTD Config 3.0//EN"

"http://mybatis.org/dtd/mybatis-3-config.dtd">

<configuration>

<!-- 后台的日志输出 输出到控制台-->

<settings>

<setting name="logImpl" value="STDOUT_LOGGING"/>

</settings>

</configuration>

spring.xml

注意哦 :仔细查看上面的项目结构 创建相应的文件夹

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:mvc="http://www.springframework.org/schema/mvc"

xmlns:context="http://www.springframework.org/schema/context"

xmlns:tx="http://www.springframework.org/schema/tx"

xsi:schemaLocation="http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/context

http://www.springframework.org/schema/context/spring-context.xsd

http://www.springframework.org/schema/tx

http://www.springframework.org/schema/tx/spring-tx.xsd">

<!-- 1.扫描包下的注解 -->

<context:component-scan base-package="controller,service,mapper"/>

<!-- 2.创建数据连接池对象 -->

<bean id="dataSource" class="com.alibaba.druid.pool.DruidDataSource"

destroy-method="close">

<property name="url" value="jdbc:mysql://localhost:3306/2022_zkproduct?serverTimezone=GMT"/>

<property name="driverClassName" value="com.mysql.jdbc.Driver"/>

<property name="username" value="root"/>

<property name="password" value="317311"/>

<property name="maxActive" value="10"/>

<property name="minIdle" value="5"/>

</bean>

<!-- 3.创建SqlSessionFactory,并引入数据源对象 -->

<bean id="sqlSessionFactory"

class="org.mybatis.spring.SqlSessionFactoryBean">

<property name="dataSource" ref="dataSource"></property>

<property name="configLocation" value="classpath:mybatis/mybatis.xml"></property>

</bean>

<!-- 4.告诉spring容器,数据库语句代码在哪个文件中-->

<!-- mapper.xDao接口对应resources/mapper/xDao.xml-->

<bean class="org.mybatis.spring.mapper.MapperScannerConfigurer">

<property name="basePackage" value="mapper"></property>

</bean>

<!-- 5.将数据源关联到事务 -->

<bean id="transactionManager"

class="org.springframework.jdbc.datasource.DataSourceTransactionManager">

<property name="dataSource" ref="dataSource"></property>

</bean>

<!-- 6.开启事务 -->

<tx:annotation-driven/>

</beans>

web.xml

注意哦 :仔细查看上面的项目结构 创建相应的文件夹

这里也会出现爆红,后面会自己消失

<?xml version="1.0" encoding="UTF-8"?>

<web-app xmlns="http://xmlns.jcp.org/xml/ns/javaee"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://xmlns.jcp.org/xml/ns/javaee

http://xmlns.jcp.org/xml/ns/javaee/web-app_3_1.xsd"

version="3.1">

<servlet>

<servlet-name>springMVC</servlet-name>

<servlet-class>org.springframework.web.servlet.DispatcherServlet</servlet-class>

<init-param>

<param-name>contextConfigLocation</param-name>

<param-value>classpath:spring/spring.xml</param-value>

</init-param>

<load-on-startup>1</load-on-startup>

<async-supported>true</async-supported>

</servlet>

<servlet-mapping>

<servlet-name>springMVC</servlet-name>

<url-pattern>/</url-pattern>

</servlet-mapping>

</web-app>

实体类

- @Data 是lombok的注解

Product

/**

* @author : look-word

* 2022-07-17 10:12

**/

@Data

public class Product implements Serializable {

private Integer id;

private String product_name;

private Integer stock;

private Integer version;

}

Order

/**

* @author : look-word

* 2022-07-17 10:12

**/

@Data

public class Order implements Serializable {

private String id;

private Integer pid;

private Integer userid;

}

持久层

ProductMapper

@Mapper

@Component

public interface ProductMapper {

// 查询商品(目的查库存)

@Select("select * from product where id = #{id}")

Product getProduct(@Param("id") int id);

// 减库存

@Update("update product set stock = stock-1 where id = #{id}")

int reduceStock(@Param("id") int id);

}

OrderMapper

@Mapper

@Component

public interface OrderMapper {

// 生成订单

@Insert("insert into `order` (id,pid,userid) values (#{id},#{pid},#{userid})")

int insert(Order order);

}

service

ProductService

/**

* @author : look-word

* 2022-07-17 10:28

**/

public interface ProductService {

// 扣除库存

void reduceStock(Integer id) throws Exception;

}

ProductServiceImpl

/**

* @author : look-word

* 2022-07-17 10:29

**/

@Transactional

@Service

public class ProductServiceImpl implements ProductService {

@Resource

private ProductMapper productMapper;

@Resource

private OrderMapper orderMapper;

@Override

public void reduceStock(Integer id) throws Exception {

// 查询商品库存

Product product = productMapper.getProduct(id);

if (product.getStock() <= 0) {

throw new RuntimeException("库存不足");

}

// 减库存

int i = productMapper.reduceStock(id);

if (i == 1) {

Order order = new Order();

order.setId(UUID.randomUUID().toString());

order.setUserid(1);

order.setPid(id);

Thread.sleep(500);

orderMapper.insert(order);

} else {

throw new RuntimeException("扣除库存失败");

}

}

}

controller

/**

* @author : look-word

* 2022-07-17 10:12

**/

@RestController

public class ProductAction {

@Resource

private ProductService productService;

@GetMapping("product/reduce/{id}")

private Object reduce(@PathVariable Integer id) throws Exception {

productService.reduceStock(id);

return "ok";

}

}

启动测试

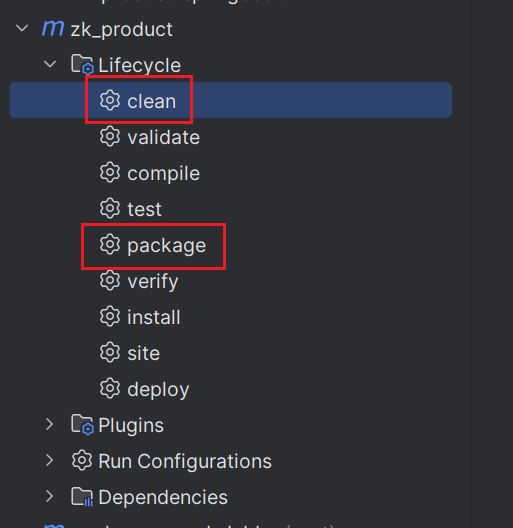

- 点击右侧的maven

还记得我们在pom.xml配置的tomcat的插件吗,我们配置的意思是

打包(package)之后会自动运行

- 在执行打包命令之前,先执行clean命令

- 执行package命令

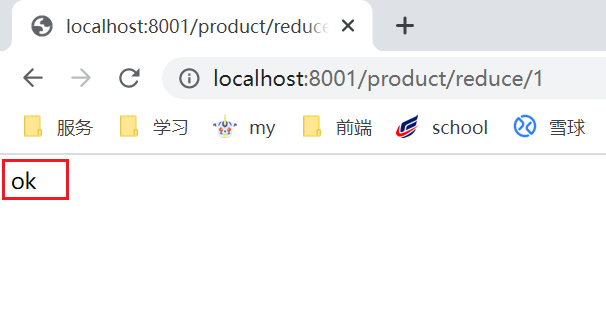

测试

- 浏览器访问

http://localhost:8001/product/reduce/1

访问流程

**注意**

在使用jmeter测试的时候 需要启动两个服务

- 在启动第一个之后 去修改pom里面的build里面tomcat插件的端口 8002

- 记得要

刷新pom文件,然后再打包启动即可

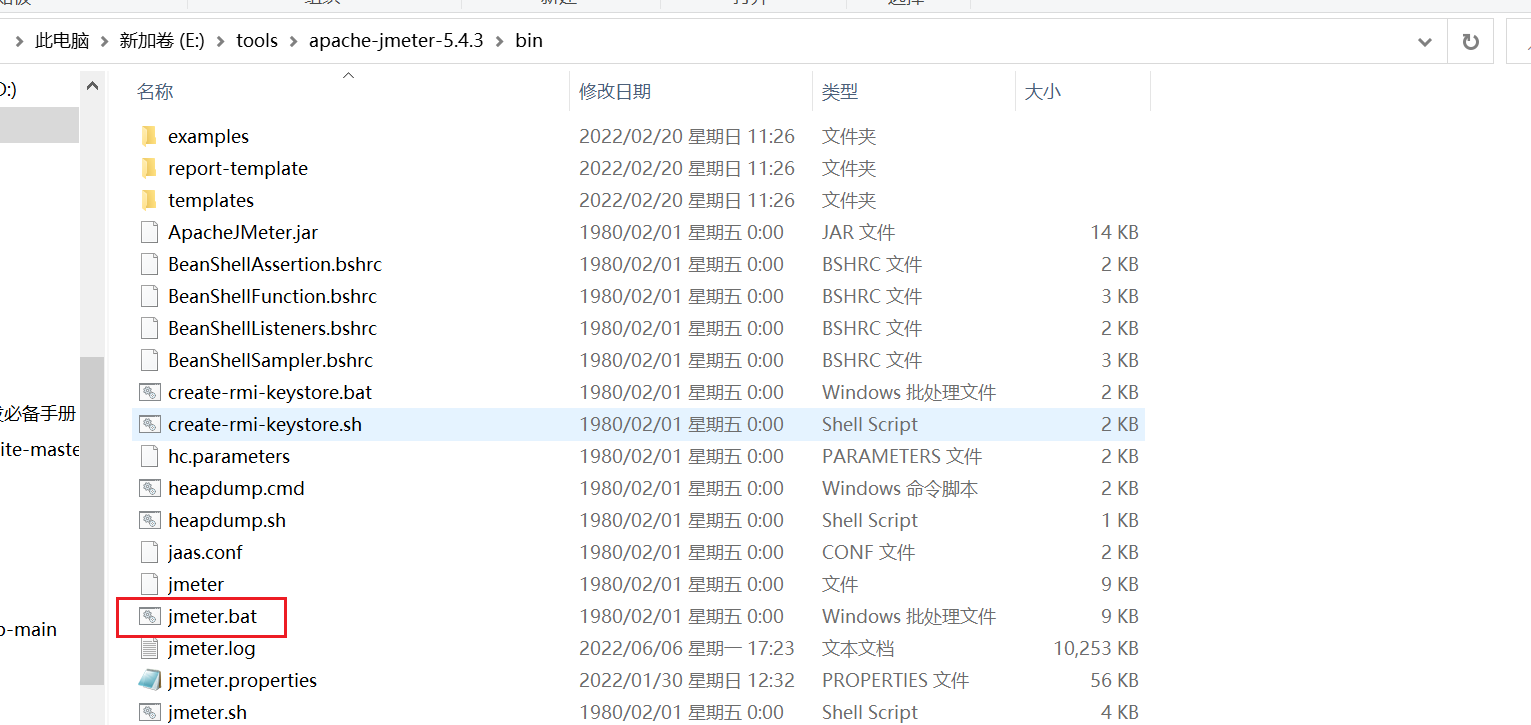

启动jmeter测试

简单阐述一下:我们会模拟高并发场景下对这个商品的库存进行扣减

- 这也就会导致一个问题,会出现商品超卖(出现负的库存)

- 出现的原因: 在同一时间,访问的请求很多。

解压双击jmeter.bat启动

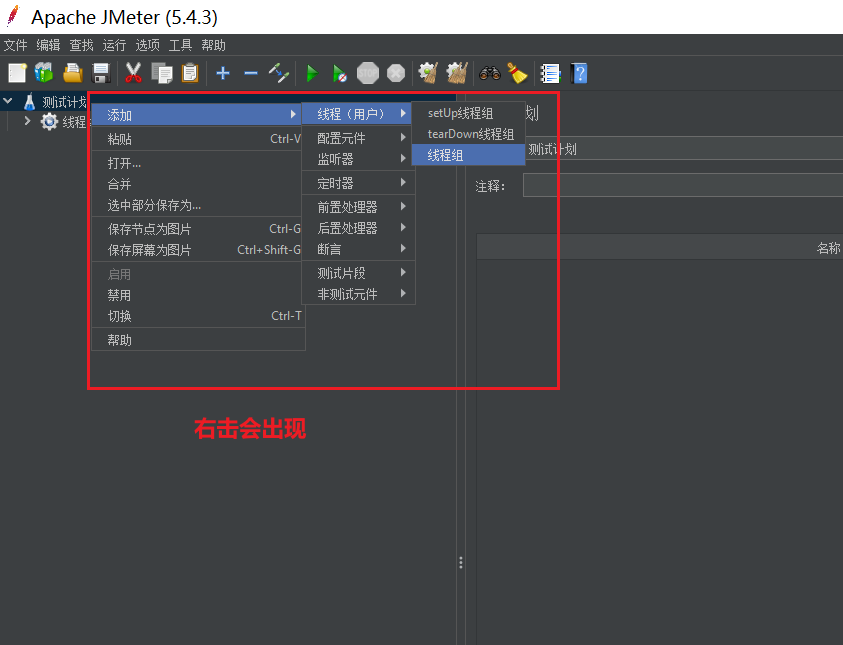

创建线程组

- 这里的线程数量根据自己电脑去设置

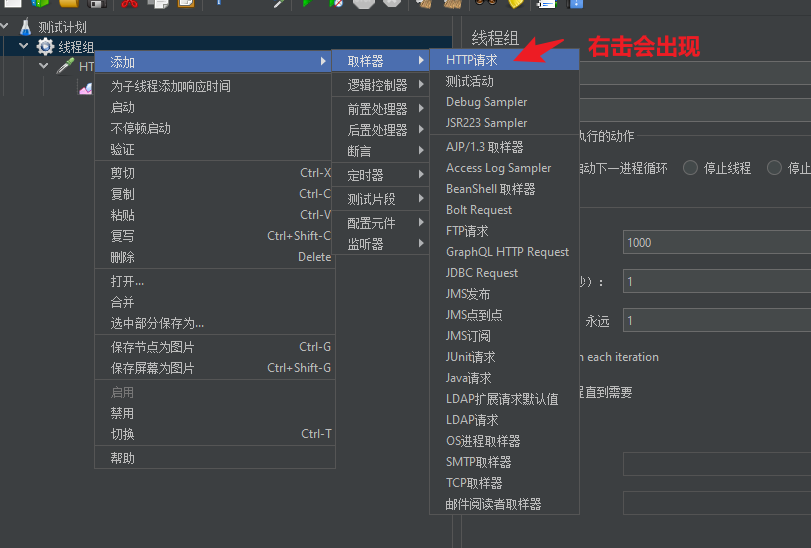

创建请求

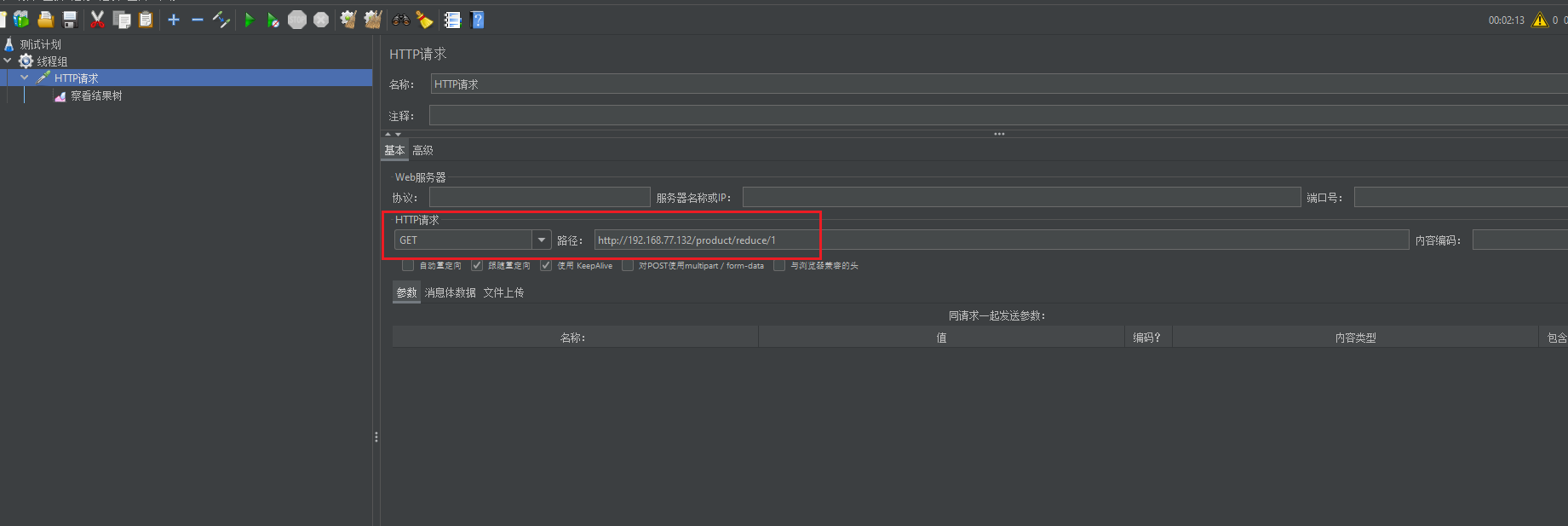

我们填写红框的内容即可就是访问的地址

- 我们还需要查看请求的结果 创建结果树 右击会出现

配置好这些之后,点击菜单栏绿色启动标志

- 会出现弹窗 第一个点yes 第二个点cancel(取消)

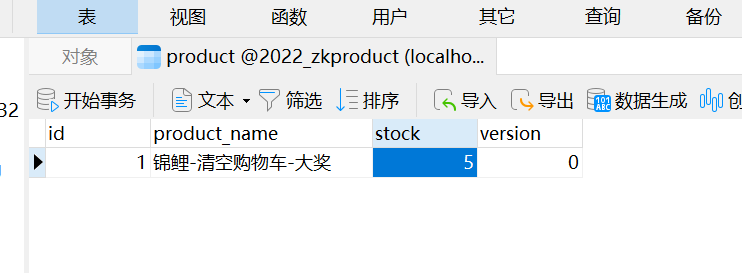

去数据库查看

没有启动前数据库的库存

可以看到 出现了 超卖

解决超卖

需要用到 zookeeper集群,搭建的文章

zookeeper分布式锁不需要我们手写去实现,有封装好的依赖,引入即可

<dependency>

<groupId>org.apache.curator</groupId>

<artifactId>curator-recipes</artifactId>

<version>4.2.0</version> <!-- 网友投票最牛逼版本 -->

</dependency>

在控制层中加入分布式锁的逻辑代码

- 添加了集群的ip

/**

* @author : look-word

* 2022-07-17 10:12

**/

@RestController

public class ProductAction {

@Resource

private ProductService productService;

// 集群ip

private String connectString = "192.168.77.132,192.168.77.131,192.168.77.130";

@GetMapping("product/reduce/{id}")

private Object reduce(@PathVariable Integer id) throws Exception {

// 重试策略 (1000毫秒试1次,最多试3次)

RetryPolicy retryPolicy = new ExponentialBackoffRetry(1000, 3);

//1.创建curator工具对象

CuratorFramework client = CuratorFrameworkFactory.newClient(connectString, retryPolicy);

client.start();

//2.根据工具对象创建“内部互斥锁”

InterProcessMutex lock = new InterProcessMutex(client, "/product_" + id);

try {

//3.加锁

lock.acquire();

productService.reduceStock(id);

} catch (Exception e) {

if (e instanceof RuntimeException) {

throw e;

}

} finally {

//4.释放锁

lock.release();

}

return "ok";

}

}

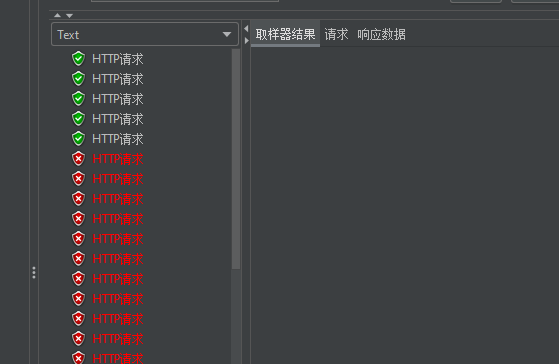

启动jmeter去测试,会发现,请求就像排队一样,一个一个出现,数据库也没有超卖现象

- 可以看到 只有前面的5课请求成功了,我们的库存只有5个

- 说明我们的分布式锁,已经实现了

springboot版本后续会退出

6 zookeeper实现分布式锁的更多相关文章

- zookeeper实现分布式锁服务

A distributed lock base on zookeeper. zookeeper是hadoop下面的一个子项目, 用来协调跟hadoop相关的一些分布式的框架, 如hadoop, hiv ...

- [ZooKeeper.net] 3 ZooKeeper的分布式锁

基于ZooKeeper的分布式锁 ZooKeeper 里实现分布式锁的基本逻辑: 1.zookeeper中创建一个根节点(Locks),用于后续各个客户端的锁操作. 2.想要获取锁的client都在L ...

- 基于 Zookeeper 的分布式锁实现

1. 背景 最近在学习 Zookeeper,在刚开始接触 Zookeeper 的时候,完全不知道 Zookeeper 有什么用.且很多资料都是将 Zookeeper 描述成一个“类 Unix/Linu ...

- zookeeper的分布式锁

实现分布式锁目前有三种流行方案,分别为基于数据库.Redis.Zookeeper的方案,其中前两种方案网络上有很多资料可以参考,本文不做展开.我们来看下使用Zookeeper如何实现分布式锁. 什么是 ...

- zookeeper 实现分布式锁安全用法

zookeeper 实现分布式锁安全用法 标签: zookeeper sessionExpire connectionLoss 分布式锁 背景 ConnectionLoss 链接丢失 SessionE ...

- 基于Zookeeper的分布式锁

实现分布式锁目前有三种流行方案,分别为基于数据库.Redis.Zookeeper的方案,其中前两种方案网络上有很多资料可以参考,本文不做展开.我们来看下使用Zookeeper如何实现分布式锁. 什么是 ...

- 转载 [ZooKeeper.net] 3 ZooKeeper的分布式锁

[ZooKeeper.net] 3 ZooKeeper的分布式锁 基于ZooKeeper的分布式锁 源码分享:http://pan.baidu.com/s/1miQCDKk ZooKeeper ...

- Redis与Zookeeper实现分布式锁的区别

Redis实现分布式锁 1.根据lockKey区进行setnx(set not exist,如果key值为空,则正常设置,返回1,否则不会进行设置并返回0)操作,如果设置成功,表示已经获得锁,否则并没 ...

- Zookeeper系列四:Zookeeper实现分布式锁、Zookeeper实现配置中心

一.Zookeeper实现分布式锁 分布式锁主要用于在分布式环境中保证数据的一致性. 包括跨进程.跨机器.跨网络导致共享资源不一致的问题. 1. 分布式锁的实现思路 说明: 这种实现会有一个缺点,即当 ...

- 10分钟看懂!基于Zookeeper的分布式锁

实现分布式锁目前有三种流行方案,分别为基于数据库.Redis.Zookeeper的方案,其中前两种方案网络上有很多资料可以参考,本文不做展开.我们来看下使用Zookeeper如何实现分布式锁. 什么是 ...

随机推荐

- springboot:使用异步注解@Async的前世今生

在前边的文章中,和小伙伴一起认识了异步执行的好处,以及如何进行异步开发,对,就是使用@Async注解,在使用异步注解@Async的过程中也存在一些坑,不过通过正确的打开方式也可以很好的避免,今天想和大 ...

- Kubernetes容器之间的通信浅谈

公众号关注 「开源Linux」 回复「学习」,有我为您特别筛选的学习资料~ 作者: Matt Zand 和 Jim Sullivan 译者: 穿过生命散发芬芳F Kubernetes是一个容器化的解决 ...

- 2020年DevOps工程师入门指南

DevOps兴起于2010年代,到现在DevOps已经在行业中拥有了一席之地,并在继续发展壮大. 有兴趣成为一名DevOps工程师吗?如果想要成为一名DevOps工程师,需要做到以下五点: 要有开发者 ...

- Mybatis-Plus入门实践

简介 Mybatis-Plus 简称 MP ,是 Mybatis 的增强工具,提供了一批开箱即用的功能.特性.接口.注解,简化了应用程序访问数据库的相关操作,完善了Mybatis作为ORM仅能做到半自 ...

- 基于C++11的线程池实现

1.线程池 1.1 线程池是什么? 一种线程管理方式. 1.2 为什么用线程池? 线程的创建和销毁都需要消耗系统开销,当线程数量过多,系统开销过大,就会影响缓存局部性和整体性能.而线程池能够在充分利用 ...

- SM3和Blake

在此给出SM3和Blake的对比 哈希函数 哈希算法 (Hash Algorithm) 是将任意长度的数据映射为固定长度数据的算法,也称为消息摘要.一般情况下,哈希算法有两个特点, 一是原始数据的细微 ...

- L2M-GAN: Learning to Manipulate Latent Space Semantics for Facial Attribute Editing阅读笔记

L2M-GAN: Learning to Manipulate Latent Space Semantics for Facial Attribute Editing 2021 CVPR L2M-GA ...

- RabbitMQ消息可靠性、死信交换机、消息堆积问题

目录 消息可靠性 生产者消息确认 示例 消费者消息确认 示例 死信交换机 例子 高可用问题 消息堆积问题 惰性队列 参考 消息可靠性 确保消息至少被消费了一次(不丢失) 消息丢失的几种情况: 消息在网 ...

- 深度学习与CV教程(4) | 神经网络与反向传播

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/37 本文地址:http://www.showmeai.tech/article-det ...

- git bisect:让你闭眼都能定位疑难 bug的利器

摘要:git bisect命令使用二分搜索算法来查找提交历史中的哪一次提交引入了错误.它几乎能让你闭着眼睛快速定位任何源码导致的问题,非常实用. 本文分享自华为云社区<利用好 git bisec ...