PyTorch中的backward [转]

转自:https://sherlockliao.github.io/2017/07/10/backward/

backward只能被应用在一个标量上,也就是一个一维tensor,或者传入跟变量相关的梯度。

特别注意Variable里面默认的参数requires_grad=False,所以这里我们要重新传入requires_grad=True让它成为一个叶子节点。

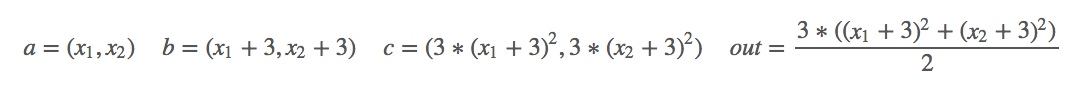

对其求偏导:

import torch as t

from torch.autograd import Variable as v # simple gradient

a = v(t.FloatTensor([2, 3]), requires_grad=True)

b = a + 3

c = b * b * 3

out = c.mean()

out.backward()

print('*'*10)

print('=====simple gradient======')

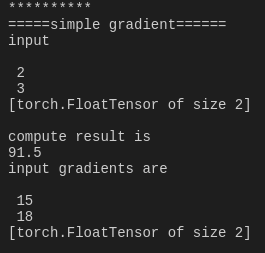

print('input')

print(a.data)

print('compute result is')

print(out.data[0])

print('input gradients are')

print(a.grad.data)

下面研究一下如何能够对非标量的情况下使用backward。backward里传入的参数是每次求导的一个系数。

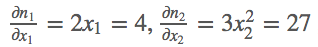

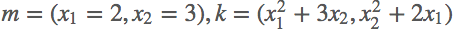

首先定义好输入m=(x1,x2)=(2,3),然后我们做的操作就是n= ,这样我们就定义好了一个向量输出,结果第一项只和x1有关,结果第二项只和x2有关,那么求解这个梯度,

,这样我们就定义好了一个向量输出,结果第一项只和x1有关,结果第二项只和x2有关,那么求解这个梯度,

# backward on non-scalar output

m = v(t.FloatTensor([[2, 3]]), requires_grad=True)

n = v(t.zeros(1, 2))

n[0, 0] = m[0, 0] ** 2

n[0, 1] = m[0, 1] ** 3

n.backward(t.FloatTensor([[1, 1]]))

print('*'*10)

print('=====non scalar output======')

print('input')

print(m.data)

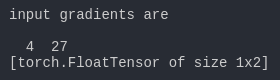

print('input gradients are')

print(m.grad.data)

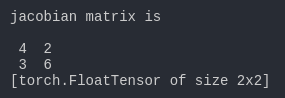

jacobian矩阵

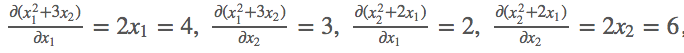

对其求导:

k.backward(parameters)接受的参数parameters必须要和k的大小一模一样,然后作为k的系数传回去,backward里传入的参数是每次求导的一个系数。

# jacobian

j = t.zeros(2 ,2)

k = v(t.zeros(1, 2))

m.grad.data.zero_()

k[0, 0] = m[0, 0] ** 2 + 3 * m[0 ,1]

k[0, 1] = m[0, 1] ** 2 + 2 * m[0, 0]

# [1, 0] dk0/dm0, dk1/dm0

k.backward(t.FloatTensor([[1, 0]]), retain_variables=True) # 需要两次反向求导

j[:, 0] = m.grad.data

m.grad.data.zero_()

# [0, 1] dk0/dm1, dk1/dm1

k.backward(t.FloatTensor([[0, 1]]))

j[:, 1] = m.grad.data

print('jacobian matrix is')

print(j)

我们要注意backward()里面另外的一个参数retain_variables=True,这个参数默认是False,也就是反向传播之后这个计算图的内存会被释放,这样就没办法进行第二次反向传播了,所以我们需要设置为True,因为这里我们需要进行两次反向传播求得jacobian矩阵。

PyTorch中的backward [转]的更多相关文章

- 关于Pytorch中autograd和backward的一些笔记

参考自<Pytorch autograd,backward详解>: 1 Tensor Pytorch中所有的计算其实都可以回归到Tensor上,所以有必要重新认识一下Tensor. 如果我 ...

- pytorch中tensorboardX的用法

在代码中改好存储Log的路径 命令行中输入 tensorboard --logdir /home/huihua/NewDisk1/PycharmProjects/pytorch-deeplab-xce ...

- pytorch 中的重要模块化接口nn.Module

torch.nn 是专门为神经网络设计的模块化接口,nn构建于autgrad之上,可以用来定义和运行神经网络 nn.Module 是nn中重要的类,包含网络各层的定义,以及forward方法 对于自己 ...

- 转pytorch中训练深度神经网络模型的关键知识点

版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:https://blog.csdn.net/weixin_42279044/articl ...

- pytorch中调用C进行扩展

pytorch中调用C进行扩展,使得某些功能在CPU上运行更快: 第一步:编写头文件 /* src/my_lib.h */ int my_lib_add_forward(THFloatTensor * ...

- 关于Pytorch中accuracy和loss的计算

这几天关于accuracy和loss的计算有一些疑惑,原来是自己还没有弄清楚. 给出实例 def train(train_loader, model, criteon, optimizer, epoc ...

- 【PyTorch】PyTorch中的梯度累加

PyTorch中的梯度累加 使用PyTorch实现梯度累加变相扩大batch PyTorch中在反向传播前为什么要手动将梯度清零? - Pascal的回答 - 知乎 https://www.zhihu ...

- PyTorch中的C++扩展

今天要聊聊用 PyTorch 进行 C++ 扩展. 在正式开始前,我们需要了解 PyTorch 如何自定义module.这其中,最常见的就是在 python 中继承torch.nn.Module,用 ...

- PyTorch中的Batch Normalization

Pytorch中的BatchNorm的API主要有: 1 torch.nn.BatchNorm1d(num_features, 2 3 eps=1e-05, 4 5 momentum=0.1, 6 7 ...

随机推荐

- logging模块--日志文件

初级的使用配置模式类似与print 默认打印waring等级及以上--通过更改等级来测试代码 logging.debug("debug no china") #调试模式 loggi ...

- 四重解法---P1047 校门外的树

题目描述 某校大门外长度为L的马路上有一排树,每两棵相邻的树之间的间隔都是1米.我们可以把马路看成一个数轴,马路的一端在数轴0的位置,另一端在L的位置:数轴上的每个整数点,即0,1,2,--,L,都种 ...

- Mudo C++网络库第三章学习笔记

多线程服务器的适用场合与常用编程模型 进程间通信与线程同步; 以最简单规范的方式开发功能正确.线程安全的多线程程序; 多线程服务器是指运行在linux操作系统上的独占式网络应用程序; 不考虑分布式存储 ...

- C# 对话框使用整理

1.保存文件对话框 SaveFileDialog saveFile = new SaveFileDialog(); saveFile.Title = "save file"; sa ...

- 转-C语言中.h和.c文件解析

C语言中.h和.c文件解析(很精彩) 简单的说其实要理解C文件与头文件(即.h)有什么不同之处,首先需要弄明白编译器的工作过程,一般说来编译器会做以下几个过程: 1.预处理阶段 2.词 ...

- centos如何安装Python3

Linux下默认系统自带python2.6的版本,这个版本被系统很多程序所依赖,所以不建议删除,如果使用最新的Python3那么我们知道编译安装源码包和系统默认包之间是没有任何影响的,所以可以安装py ...

- Winform按键捕获

参考:http://blog.csdn.net/zhensoft163/article/details/4239796 下载链接 方法1:使用窗体的 KeyDown 事件 private void F ...

- js设置睡眠N秒后再执行

function sleep(NumMillis) { var nowTime = new Date(); var exitTime = nowTime .getTime() + NumMillis; ...

- elasticsearch6.3.1 安装以及配置IK 使用

https://blog.csdn.net/whb3299065/article/details/80104323

- spring、springMVC、mybatis配置文件

一.jdbc.properties 文件: driver=com.mysql.jdbc.Driverurl=jdbc:mysql://192.168.31.xxx:3306/abc?useUnicod ...