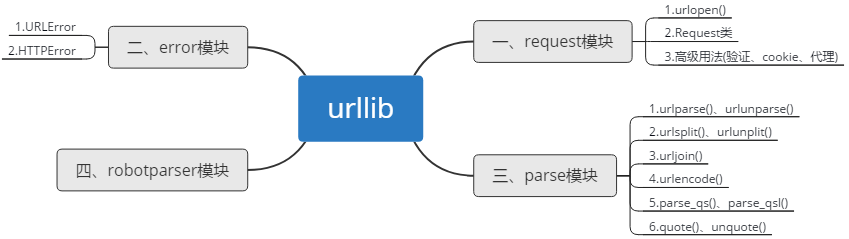

爬虫之urllib

一、request模块

1.urlopen() --返回值为HTTPResponse对象

urlopen(url, data=None, timeout=socket._GLOBAL_DEFAULT_TIMEOUT,

*, cafile=None, capath=None, cadefault=False, context=None)

参数:url必传

①data:传入之后请求变为POST,需转为bytes类型的参数

②timeout:设置超时时间,没有得到响应则抛出异常,异常类型为socket.timeout,默认为全局时间

③其他:context:设置SSL,ca:ca证书(使用HTTPS有用),cadefault已经弃用

2.Request类 --加入Headers信息,伪装成浏览器

class Request:

def __init__(self, url, data=None, headers={},

origin_req_host=None, unverifiable=False,

method=None):

参数:url必传

①data:bytes类型

②headers:字典类型,请求头,可通过修改User-Agent来伪装浏览器。等同于实例方法add_header(k,v)

③origin_req_host:请求方的host名称或ip地址

④unverifiable:没有权限为True,默认为False

⑤method:请求方法

3.高级用法

利用Handler来构建Opener。验证(HTTPBasicAuthHandler)、代理(ProxyHandler)、Cookies(HTTPCookieProcessor)

二、error模块

error模块定义了由request模块产生的异常

基类:URLError;子类:HTTPError

三、parse模块

1.urlparse() --返回ParseResult对象(scheme:'http',netloc='www,baidu.com',path='/index.html',params='user',query='id=5',fragment='comment')

http://www.baidu.com/index.html;user?id=5#comment 当url不包含params和query时,fragment会被解析为path的一部分

ParseResult实际上是一个元组,可以用索引或属性名来获取,如result[0],result.scheme

def urlparse(url, scheme='', allow_fragments=True):

参数:url必填

①scheme:协议(http,https),只有在url中不包含scheme信息时设置的才有效

②allow_fragments:是否忽略fragment,默认不忽略

2.urlunparse()

构造url,参数为一个可迭代对象如['http','www.baidu.com','index.htm','user','a=6','comment'],长度必须为6

3.urlsplit()

和urlparse()类似,不单独解析params,将params合并到path中

--返回SplitResult对象(scheme:'http',netloc='www,baidu.com',path='/index.html;user',query='id=5',fragment='comment')

4.urlunsplit()

与urlunparse()类似

构造url,参数为一个可迭代对象如['http','www.baidu.com','index.htm','a=6','comment'],长度必须为5

5.urljoin()

构造url,该方法会分析base的scheme,netloc和path并对新链接缺失的部分进行补充。

def urljoin(base, url, allow_fragments=True):

6.urlencode()

def urlencode(query, doseq=False, safe='', encoding=None, errors=None,

quote_via=quote_plus):

在构造GET请求参数的时候非常有用,将字典类型序列化为GET请求参数

from urllib.parse import urlencode

params={'name':'jyh','age':18}

base='http://www.baidu.com?'

url=base+urlencode(params)

print(url)

#---> http://www.baidu.com?name=jyh&age=18

7.parse_qs()

反序列化,将GET请求参数转回字典

8.parse_qsl()

将GET参数转化为元组组成的列表

9.quote()

将内容转化为URL编码的格式

quote('壁纸') --->%E5%A3%81%E7%BA%B8

10.unquote()

URL解码

四、robotparser模块 --Robots协议

规定网页哪些可爬,哪些不可爬

本文参考文献:[1]崔庆才.python3网络爬虫开发实战[M].北京:人民邮电出版社,2018:102-122.

爬虫之urllib的更多相关文章

- python 3.x 爬虫基础---Urllib详解

python 3.x 爬虫基础 python 3.x 爬虫基础---http headers详解 python 3.x 爬虫基础---Urllib详解 前言 爬虫也了解了一段时间了希望在半个月的时间内 ...

- Python爬虫之urllib模块2

Python爬虫之urllib模块2 本文来自网友投稿 作者:PG-55,一个待毕业待就业的二流大学生. 看了一下上一节的反馈,有些同学认为这个没什么意义,也有的同学觉得太简单,关于Beautiful ...

- Python爬虫之urllib模块1

Python爬虫之urllib模块1 本文来自网友投稿.作者PG,一个待毕业待就业二流大学生.玄魂工作室未对该文章内容做任何改变. 因为本人一直对推理悬疑比较感兴趣,所以这次爬取的网站也是平时看一些悬 ...

- python爬虫之urllib库(三)

python爬虫之urllib库(三) urllib库 访问网页都是通过HTTP协议进行的,而HTTP协议是一种无状态的协议,即记不住来者何人.举个栗子,天猫上买东西,需要先登录天猫账号进入主页,再去 ...

- python爬虫之urllib库(二)

python爬虫之urllib库(二) urllib库 超时设置 网页长时间无法响应的,系统会判断网页超时,无法打开网页.对于爬虫而言,我们作为网页的访问者,不能一直等着服务器给我们返回错误信息,耗费 ...

- python爬虫之urllib库(一)

python爬虫之urllib库(一) urllib库 urllib库是python提供的一种用于操作URL的模块,python2中是urllib和urllib2两个库文件,python3中整合在了u ...

- python爬虫之urllib库

请求库 urllib urllib主要分为几个部分 urllib.request 发送请求urllib.error 处理请求过程中出现的异常urllib.parse 处理urlurllib.robot ...

- 练手爬虫用urllib模块获取

练手爬虫用urllib模块获取 有个人看一段python2的代码有很多错误 import re import urllib def getHtml(url): page = urllib.urlope ...

- Python爬虫之urllib.parse详解

Python爬虫之urllib.parse 转载地址 Python 中的 urllib.parse 模块提供了很多解析和组建 URL 的函数. 解析url 解析url( urlparse() ) ur ...

- 爬虫---request+++urllib

网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本.另外一些不常使用的名字还有蚂蚁.自动索引.模拟程序或者蠕 ...

随机推荐

- 如何使用python在保留原excel格式的前提下插入/修改数据

一.需求分析: 统计的报表中需要每日查询当天数据并追加到原有的excel后面. 因为原始excel格式已经设定好,如果使用xlwt,仅仅指定设定我们要插入的单元格的格式,原始数据的格式会被初始化. 所 ...

- LDAP&it's usage

LDAP: 的英文全称是Lightweight Directory Access Protocol,简称为LDAP.LDAP是轻量目录访问协议[1],它是基于X.500标准的,但是简单多了并且可以根据 ...

- 学习笔记CB007:分词、命名实体识别、词性标注、句法分析树

中文分词把文本切分成词语,还可以反过来,把该拼一起的词再拼到一起,找到命名实体. 概率图模型条件随机场适用观测值条件下决定随机变量有有限个取值情况.给定观察序列X,某个特定标记序列Y概率,指数函数 e ...

- 真tm郁闷

昨天这时还是信心满满,今天这时就已经彻底颓了. 感觉这次是最接近的了,4个题目都做出来了,怎么还会fail,那边也不说为什么,到底是哪里不足,尽说些没用的. 前后都当了4次炮灰了,以后也不会再冲动了, ...

- todos+增删改查+js练习

增删改查+js练习+es6字符串模板@haloBabyBear <!DOCTYPE html> <html lang="en"> <head> ...

- MFC程序打包方法

目录 1. 新建工程 2. 设置信息 3. 其他设置 4. 生成安装包 1. 新建工程 在同一个解决方案下,新建一个Setup工程,工程名为SetupVSR. (1)在"解决方案资源管理器& ...

- git编译安装

因yum安装的git版本过低,所以尝试使用编译安装git 以下为编译安装时执行的命令 tar xf git-2.9.5.tar.gz cd git-2.9.5yum install curl-deve ...

- keepalived.conf配置说明

vim /etc/keepalived/keepalived.conf配置信息如下! Configuration File for keepalived global_defs { notificat ...

- github-上传自己的项目到github仓库

参考链接: https://blog.csdn.net/m0_37725003/article/details/80904824 https://www.cnblogs.com/cxk1995/p/5 ...

- Hbase各版本环境要求

1.HBase各版本JDK支持情况 HBase Version JDK 7 JDK 8 JDK 9 JDK 10 2.0 Not Supported yes Not Support ...