hadoop学习笔记(二):简单启动

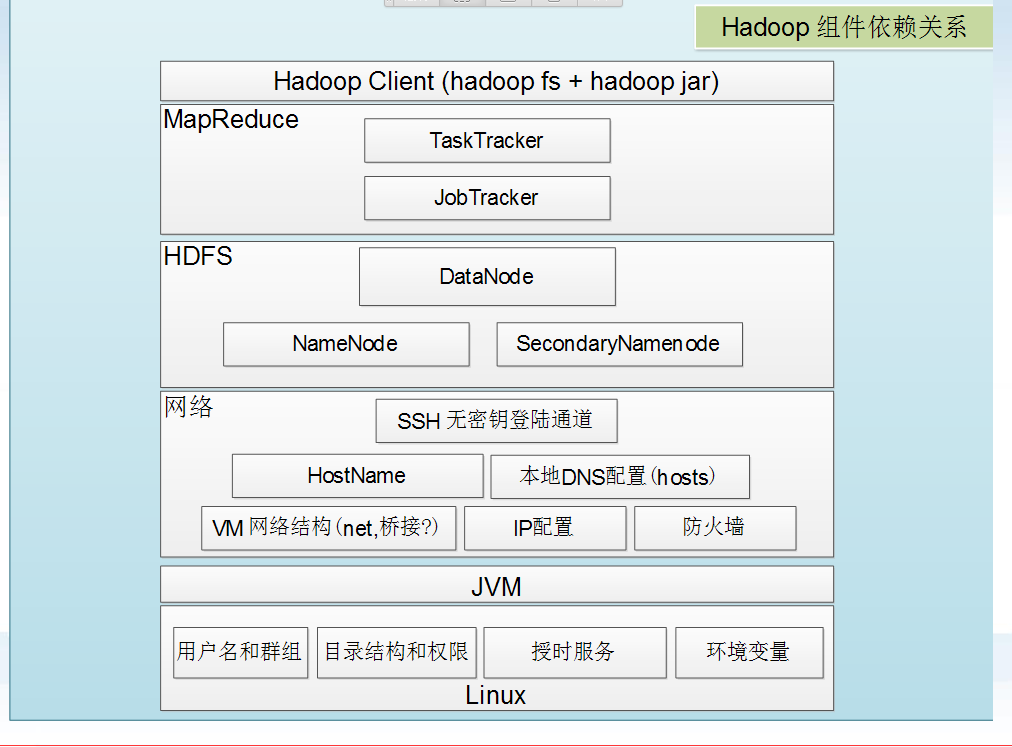

一、hadoop组件依赖关系

二、hadoop日志格式:

两种日志,分别以out和log结尾:

1 以log结尾的日志:通过log4j日志记录格式进行记录的日志,采用日常滚动文件后缀策略来命名日志文件,内容比较全。

2 以out结尾的日志:记录标准输出和标注错误的日志,内容比较少。默认的情况,系统保留最新的5个日志文件。

可以在/etc/hadoop/hadoop-env.sh中进行配置:

#Where log files are stored. $HADOOP_HOME/logs by default.

#export HADOOP_LOG_DIR = ${HADOOP_HOME}/logs

日志名称的解释:

二、hadoop启动和停止:

第一种方式:

启动:

start-dfs.sh

start-mapred.sh(hadoop 2.x为 start-yarn.sh)

停止:

stop-dfs.sh stop-mapred.sh(Hadoop 2.x为 stop-yarn.sh)

全部启动:

start-all.sh

启动顺序:NameNode --> DataNode --> Secondary NameNode --> JobTracker --> TaskTracker

全部停止:

stop-all.sh

停止顺序:JobTracker --> TaskTracker --> NameNode --> DataNode --> Secondary NameNode

第二种方式(守护进程逐一启动和关闭):

启动:

hadoop-daemon.sh start namenode

hadoop-daemon.sh start datanoe

hadoop-daemon.sh start secondarynamenode

hadoop-daemon.sh start jobtracker

hadoop-daemon.sh start tasktracker

启动顺序和上面的启动顺序一样:NameNode --> DataNode --> Secondary NameNode --> JobTracker --> TaskTracker

停止:

1 hadoop-daemon.sh stop jobtracker

2 hadoop-daemon.sh stop tasktracker

3 hadoop-daemon.sh stop namenode

4 hadoop-daemon.sh stop datanoe

5 hadoop-daemon.sh stop secondarynamenode

停止顺序和上面的启动顺序一样:JobTracker --> TaskTracker --> NameNode --> DataNode --> Secondary NameNode

第三种方式:

启动:

start-all.sh

停止:

stop-all.sh

三、测试

1 HDFS测试

对HDFS文件系统进行查看文件,对文件的基本操作。

hadoop fs -put hdfs://master01:9000 /xxx //上传文件

hadoop fs -get hdfs://master01:9000 /xxx //下载文件

hadoop fs -cat hdfs://master01:9000 /xxx //查看文件

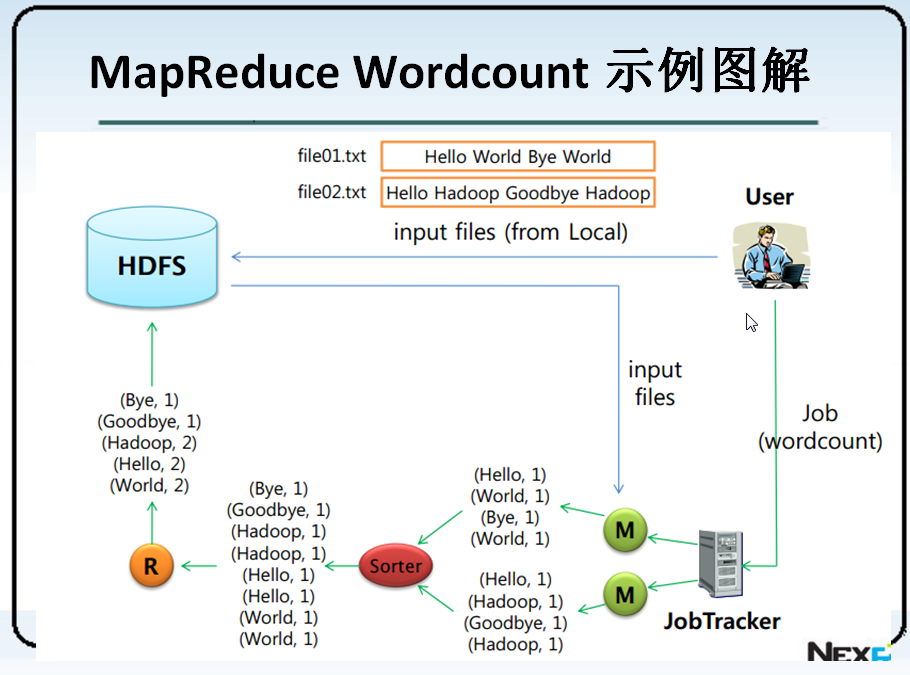

2 MapReduce程序测试

测试一个wordcount程序,思路是首先往文件系统中去上传一些文本文件,然后通过wordcount函数执行。

hadoop fs -mkdir /laowang/ //在HDFS中创建一个文件夹

hadoop fs -mkdir /laowang/input //在该文件夹下再创建一个文件夹

hadoop fs -put /software/hadoop2.7.3/conf/*.xml /laowang/input/ //将我们指定的文件上传到刚刚创建的文件夹中

hadoop jar hadoop-examples-x.x.x.jar wordcount /laowang/input/ /laowang/output/ //使用wordcount函数运行。前者是输入路径,后者是输出路径

3 查看MapReduce的运行状态

可以通过端口号50030查看MapReduce的执行状态,端口号50070查看HDFS的文件结构。

4 MapReduce Wordcount 示例图解

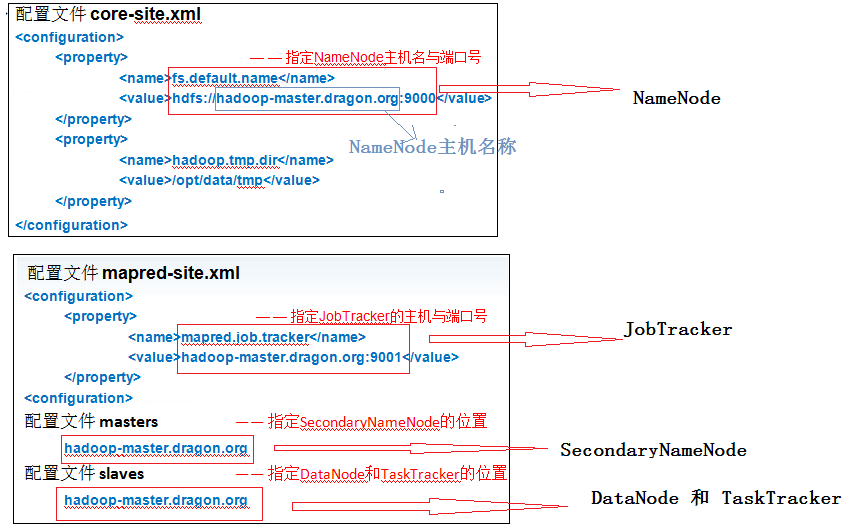

四、hadoop配置文件

三大基础配置文件:

1 core-site.xml

配置hadoop common project 的相关属性,hadoop框架的基础属性配置。

2 hdfs-site.xml

配置HDFS project 的相关属性。

3 mapred-site.xml

配置与MapReduce框架相关的属性。

额外配置文件:

1 master:

主节点,并不是配置hadoop 主节点的信息,而是配置HDFS辅助节点的信息。

2 slaves:

从节点,配置hadoop 中HDFS和MapReduce框架的从节点信息。

五、配置文件与五大守护进程的相互联系(重要)

hadoop学习笔记(二):简单启动的更多相关文章

- Html学习笔记(二) 简单标签

标签的重点 标签的用途 标签在浏览器中的默认样式 <body>标签: 在网页上显示的内容 <p>标签: 添加段落 <hx>标签: 添加标题 标签一共有6个,h1.h ...

- Java设计模式学习笔记(二) 简单工厂模式

前言 本篇是设计模式学习笔记的其中一篇文章,如对其他模式有兴趣,可从该地址查找设计模式学习笔记汇总地址 正文开始... 1. 简介 简单工厂模式不属于GoF23中设计模式之一,但在软件开发中应用也较为 ...

- Hadoop学习笔记二

一.设置无密码sudo权限,不用在普通用户和root用户间来回切换 chmod u+w /etc/sudoers vim /etc/sudoers #首行添加如下的内容: hadoop ALL=(ro ...

- Hadoop-HBASE案例分析-Hadoop学习笔记<二>

之前有幸在MOOC学院抽中小象学院hadoop体验课. 这是小象学院hadoop2.X概述第八章的笔记 主要介绍HBase,一个分布式数据库的应用案例. 案例概况: 1)时间序列数据库(OpenTSD ...

- hadoop 学习笔记二

NameNode的持久化(persistent)(day4,1) 类似于:Redis redis中的持久化文件是相互独立的当两个持久化文件同时存在时默认使用的是aof ,但是namenode 的持久化 ...

- redis 学习笔记二 (简单动态字符串)

redis的基本数据结构是动态数组 一.c语言动态数组 先看下一般的动态数组结构 struct MyData { int nLen; char data[0]; }; 这是个广泛使用的常见技巧,常用来 ...

- hadoop学习笔记叁--简单应用

1.通过命令向HDFS传输文件 上传:./hadoop fs -put hdfs.cmd (本地文件名) hdfs://主机名称:9000/ hadoop fs -copyFromLoca ...

- rabbitMQ学习笔记(二) 简单的发送与接收消息 HelloWorld

首先要下载rabbitmq的javaClient库,然后加入到项目中,下载地址为:http://www.rabbitmq.com/releases/rabbitmq-java-client/v3.1. ...

- nodejs学习笔记<二>简单的node服务器

在环境搭建好后,就可以开始动手架设(node驱动)一个简单的web服务器. 首先,nodejs还是用js编写.先来看一段node官网上的实例代码. var http = require('http') ...

- Hadoop学习笔记—22.Hadoop2.x环境搭建与配置

自从2015年花了2个多月时间把Hadoop1.x的学习教程学习了一遍,对Hadoop这个神奇的小象有了一个初步的了解,还对每次学习的内容进行了总结,也形成了我的一个博文系列<Hadoop学习笔 ...

随机推荐

- DataTable转List<T>

/// <summary> /// DataTable转List<T> /// </summary> public static class TableToList ...

- ASP.NET MVC学习目录

一.ASP.NET MVC原理详解 1.了解MVC架构模式 3.学习ASP.NET MVC的必备语言知识 4.MVC中的razor语法详解 5.ASP.NET MVC路由系统机制详细讲解 6.ASP. ...

- 如何使用jQuery实现根据不同IP显示不同的内容

一些SEM的投放页会针对不同地域做针对性的内容推广,下面我把实现方法分享出来. 一.引用新浪提供的IP查询的js库 <script src="http://int.dpool.sina ...

- poj 2981 Strange Way to Express Integers (中国剩余定理不互质)

http://poj.org/problem?id=2891 Strange Way to Express Integers Time Limit: 1000MS Memory Limit: 13 ...

- sharepoint 2013工具

caml designer 2013 生成caml工具 http://camlbuilder.codeplex.com/ 设计工具 CamlDesigner2013 爬网工具 HtmlAgilityP ...

- 虚拟机安装MAC OS X 10.9与Windows 7共享文件夹的方法

在虚拟机中安装好MAC OS X后, 把CD/DVD中的ISO映像换成 VMwareWorkstation安装目录下的/darwin.iso, 然后连接上 进入MAC 系统后, 先安装vmware t ...

- Posix消息队列注意事项

随内核的持续性 读总是返回最高优先级的最早消息. 当往一个空队列放置一个消息时,允许产生一个信号或启动一个线程. 可认为是一个消息链表 队列中每个消息具有 1.一个无符号整数优先级 2.消息的数据部分 ...

- Django-DRF-视图的演变

版本一(基于类视图APIView类) views.py: APIView是继承的Django View视图的. from .serializers import UserSerializers #导入 ...

- FTP枢轴攻击

简单来说,这是攻击者可以利用属于不同网络的那些系统的攻击. 本文作者:jishuzhain 对于这种攻击,攻击者需要利用主服务器来帮助攻击者将自己添加到本地网络中,然后攻击者就可以将客户端系统进行定位 ...

- 前端必学内容:webpack3快速入门 1-23节内容参考

前端必学内容:webpack(模块打包器) webpack3 学习内容,点击即可到达 (1).webpack快速入门——如何安装webpack及注意事项 (2).webpack快速入门——webpac ...