filebeat配置文件

filebeat主要用于收集和转发日志。filebeat监视指定的日志文件和位置,收集日志事件,并将它们转发到es或logstash进行索引。

安装

官网:https://www.elastic.co/guide/en/beats/filebeat/current/filebeat-installation.html

# curl -L -O https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-6.5.2-x86_64.rpm

# sudo rpm -vi filebeat-6.5.2-x86_64.rpm

说明

Filebeat的工作原理:启动Filebeat时,它会启动一个或多个inputs,这些inputs将查找指定的log的路径。对于查找到的每个日志,Filebeat将启动一个harvester。每个harvester读取单个日志的新内容,并将新日志数据发送到libbeat,libbeat聚合事件并将聚合数据发送到配置的output。

我们采用的是 filebeat -> kafka ->logstash -> es。

配置文件

filebeat 配置文件比较简单, 只需要配置一个filebeat.yml

input

#============== Filebeat prospectors ===========

filebeat.inputs: # 6.3以前是 filebeat.prospectors:

- type: log # input类型,默认为log,6.0以前配置是 - input_type: log

paths:

- /var/log/java/test-java.log

- /var/log/java/*.log

- /var/log/*/*.log

fields:

log_topic: java_log # 附加的可选字段,以向output添加额外的信息。output里面可以使用这个变量

multiline.pattern: '^\[' #多行合并 同logstash的multiline用法相似

multiline.negate: true

multiline.match: after - type: log # 一个配置文件里面可以同时收集多个日志

enabled: true

paths:

- /var/log/nginx/*.log

fields:

my_log_topic: nginx_log

常用配置

type: 指定input类型,有log、stdin、redis、tcp、syslog等

fields: 可以自定义添加字段,到output中去,后续可以使用这些字段,例如:

fields:

log_topic: mysql_slow

idc: szjf

tail_files: 默认为false。配置为true时,filebeat将从新文件的最后位置开始读取,而不是从开头读取新文件, 注意:如果配合日志轮循使用,新文件的第一行将被跳过。

此选项适用于Filebeat尚未处理的文件。如果先前运行了Filebeat并且文件的状态已经保留,tail_files则不会应用。

第一次运行Filebeat时,可以使用 tail_files: true 来避免索引旧的日志行。第一次运行后,建议禁用此选项。

registry file

filebeat会将自己处理日志文件的进度信息写入到registry文件中,以保证filebeat在重启之后能够接着处理未处理过的数据,而无需从头开始。

如果要让filebeat从头开始读文件,需要停止filebeat,然后删除registry file:

systemctl stop filebeat ;rm -fr /var/lib/filebeat/registry/* ; systemctl start filebaet

registry文件里字段的解释:

- source: 日志文件的路径

- offset:已经采集的日志的字节数;已经采集到日志的哪个字节位置

- inode: 日志文件的inode号

- device: 日志所在的磁盘编号

- timestamp: 日志最后一次发生变化的时间戳

- ttl: 采集失效时间,-1表示只要日志存在,就一直采集该日志

multiline: https://www.elastic.co/guide/en/beats/filebeat/current/multiline-examples.html#multiline 处理多行合并

output

配置输出的位置,比如kafka,logstash,es,redis,file 等

#================================ Outputs =====================================

#-------------------------Kafka output ------------------------------

output.kafka:

hosts: ["kafka01:9092","kafka02:9092","kafka03:9092]

topic: '%{[fields.my_log_topic]}'

partition.round_robin:

reachable_only: false

version: 0.10.0.0

required_acks: 1

compression: none

max_message_bytes: 1000000

#output.logstash:

# hosts: ["localhost:5044"]

还可以有一些其他配置,比如processor处理器配置(不是必需的)

#====================Preocessors=====================

processors:

- drop_fields: #删除字段,不再kibana里面展示,默认情况kibana里面会自动展示这些beat字段

fields: ["beat.hostname","beat.version","beat.name","prospector.type","input.type"] #也可以在logstash里面通过remove_field 删除字段

#mutate{

# remove_field => ["[beat][hostname]","[beat][version]","input","prospector"]

# }

配置完filebeat.yml,启动filebeat 即可。# /etc/init.d/filebeat start

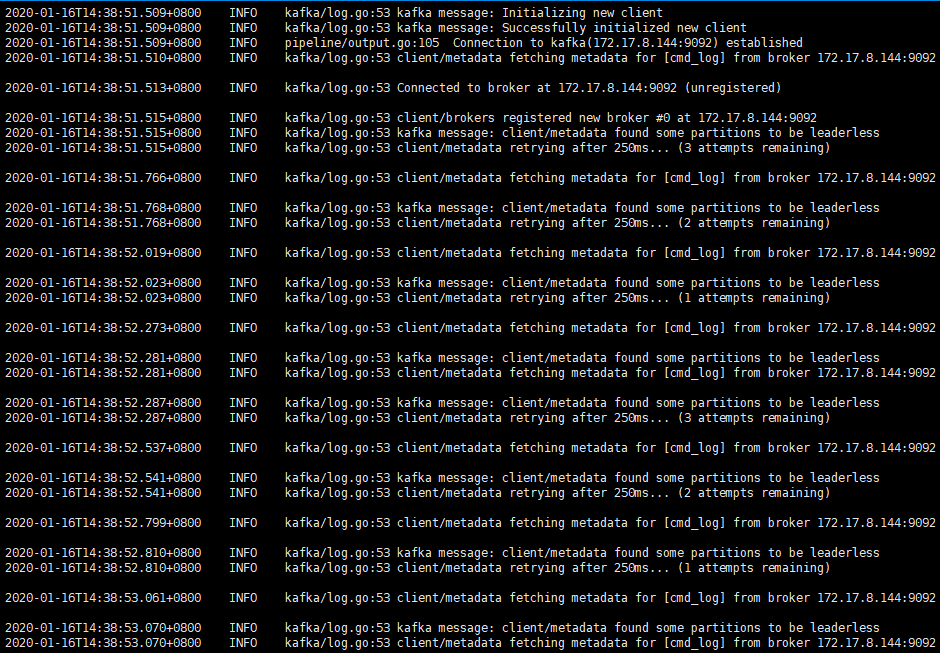

使用filebeat遇到的问题

手动在kafka创建topic后,再重新启动filebeat, 问题解决。

./bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 6 --topic nginx_log

经检查发现是因为kafka配置文件里面配置了 auto.create.topics.enable = false。auto.create.topics.enable 参数可以用来配置Kafka Server是否自动创建topic。

filebeat配置文件的更多相关文章

- Elasticsearch优化 & filebeat配置文件优化 & logstash格式配置 & grok实践

Elasticsearch优化 & filebeat配置文件优化 & logstash格式配置 & grok实践 编码转换问题(主要就是中文乱码) (1)input 中的cod ...

- Filebeat配置文件解析-转载

转载地址:https://dongbo0737.github.io/2017/06/13/filebeat-config/ Filebeat配置文件解析 filebeat 一个ELK架构中,专门用来收 ...

- filebeat 配置文件参数

filebeat 配置 所有的 beats 组件在 output 方面的配置都是一致的,之前章节已经介绍过.这里只介绍 filebeat 在 input 段的配置,如下: filebeat: sp ...

- FileBeat yml配置文件 -常用参数详解

#filebeat 5.2.2 #prospector(input)段配置 filebeat.prospectors: #每一个prospectors,起始于一个破折号"-" - ...

- logstash配合filebeat监控tomcat日志

环境:logstash版本:5.0.1&&filebeat 5.0.1 ABC为三台服务器.保证彼此tcp能够相互连接. Index服务器A - 接收BC两台服务器的tomcat日志 ...

- Filebeat轻量级日志采集工具

Beats 平台集合了多种单一用途数据采集器.这些采集器安装后可用作轻量型代理,从成百上千或成千上万台机器向 Logstash 或 Elasticsearch 发送数据. 一.架构图 此次试验基于前几 ...

- Elastic 技术栈之 Filebeat

Elastic 技术栈之 Filebeat 简介 Beats 是安装在服务器上的数据中转代理. Beats 可以将数据直接传输到 Elasticsearch 或传输到 Logstash . Beats ...

- ELK 架构之 Logstash 和 Filebeat 安装配置

上一篇:ELK 架构之 Elasticsearch 和 Kibana 安装配置 阅读目录: 1. 环境准备 2. 安装 Logstash 3. 配置 Logstash 4. Logstash 采集的日 ...

- 2-4、配置Filebeat使用logstash

配置filebeat使用logstash 重要:要将事件发送到Logstash,还需要创建一个Logstash配置管道,该管道监听传入的Beats连接并将收到的事件编入索引到Elasticsearch ...

随机推荐

- macOS搭建开发环境

1.包管理器Homebrew使用下面的命令安装: ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/insta ...

- 3545: [ONTAK2010]Peaks 平衡树,最小生成树

链接 https://www.lydsy.com/JudgeOnline/problem.php?id=3545 离线询问,按照权值排个序 就是在克鲁斯卡尔时候维护个treap,到时候挨个查询一下就好 ...

- Maven集成Tomcat插件

目录 类似插件及版本区别: 本地运行,启动嵌入式tomcat: 错误一: 错误二: Idea运行调试: vscode运行调试: 远程部署: 项目中的pom.xml配置: Tomcat中的tomcat- ...

- 【做题】CF285E. Positions in Permutations——dp+容斥

题意:求所有长度为\(n\)的排列\(p\)中,有多少个满足:对于所有\(i \,(1 \leq i \leq n)\),其中恰好有\(k\)个满足\(|p_i - i| = 1\).答案对\(10^ ...

- hihoCoder week11 树中的最长路

题目链接: https://hihocoder.com/contest/hiho11/problem/1 求树中节点对 距离最远的长度 #include <bits/stdc++.h> u ...

- 17秋 SDN课程 第五次上机作业

17秋 SDN课程 第五次上机作业 Project:https://github.com/Wasdns/new_balance Slide is available at https://github ...

- 【译】第11节---数据注解-TimeStamp

原文:http://www.entityframeworktutorial.net/code-first/TimeStamp-dataannotations-attribute-in-code-fir ...

- 深入理解char * ,char ** ,char a[ ] ,char *a[]

1.数组的本质 数组是多个元素的集合,在内存中分布在地址相连的单元中,所以可以通过其下标访问不同单元的元素. 2.指针 指针也是一种变量,只不过它的内存单元中保存的是一个标识其他位置的地址.由于地址也 ...

- 主键非自增列 EF 插入数据库引起的 ID 列不能为 NULL 的错误

protected override void OnModelCreating(DbModelBuilder modelBuilder) { modelBuilder.Entity<PostBo ...

- 一:requests爬虫基础

一,什么是爬虫? 描述: 本质是一个自动化程序,一个模拟浏览器向某一个服务器发送请求获取响应资源的过程. 爬虫的基本流程 robots.txt协议 编写一个robots.txt的协议文件来约束爬虫程序 ...